HGX B300: Escalabilidade Líquida para AI Factories

Supermicro HGX B300: Arquitetura Líquida e Escalável para AI Factories de Alta Densidade

Introdução

A aceleração da demanda global por infraestrutura de IA tem pressionado data centers a atingirem níveis inéditos de densidade computacional, eficiência energética e escalabilidade operacional. Nesse contexto, a expansão do portfólio NVIDIA Blackwell pela Supermicro — com os novos sistemas HGX B300 resfriados a líquido nas versões 4U e 2-OU (OCP) — representa uma inflexão estratégica para organizações que precisam treinar modelos maiores, operar agentes de IA mais complexos e construir AI factories realmente sustentáveis.

O desafio central que estas organizações enfrentam não é apenas computacional: trata-se de equilibrar energia, resfriamento, densidade, capacidade de upgrade e interoperabilidade com redes avançadas. O custo da inação, especialmente em ambientes hyperscale, se traduz em desperdício energético, limitações de capacidade de expansão, aumento de latência interna e restrições para rodar modelos de última geração.

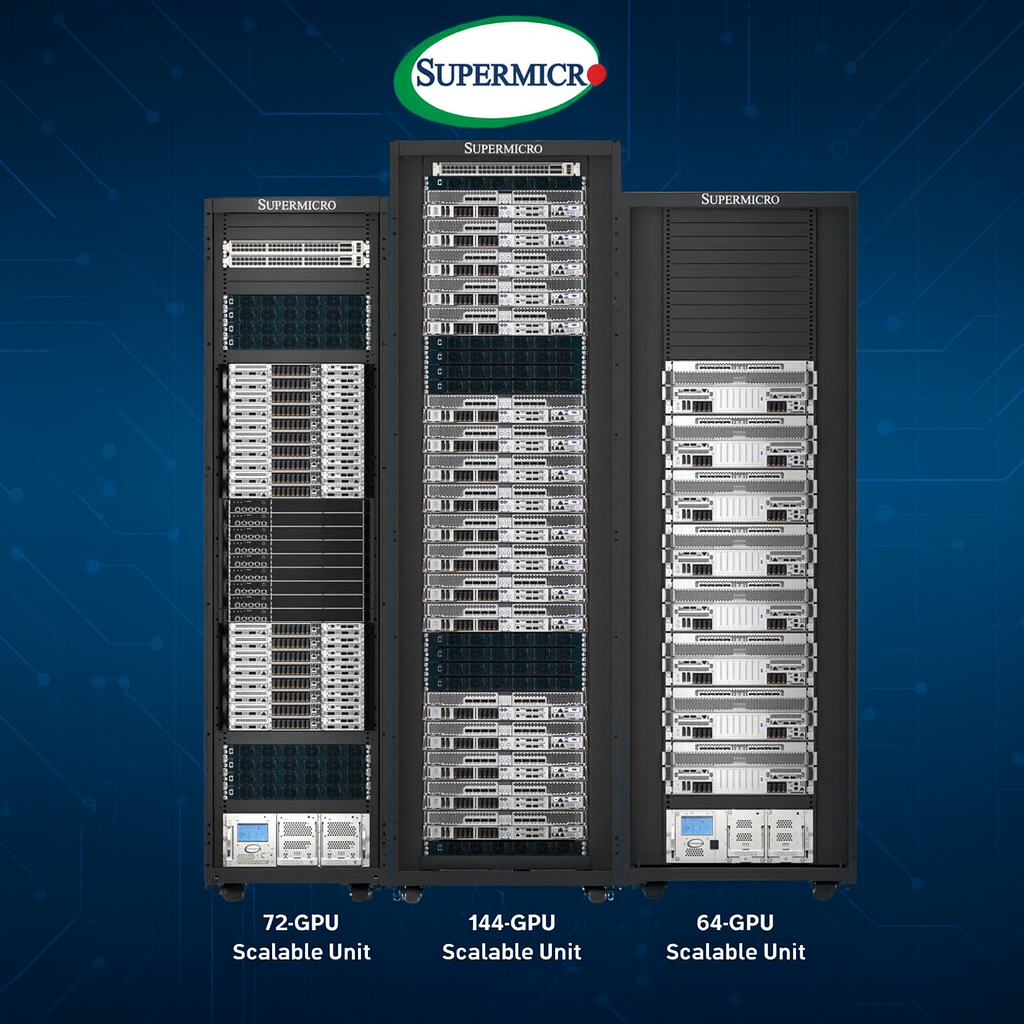

Este artigo aprofunda como as novas plataformas HGX B300 da Supermicro atacam esses desafios através de engenharia térmica avançada, integração de rede de alta largura de banda, design modular e capacidade de escalar até níveis massivos — como 144 GPUs por rack e SuperClusters com 1.152 GPUs.

Nos próximos tópicos, analisaremos a fundo os dilemas estratégicos para operações em escala, como o HGX B300 responde a eles e por que esses sistemas se tornam peças centrais no futuro das AI factories.

O Problema Estratégico: Como Escalar IA Sem Aumentar Exponencialmente o Consumo Energético?

Pressão por densidade computacional extrema

Organizações que trabalham com IA de larga escala enfrentam uma pressão crescente para aumentar a densidade de GPUs por metro quadrado. Isso ocorre porque modelos maiores — especialmente em aplicações multimodais e agentes avançados — dependem de clusters extremamente grandes para treinamento e inferência. No entanto, atingir essa densidade aumenta dificuldades relacionadas à dissipação térmica, gerenciamento de energia e manutenção.

Limitantes arquiteturais em racks tradicionais

Sistemas de rack convencionais possuem limites intrínsecos de eficiência térmica, o que força data centers a investirem em infraestrutura de resfriamento cada vez mais cara. Isso impacta diretamente o OPEX. Para AI factories, onde centenas de GPUs trabalham continuamente em cargas intensivas, o resfriamento por ar se torna insuficiente e energeticamente inviável.

Dependência de interconexões rápidas

Modelos grandes não escalam apenas em número de GPUs — dependem de redes capazes de manter baixa latência e alta largura de banda em clusters distribuídos. Sem uma rede acelerada, mesmo centenas de GPUs podem operar abaixo de seu potencial.

Consequências da Inação: Quando o Resfriamento e a Rede se Tornam Gargalos

Aumento de custos de energia e infraestrutura

Data centers que tentam lidar com densidade crescente usando técnicas tradicionais sofrem com custos energéticos explosivos, além da necessidade de chillers e compressores adicionais. Isso resulta em tempo de retorno de investimento mais longo e limitações futuras para expansão.

Redução de desempenho efetivo

Sem interconexão capaz de 800Gb/s, clusters de IA sofrem com subutilização, aumento de latência, e redução drástica na eficiência durante treinamento de modelos. Isso afeta diretamente prazos de projeto e competitividade.

Dificuldade de escalar clusters e manter disponibilidade

Soluções que dependem de racks convencionais e módulos sem modularidade de manutenção criam barreiras para upgrades, substituições, reparos e expansão em escala hyperscale.

Fundamentos da Solução Supermicro HGX B300

Densidade máxima com arquitetura otimizada para IA

A Supermicro introduz dois sistemas complementares:

- 2-OU OCP HGX B300 — para racks 21” ORV3 com até 144 GPUs por rack.

- 4U Front I/O HGX B300 — para racks padrão 19″ com até 64 GPUs por rack.

Ambos foram projetados para incluir 8 GPUs NVIDIA Blackwell Ultra em cada nó, permitindo densidade competitiva tanto em ambientes OCP quanto em infraestruturas tradicionais.

Resfriamento líquido avançado com DLC e DLC-2

O uso de resfriamento direto a líquido é o diferencial que resolve a barreira térmica dos sistemas de IA modernos. O modelo 4U utiliza tecnologia DLC-2 capaz de capturar até 98% do calor gerado pelo sistema, enquanto o sistema OCP utiliza um design com blind-mate manifold para encaixe automático no rack.

Essas tecnologias eliminam dependência de água gelada, permitem operação com água morna a 45°C e reduzem o consumo energético do data center em até 40% segundo parâmetros da própria empresa.

Interconexão de alto desempenho com 800Gb/s

A eficiência da IA moderna depende da rede. Os HGX B300 usam NVIDIA ConnectX-8 SuperNICs integradas que dobram a largura de banda da malha para 800Gb/s. Essa capacidade é projetada para clusters com NVIDIA Quantum-X800 InfiniBand ou Spectrum-4 Ethernet — redes de última geração essenciais para modelos de larga escala.

Implementação Estratégica em AI Factories

Integrando sistemas 2-OU OCP HGX B300

O modelo OCP é desenhado para operações hyperscale e cloud providers que precisam maximizar densidade. Sua arquitetura modular permite que o rack ORV3 suporte até 18 nós, cada um com oito GPUs Blackwell Ultra. A combinação desses nós alcança 144 GPUs por rack, mantendo ao mesmo tempo modularidade e manutenção simplificada.

Implementação do 4U HGX B300 em racks tradicionais

Para empresas que utilizam racks de 19 polegadas, o sistema 4U oferece densidade competitiva com até 64 GPUs por rack, mantendo compatibilidade e facilidade de manutenção. A versão 4U prioriza serviceability através do acesso frontal e integração direta com a infraestrutura existente.

Escalando para SuperClusters com 1.152 GPUs

Um SuperCluster completo é composto por:

- 8 racks HGX B300 (computação)

- 3 racks de rede NVIDIA Quantum-X800

- 2 racks Supermicro com CDUs in-row de 1,8MW

A soma dessas unidades resulta em um conjunto escalável de 1.152 GPUs, projetado para treinar modelos de última geração e sustentar operações de IA em escala industrial.

Melhores Práticas Avançadas

Padronização em formas de rack (19″ ou 21″)

Organizações devem avaliar se seu ambiente de data center se beneficia mais do formato OCP 21” — ideal para densidade máxima — ou do padrão EIA 19”, normalmente mais compatível com ambientes corporativos. A seleção correta evita retrabalho estrutural e reduz CAPEX.

Uso do ecossistema NVIDIA certificado

Os sistemas HGX B300 fazem parte do ecossistema NVIDIA-Certified Systems, o que significa compatibilidade direta com:

- NVIDIA AI Enterprise

- NVIDIA Run:ai

- NVIDIA networking avançado

Aproveitar esta certificação reduz riscos de incompatibilidade e acelera time-to-online.

Adoção do DCBBS — Data Center Building Block Solutions

O modelo DCBBS da Supermicro entrega racks pré-validados nos níveis L11 e L12, eliminando fases de integração que normalmente retardam projetos de AI factories. Para hyperscalers, isso remove semanas de testes e garante consistência operacional.

Medição de Sucesso: Como Avaliar a Eficácia da Implementação

Eficiência energética

A métrica central é o quanto a organização consegue reduzir custos de energia comparado com resfriamento a ar. A tecnologia de resfriamento líquido da Supermicro reduz até 40% de consumo energético em data centers.

Densidade por rack

Considerar quantas GPUs são suportadas por rack e como isso afeta footprint físico. Os HGX B300 atingem entre 64 e 144 GPUs por rack, dependendo do formato.

Escalabilidade do cluster

O cluster completo com 1.152 GPUs representa o patamar máximo de expansão sugerido para AI factories baseadas no HGX B300.

Desempenho em workloads reais

Casos como:

- Treinamentos de foundation models

- Inferência multimodal em larga escala

- Aplicações agentic AI

São essenciais para validar se a malha de 800Gb/s e o resfriamento líquido estão sustentando performance consistente.

Conclusão

As novas plataformas Supermicro HGX B300 representam um avanço significativo para data centers que precisam suportar a próxima geração de cargas de trabalho em IA. A capacidade de operar com até 144 GPUs por rack, somada ao resfriamento líquido eficiente e à integração com redes de 800Gb/s, cria uma base sólida para AI factories em escala industrial.

A combinação entre densidade, eficiência e modularidade não apenas resolve desafios operacionais, mas redefine como organizações podem escalar seus clusters de IA sem comprometer custos ou sustentabilidade.

Com a expansão do portfólio NVIDIA Blackwell e a abordagem DCBBS, a Supermicro oferece um caminho claro para empresas que precisam entregar IA em grande escala, com tempos de implantação mais rápidos e performance por watt incomparável.

As organizações que desejam preparar sua infraestrutura para a próxima década de evolução da IA encontrarão no HGX B300 uma plataforma estratégica, robusta e altamente otimizada para ambientes críticos.