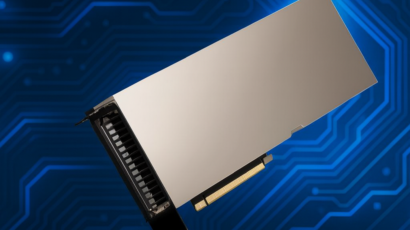

Cloud HPC as a Service, IA as a Service (GPUs sob demanda para treinamento e inferência), cloud computing enterprise, implementação e gerenciamento de infraestrutura cloud, virtualização VMware (administração, migração, licenciamento), consultoria em HPC e alta performance, monitoramento 24/7 de clusters, otimização de workloads IA/ML, migração e repatriação de nuvem pública, colocation, datacenter, bare metal servers, gestão de máquinas virtuais, adequação LGPD, disaster recovery, backup corporativo, treinamentos técnicos certificados, suporte multilíngue (Português/Inglês/Russo). Atendimento no Brasil e exterior desde 2016.