AMD Helios e GPUs MI500: arquitetura para IA em escala yotta

Introdução

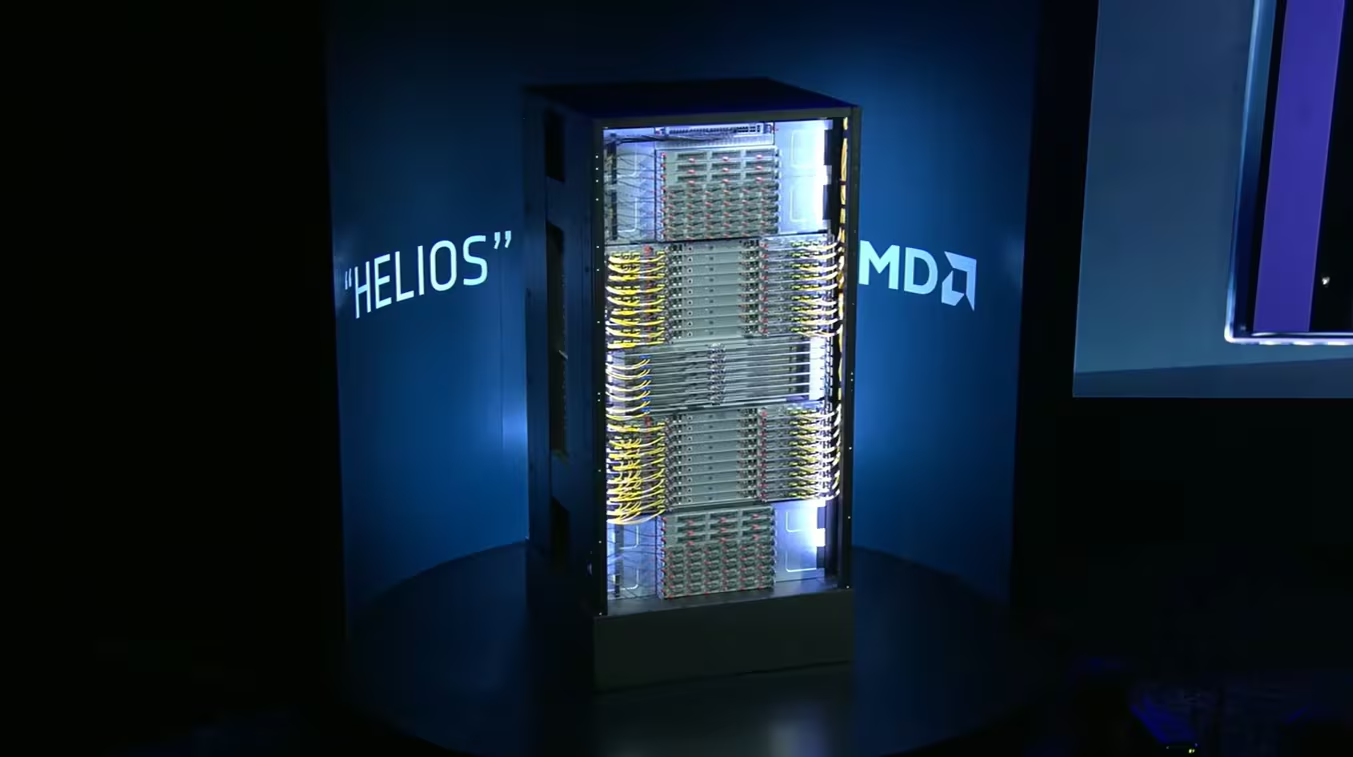

A aceleração exponencial das cargas de trabalho de inteligência artificial está redefinindo, em ritmo acelerado, os limites da infraestrutura de computação corporativa. Durante a CES 2026, a AMD apresentou uma prévia concreta de como pretende responder a esse desafio ao revelar detalhes do sistema Helios e das futuras GPUs Instinct MI500, posicionando-se estrategicamente para disputar protagonismo em um mercado atualmente dominado pela Nvidia.

O cenário descrito pela própria AMD é revelador: ao longo da última década, a capacidade computacional necessária para treinamento de modelos de IA cresceu quatro vezes ao ano, enquanto a inferência passou a dominar o consumo de recursos, com o volume de tokens processados aumentando cem vezes apenas nos últimos dois anos. Essa mudança estrutural impõe pressões inéditas sobre desempenho, largura de banda, eficiência energética e capacidade de integração em escala de data center.

Para as organizações, a inação diante desse movimento não é neutra. A incapacidade de acompanhar essas demandas pode resultar em gargalos operacionais, custos crescentes de infraestrutura e perda de competitividade em iniciativas de IA. Nesse contexto, a proposta da AMD com o Helios vai além de um novo GPU: trata-se de uma arquitetura de rack em escala yotta, pensada para integrar CPUs, aceleradores, memória e rede em um sistema coengenheirado.

Este artigo analisa, de forma aprofundada, os fundamentos técnicos e estratégicos do sistema Helios, das GPUs MI455 e da futura família MI500, avaliando implicações para arquiteturas de IA corporativas, desafios de implementação e os possíveis impactos no equilíbrio competitivo do mercado de infraestrutura para inteligência artificial.

O desafio estratégico da IA em escala extrema

Pressão crescente por desempenho e escala

A expansão acelerada das aplicações de IA corporativa deslocou o foco do treinamento isolado de modelos para a execução contínua de inferência em larga escala. Esse movimento altera radicalmente o perfil das cargas de trabalho, exigindo não apenas maior poder computacional bruto, mas também conectividade de altíssima velocidade entre milhares de aceleradores.

Segundo a AMD, a inferência já supera o treinamento em volume de processamento, o que implica arquiteturas capazes de sustentar fluxos massivos de dados com latência mínima. Em ambientes corporativos, isso se traduz na necessidade de racks altamente integrados, capazes de operar como sistemas unificados e não como conjuntos de servidores isolados.

Ignorar essa transição implica arquitetar data centers que rapidamente se tornam obsoletos, incapazes de absorver o crescimento das cargas de IA sem custos desproporcionais de expansão ou complexidade operacional excessiva.

Consequências da inação

Organizações que mantêm arquiteturas fragmentadas enfrentam limitações claras: subutilização de GPUs, gargalos de memória, latências elevadas entre nós e aumento do consumo energético por unidade de desempenho entregue. Em escala, esses fatores comprometem tanto o retorno sobre investimento quanto a viabilidade de projetos avançados de IA.

Além disso, a dependência de soluções pouco integradas dificulta a adoção de novos aceleradores e tecnologias de interconexão, ampliando riscos de lock-in arquitetural e reduzindo flexibilidade estratégica.

Fundamentos do sistema Helios

Arquitetura de rack em escala yotta

O Helios foi concebido pela AMD como uma plataforma de rack modular e aberta, capaz de evoluir ao longo de múltiplas gerações de produtos. Essa abordagem reconhece que a escala exigida pela IA moderna não pode ser atendida apenas por ganhos incrementais de desempenho em componentes isolados.

Quando entrar em produção, ainda em 2026, o Helios combinará GPUs Instinct MI455, CPUs EPYC “Venice”, memória HBM4 e unidades de processamento de dados (DPUs) Pensando, integradas por meio da arquitetura de empilhamento 3D da AMD e resfriamento líquido.

O foco declarado da empresa é oferecer soluções turnkey, reduzindo a complexidade de implantação em ambientes corporativos e permitindo que milhares de aceleradores operem como um único sistema lógico.

Interconexão e rede como pilares

Um dos diferenciais centrais do Helios é o uso de interconexões Ethernet de alta velocidade em múltiplos níveis. Dentro do rack, os dados trafegam via Ultra Accelerator Link (UALink), enquanto a comunicação entre racks ocorre por meio de Ultra Ethernet (UE) e NICs compatíveis.

Essa escolha reflete uma estratégia de adoção de padrões abertos e escaláveis, em oposição a interconexões proprietárias, facilitando a expansão para dezenas de milhares de racks interligados em um único data center.

Do ponto de vista corporativo, essa abordagem favorece interoperabilidade e governança, reduzindo riscos associados à adoção de tecnologias fechadas em ambientes críticos.

GPUs Instinct MI455: base computacional do Helios

Avanços arquiteturais e densidade extrema

A GPU MI455 foi descrita pela AMD como o chip mais avançado já produzido pela empresa. Construída com processos de 2 nm e 3 nm, ela incorpora 320 bilhões de transistores, representando um aumento de 70% em relação à geração anterior MI355.

O design utiliza 12 chiplets de computação e I/O, integrados por meio da tecnologia de empilhamento 3D da AMD, além de 432 GB de memória HBM4 de alta velocidade. Quatro dessas GPUs são instaladas em cada bandeja de computação do Helios.

Essa densidade extrema visa atender diretamente às demandas de inferência e treinamento em larga escala, reduzindo latências internas e maximizando a taxa de transferência de dados.

Implicações para desempenho e eficiência

A combinação de HBM4 e empilhamento 3D permite que a MI455 opere com larguras de banda significativamente superiores às gerações anteriores, mitigando gargalos comuns em cargas de IA intensivas em memória.

Do ponto de vista estratégico, esse avanço reforça a posição da AMD como fornecedora de aceleradores capazes de competir em ambientes de missão crítica, onde eficiência energética e densidade por rack são fatores determinantes.

CPUs EPYC “Venice” e a coengenharia CPU-GPU

CPU projetada para IA

As CPUs EPYC Venice, baseadas na arquitetura Zen 6 em processo de 2 nm, foram explicitamente projetadas para atuar como “AI CPUs”, segundo a própria AMD. O foco está na ampliação da largura de banda de memória e de comunicação com GPUs.

De acordo com Lisa Su, a Venice dobra a largura de banda de memória e de GPU em relação à geração anterior, garantindo que as MI455 sejam alimentadas com dados em velocidade plena, mesmo em escala de rack.

Essa coengenharia reduz desequilíbrios clássicos entre CPU e GPU, comuns em arquiteturas menos integradas.

Impacto no TCO e na escalabilidade

A AMD destaca ganhos simultâneos em desempenho, eficiência e custo total de propriedade. Em ambientes corporativos, essa combinação é crítica para viabilizar projetos de IA em larga escala sem explosão de custos operacionais.

A presença de mais de 4.600 núcleos Zen por rack Helios reforça a capacidade de processamento geral necessária para orquestração, pré-processamento e integração com aplicações empresariais.

Escala, desempenho e métricas do Helios

Capacidade por rack

Cada rack Helios oferecerá 18.000 unidades de computação CDNA5 e até 2,9 exaflops de desempenho em IA, embora a AMD não tenha especificado a precisão associada a esse número.

Além disso, cada rack contará com 31 TB de memória HBM4, 260 TB/s de largura de banda de scale-up e 43 TB/s de largura de banda agregada.

Esses números evidenciam a ambição do Helios de estabelecer um novo patamar de referência em infraestrutura de IA.

Escalabilidade em nível de data center

A arquitetura foi projetada para conectar dezenas de milhares de racks em um único ambiente, viabilizando sistemas verdadeiramente em escala yotta.

Para organizações que operam grandes data centers ou ambientes de pesquisa avançada, essa escalabilidade representa a possibilidade de consolidar cargas massivas de IA em plataformas unificadas.

MI500: a próxima etapa da estratégia da AMD

CDNA 6 e processo de 2 nm

A AMD também apresentou uma prévia da futura série MI500, sucessora da MI455. As GPUs MI500 serão baseadas na arquitetura CDNA 6 e fabricadas em processo de 2 nm, incorporando memória HBM ainda mais rápida.

Segundo a empresa, o desenvolvimento da MI500 já está em andamento e sua disponibilidade está prevista para 2027.

Essa antecipação sinaliza uma estratégia de continuidade e evolução agressiva no segmento de aceleradores para IA.

Projeção de desempenho e implicações estratégicas

De acordo com Lisa Su, a MI500 representará um ganho de até 1.000 vezes no desempenho de IA ao longo de quatro anos, refletindo a necessidade de avanços extremos para acompanhar a demanda do mercado.

Embora a Nvidia mantenha liderança significativa em participação de mercado, a AMD aposta na inovação contínua e em arquiteturas abertas para conquistar espaço em futuros contratos de infraestrutura.

Considerações finais e perspectivas

A prévia do sistema Helios e das GPUs MI500 apresentada na CES 2026 revela uma AMD focada em competir em igualdade técnica no mercado de infraestrutura para IA em larga escala. A ênfase em coengenharia, padrões abertos de interconexão e integração profunda de CPU, GPU, memória e rede demonstra uma compreensão clara dos desafios impostos pela IA moderna.

Para organizações corporativas, o Helios representa uma proposta arquitetural que busca reduzir complexidade, aumentar eficiência e viabilizar escalas antes restritas a ambientes experimentais. No entanto, sua adoção exigirá maturidade operacional, capacidade de integração e governança robusta para lidar com sistemas dessa magnitude.

O avanço rumo à MI500 indica que a competição no mercado de aceleradores de IA está longe de se estabilizar. Em um cenário onde ninguém detém monopólio da inovação, a capacidade de entregar soluções integradas e escaláveis será determinante para definir os vencedores da próxima fase da IA corporativa.

Para as organizações interessadas, o próximo passo prático é acompanhar a evolução dessas plataformas, avaliar sua compatibilidade com arquiteturas existentes e planejar, desde já, estratégias de adoção que considerem não apenas desempenho, mas também custo, governança e sustentabilidade operacional.