NAS 4 Baias QNAP: Alta Performance e Segurança para seu Ambiente Corporativo

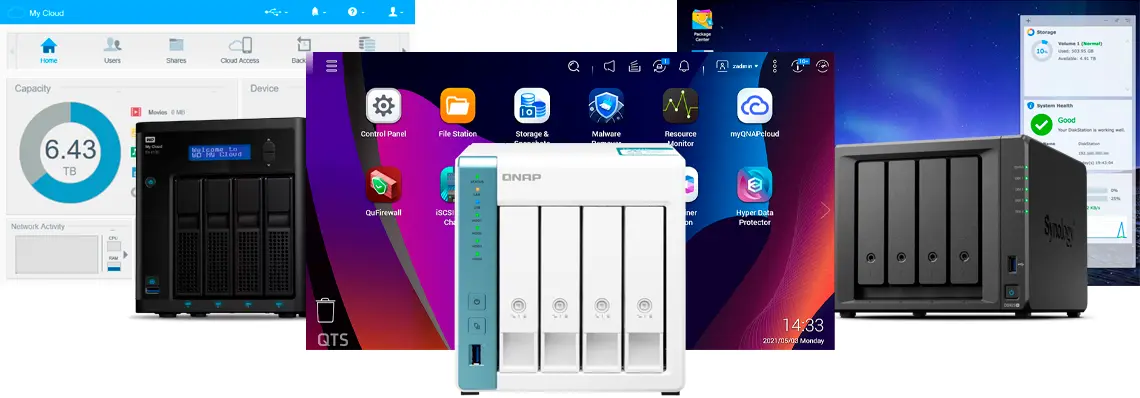

Em um cenário empresarial onde os dados são o ativo mais estratégico, a escolha do sistema de armazenamento correto é decisiva para garantir a integridade, performance e disponibilidade das informações corporativas. Os dispositivos NAS (Network Attached Storage) de 4 baias da QNAP destacam-se como soluções robustas, flexíveis e tecnológicas, capazes de atender desde pequenas empresas até ambientes que demandam alto desempenho e segurança.

Contextualização Estratégica e Desafios Empresariais

O volume crescente de dados gerados pelas organizações exige soluções de armazenamento que não apenas armazenem informações, mas que ofereçam agilidade, confiabilidade e facilitem a gestão centralizada. Uma decisão inadequada na escolha do NAS pode acarretar falhas, perdas de dados e custos elevados de recuperação, impactando diretamente a continuidade do negócio e sua competitividade.

Os desafios enfrentados pelas empresas incluem a necessidade de manter sistemas ativos 24/7, garantir proteção contra falhas e ataques, além de escalabilidade para suportar crescimento e demandas variáveis. Assim, os NAS QNAP de 4 baias surgem como alternativas capazes de superar esses desafios através de hardware e software integrados, focados em performance e segurança.

Problema Estratégico: A Escolha do NAS Adequado para Suporte à Operação

A escolha de um NAS envolve compreender as demandas específicas da operação, desde o tipo de processamento necessário até a interoperabilidade com sistemas existentes. O impacto de uma infraestrutura mal dimensionada pode ser sentido na lentidão do acesso aos dados, indisponibilidade de serviços e vulnerabilidades de segurança, especialmente para operações que demandam alta performance em backup, virtualização ou streaming de mídia.

A QNAP oferece no mercado modelos equipados com processadores eficientes, memória expansível e múltiplas opções de conectividade, garantindo que a solução atenda desde tarefas básicas até operações mais críticas, como transcodificação de vídeo e ambientes com alta carga de trabalho.

Fundamentos Técnicos das Soluções NAS 4 Baias QNAP

O modelo TS-431K exemplifica a proposta QNAP para o segmento de NAS 4 baias, combinando um processador quad-core de 1,7 GHz e suporte a até 4 GB de RAM, configurável conforme as necessidades do usuário. Essa arquitetura permite um balanceamento entre desempenho e custo, ideal para quem busca um armazenamento seguro e eficiente sem comprometer o orçamento.

O suporte a discos hot-swappable é uma característica fundamental, permitindo a substituição dos discos rígidos sem necessidade de desligar o equipamento, o que assegura alta disponibilidade do sistema e minimiza o impacto em operações contínuas. Ainda que não disponha de fontes de alimentação redundantes, o design do gabinete prioriza a facilidade de manutenção e o uso otimizado em ambientes desktop.

Além disso, os sistemas QNAP permitem configuração RAID nos níveis 0, 1, 5, 6 e 10, oferecendo equilíbrio entre desempenho e redundância, fundamental para proteger os dados contra falhas físicas dos discos e garantir continuidade operacional.

Arquitetura e Processamento

Os processadores ARM Alpine AL214 e os quad-core de 1,7 GHz garantem uma capacidade de processamento adequada para tarefas multifuncionais, desde o gerenciamento de arquivos até a execução de aplicativos avançados via QTS, o sistema operacional proprietário da QNAP. A possibilidade de expansão de memória RAM melhora ainda mais a performance em ambientes multitarefa e aplicações que demandam maior throughput.

Conectividade e Agregação de Link

Um diferencial estratégico dos modelos QNAP é a possibilidade de agregação de portas LAN (Link Aggregation), que combina múltiplas conexões físicas em uma única conexão lógica, aumentando a largura de banda e fornecendo redundância em caso de falha de alguma porta. Isso é especialmente importante para empresas que realizam grandes transferências de dados ou suportam múltiplos usuários simultaneamente.

O suporte a portas de 1 Gbps, e em alguns modelos portas de 2,5 Gbps, permite uma comunicação ágil dentro da rede corporativa, otimizando o fluxo de trabalho e a distribuição de arquivos críticos.

Software QTS e Ecossistema de Aplicações

O sistema operacional QTS, exclusivo da QNAP, é um diferencial fundamental na análise das soluções NAS. Ele entrega uma interface intuitiva e um vasto ecossistema de aplicativos que suportam desde backup automático, sincronização, virtualização, até serviços de nuvem híbrida e streaming multimídia.

Este ambiente integrado possibilita que empresas possam personalizar seu sistema de armazenamento conforme suas demandas, simplificando operações complexas e agregando valor através da automação e monitoramento em tempo real.

Segurança e Proteção de Dados

O QTS inclui funcionalidades de snapshots, que permitem gravar estados do sistema e dos dados periodicamente, protegendo contra exclusões acidentais e ataques de ransomware. Além disso, oferece criptografia avançada para garantir a confidencialidade dos dados em repouso e em trânsito.

Outras medidas de segurança incluem antivírus integrado, firewall configurável e políticas de acesso granular, essenciais para atender a requisitos de compliance e governança de dados em ambientes corporativos.

Implementação Estratégica e Melhores Práticas

A implementação de um NAS QNAP deve começar com um diagnóstico preciso das necessidades de armazenamento, desempenho e segurança da empresa. A escolha correta do modelo, configuração RAID, opções de backup e redundância, além da configuração da rede, são passos críticos para o sucesso da operação.

Recomenda-se também planejar a escalabilidade do ambiente, levando em consideração futuras demandas de capacidade e performance, bem como a integração com soluções de nuvem para maior flexibilidade e resiliência.

A manutenção preventiva, incluindo atualizações do firmware, monitoramento constante e testes periódicos de recuperação, são práticas recomendadas para evitar falhas e garantir o máximo uptime.

Considerações sobre Suporte e Garantia

A QNAP oferece uma rede de suporte técnico qualificado e uma comunidade ativa, que auxiliam os usuários na resolução de problemas e na otimização das soluções. Contar com garantia adequada e canais de atendimento especializados é essencial para minimizar riscos e proteger o investimento realizado em infraestrutura.

Medição de Sucesso: Indicadores e Monitoramento

Para garantir a eficácia da implementação, métricas como tempo de resposta, taxa de transferência de dados, disponibilidade do sistema, e frequência de backups devem ser monitoradas continuamente. Ferramentas nativas do QTS permitem relatórios detalhados, auxiliando a gestão em tomadas de decisão e ajustes operacionais.

Conclusão

Os NAS 4 baias da QNAP apresentam uma combinação equilibrada entre desempenho, segurança e custo-benefício para empresas que buscam soluções de armazenamento confiáveis e escaláveis. A arquitetura avançada, somada ao sistema operacional QTS e sua gama de aplicativos, permitem que as organizações gerenciem seus dados com eficiência, protegendo ativos críticos e suportando o crescimento futuro.

Ao optar por uma solução QNAP, o investimento não se limita ao hardware, mas inclui uma plataforma completa e flexível, que pode ser ajustada às necessidades específicas do negócio, garantindo vantagem competitiva e continuidade operacional.

Para organizações que desejam garantir a integridade e acessibilidade dos seus dados, a adoção estratégica de NAS QNAP de 4 baias é um passo fundamental para modernizar e fortalecer a infraestrutura de TI.