Introdução A Supermicro, reconhecida mundialmente como um dos principais fabricantes de soluções completas de TI para inteligência artificial, nuvem e data centers, anunciou um movimento estratégico de grande escala: a construção de seu terceiro campus em Silicon Valley. Mais do que uma simples expansão física, o projeto representa uma reconfiguração do ecossistema de inovação dos Estados Unidos, com implicações diretas na economia local, na eficiência energética e no avanço de tecnologias críticas para o futuro da infraestrutura digital global. Em um cenário onde o crescimento de aplicações baseadas em IA exige infraestruturas cada vez mais potentes e sustentáveis, a iniciativa da Supermicro responde a uma necessidade premente: repensar como os data centers são projetados, resfriados e operados. O novo campus, que deverá atingir quase 3 milhões de pés quadrados, simboliza a convergência entre expansão industrial, inovação tecnológica e compromisso ambiental — pilares que sustentam a competitividade no mercado global de TI. O artigo a seguir analisa em profundidade o impacto estratégico dessa expansão, seus fundamentos tecnológicos, a transformação da cadeia produtiva e os desdobramentos para o mercado de data centers líquidos e computação de alta performance (HPC). O problema estratégico: infraestrutura em transformação O crescimento exponencial da IA tem pressionado a infraestrutura tradicional de TI. A densidade computacional exigida por modelos generativos e inferência em larga escala ultrapassa os limites de refrigeração de data centers convencionais. Sistemas baseados apenas em ar, outrora suficientes, agora enfrentam gargalos térmicos, energéticos e de densidade. Empresas globais procuram alternativas que equilibrem desempenho, eficiência energética e sustentabilidade. Nesse contexto, a refrigeração líquida surge não apenas como tendência, mas como imperativo técnico e econômico. Entretanto, sua adoção demanda ecossistemas integrados — desde design de servidores até integração de energia e rede — o que limita a capacidade de resposta de fabricantes fragmentados. Para a Supermicro, a lacuna entre demanda e capacidade instalada representava um desafio estratégico: como manter sua liderança tecnológica e atender à nova geração de “fábricas de IA” sem comprometer agilidade, qualidade ou sustentabilidade? Consequências da inação Ignorar a transição para tecnologias líquidas e infraestruturas otimizadas para IA teria custos substanciais. Data centers baseados exclusivamente em ar tendem a apresentar elevação constante de consumo elétrico, degradação de componentes e limitações físicas que comprometem a expansão. Em um mercado onde o tempo de implantação (TTD) e o tempo de entrada em operação (TTO) determinam vantagem competitiva, atrasos de semanas podem significar milhões em perdas. Além disso, a ausência de capacidade local de produção — especialmente nos EUA — comprometeria a autonomia industrial frente a cadeias de suprimentos asiáticas e à crescente demanda doméstica por servidores otimizados para IA e HPC. A inação implicaria perda de mercado e dependência tecnológica. Fundamentos da solução: expansão e integração industrial O plano de expansão anunciado pela Supermicro vai muito além da construção física de prédios. Ele simboliza a consolidação de uma arquitetura industrial integrada, que une design, fabricação e testes de soluções completas sob o conceito de Total IT Solutions. O novo campus de Silicon Valley, que inicia com um edifício de mais de 300 mil pés quadrados, permitirá à empresa aumentar sua produção para até 5.000 racks com refrigeração a ar ou 2.000 racks com refrigeração líquida por mês. Essa capacidade de produção massiva é o coração de uma estratégia de escala e resposta rápida às demandas globais por infraestrutura de IA. A abordagem Building Block Solutions® da Supermicro — um ecossistema modular de componentes reutilizáveis que inclui placas-mãe, sistemas de energia, chassis e soluções de resfriamento — garante flexibilidade para adaptar servidores a workloads diversos, desde IA generativa até HPC e nuvem corporativa. O foco em refrigeração líquida destaca um compromisso técnico com eficiência e sustentabilidade. A empresa estima que cerca de 30% dos novos data centers adotarão esse modelo, reduzindo significativamente o consumo energético e a emissão de carbono associada à operação de grandes clusters computacionais. Implementação estratégica: ecossistema e governança tecnológica A execução desse projeto de expansão envolve coordenação entre múltiplos atores: governo municipal, fornecedores de energia e parceiros de tecnologia. O apoio do prefeito de San Jose e a colaboração com a PG&E, responsável por energia e infraestrutura, demonstram uma sinergia público-privada rara, centrada em crescimento sustentável e inovação de base local. Segundo a própria Supermicro, a nova planta criará centenas de empregos de alta qualificação, incluindo engenheiros, técnicos e profissionais corporativos. Esse investimento em capital humano é tão estratégico quanto o investimento em infraestrutura: a empresa reforça o conceito de “Made in America” como sinônimo de excelência tecnológica e soberania industrial. Do ponto de vista de governança, a Supermicro mantém o controle integral sobre design, fabricação e testes — um modelo verticalizado que minimiza riscos de fornecimento e garante consistência de qualidade. A expansão também integra princípios de Green Computing, alinhando-se às metas de eficiência energética e redução de emissões impostas por regulações ambientais e por clientes corporativos globais. Melhores práticas avançadas: inovação sustentável e tempo de implantação Entre as práticas mais relevantes da Supermicro destacam-se a otimização de Time-to-Deployment (TTD) e Time-to-Online (TTO). Ao reduzir o intervalo entre fabricação e operação efetiva, a empresa melhora o ciclo de entrega e acelera o retorno sobre investimento para seus clientes. Isso é particularmente crítico em projetos de IA, onde a demanda por capacidade de processamento evolui rapidamente. A padronização modular da linha Building Block Solutions® também promove interoperabilidade entre gerações de hardware, permitindo atualizações graduais sem substituição total da infraestrutura. Essa abordagem reduz o custo total de propriedade (TCO) e prolonga o ciclo de vida operacional de data centers. Por fim, o investimento em refrigeração líquida demonstra uma visão de longo prazo. O resfriamento direto por líquido, ao reduzir o consumo de energia elétrica em comparação com sistemas de ar condicionado, cria um efeito cascata de eficiência — menores custos operacionais, menor necessidade de manutenção e melhor densidade computacional por rack. Medição de sucesso: impacto econômico e tecnológico A eficácia dessa expansão pode ser avaliada por métricas objetivas e intangíveis. Entre os indicadores tangíveis estão o número de racks entregues mensalmente, a capacidade

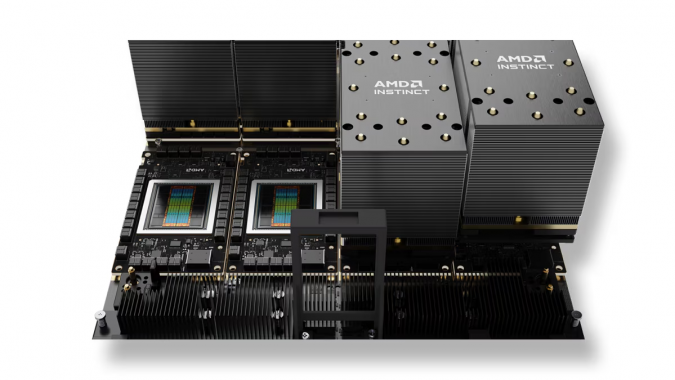

Introdução A corrida por poder computacional nunca foi tão intensa quanto em 2025. À medida que o avanço da inteligência artificial redefine indústrias inteiras, os chips que sustentam esse ecossistema tornam-se ativos estratégicos de valor incomensurável. O mais recente capítulo dessa disputa foi escrito pela AMD e pela OpenAI, que anunciaram um acordo bilionário para fornecimento de aceleradores de IA com potencial para reconfigurar o equilíbrio de poder no mercado dominado pela Nvidia. O compromisso prevê que a OpenAI adquira até 6 gigawatts em aceleradores da AMD nos próximos cinco anos, com o primeiro lote baseado na GPU Instinct MI450, prevista para o segundo semestre de 2026. Mais do que uma transação comercial, esse acordo reflete a transformação estrutural da infraestrutura de IA — onde a inferência passa a ser o motor econômico central, e a dependência tecnológica torna-se uma vulnerabilidade estratégica. Empresas que não compreenderem as implicações dessa aliança correm o risco de perder competitividade em um mercado em que o controle sobre a capacidade de processamento equivale a dominar o próprio ciclo de inovação. Este artigo aprofunda o contexto, as motivações e as implicações técnicas e empresariais dessa parceria. O problema estratégico: escassez e dependência tecnológica Nos últimos anos, o mercado global de IA enfrentou um problema recorrente: a escassez crônica de GPUs capazes de atender à demanda crescente por treinamento e inferência de modelos de larga escala. A Nvidia, líder incontestável no segmento, viu suas receitas crescerem quase sete vezes em quatro anos, alcançando US$ 130,5 bilhões em 2025. Esse domínio, porém, criou uma dependência estrutural que limita a expansão de empresas emergentes de IA, incluindo a própria OpenAI. Do ponto de vista estratégico, depender de um único fornecedor representa um risco de concentração inaceitável. A Nvidia, mesmo com sua capacidade industrial sem precedentes, não consegue atender à demanda insaciável por aceleradores de IA, criando gargalos que comprometem cronogramas e aumentam custos de operação. Esse cenário levou a OpenAI a diversificar suas fontes de hardware — primeiro com Broadcom e agora com AMD — em busca de resiliência e autonomia tecnológica. Além disso, o foco crescente na inferência de IA — ou seja, na execução prática de modelos em ambiente produtivo — exige arquiteturas otimizadas para eficiência energética e densidade computacional. Essa transição impõe novas exigências aos fornecedores de chips e redefine o que significa “liderança” em aceleração de IA. Consequências da inação Ignorar a necessidade de diversificação de hardware e de investimentos em capacidade de inferência é uma aposta perigosa. A falta de alternativas à Nvidia não apenas cria vulnerabilidade operacional, mas também limita o poder de negociação das empresas consumidoras de chips, concentrando inovação e margem de lucro em um único polo. Para provedores de nuvem, como Microsoft, Google e Meta, a ausência de fornecedores alternativos significa custos crescentes e menor flexibilidade arquitetônica em seus data centers. Para a OpenAI, o impacto é ainda mais direto: sem acesso contínuo a chips de alto desempenho, sua capacidade de oferecer inferência comercial em escala — base de sua receita futura — ficaria comprometida. A consequência estratégica seria dupla: estagnação tecnológica e perda de vantagem competitiva. Em mercados guiados por ciclos rápidos de aprendizado e adaptação, atrasos de meses podem significar anos de desvantagem acumulada. Fundamentos da solução: o papel do MI450 No centro do acordo entre AMD e OpenAI está o Instinct MI450, sucessor da série MI300X, projetado para competir diretamente com os superchips Vera Rubin da Nvidia. A arquitetura do MI450 incorpora avanços em memória de alta largura de banda (HBM4) e densidade de processamento, oferecendo até 432 GB de memória e desempenho superior a 40 PFLOPs em FP4. Essas especificações representam mais do que um salto técnico — são a base de uma nova geração de infraestrutura de inferência, projetada para maximizar throughput, reduzir latência e otimizar consumo energético. Comparado ao Vera Rubin, com 288 GB de HBM4 e 50 PFLOPs, o MI450 oferece uma proposta de equilíbrio entre eficiência, escalabilidade e custo total de propriedade (TCO). Do ponto de vista empresarial, o MI450 posiciona a AMD como uma alternativa concreta em um mercado até então monopolizado. Essa pluralidade de oferta pode catalisar um ciclo virtuoso de inovação, reduzindo preços e aumentando o acesso a tecnologias de ponta para novas empresas e centros de pesquisa. Implementação estratégica: arquitetura e impacto empresarial Implementar o MI450 em escala requer mais do que integração de hardware — envolve planejamento arquitetônico e reengenharia de workloads. As cargas de trabalho de inferência demandam otimização de pipelines de dados, suporte a formatos quantizados como FP4 e integração com frameworks como PyTorch e TensorRT. A AMD, historicamente atrás da Nvidia nesse ecossistema, vem investindo em camadas de software e bibliotecas abertas que reduzam essa distância. Para a OpenAI, a adoção estratégica da linha Instinct representa um movimento de diversificação inteligente. Ao construir infraestrutura com múltiplos fornecedores, a empresa reduz o risco de interrupções de fornecimento e aumenta a resiliência operacional. Além disso, cria condições para testar arquiteturas híbridas, combinando chips AMD e Nvidia de acordo com o perfil de cada workload. Essa abordagem também tem implicações financeiras. A troca por warrants equivalentes a 10% das ações da AMD consolida uma relação de longo prazo, alavancando valor para ambas as partes: a AMD garante demanda previsível e legitimidade no mercado de IA, enquanto a OpenAI obtém prioridade em fornecimento e acesso antecipado a novas gerações de chips. Melhores práticas avançadas e desafios técnicos Embora a adoção do MI450 represente uma oportunidade, sua integração não está isenta de desafios. O principal deles é o ecossistema de software. O domínio da Nvidia não se deve apenas à superioridade de hardware, mas à maturidade do CUDA e de seu stack completo de ferramentas, otimizadas para cada geração de GPU. A AMD precisa consolidar sua plataforma ROCm como um ambiente robusto, compatível e eficiente para execução de cargas de inferência de larga escala. Para isso, empresas como a OpenAI tornam-se parceiras críticas na validação de performance, escalabilidade e interoperabilidade. Cada avanço obtido nesse contexto representa um

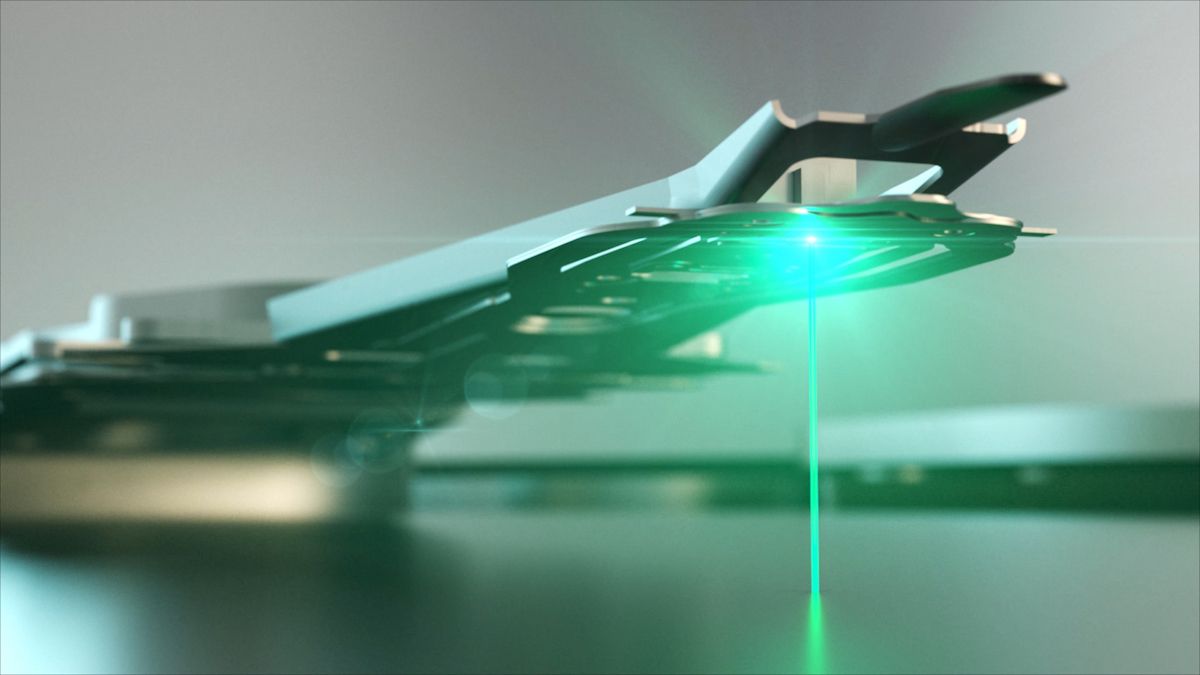

Discos HAMR: A Próxima Fronteira em Armazenamento de Dados para Pesquisadores e Data Centers Resumo Na era da informação, onde dados são o novo ouro, pesquisadores e centros de processamento de dados, como hospitais e data centers, estão constantemente em busca de soluções de armazenamento que sejam não apenas eficientes, mas também expansíveis e confiáveis. A tecnologia de Gravação Magnética Assistida por Calor (HAMR – Heat-Assisted Magnetic Recording) surge como uma resposta a essa demanda crescente. Este artigo visa esclarecer, de forma acessível, o que são os discos HAMR e como eles podem ser aplicados nesses campos críticos. O Que São Discos HAMR? Discos HAMR são dispositivos de armazenamento que utilizam uma tecnologia avançada para aumentar drasticamente a capacidade de armazenamento de dados. Através do uso de um feixe de laser que aquece a superfície do disco, é possível gravar informações em partículas magnéticas muito menores do que as utilizadas em tecnologias anteriores. Isso significa que os discos HAMR têm potencial para armazenar dados na ordem de terabytes (TB) ou até petabytes (PB) em um único dispositivo. Por Que os Discos HAMR São Importantes para Pesquisadores e Data Centers?Capacidade de Armazenamento Ampliada: Em campos como pesquisa científica e processamento de dados em larga escala, a capacidade de armazenar grandes volumes de dados é crucial. Os discos HAMR oferecem essa capacidade, permitindo que grandes conjuntos de dados sejam mantidos próximos ao local de processamento, o que pode ser vital para análises rápidas e eficientes. Durabilidade e Confiabilidade: A integridade dos dados é fundamental, especialmente em hospitais onde os registros médicos precisam ser preservados por muitos anos. Os discos HAMR são projetados para serem robustos e confiáveis, garantindo que os dados sejam seguros ao longo do tempo. Eficiência Energética: Data centers buscam constantemente reduzir o consumo de energia. Com maior densidade de armazenamento, os discos HAMR podem armazenar mais dados em menos espaço físico, o que pode levar a uma redução significativa no consumo de energia. Aplicações Recomendadas Pesquisa Científica e AcadêmicaPesquisadores que lidam com grandes conjuntos de dados, como aqueles encontrados em genômica ou pesquisas climáticas, podem se beneficiar enormemente dos discos HAMR. A capacidade de armazenar vastas quantidades de dados permite uma análise mais complexa e a possibilidade de descobrir novas informações sem o gargalo do espaço de armazenamento. Hospitais e Registros MédicosHospitais e outras instituições de saúde produzem uma quantidade imensa de dados. Os discos HAMR podem ser usados para armazenar registros médicos, imagens de diagnóstico de alta resolução e sequenciamentos genéticos, garantindo que essas informações críticas sejam acessíveis rapidamente e mantidas seguras por longos períodos. Data CentersData centers, que são o coração do armazenamento e processamento de dados na nuvem, podem se beneficiar da alta densidade e durabilidade dos discos HAMR. Isso é crucial para serviços que exigem grande capacidade de armazenamento e alta velocidade de acesso, como streaming de vídeo, serviços em nuvem e grandes bancos de dados empresariais. Análise FinanceiraInstituições financeiras geram e processam uma quantidade substancial de dados transacionais e de mercado. Os discos HAMR podem ser utilizados para armazenar e analisar esses dados, ajudando na identificação de tendências do mercado e na tomada de decisões baseadas em dados. Inteligência Artificial e Aprendizado de MáquinaA IA e o aprendizado de máquina requerem o processamento e armazenamento de grandes volumes de dados para treinamento de modelos. Com os discos HAMR, os cientistas de dados podem manter extensos datasets necessários para treinar algoritmos mais sofisticados. Serviços de Emergência e DefesaOrganizações que lidam com operações críticas, como serviços de emergência e defesa nacional, podem utilizar os discos HAMR para armazenar informações operacionais e de inteligência. A confiabilidade e capacidade ampliada são essenciais para a operação eficaz desses serviços. Arquivamento Digital a Longo PrazoInstituições que precisam manter arquivos digitais por longos períodos, como bibliotecas digitais e arquivos nacionais, encontrarão nos discos HAMR uma solução para preservar a história digital da humanidade. Essas aplicações são apenas a ponta do iceberg quando se trata do potencial dos discos HAMR. À medida que a tecnologia amadurece e se torna mais acessível, espera-se que seu uso se torne mais difundido, abrindo novas fronteiras no campo do armazenamento de dados. Conclusão Para pesquisadores e centros de processamento de dados que buscam otimizar suas capacidades de armazenamento, os discos HAMR representam uma tecnologia promissora, oferecendo avanços significativos em termos de capacidade, durabilidade e eficiência energética. À medida que a tecnologia HAMR continua a amadurecer, espera-se que ela desempenhe um papel crucial no gerenciamento da crescente enxurrada de informações digitais nos campos mais exigentes da ciência e da indústria. Palavras-chave: Discos HAMR, armazenamento de dados, data centers, pesquisa científica, registros médicos, eficiência energética, tecnologia de armazenamento.