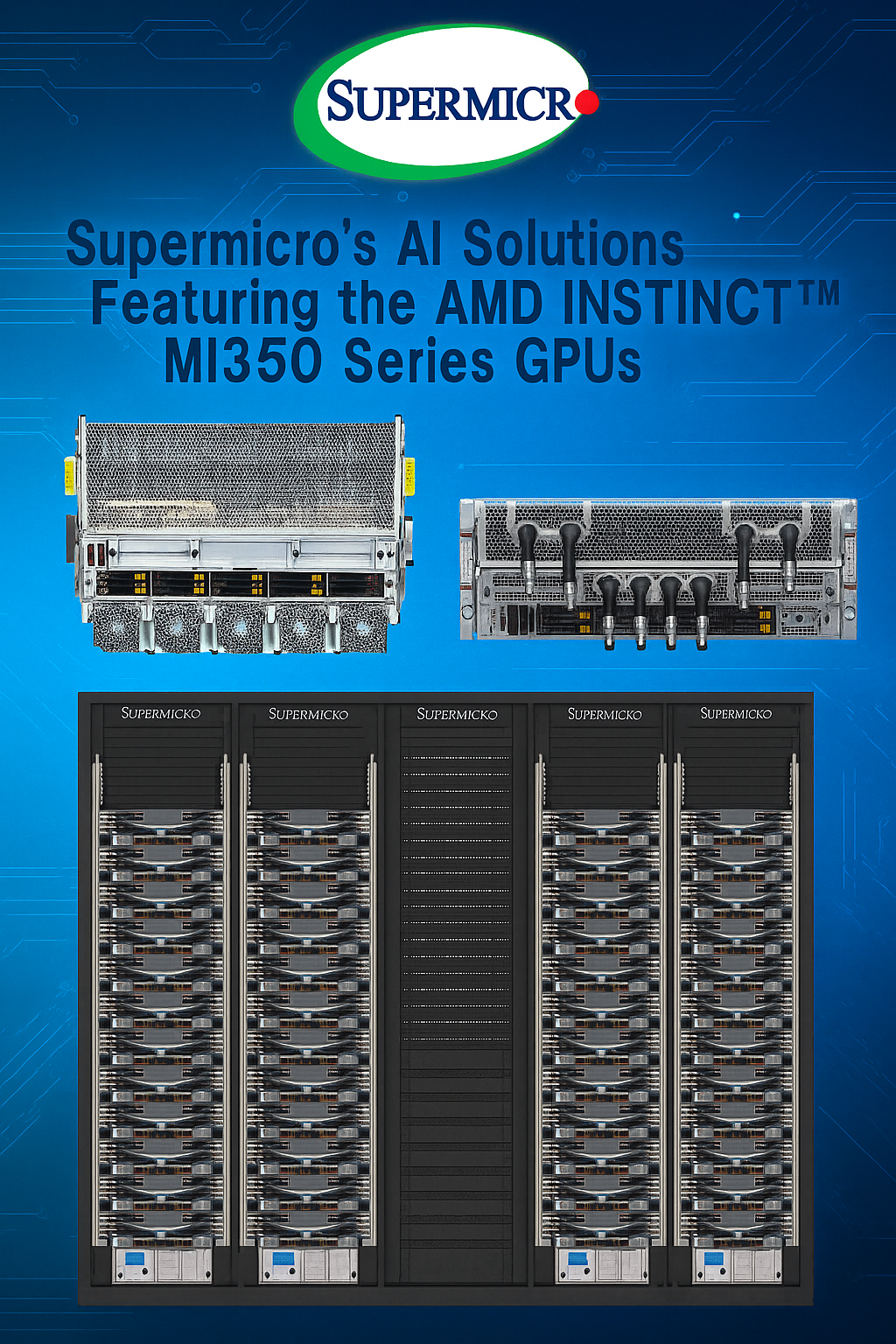

Supermicro H14 com AMD Instinct MI350: Potência máxima em IA e eficiência energética

Introdução

O avanço da inteligência artificial (IA) corporativa está diretamente ligado à evolução das arquiteturas de hardware que a suportam. Em um cenário onde modelos de linguagem, análise preditiva, inferência em tempo real e simulações científicas exigem processamento maciço, a eficiência energética e a escalabilidade se tornaram tão críticas quanto a própria capacidade de cálculo. Nesse contexto, a Supermicro, combinando sua expertise em soluções de data center e HPC, apresenta a geração H14 de servidores GPU equipados com as novas GPUs AMD Instinct™ MI350 Series, baseadas na arquitetura AMD CDNA™ de 4ª geração.

Essas soluções foram projetadas para ambientes empresariais de missão crítica, capazes de lidar com treinamento e inferência de grandes modelos de IA, mantendo baixo custo total de propriedade (TCO) e alta densidade computacional. A combinação de GPUs AMD Instinct MI350, CPUs AMD EPYC™ 9005 e opções avançadas de resfriamento a líquido ou a ar entrega não apenas desempenho extremo, mas também flexibilidade de implementação para diferentes perfis de data center.

Este artigo apresenta uma análise detalhada da abordagem técnica e estratégica da Supermicro com a linha H14, explorando os desafios que ela resolve, seus fundamentos de arquitetura, melhores práticas de adoção e métricas para avaliar seu sucesso em cenários reais.

O problema estratégico

Empresas que atuam na fronteira da IA enfrentam uma barreira dupla: por um lado, a demanda por poder computacional cresce exponencialmente; por outro, as limitações físicas e energéticas dos data centers impõem restrições severas. O aumento do tamanho dos modelos e o volume de dados a serem processados pressiona não apenas a CPU, mas sobretudo a GPU e a memória de alta largura de banda.

Sem infraestrutura adequada, organizações acabam comprometendo a velocidade de treinamento, limitando a complexidade dos modelos ou elevando drasticamente o consumo energético — um fator que impacta tanto o orçamento quanto as metas ambientais de ESG. A ausência de soluções que conciliem alto desempenho com eficiência energética representa uma perda competitiva significativa.

Consequências da inação

Ignorar a modernização da infraestrutura de IA significa aceitar tempos de processamento mais longos, custos operacionais mais altos e menor capacidade de resposta a demandas de negócio. Modelos que poderiam ser treinados em dias passam a levar semanas, comprometendo a agilidade na entrega de novos serviços baseados em IA. Além disso, sem sistemas projetados para lidar com alta densidade térmica, o risco de falhas e degradação prematura de hardware aumenta substancialmente.

No cenário competitivo atual, a latência na entrega de soluções de IA não é apenas um problema técnico — é uma ameaça direta à relevância no mercado.

Fundamentos da solução

A resposta da Supermicro é uma arquitetura modular e otimizada para cargas de trabalho intensivas em IA, suportada pelas GPUs AMD Instinct MI350 Series. Baseada na arquitetura AMD CDNA™ de 4ª geração, essa linha oferece até 288 GB de memória HBM3e por GPU, totalizando impressionantes 2,304 TB em servidores de 8 GPUs. Essa configuração não apenas amplia a capacidade de memória em 1,5x em relação à geração anterior, como também proporciona largura de banda de 8 TB/s, essencial para alimentar modelos de IA com volumes massivos de dados.

O salto de desempenho é igualmente significativo: até 1,8x petaflops de FP16/FP8 em relação ao modelo MI325X, com novos formatos FP6 e FP4 que aumentam a eficiência em inferência e treinamento. Essa potência é combinada a CPUs AMD EPYC 9005, garantindo equilíbrio entre processamento paralelo massivo e tarefas de coordenação e pré-processamento de dados.

Eficiência energética integrada

Os sistemas H14 oferecem opções de resfriamento a líquido (4U) e a ar (8U). O design de Resfriamento Líquido Direto (DLC) aprimorado da Supermicro pode reduzir o consumo de energia em até 40%, resfriando não apenas as GPUs, mas múltiplos componentes críticos, o que maximiza o desempenho por rack e viabiliza operações em alta densidade.

Interoperabilidade e padrões abertos

A adoção do Módulo Acelerador OCP (OAM), um padrão aberto da indústria, garante que as soluções sejam compatíveis com múltiplas arquiteturas e simplifica a integração em infraestruturas OEM já existentes, reduzindo barreiras para atualização de data centers.

Implementação estratégica

Para adoção efetiva das soluções H14 com AMD MI350, as empresas devem alinhar a implementação ao perfil de carga de trabalho. Treinamento de modelos de grande escala se beneficia mais de configurações líquidas de alta densidade, enquanto cargas de inferência distribuída podem operar eficientemente em versões refrigeradas a ar.

A estratégia de implementação deve considerar:

- Topologia de rede interna: maximizar a largura de banda entre GPUs e nós para evitar gargalos na troca de parâmetros durante o treinamento.

- Planejamento térmico: avaliar a infraestrutura existente para suportar DLC ou identificar melhorias necessárias para refrigeração eficiente.

- Balanceamento de custo e desempenho: identificar o ponto ótimo entre investimento inicial e ganhos em tempo de processamento, considerando o TCO ao longo do ciclo de vida.

Melhores práticas avançadas

Dimensionamento baseado em métricas reais

Antes da aquisição, realizar benchmarks internos com modelos representativos das cargas de trabalho reais garante que a configuração seja dimensionada corretamente.

Integração com ecossistema AMD ROCm™

As GPUs AMD MI350 são suportadas pela plataforma ROCm, que oferece bibliotecas e ferramentas otimizadas para IA e HPC. Integrar esses recursos ao pipeline de desenvolvimento acelera a entrega de soluções.

Governança e compliance

Com maior capacidade de processamento e armazenamento, cresce também a responsabilidade sobre segurança de dados. É essencial implementar criptografia em trânsito e em repouso, além de controles de acesso rigorosos, especialmente em projetos que envolvem dados sensíveis.

Medição de sucesso

A avaliação do sucesso da implementação deve ir além de benchmarks sintéticos. Indicadores recomendados incluem:

- Redução no tempo de treinamento de modelos-chave.

- Eficiência energética medida em operações reais (watts por token processado).

- Escalabilidade do ambiente sem perda de desempenho linear.

- Taxa de utilização efetiva das GPUs e memória HBM3e.

Conclusão

As soluções Supermicro H14 com GPUs AMD Instinct MI350 representam um avanço significativo para empresas que buscam impulsionar sua capacidade de IA com equilíbrio entre potência, eficiência e flexibilidade. Ao combinar arquitetura de última geração, opções avançadas de resfriamento e integração plena com o ecossistema AMD, esses servidores oferecem uma plataforma sólida para enfrentar os desafios crescentes do processamento de IA em escala.

Com capacidade de atender desde provedores de nuvem até empresas com data centers privados, a linha H14 reafirma o compromisso da Supermicro em entregar soluções de alto desempenho alinhadas às demandas de mercado e à sustentabilidade operacional. No horizonte, a adoção de formatos FP6 e FP4 e a consolidação de padrões abertos indicam um caminho de evolução contínua, mantendo empresas preparadas para a próxima geração de IA corporativa.