Supermicro 4U GPU Server NVIDIA HGX H100/H200: Desempenho Máximo para HPC e IA

Em um cenário empresarial em que o poder computacional é determinante para inovação e competitividade, o Supermicro 4U GPU Server com NVIDIA HGX H100/H200 representa uma solução estratégica. Projetado para suportar cargas de trabalho críticas em High Performance Computing (HPC), Inteligência Artificial (IA), Large Language Models (LLM) e Natural Language Processing (NLP), este servidor oferece densidade de GPU e capacidade de memória excepcionais, garantindo que organizações possam processar grandes volumes de dados de maneira confiável e eficiente.

O desafio central das organizações modernas é equilibrar desempenho computacional com escalabilidade, confiabilidade e eficiência energética. Sistemas tradicionais muitas vezes enfrentam gargalos em throughput de GPU e memória, comprometendo o tempo de execução de modelos complexos de IA e análise de dados massiva. A implementação de um servidor otimizado como o Supermicro 4U permite mitigar esses riscos, proporcionando um ambiente robusto e preparado para expansão futura.

Custos e riscos da inação incluem atrasos em projetos de IA, maior consumo energético por GPU mal dimensionada, riscos de downtime devido à limitação de resfriamento e dificuldades em atender à demanda crescente por processamento paralelo. Este artigo explorará detalhadamente a arquitetura, recursos técnicos, estratégias de implementação e métricas de sucesso do Supermicro 4U GPU Server, fornecendo uma análise profunda e estratégica para equipes de TI e decisão empresarial.

Problema Estratégico

Desafios de Desempenho em HPC e IA

Organizações que dependem de HPC e workloads de IA enfrentam desafios críticos relacionados à largura de banda da GPU, comunicação CPU-GPU e gestão de memória. Modelos LLM de grande escala e tarefas complexas de NLP exigem memória de alta velocidade e interconexão eficiente entre GPUs. O Supermicro 4U GPU Server endereça essas limitações com suporte a NVIDIA SXM HGX H100/H200, fornecendo interconexão NVLink entre GPUs e PCIe 5.0 x16 para comunicação CPU-GPU, maximizando throughput e reduzindo latência.

Riscos Operacionais e Custos Ocultos

A falta de infraestrutura adequada leva a uso ineficiente de recursos, aumento do TCO e dificuldades de manutenção. Problemas de resfriamento e monitoramento podem resultar em degradação precoce de GPUs ou falhas de memória. Com 32 DIMM slots suportando até 8TB de ECC DDR5 4800/5600 MT/s, o servidor garante redundância e confiabilidade, mitigando riscos de perda de dados ou interrupção de processos críticos.

Fundamentos da Solução

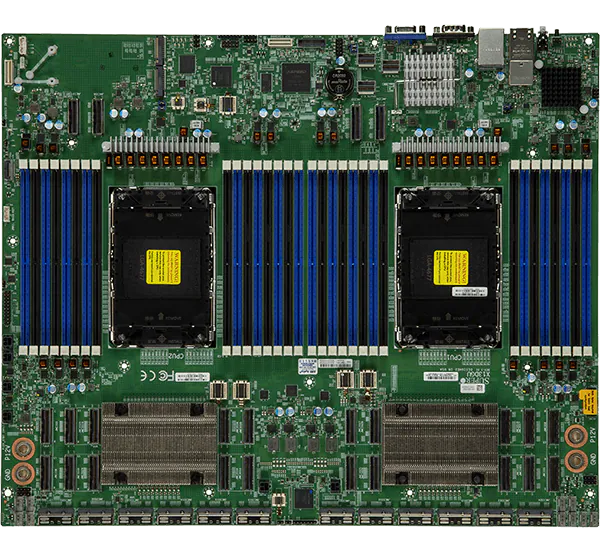

Arquitetura do Supermicro 4U GPU Server

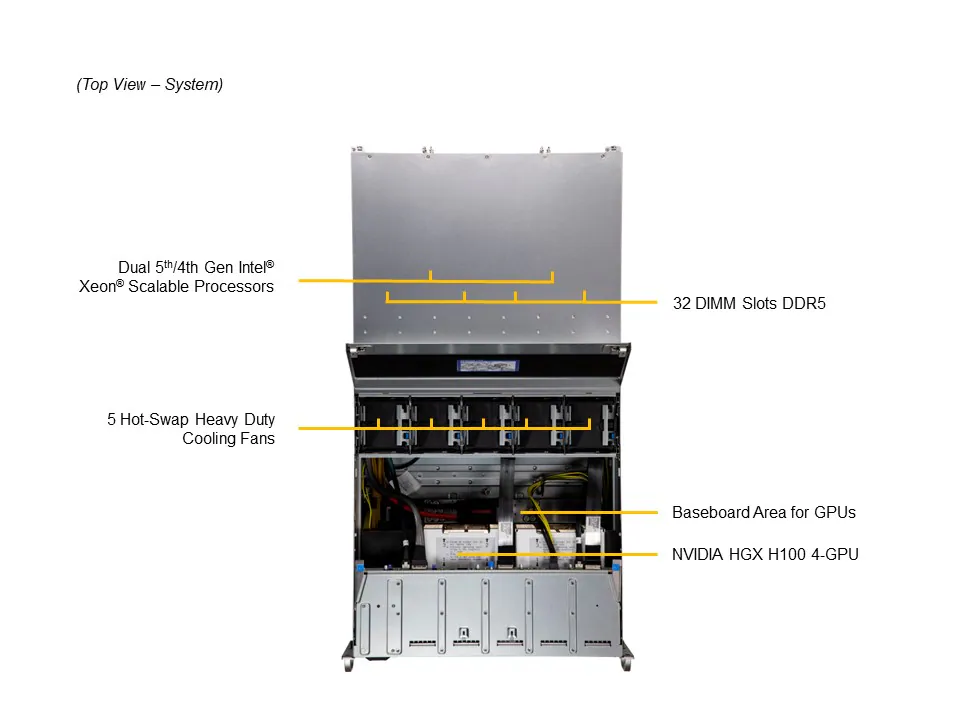

O Supermicro SYS-421GU-TNXR é baseado na motherboard Super X13DGU, suportando CPUs Dual Socket E (LGA-4677) com até 56 cores/112 threads, e TDP de até 350W. Este design oferece flexibilidade para cargas de trabalho intensivas e escalabilidade futura, permitindo suporte a até quatro GPUs HGX H100/H200 onboard. O chipset Intel C741 garante compatibilidade de rede e integração de dispositivos on-board.

Memória e Interconexões

Com 32 slots DIMM, o servidor possibilita até 8TB de memória ECC DDR5, crítica para tarefas de IA que demandam datasets massivos. A comunicação GPU-GPU via NVLink e CPU-GPU via PCIe 5.0 x16 reduz gargalos, enquanto suporte a 8 PCIe Gen 5.0 X16 LP slots permite expansão de aceleradores adicionais ou placas de rede de alta velocidade.

Implementação Estratégica

Configuração de GPU e Armazenamento

A solução conta com seis baias hot-swap 2.5″ para NVMe/SATA/SAS, e dois slots M.2 para boot drive, garantindo alta performance e confiabilidade. A estratégia de implementação envolve otimização do layout de armazenamento para maximizar IOPS, alinhada à densidade de GPU para reduzir latência de acesso a dados críticos.

Gerenciamento e Segurança

O servidor integra software avançado como SuperCloud Composer, SSM, SUM e SuperDoctor 5, permitindo monitoramento e automação completa. Recursos de segurança incluem TPM 2.0, Silicon Root of Trust, Secure Boot e criptografia de firmware, alinhando-se às práticas NIST 800-193. Estratégias de mitigação de falhas incluem monitoramento contínuo de temperatura, voltagem e velocidade de fans PWM.

Melhores Práticas Avançadas

Otimização de Resfriamento e Eficiência Energética

O sistema utiliza até cinco fans de alto desempenho, air shroud e suporte a Direct-to-Chip Cold Plate para resfriamento líquido opcional. Implementações recomendam monitoramento dinâmico de RPM e ajustes automatizados conforme carga de GPU, reduzindo riscos térmicos e aumentando a vida útil do hardware.

Escalabilidade e Flexibilidade

A arquitetura modular permite upgrades incrementais de memória, GPUs e storage, garantindo que investimentos acompanhem crescimento de demanda. O design 4U balanceia densidade e facilidade de manutenção, essencial para data centers com limitações de rackspace.

Medição de Sucesso

Métricas de Desempenho

Indicadores críticos incluem throughput de GPU, latência de memória, utilização de CPU e tempo médio de processamento de workloads de IA. Métricas de confiabilidade incluem uptime, integridade de dados em memória ECC e eficiência energética medida em FLOPS/Watt.

Governança e Compliance

Monitoramento contínuo do hardware aliado a políticas de segurança e auditoria garante compliance com normas internas e externas, mitigando riscos regulatórios e assegurando operação contínua em workloads sensíveis.

Conclusão

O Supermicro 4U GPU Server com NVIDIA HGX H100/H200 oferece uma solução completa para organizações que buscam desempenho máximo em HPC, IA, LLM e NLP. Sua arquitetura de alta densidade, memória massiva, interconexões avançadas e gestão de segurança consolidam a confiabilidade operacional.

Empresas que adotarem esta solução poderão reduzir riscos operacionais, acelerar projetos de IA e otimizar eficiência energética. A flexibilidade e escalabilidade permitem crescimento progressivo, enquanto a integração com softwares de gerenciamento garante monitoramento proativo.

Perspectivas futuras incluem adaptação a novas gerações de GPUs, maior automação de resfriamento e inteligência preditiva em manutenção. O próximo passo para organizações interessadas é alinhar configuração de hardware com workloads específicos e políticas de segurança corporativa, garantindo máxima eficiência e retorno sobre investimento.