Servidor 4U AMD com 8 GPUs NVIDIA HGX: Alto Desempenho para IA e HPC

Introdução

No atual cenário empresarial, a demanda por processamento de alto desempenho para Inteligência Artificial (IA), Deep Learning e aplicações HPC é crescente. Organizações enfrentam desafios críticos relacionados à capacidade de computação, velocidade de interconexão entre GPUs e eficiência energética. Sistemas tradicionais muitas vezes não suportam as cargas de trabalho de IA em larga escala, resultando em atrasos, ineficiência e custos operacionais elevados.

A inação frente a essas necessidades pode acarretar perda de competitividade e limitações estratégicas, especialmente em pesquisa científica, análise de dados avançada e desenvolvimento de modelos de machine learning. Implementações inadequadas podem gerar gargalos de I/O, falhas de comunicação GPU-GPU e desperdício de recursos energéticos.

Este artigo apresenta uma análise detalhada do servidor Supermicro DP AMD 4U Liquid-Cooled com 8 GPUs NVIDIA HGX H100/H200, abordando fundamentos técnicos, implementação estratégica, trade-offs, métricas de sucesso e melhores práticas, conectando cada aspecto técnico aos impactos de negócio.

Desenvolvimento

Problema Estratégico

Empresas que dependem de processamento intensivo em IA enfrentam desafios significativos de escalabilidade e throughput. A interconexão eficiente entre múltiplas GPUs é crucial para evitar gargalos em treinamento de modelos de deep learning e simulações HPC. Servidores convencionais não suportam NVLink em larga escala nem oferecem redundância energética e cooling avançado, limitando a confiabilidade operacional.

Além disso, a crescente complexidade de pipelines de machine learning e cargas de trabalho analíticas exige memória de alta capacidade e comunicação rápida entre CPU e GPU, algo que sistemas tradicionais PCIe não conseguem otimizar, impactando diretamente no tempo de treinamento de modelos e na velocidade de entrega de insights estratégicos.

Consequências da Inação

Não atualizar a infraestrutura de servidores para suportar alta densidade de GPU acarreta custos elevados: maior consumo energético, maior espaço físico ocupado, latência em processamento de dados críticos e aumento do risco de falhas de hardware durante operações de ponta. Falhas em comunicação GPU-GPU podem degradar significativamente a performance de modelos de IA, atrasando projetos estratégicos e impactando decisões baseadas em dados.

Empresas podem ainda enfrentar desafios de compliance e segurança, já que soluções tradicionais não oferecem suporte a Trusted Platform Module (TPM) 2.0, Root of Trust ou Secure Boot, deixando vulnerabilidades abertas para ataques sofisticados ou falhas de firmware não detectadas.

Fundamentos da Solução

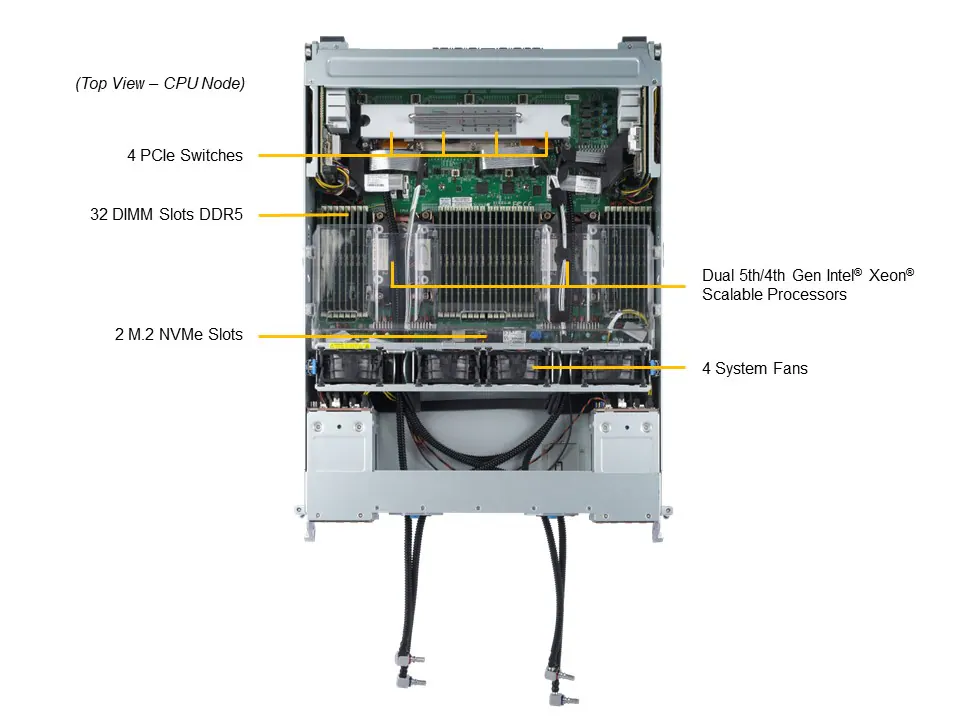

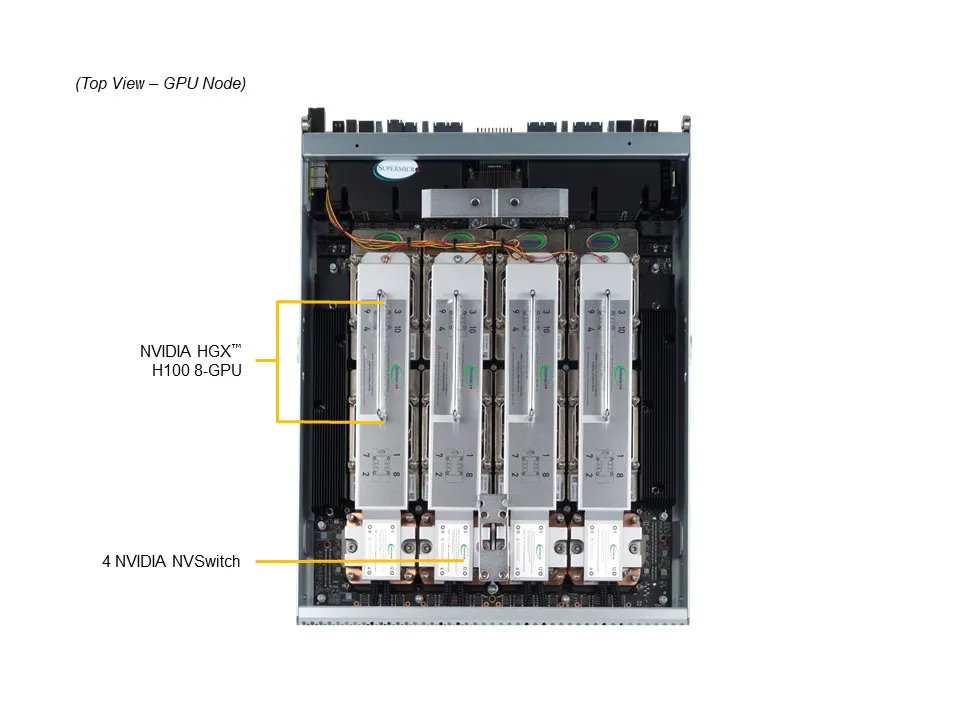

O servidor Supermicro DP AMD 4U é construído para alta densidade de GPU com suporte a até 8 GPUs NVIDIA HGX H100/H200, cada uma conectada via NVLink e NVSwitch, garantindo comunicação ultra-rápida entre unidades. O suporte a PCIe 5.0 x16 permite throughput máximo entre CPU e GPU, essencial para cargas de trabalho intensivas de IA.

O uso de processadores AMD EPYC 9004/9005 em configuração dual-socket, com até 128 cores e 6TB de DDR5 ECC, fornece capacidade de memória suficiente para manipulação de grandes datasets e treinamento de modelos complexos. A redundância energética (4x 5250W Titanium) e o sistema de refrigeração líquida (D2C Cold Plate) garantem estabilidade operacional mesmo sob carga máxima, minimizando riscos de downtime.

A arquitetura também contempla 8 NVMe drives frontais para armazenamento de dados de alta velocidade, suportando NVIDIA GPUDirect Storage e GPUDirect RDMA, o que reduz latência e overhead de CPU, aumentando eficiência e produtividade em ambientes HPC e IA.

Implementação Estratégica

Para maximizar performance, recomenda-se configurar GPUs em interconexão NVLink completa, garantindo comunicação ponto-a-ponto e redução de congestionamento em modelos distribuídos. O balanceamento da carga de trabalho entre CPUs e GPUs deve ser monitorado continuamente, usando ferramentas como Supermicro Server Manager (SSM) e SuperCloud Composer para automação e monitoramento proativo.

A refrigeração líquida requer instalação técnica especializada on-site, garantindo operação segura de CPUs de até 400W TDP e mantendo temperaturas ideais para otimização da longevidade dos componentes. Políticas de backup e redundância devem ser alinhadas com o uso de drives NVMe, garantindo integridade dos dados mesmo em falhas críticas.

Melhores Práticas Avançadas

É fundamental adotar monitoramento contínuo de temperatura, velocidade de ventiladores, consumo energético e status de GPUs usando SuperDoctor® 5 e Thin-Agent Service. A implementação de Secure Boot, firmware assinado e Supply Chain Security Remote Attestation protege contra ataques de firmware, garantindo compliance com NIST 800-193 e padrões corporativos.

O dimensionamento adequado de memória DDR5 ECC e uso de NVLink para comunicação GPU-GPU permitem treinamento de modelos de AI de grande escala sem throttling, otimizando tempo e recursos. Em cenários de multi-tenancy, recomenda-se segmentar workloads por GPU, evitando contenção e maximizando eficiência de uso de hardware.

Medição de Sucesso

Indicadores críticos incluem throughput de treinamento de IA (samples/segundo), latência de comunicação GPU-GPU, utilização de memória DDR5 e I/O NVMe, consumo energético por workload e tempo médio entre falhas (MTBF) do sistema. Métricas de monitoramento contínuo devem ser integradas a dashboards corporativos, permitindo decisões estratégicas e ajustes proativos.

O sucesso da implementação também se reflete na redução de custos operacionais por unidade de processamento e na capacidade de escalabilidade vertical sem comprometimento da performance, garantindo retorno sobre investimento e vantagem competitiva em projetos de IA e HPC.

Conclusão

O servidor Supermicro DP AMD 4U Liquid-Cooled com 8 GPUs NVIDIA HGX H100/H200 representa uma solução de alta densidade e performance para ambientes de IA, Deep Learning e HPC. Sua arquitetura avançada conecta capacidade de processamento, armazenamento rápido e segurança robusta, garantindo suporte a workloads críticos e escalabilidade futura.

A adoção desta solução reduz riscos operacionais, aumenta eficiência energética e permite que organizações acelerem projetos estratégicos de AI, mantendo compliance e integridade de dados. As melhores práticas incluem configuração otimizada de NVLink, monitoramento avançado e gestão de refrigeração líquida com suporte especializado.

Perspectivas futuras apontam para expansão de workloads de IA mais complexos, exigindo interconexões ainda mais rápidas e capacidade de memória ampliada, áreas em que esta arquitetura está preparada para evoluir sem comprometer performance. O próximo passo prático é avaliar a integração da solução no datacenter corporativo, alinhando recursos físicos, rede e segurança com objetivos estratégicos de negócio.