ASUS ESC8000A-E11: Servidor GPU para IA e HPC de Próxima Geração

No cenário atual de transformação digital e Inteligência Artificial (IA), a capacidade de processar grandes volumes de dados e treinar modelos de aprendizado profundo tornou-se um fator competitivo essencial. O ASUS ESC8000A-E11 representa a síntese entre poder computacional e eficiência térmica, oferecendo uma arquitetura projetada especificamente para cargas de trabalho intensivas em GPU, como IA generativa, simulações científicas e análise de dados em larga escala.

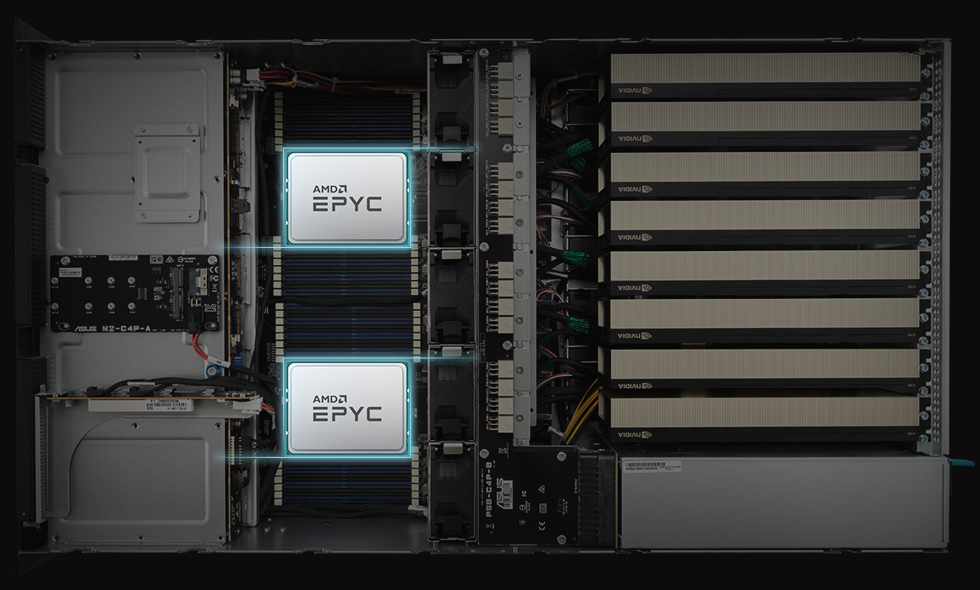

Empresas que investem em infraestrutura HPC precisam equilibrar desempenho, densidade e confiabilidade. Nesse contexto, o ESC8000A-E11 surge como uma plataforma robusta baseada em processadores AMD EPYC 7003 e suporte a até oito GPUs NVIDIA A100 ou AMD Instinct MI100, entregando escalabilidade horizontal e vertical em uma estrutura 4U otimizada para eficiência energética e segurança de firmware.

Ao longo deste artigo, exploraremos como o design do ESC8000A-E11 permite maximizar o throughput de dados, reduzir gargalos de comunicação entre GPUs e CPUs e garantir alta disponibilidade operacional em ambientes empresariais críticos.

Desafio Estratégico: Acelerando a IA e o HPC com Eficiência

Nos últimos anos, a IA corporativa e o HPC evoluíram de projetos experimentais para infraestruturas centrais de negócio. No entanto, a execução dessas cargas exige não apenas potência de GPU, mas também uma interconexão balanceada, gerenciamento térmico refinado e disponibilidade constante. A fragmentação de recursos em data centers tradicionais gera ineficiências e eleva custos operacionais.

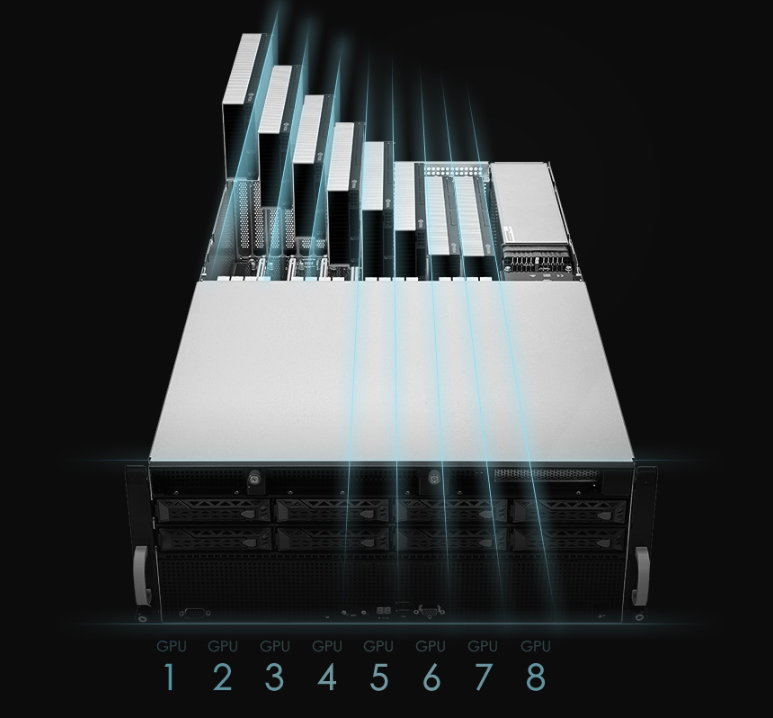

O desafio está em consolidar poder computacional sem comprometer confiabilidade ou eficiência energética. O ESC8000A-E11 foi desenhado exatamente para superar essa barreira, fornecendo um chassi 4U que abriga até oito GPUs duais-slot ativas ou passivas e múltiplas opções de expansão PCIe 4.0 x16, mantendo integridade térmica e estabilidade elétrica mesmo sob carga máxima.

Consequências da Inação

Ignorar a otimização da infraestrutura para IA e HPC resulta em tempos de treinamento mais longos, consumo excessivo de energia e baixa utilização de hardware. A consequência direta é o aumento do custo total de propriedade (TCO) e a limitação da escalabilidade de modelos de IA e simulações científicas. Organizações que continuam dependentes de arquiteturas legadas enfrentam gargalos de E/S, ineficiência de GPU e maior risco de falhas térmicas.

Além disso, a ausência de redundância energética e gestão out-of-band robusta impacta a disponibilidade de serviços críticos. O ESC8000A-E11 mitiga esses riscos ao incorporar quatro fontes de 3000 W 80 Plus Titanium redundantes (2+2) e o módulo ASMB10-iKVM para gerenciamento remoto completo, garantindo visibilidade e controle mesmo em cenários de falha de rede principal.

Fundamentos Técnicos da Solução

Arquitetura Baseada em AMD EPYC 7003

No núcleo do ESC8000A-E11 estão dois soquetes SP3 (LGA 4094) capazes de hospedar processadores AMD EPYC 7003 de até 280 W TDP. Essa arquitetura oferece até 64 núcleos por CPU e 8 canais de memória DDR4-3200, permitindo 32 slots e capacidade total de 4 TB em módulos RDIMM/LRDIMM. O resultado é uma largura de banda de memória excepcional, fundamental para alimentar múltiplas GPUs com dados simultâneos sem criar gargalos.

A presença de até 11 slots PCIe 4.0 proporciona maior throughput e reduz latências, algo essencial para IA distribuída e aplicações de HPC que dependem de comunicação paralela intensiva.

Topologia GPU e Escalabilidade via NVLink

O sistema suporta até oito GPUs duais-slot, configuráveis tanto com placas NVIDIA A100 quanto AMD Instinct MI100. Para workloads que exigem comunicação GPU-a-GPU de alta largura de banda, o suporte ao NVIDIA NVLink® bridge possibilita o aumento linear de desempenho sem sobrecarga da CPU, beneficiando treinamentos de redes neurais profundas e renderização de cenas complexas.

Essa flexibilidade faz do ESC8000A-E11 uma solução ideal tanto para centros de pesquisa quanto para provedores de nuvem que oferecem instâncias GPU compartilhadas.

Design Térmico e Eficiência Energética

O chassi 4U emprega um sistema de fluxo de ar independente para CPU e GPU, garantindo controle térmico otimizado mesmo sob carga contínua. Aliado às fontes 80 Plus Titanium, o sistema atinge eficiência energética superior a 96%, reduzindo custos operacionais e emissões de CO₂. Essa abordagem é crítica em ambientes de IA onde o consumo energético de GPU pode ultrapassar 1 kW por nó.

Implementação Estratégica e Operacional

Integração e Expansão Modular

A arquitetura do ESC8000A-E11 permite várias configurações de expansão (SKU-1 a SKU-4) com combinações de PCIe, OCP 3.0 e NVMe, oferecendo ao administrador flexibilidade para equilibrar I/O, armazenamento e interconexões de rede. Essa modularidade é vital para organizações que precisam escalar de projetos de IA piloto para ambientes de produção com múltiplos nós interconectados.

O suporte a NVMe duplo e M.2 garante latências mínimas para carregamento de datasets massivos, enquanto as controladoras ASUS PIKE II oferecem opções de RAID e SAS 12 Gb/s para armazenamento corporativo seguro e redundante.

Gerenciamento Avançado com ASMB10-iKVM

O ESC8000A-E11 incorpora o ASMB10-iKVM, baseado no controlador ASPEED AST2600, para gerenciamento out-of-band completo. Combinado ao ASUS Control Center Enterprise, ele possibilita monitoramento remoto, atualizações firmware seguras e recuperação automatizada de falhas, reduzindo drasticamente o tempo de inatividade e a necessidade de intervenção manual no datacenter.

Melhores Práticas Avançadas

Para organizações que pretendem maximizar a vida útil e a eficiência do ESC8000A-E11, recomenda-se planejar a distribuição de GPUs com base no perfil térmico e nas características de interconexão PCIe. A utilização de GPUs ativas com fluxo direcionado à zona frontal melhora a eficiência de refrigeração em até 15%. Além disso, a configuração de fontes 2+2 redundantes é essencial para evitar falhas em cargas acima de 350 W por GPU.

O emprego de monitoramento proativo de temperatura e energia via ASMB10-iKVM permite ajustar curvas de ventoinha e otimizar o consumo em função da demanda computacional. Essa abordagem garante estabilidade térmica contínua e reduz desgaste de componentes críticos.

Governança e Segurança de Firmware

Com o PFR FPGA integrado como Root of Trust, o ESC8000A-E11 assegura integridade de firmware desde o boot. Essa camada de segurança previne ataques a nível de BIOS e garante conformidade com padrões corporativos de resiliência cibernética em infraestruturas de IA e HPC.

Medição de Sucesso e Indicadores

O sucesso da implementação do ESC8000A-E11 pode ser avaliado por métricas como tempo de treinamento de modelos, eficiência de uso de GPU (% utilização média), consumo energético por teraflop entregue e disponibilidade sistêmica (% uptime). Empresas que migram de servidores GPU geração anterior para essa plataforma relatam reduções de até 30% no tempo de processamento e melhoria na consistência térmica.

O uso de ASUS Control Center Enterprise para telemetria centralizada permite analisar tendências de uso e otimizar a alocação de recursos em tempo real, garantindo ROI positivo mesmo em cenários de alto consumo energético.

Conclusão: Infraestrutura Pronta para a Era da IA

O ASUS ESC8000A-E11 não é apenas um servidor GPU — é um ecossistema de computação otimizado para desempenho, resiliência e governança. Sua arquitetura dual AMD EPYC, suporte a oito GPUs e design térmico inteligente posicionam-no como um pilar para organizações que buscam escala em IA e HPC sem abrir mão de eficiência e confiabilidade.

Com recursos como NVLink, PCIe 4.0, PFR FPGA e gerenciamento ASMB10-iKVM, a plataforma representa a nova geração de infraestrutura empresarial preparada para processar modelos de IA cada vez mais complexos com segurança e controle total.