Descrição

Visão Geral do Produto:

O Supermicro A+ Server AS-4125GS-TNHR2-LCC representa a evolução da computação acelerada por GPU, oferecendo desempenho sem precedentes para treinamento de IA, simulações científicas e inferência de modelos generativos.

Com suporte a 8 GPUs NVIDIA HGX H100 (80GB) ou H200 (141GB), processadores AMD EPYC série 9004/9005, memória DDR5 ECC de até 6TB e NVLink com NVSwitch, o sistema entrega largura de banda e paralelismo ideais para cargas de trabalho de última geração.

Sua refrigeração líquida Direct-to-Chip (D2C) garante estabilidade térmica e operação contínua sob altas cargas de processamento.

Características Técnicas:

Hardware:

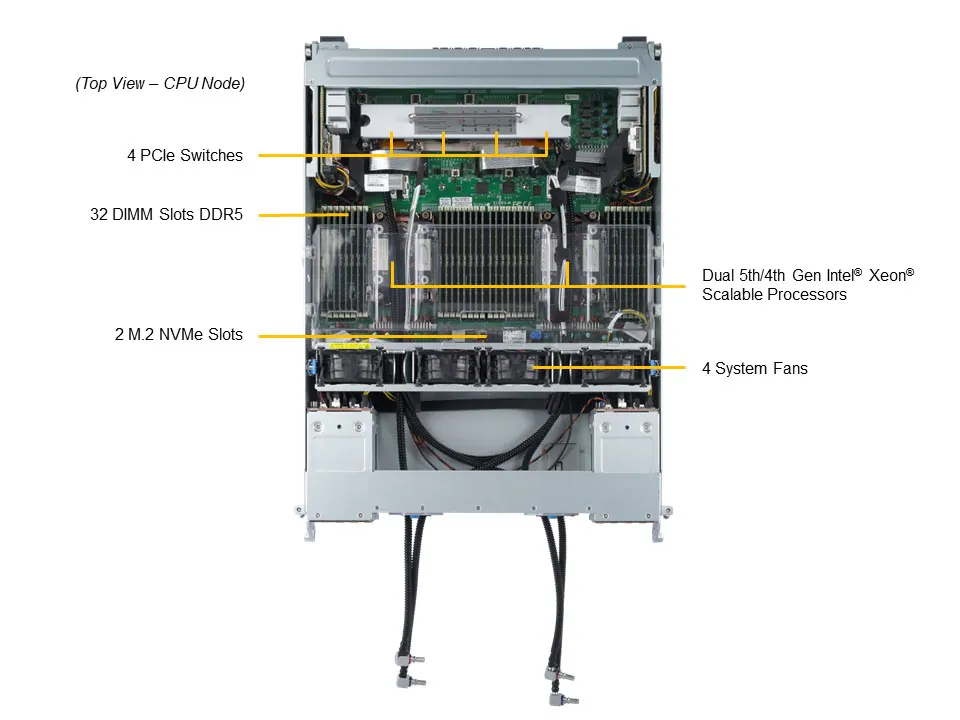

Processadores: 2x AMD EPYC™ série 9004/9005 (até 128 núcleos, 400W TDP, suporte a refrigeração líquida)

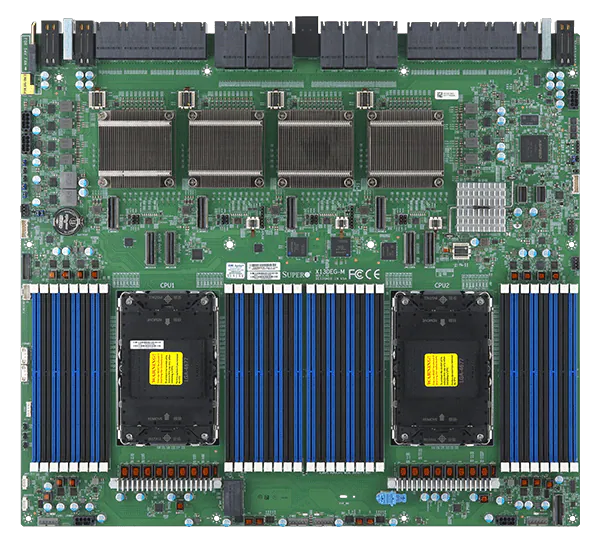

Placa-mãe: Super H13DSG-OM

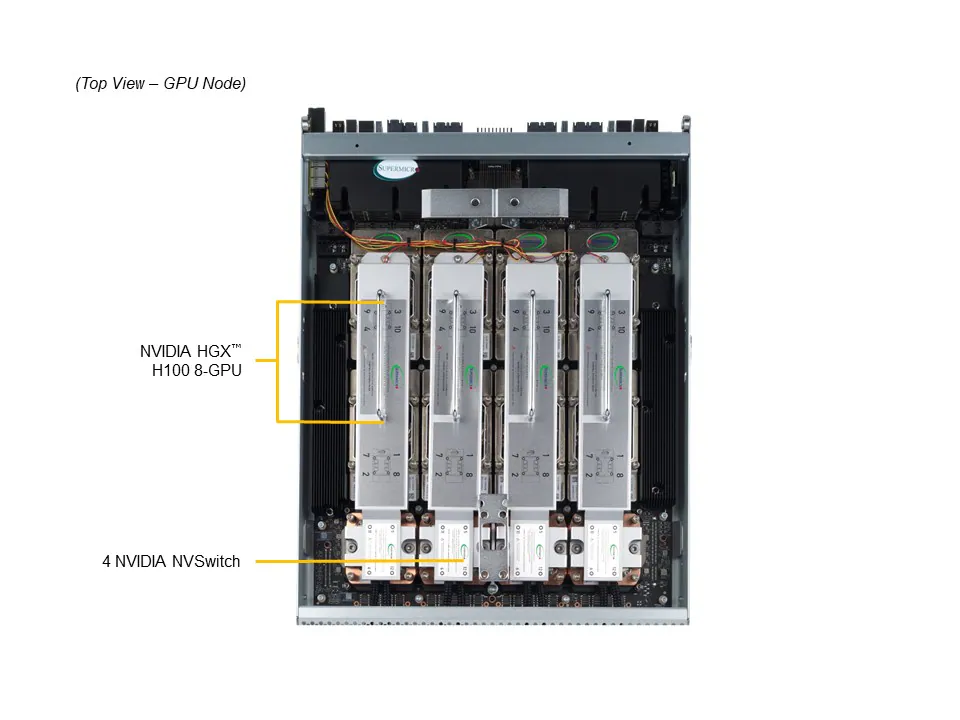

GPU: 8x NVIDIA® HGX™ H100 (80GB) ou HGX™ H200 (141GB)

Interconexão GPU-GPU: NVIDIA® NVLink® com NVSwitch™

Interconexão CPU-GPU: PCIe 5.0 x16

Memória:

Slots: 24x DIMM DDR5

Capacidade máxima: Até 6TB DDR5 ECC (4800MT/s – EPYC 9004 | 6000MT/s – EPYC 9005)

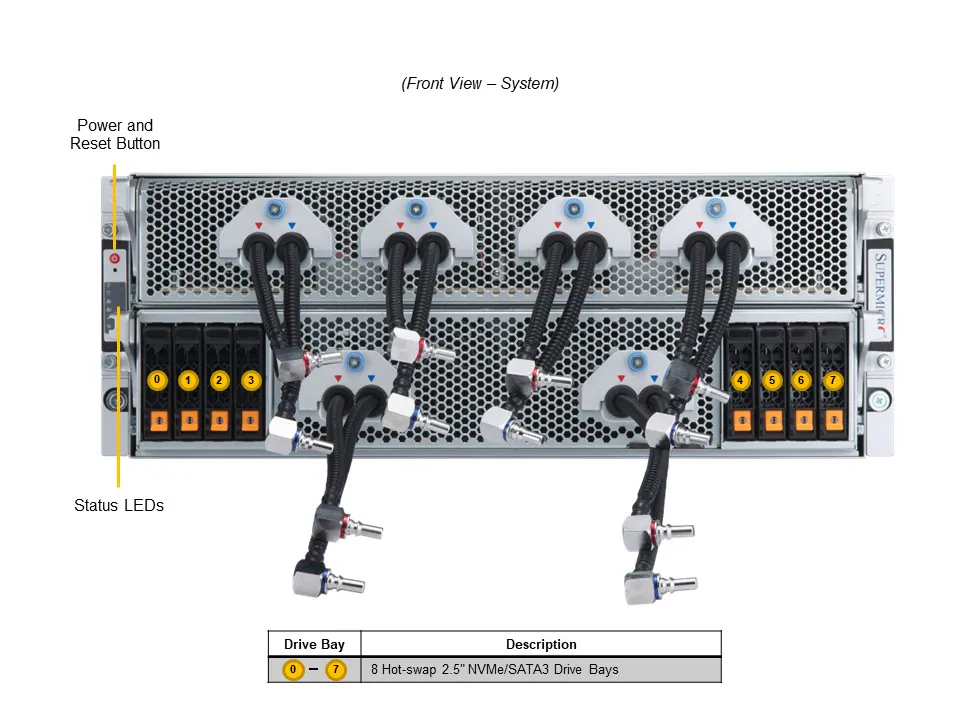

Armazenamento:

Baias: 8x frontais hot-swap NVMe U.2 (2.5”)

M.2: 1x slot M-Key NVMe

Suporte a GPUDirect Storage para acesso direto entre GPU e NVMe

Conectividade:

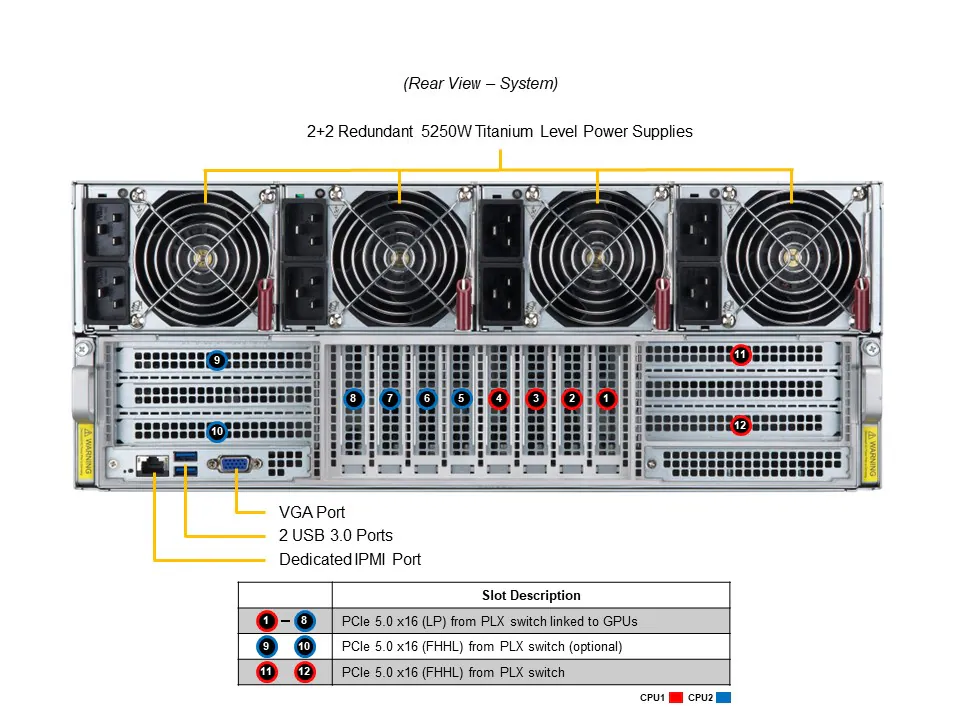

Rede: 1x porta BMC dedicada (RJ45 1GbE)

USB: 2x USB 3.0 traseiras

Vídeo: 1x VGA

Expansão:

Slots PCIe padrão: 8x PCIe 5.0 x16 (LP)

Slots adicionais (opcionais): até 4x PCIe 5.0 x16 FHHL

Gerenciamento e Segurança:

Plataforma de Gerenciamento: SuperCloud Composer®, SSM, SUM, SD5, TAS, SAA

Segurança: TPM 2.0, Root of Trust (NIST 800-193), Secure Boot, firmware assinado e proteção em runtime

Sistema de Refrigeração:

Ventoinhas: até 4x 80mm de alta pressão

Líquido: refrigeração líquida Direct-to-Chip (D2C) opcional

Fonte de Alimentação:

PSUs: 4x fontes redundantes de 5250W (2+2)

Eficiência: Certificação Titanium Level (96%)

Tensão: 200–240Vac, 50/60Hz

Dimensões e Peso:

Formato: 4U Rackmount

Dimensões: 174 x 449 x 842 mm

Peso líquido: 53 kg

Peso bruto: 63 kg

Condições Ambientais:

Operação: 10°C a 35°C, 8–90% UR

Armazenamento: -40°C a 60°C, 5–95% UR

Benefícios e Aplicações:

Desempenho extremo em IA e Deep Learning: arquitetura com 8 GPUs NVIDIA H100/H200 interligadas via NVLink e NVSwitch, ideal para modelos generativos e LLMs.

Eficiência térmica avançada: refrigeração líquida D2C que mantém desempenho máximo sob cargas intensas.

Escalabilidade e largura de banda: suporte total a PCIe 5.0 e GPUDirect Storage/RDMA.

Alta confiabilidade: fontes redundantes Titanium e design de 4U otimizado para operação contínua.

Gerenciamento unificado e seguro: com SuperCloud Composer®, IPMI e autenticação baseada em hardware.

Conclusão

O Supermicro A+ Server AS-4125GS-TNHR2-LCC é uma solução definitiva para IA corporativa, deep learning, LLMs e HPC, combinando potência bruta, segurança avançada e gerenciamento simplificado.

Com suporte a até 8 GPUs NVIDIA HGX H100/H200, processadores AMD EPYC 9005 e refrigeração líquida integrada, este sistema oferece o desempenho e a estabilidade necessários para data centers de ponta e operações críticas em escala global.

FAQ – Perguntas Frequentes

1. Este servidor é adequado para IA e Deep Learning?

Sim. Ele foi projetado para cargas de trabalho de IA, treinamento de LLMs e HPC, com suporte a 8 GPUs NVIDIA HGX H100/H200 conectadas via NVLink e NVSwitch.

2. Precisa de instalação especial?

Sim. O sistema exige integração com rack refrigerado a líquido e suporte onsite especializado.

3. Qual sistema de refrigeração é utilizado?

Refrigeração líquida Direct-to-Chip (D2C), garantindo temperatura estável em CPUs e GPUs de alto TDP.

4. É possível expandir a memória RAM?

Sim. São 24 slots DDR5 ECC, suportando até 6TB com velocidades de até 6000MT/s.

5. Há redundância de energia?

Sim. O sistema conta com 4 fontes de alimentação redundantes de 5250W, com eficiência Titanium Level (96%).

6. Qual é o público-alvo deste servidor?

Empresas e instituições que operam com IA, data centers, pesquisa científica, computação financeira e modelagem preditiva.

7. O servidor é compatível com GPUs PCIe?

Não. Ele é projetado exclusivamente para módulos NVIDIA HGX SXM com NVSwitch.

8. Há suporte para gerenciamento remoto?

Sim. Inclui ferramentas como SuperCloud Composer®, Supermicro Server Manager (SSM) e IPMI com BMC dedicado.

9. Pode ser usado para LLMs como GPT, Claude ou Gemini?

Sim. É otimizado para treinamento e inferência de modelos de linguagem de larga escala.

10. Qual é a eficiência energética do sistema?

O sistema opera com fontes de 5250W certificadas Titanium Level, oferecendo eficiência acima de 96%.