Descrição

Visão Geral do Produto:

O servidor Supermicro A+ AS-A126GS-TNBR da série Gold é uma solução de última geração projetada para cargas de trabalho exigentes em Inteligência Artificial, Aprendizado Profundo, HPC, Análise de Dados e Centros de Dados Corporativos. Com arquitetura dual AMD EPYC da série 9004/9005, este sistema 10U entrega desempenho extremo e confiabilidade para aplicações de missão crítica, sendo ideal para modelagem climática, descoberta de medicamentos, finanças, automação e mais.

Características Técnicas:

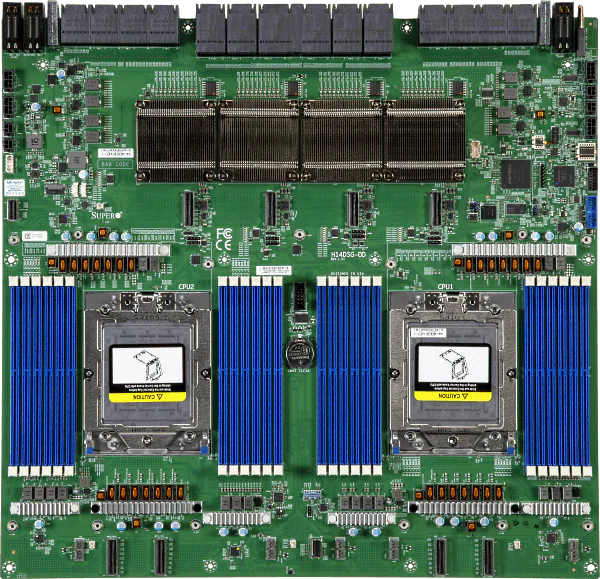

Hardware:

Processadores: Dual AMD EPYC™ série 9005/9004, até 384 núcleos

Memória: Até 6 TB DDR5 ECC 6400 MT/s, 24 slots DIMM

GPU: 8x NVIDIA HGX B200 (SXM), interconectadas via NVLink/NVSwitch

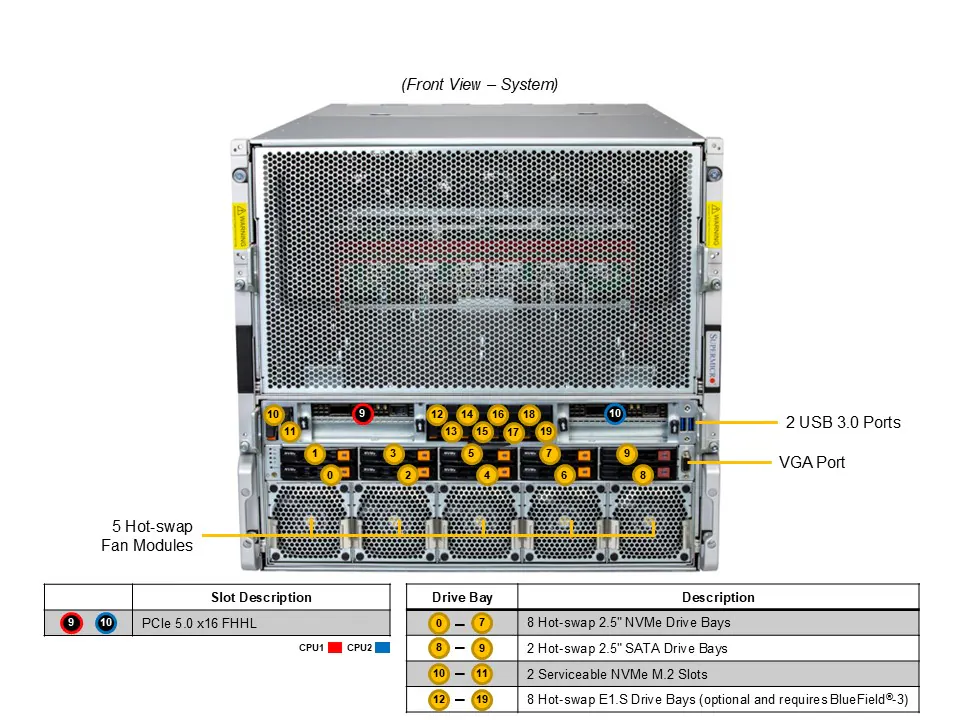

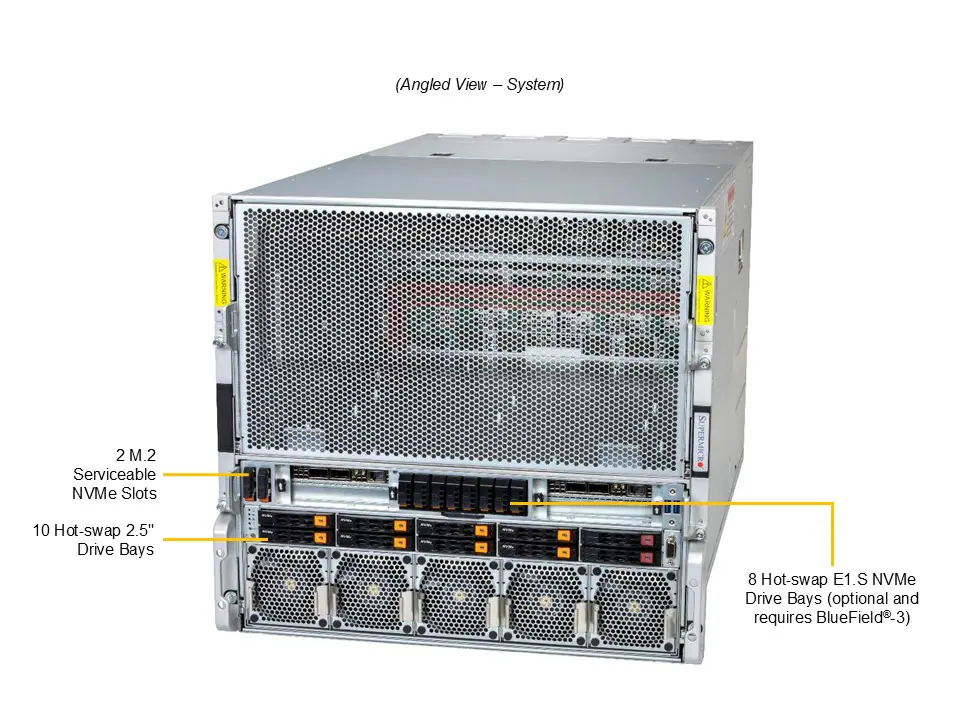

Armazenamento:

8x baias hot-swap NVMe 2,5″

2x baias hot-swap SATA 2,5″

8x baias E1.S opcionais

2x slots M.2 NVMe com suporte a RAID

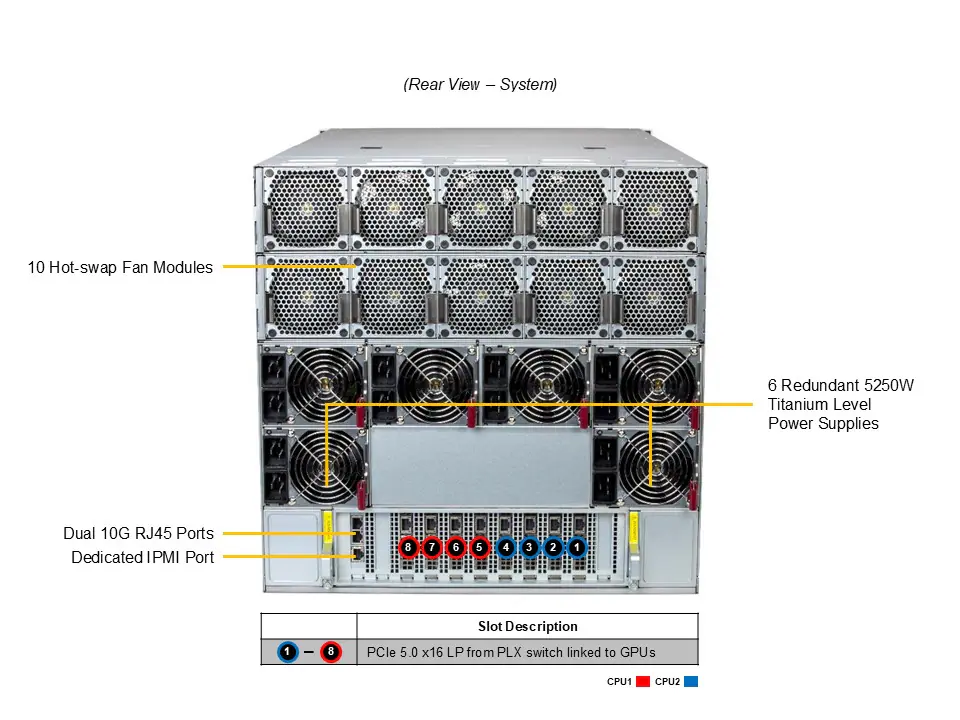

Conectividade:

2x portas 10GbE RJ45 (Intel X710)

1x porta IPMI dedicada

2x USB 3.0 Tipo A, 1x VGA

Expansão:

8x PCIe 5.0 x16 LP

2x PCIe 5.0 x16 FHHL

Características Físicas:

Formato: Rack 10U

Dimensões: 17,2″ x 17,6″ x 33,2″

Peso: 133 kg (líquido)

Energia e Ambiente:

6x fontes redundantes 5250W nível Titânio (3+3)

Operação: 10°C a 35°C, 8% a 90% UR

Arrefecimento: 19 ventoinhas 8cm com controle PWM

Informações Adicionais:

Segurança: TPM 2.0, firmware assinado, inicialização segura

Gerenciamento: Supermicro SSM, SD5, SUM, Composer, TAS

BIOS: AMI 64MB SPI Flash

Benefícios e Aplicações:

Desempenho extremo para treinamento de modelos de IA e deep learning

Escalabilidade para HPC, análise preditiva e computação científica

Confiabilidade para ambientes de missão crítica e infraestruturas de data center

Eficiência energética com fontes de nível Titânio

Flexibilidade de expansão com múltiplos slots PCIe e suporte a armazenamento de alta velocidade

Conclusão:

O Supermicro AS-A126GS-TNBR é um dos servidores mais potentes e completos do mercado, ideal para aplicações que exigem desempenho massivo e confiabilidade total. Com suporte a até 8 GPUs HGX B200, dual AMD EPYC e 6TB de DDR5, este sistema é a escolha certa para empresas que lideram em inovação em IA, ciência de dados, HPC e cloud computing.

FAQ- Perguntas Frequentes

1. Esse servidor é ideal para projetos de IA e deep learning?

Sim. O AS-A126GS-TNBR suporta até 8 GPUs NVIDIA HGX B200 interligadas por NVLink/NVSwitch, sendo perfeito para treinar e inferir grandes modelos de IA.

2. Quantas CPUs e GPUs o sistema suporta?

O sistema suporta dois processadores AMD EPYC e até oito GPUs HGX B200 em formato SXM.

3. Qual é a capacidade máxima de memória RAM?

Suporta até 6 TB de memória DDR5 ECC 6400 MT/s, utilizando todos os 24 slots DIMM com processadores da série AMD EPYC 9005.

4. Ele pode ser usado em ambientes de HPC ou data centers?

Com certeza. Esse servidor foi projetado para ambientes de missão crítica, com fontes de alimentação redundantes, gerenciamento remoto completo e alta escalabilidade.

5. Quais são as opções de armazenamento?

Conta com 8 baias NVMe hot-swap de 2,5″, 2 baias SATA de 2,5″, 2 slots M.2 e opcionalmente 8 baias E1.S.

6. Como é feita a refrigeração do sistema?

Possui 19 ventoinhas de 8 cm com controle inteligente de velocidade e mortalha de ar para condução eficiente do fluxo térmico.

7. Ele é compatível com placas de expansão?

Sim, conta com 10 slots PCIe 5.0 x16 (8 LP + 2 FHHL) para total flexibilidade.

8. Quais diferenciais esse servidor oferece para cargas intensivas de IA e HPC?

Além das 8 GPUs HGX B200 interligadas por NVSwitch, ele oferece suporte a CPUs AMD EPYC com até 384 núcleos, memória DDR5 de alta largura de banda e fontes redundantes de 5250W nível Titânio, assegurando desempenho, estabilidade e eficiência energética incomparáveis.

9. Possui gerenciamento remoto?

Sim. Possui IPMI dedicado e suporte a soluções como SUM, SSM, Composer e SD5.

10. O servidor suporta virtualização e orquestração com Kubernetes ou outras plataformas?

Sim. O AS-A126GS-TNBR é totalmente compatível com ambientes virtualizados e plataformas de orquestração como VMware, Proxmox, Kubernetes e Docker. Sua arquitetura com múltiplas GPUs e amplo suporte a memória o torna ideal para clusters de IA, containers e workloads escaláveis em nuvem privada ou híbrida.