Nvidia Rubin: arquitetura que redefine desempenho e escala da IA

Introdução: a próxima fronteira da computação para IA

A evolução recente da inteligência artificial deixou de ser limitada por algoritmos e passou a ser condicionada pela capacidade da infraestrutura computacional de acompanhar modelos cada vez maiores, mais complexos e mais intensivos em dados. Nesse contexto, a Nvidia ocupa um papel central ao concentrar aproximadamente 90% do mercado de chips dedicados à IA, tornando suas decisões arquitetônicas determinantes para todo o ecossistema.

Com o anúncio oficial da plataforma Vera Rubin na CES 2026, a Nvidia não apresentou apenas uma nova GPU, mas sinalizou uma mudança profunda na forma como a indústria precisa pensar desempenho, escalabilidade e design de sistemas para IA. Segundo a própria empresa, a GPU Rubin entregará um aumento de cinco vezes no desempenho de inferência NVPF4 e de 3,5 vezes no treinamento, quando comparada à geração Blackwell.

Esse salto não ocorre em um cenário trivial. A desaceleração da Lei de Moore impõe limites claros ao crescimento linear de transistores, enquanto a demanda por geração de tokens de IA e redução de custos pressiona arquiteturas existentes. A Rubin surge, portanto, como resposta direta a um problema estratégico: como continuar escalando desempenho em um mundo onde simplesmente “colocar mais transistores” já não é suficiente.

Este artigo analisa, de forma técnica e estratégica, o que a arquitetura Nvidia Rubin representa para organizações que dependem de IA em larga escala, explorando seus fundamentos, implicações, riscos e os novos paradigmas de design que emergem com essa geração.

O problema estratégico: escalar IA além dos limites da Lei de Moore

O desafio estrutural da evolução dos modelos de IA

Modelos de IA modernos cresceram em ordens de magnitude nos últimos anos, tanto em parâmetros quanto em volume de dados processados. Esse crescimento cria uma pressão contínua por maior capacidade de inferência e treinamento, especialmente em ambientes corporativos e científicos que operam em escala industrial.

Entretanto, conforme destacado pelo próprio CEO da Nvidia, Jensen Huang, a Lei de Moore desacelerou significativamente. O número de transistores adicionados a cada nova geração de chips já não acompanha o ritmo de crescimento dos modelos, criando um descompasso estrutural entre demanda computacional e capacidade física do silício.

Esse cenário torna inviável depender exclusivamente de ganhos incrementais tradicionais. Um aumento de 1,6 vezes no número de transistores, como ocorre do Blackwell para o Rubin, não seria suficiente para sustentar aumentos de desempenho da ordem de cinco ou dez vezes exigidos pelo mercado.

Consequências da inação arquitetônica

Sem uma mudança estrutural no design dos sistemas, organizações enfrentariam custos crescentes, gargalos de desempenho e limitação na viabilidade econômica de aplicações de IA em larga escala. A incapacidade de escalar inferência impacta diretamente modelos generativos, sistemas de recomendação e aplicações que dependem de respostas em tempo quase real.

Além disso, a estagnação arquitetônica comprometeria a redução do custo por token, um fator crítico para a viabilidade comercial de soluções de IA. Nesse sentido, a inação não representa apenas um problema técnico, mas um risco estratégico direto para negócios baseados em IA.

Fundamentos da solução: a arquitetura Nvidia Rubin

Desempenho bruto e métricas divulgadas

De acordo com a Nvidia, a GPU Rubin oferecerá 50 petaflops de desempenho de inferência NVPF4, representando um aumento de cinco vezes em relação à Blackwell. No treinamento NVPF4, o desempenho anunciado é de 35 petaflops, um ganho de 3,5 vezes.

Esses números são acompanhados por avanços substanciais na subsistema de memória. A Rubin contará com 22 TB/s de largura de banda de memória HBM4, uma melhoria de 2,8 vezes sobre a geração anterior. Esse aspecto é crítico, pois gargalos de memória frequentemente limitam o aproveitamento do poder computacional em cargas de IA.

No campo da interconexão, cada GPU Rubin oferecerá 3,6 TB/s de largura de banda NVLink, o dobro do que estava disponível no Blackwell. Esse fator é determinante para arquiteturas multi-GPU e sistemas NVL72, onde a comunicação entre aceleradores define o desempenho global.

O papel do processador Vera

A plataforma Vera Rubin não se limita à GPU. O processador Vera, baseado em arquitetura Arm, foi projetado para substituir o Grace e, segundo Jensen Huang, oferecerá o dobro de desempenho. Embora a Nvidia não tenha divulgado métricas detalhadas, alguns elementos arquitetônicos foram confirmados.

O chip contará com 88 núcleos Olympus personalizados e suportará 176 threads por núcleo por meio da tecnologia de “multithreading espacial” da Nvidia. Essa abordagem indica uma otimização profunda para cargas altamente paralelizáveis, típicas de pipelines de IA.

O Vera também incorpora uma conexão NVLink C2C de 1,8 TB/s, 1,5 TB de memória on-chip — três vezes mais que o Grace — e 1,2 TB/s de largura de banda de memória LPDDR5X. Esses números reforçam a estratégia de eliminar gargalos entre CPU e GPU, tratando o sistema como uma entidade coesa.

Design colaborativo extremo: rompendo paradigmas tradicionais

Por que redesenhar tudo ao mesmo tempo

Historicamente, a Nvidia seguia uma regra interna clara: nenhuma nova geração deveria introduzir mais do que uma ou duas mudanças significativas no chip. Essa abordagem reduzia riscos e facilitava a evolução incremental.

Contudo, conforme explicado por Huang, esse modelo tornou-se inviável diante da desaceleração da Lei de Moore e da explosão dos modelos de IA. A Rubin representa uma ruptura deliberada, na qual cada componente — GPU, CPU, interconexão, memória e rack — foi redesenhado simultaneamente.

Esse “design colaborativo extremo” permite ganhos sistêmicos que não seriam alcançáveis por otimizações isoladas. O aumento de desempenho não vem apenas do silício, mas da integração profunda entre todos os elementos do sistema.

O caso do Vera Rubin NVL72

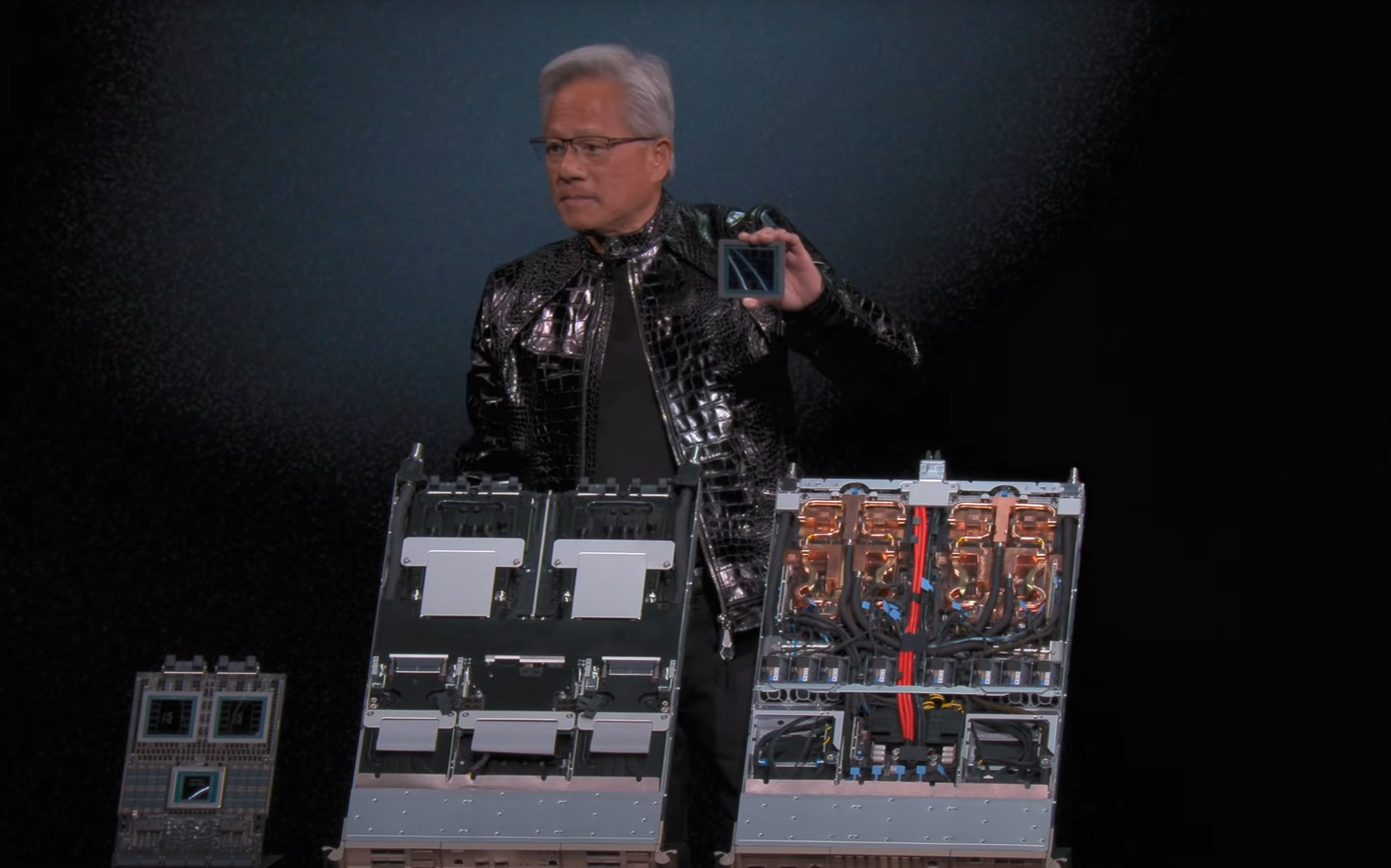

O pod Vera Rubin NVL72 exemplifica essa abordagem. O primeiro rack, apresentado na CES 2026, contém 18 bandejas de computação, nove bandejas NVLink e pesa quase duas toneladas. Segundo a Nvidia, o sistema totaliza 220 trilhões de transistores.

Huang afirmou que o projeto consumiu o equivalente a 15.000 anos de engenharia, uma métrica simbólica que ilustra a complexidade e o nível de coordenação necessário para viabilizar essa geração.

Esse tipo de sistema não pode ser analisado apenas como um conjunto de GPUs, mas como uma plataforma integrada, onde computação, memória e interconexão são tratados como partes inseparáveis de um todo.

Tensor Cores e a revolução da inferência adaptativa

Precisão dinâmica como fator-chave

Um dos principais fatores por trás do salto de cinco vezes em inferência, segundo a Nvidia, está na evolução dos Tensor Cores. Essas unidades especializadas são projetadas para acelerar operações de multiplicação e acumulação de matrizes, essenciais para cargas de IA.

Na Rubin, os Tensor Cores foram concebidos como unidades de processamento completas, capazes de ajustar dinamicamente a precisão e a estrutura de cálculo conforme o estágio do transformador. Isso permite explorar regiões do modelo onde perdas de precisão são aceitáveis, retornando à máxima precisão quando necessário.

Essa abordagem representa uma mudança conceitual relevante, pois trata precisão como um parâmetro adaptativo e não fixo. Segundo Huang, essa inovação pode se tornar um padrão futuro da indústria.

Trade-offs e implicações técnicas

Embora essa estratégia permita ganhos expressivos de desempenho, ela também levanta questões sobre precisão numérica em determinados contextos. A própria comunidade de HPC expressou preocupações quanto à redução de recursos de alta precisão, como FP64, já observada na geração Blackwell.

A Nvidia afirmou recentemente que não está abandonando a computação de 64 bits, mas ainda não divulgou métricas de desempenho FP64 para a Rubin. Essas informações são críticas para cargas tradicionais de modelagem e simulação científica.

Assim, o avanço em inferência e treinamento vem acompanhado de um debate legítimo sobre equilíbrio entre desempenho, precisão e abrangência de aplicações.

Governança, consumo de energia e lacunas em aberto

O que ainda não foi divulgado

Apesar do volume significativo de informações apresentadas, a Nvidia ainda não divulgou dados completos sobre consumo de energia da GPU Rubin. Em um cenário onde eficiência energética é um fator crítico, essa ausência impede uma avaliação completa do custo total de propriedade.

Da mesma forma, métricas detalhadas de desempenho FP64 permanecem pendentes. A expectativa é que essas informações sejam apresentadas apenas na GTC 26, em março.

Essas lacunas reforçam a necessidade de cautela por parte de organizações que operam cargas mistas, combinando IA com simulações científicas tradicionais.

Conclusão: o que a Nvidia Rubin representa para a estratégia de IA

A arquitetura Nvidia Rubin marca um ponto de inflexão na evolução da computação para IA. Ao entregar ganhos de até cinco vezes em inferência, mesmo com apenas 1,6 vezes mais transistores, a Nvidia demonstra que o futuro do desempenho está na integração sistêmica e no design colaborativo extremo.

Mais do que uma nova GPU, a Rubin representa uma mudança de paradigma, na qual precisão adaptativa, interconexão de alta largura de banda e co-design de CPU e GPU tornam-se elementos centrais da estratégia.

Ao mesmo tempo, permanecem questões relevantes sobre consumo de energia e suporte a alta precisão, especialmente para a comunidade de HPC. Essas respostas serão decisivas para determinar o alcance real dessa plataforma.

Para organizações que dependem de IA em escala, a Rubin sinaliza tanto uma oportunidade quanto um novo conjunto de decisões estratégicas. Entender essas implicações é fundamental para alinhar tecnologia, custo e objetivos de longo prazo em um cenário onde a evolução da IA já não pode esperar pelos limites tradicionais do silício.