Nvidia Rubin CPX: potência para inferência de IA em contexto massivo

A Nvidia anunciou a GPU Rubin CPX, uma inovação projetada para redefinir os limites da inferência de inteligência artificial (IA) em cenários de contexto massivo. Combinando avanços em computação paralela, largura de banda de memória e integração em arquiteturas de data center, a nova geração de GPUs responde a um desafio estratégico: suportar janelas de contexto que deixam para trás os atuais 250.000 tokens e avançam para a escala de milhões.

Este artigo analisa em profundidade o anúncio da Nvidia, destacando os problemas estratégicos que levaram à criação do Rubin CPX, as consequências da inação diante da evolução da inferência de IA, os fundamentos técnicos da solução, a implementação em data centers e os impactos estratégicos para empresas que dependem de IA de última geração.

Introdução: a mudança de paradigma da IA

Nos últimos anos, o debate em torno da inteligência artificial esteve dominado pelo tema do treinamento de modelos cada vez maiores. No entanto, como observou Ian Buck, vice-presidente e gerente geral de hiperescala e HPC da Nvidia, o foco da comunidade está mudando rapidamente para a inferência, ou seja, a execução prática desses modelos em escala empresarial e consumer. Essa mudança redefine não apenas o software, mas também o hardware que sustenta o ecossistema de IA.

A inferência apresenta desafios únicos que diferem do treinamento. Enquanto o treinamento busca maximizar throughput em processos intensivos e previsíveis, a inferência exige equilíbrio entre latência, escalabilidade, custo energético e experiência do usuário. Em cargas emergentes como copilotos de programação e geração de vídeo, a pressão recai sobre a capacidade de processar contextos cada vez mais longos sem comprometer a responsividade.

Ignorar essa transição representa riscos significativos para data centers e provedores de serviços de IA. Um atraso na adaptação pode significar perda de competitividade, aumento exponencial de custos operacionais e incapacidade de atender a demandas de clientes em mercados que crescem a dois dígitos.

O problema estratégico: inferência de IA em escala massiva

A complexidade da inferência se manifesta em múltiplos vetores de otimização. Buck destacou que há um constante trade-off entre throughput e experiência do usuário. É possível maximizar a produção de tokens por segundo em um único fluxo, mas isso pode prejudicar a equidade entre múltiplos usuários simultâneos. Além disso, equilibrar eficiência energética e desempenho se tornou um imperativo em fábricas de IA modernas.

Outro desafio central é o delta de desempenho entre as fases de inferência. A fase de pré-preenchimento, onde o modelo processa a entrada do usuário e tokens associados, pode explorar paralelismo massivo nas GPUs. Já a fase de geração, que é autorregressiva, exige execução linear, demandando altíssima largura de banda de memória e interconexões NVLink otimizadas.

Esse contraste cria gargalos que comprometem a escalabilidade. A solução atual de muitos data centers, baseada em desagregação via cache KV, permite dividir GPUs entre contexto e geração, mas introduz complexidade de sincronização e limitações à medida que os contextos crescem.

Consequências da inação diante da evolução da inferência

O crescimento exponencial das janelas de contexto pressiona a infraestrutura existente. Modelos atuais conseguem lidar com cerca de 250.000 tokens, mas aplicações emergentes já projetam a necessidade de ultrapassar a barreira de 1 milhão de tokens. Para copilotos de código, isso significa reter em memória mais de 100.000 linhas, enquanto a geração de vídeo amplia a exigência para múltiplos milhões.

A ausência de infraestrutura capaz de lidar com esse salto traz riscos claros:

- Experiência limitada do usuário: respostas truncadas ou inconsistentes em copilotos e assistentes virtuais.

- Custos crescentes: uso ineficiente de GPUs ao tentar compensar limitações arquiteturais.

- Perda de mercado: em setores como entretenimento, cujo valor atual de US$ 4 bilhões pode chegar a US$ 40 bilhões na próxima década.

Empresas que não se adaptarem rapidamente correm o risco de ficar para trás em um mercado de alto valor, onde a latência e a precisão determinam não apenas competitividade, mas também confiança do cliente.

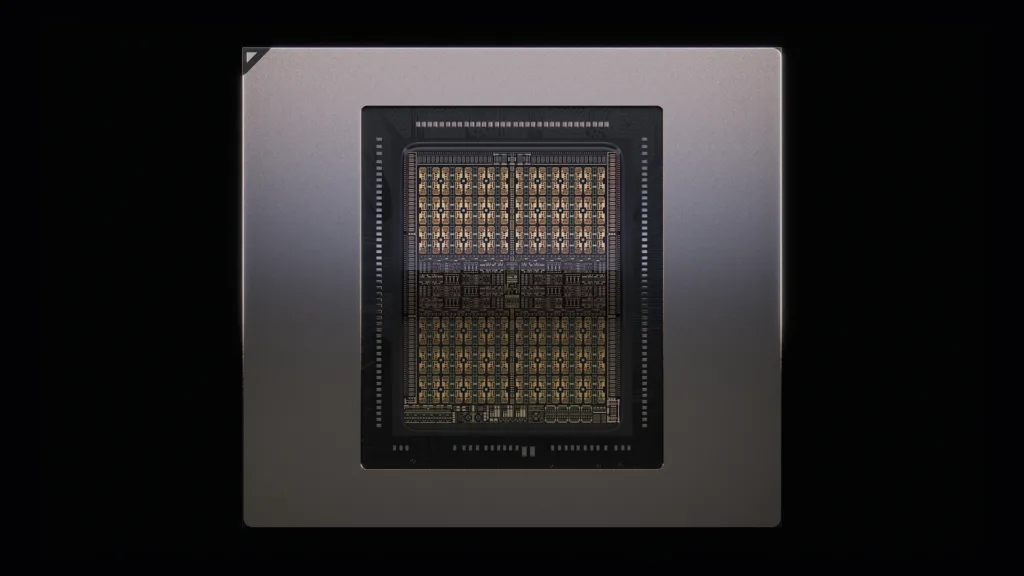

Fundamentos técnicos da solução Rubin CPX

A Nvidia respondeu a esse desafio com a GPU Rubin CPX, baseada na arquitetura Rubin e compatível com CUDA. Diferente das gerações anteriores, ela foi otimizada especificamente para cargas de inferência em contexto massivo, com suporte a milhões de tokens.

Capacidade computacional

O Rubin CPX entrega 30 petaFLOPs de computação NVFP4, estabelecendo uma base sólida para lidar com inferências massivamente paralelas. Esse poder bruto é fundamental para reduzir a lacuna entre as fases de pré-preenchimento e geração.

Memória e largura de banda

Equipado com 128 GB de memória GDDR7, o Rubin CPX prioriza largura de banda sobre escalabilidade NVLink em cargas de contexto. Essa escolha arquitetural permite lidar com o peso computacional da fase de pré-processamento de maneira mais eficiente.

Aceleradores especializados

A Nvidia triplicou os núcleos de aceleração de atenção e dobrou os codificadores/decodificadores de vídeo. Esses aprimoramentos respondem diretamente às necessidades de modelos de atenção longos e geração de vídeo em escala, que são pilares de aplicações emergentes.

Implementação estratégica em data centers

A GPU Rubin CPX não é um elemento isolado, mas parte de uma estratégia integrada de infraestrutura. A Nvidia anunciou sua incorporação nos sistemas Vera Rubin e DGX, ampliando a capacidade desses ambientes.

Vera Rubin NVL144

Esse novo sistema oferecerá 8 exaflops de computação de IA, cerca de 7,5 vezes mais que os atuais GB300 NVL72. Ele combina 100 TB de memória rápida e 1,7 petabytes por segundo de largura de banda de memória em um único rack, estabelecendo um novo patamar de densidade computacional.

Rack duplo com Rubin CPX

Além disso, a Nvidia disponibilizará uma solução de rack duplo que combina a Vera Rubin NVL144 com um “sidecar” de Rubin CPXs, otimizando a distribuição de cargas entre fases de contexto e geração.

Melhores práticas para adoção da Rubin CPX

Empresas que avaliam a adoção do Rubin CPX devem considerar alguns pontos estratégicos:

- Balanceamento de cargas: alinhar GPUs dedicadas ao pré-preenchimento e à geração para minimizar latência.

- Integração com software: explorar o ecossistema CUDA e frameworks de inferência otimizados.

- Escalabilidade futura: preparar data centers para janelas de contexto que poderão ultrapassar milhões de tokens.

Seguir essas práticas é essencial para mitigar riscos de subutilização ou gargalos inesperados em aplicações críticas.

Medição de sucesso e indicadores de desempenho

A avaliação da adoção do Rubin CPX deve se basear em métricas específicas, como:

- Tokens por segundo: medição da velocidade de geração autorregressiva.

- Latência de resposta: tempo entre entrada do usuário e saída inicial.

- Eficiência energética: tokens gerados por watt consumido.

- Escalabilidade: capacidade de manter performance estável ao lidar com contextos superiores a 1 milhão de tokens.

Esses indicadores permitem alinhar os resultados técnicos com objetivos de negócio, garantindo retorno sobre investimento em infraestrutura de IA.

Conclusão: o futuro da inferência em contexto massivo

A GPU Nvidia Rubin CPX representa uma mudança de paradigma no suporte a cargas de inferência de IA. Ao priorizar contextos longos e integrar otimizações de memória e aceleradores especializados, ela se posiciona como fundamento crítico para data centers que desejam competir em mercados em rápida transformação.

Do ponto de vista estratégico, organizações que adotarem o Rubin CPX estarão preparadas para enfrentar um cenário de IA cada vez mais centrado em contextos massivos. Aquelas que não se moverem rapidamente enfrentarão riscos de obsolescência e perda de competitividade.

No horizonte, é possível prever que a evolução da IA caminhará para aplicações ainda mais intensivas em contexto — desde copilotos corporativos até entretenimento gerado por IA em escala global. O Rubin CPX não é apenas uma resposta técnica a um desafio atual, mas também uma aposta estratégica na próxima década da inteligência artificial.