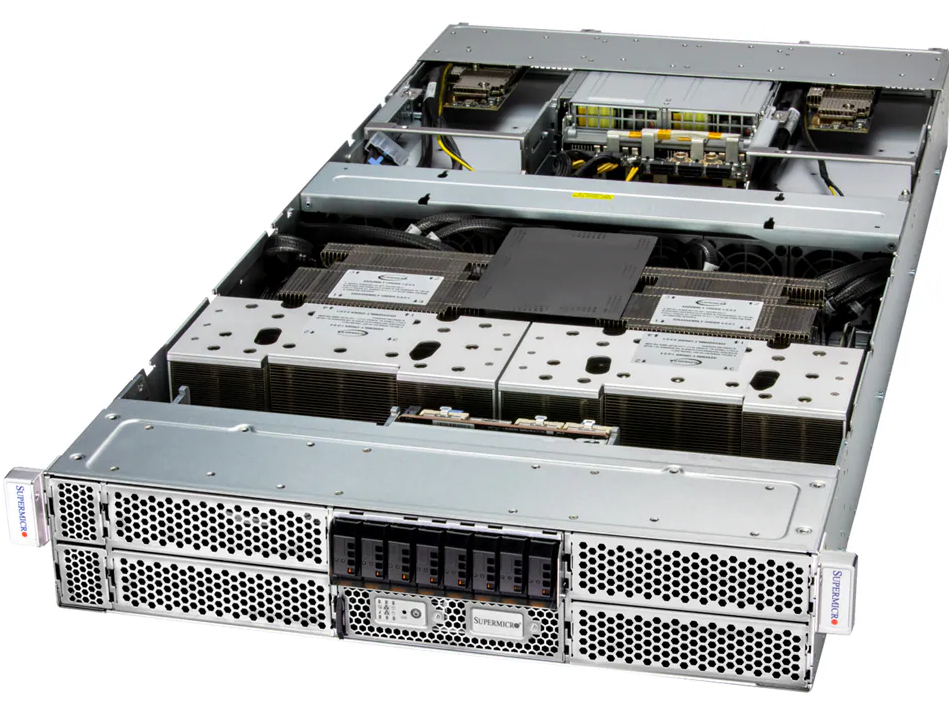

SuperServer SYS-820GP-TNAR+ com NVIDIA HGX A100: Desempenho Máximo para HPC e Treinamento de IA O SuperServer SYS-820GP-TNAR+ representa o ápice em servidores GPU de alta densidade, projetado para atender às demandas crescentes de High Performance Computing (HPC) e treinamento de inteligência artificial (IA) em escala corporativa. Em um cenário onde os modelos de IA crescem exponencialmente em tamanho e complexidade, e onde simulações científicas exigem throughput massivo, um sistema capaz de entregar desempenho, escalabilidade e confiabilidade torna-se estratégico. Introdução Estratégica ao Servidor GPU 8U Empresas que lidam com análise de grandes volumes de dados, modelagem científica avançada ou treinamento de redes neurais complexas enfrentam desafios significativos de infraestrutura. A escolha inadequada de hardware não apenas limita o desempenho, mas também pode gerar custos elevados de operação e manutenção. O SYS-820GP-TNAR+ foi projetado para resolver esses problemas oferecendo até 8 GPUs NVIDIA HGX A100 interconectadas via NVLink com NVSwitch, permitindo comunicação de alta largura de banda entre GPUs e aceleração eficiente de cargas de trabalho paralelas. Com suporte a 32 DIMMs e até 8TB de DRAM, além de Intel Optane Persistent Memory, ele equilibra memória de alta capacidade e persistência para workloads críticos. Desafios Críticos no Cenário Empresarial Atual Organizações que implementam HPC ou treinamento de IA enfrentam três grandes desafios: Escalabilidade de Recursos O crescimento exponencial de dados exige sistemas que possam escalar vertical e horizontalmente. O SYS-820GP-TNAR+ resolve parcialmente este desafio com arquitetura modular, permitindo até 8 GPUs de duplo slot e 32 DIMMs de memória, garantindo suporte a workloads massivos sem necessidade de múltiplos racks. Interconectividade e Throughput Em aplicações de IA, a comunicação entre GPUs é crítica. O uso de PCIe 4.0 x16 CPU-to-GPU combinado com NVLink/NVSwitch permite baixa latência e alto throughput, essencial para treinamento eficiente de modelos de grande escala. Confiabilidade e Gestão Servidores de alta performance exigem monitoramento e redundância robustos. O SYS-820GP-TNAR+ inclui 4 fontes de 3000W redundantes Titanium, controle inteligente de ventoinhas e software de gestão Supermicro (SSM, SUM, SD5), garantindo operação confiável e manutenção proativa. Problema Estratégico A crescente complexidade de projetos de IA corporativa e simulações HPC impõe requisitos simultâneos de processamento massivo, grande memória e comunicação eficiente entre GPUs. Sistemas tradicionais falham em balancear esses elementos, levando a gargalos de desempenho, maior consumo de energia e limitações na escalabilidade. Consequências da Inação Ignorar a necessidade de servidores GPU de alta densidade implica riscos concretos: Redução do desempenho em treinamento de modelos de IA, prolongando ciclos de desenvolvimento. Maior consumo de energia e espaço físico, sem aumento proporcional de performance. Risco de downtime devido à falta de redundância e monitoramento avançado. Fundamentos da Solução O SYS-820GP-TNAR+ combina hardware de ponta e software de gestão avançado. Principais fundamentos incluem: Processamento e Interconexão de GPUs O suporte a 8 GPUs NVIDIA HGX A100 com NVLink/NVSwitch permite paralelização massiva de operações matriciais, essencial para deep learning e simulações científicas. Cada GPU comunica-se eficientemente com as demais, reduzindo latência e aumentando throughput global do sistema. Memória e Persistência Com 32 DIMMs e até 8TB de DRAM, o servidor suporta cargas de trabalho que exigem grande espaço de memória temporária. A inclusão de Intel Optane Persistent Memory oferece níveis adicionais de persistência, reduzindo o risco de perda de dados em cenários críticos. Armazenamento e Expansão O sistema possui 6 baias hot-swap para NVMe/SATA/SAS e 2 M.2 para boot, garantindo flexibilidade e performance de I/O. Esta configuração atende demandas de HPC e IA que exigem leitura/gravação massiva de dados. Implementação Estratégica A implementação de um servidor como o SYS-820GP-TNAR+ requer planejamento detalhado: Configuração de Hardware Escolha de GPUs e CPUs compatíveis, configuração de memória DRAM e Optane, balanceamento térmico e distribuição de energia são essenciais para maximizar desempenho e confiabilidade. Rede e Integração O servidor suporta múltiplas opções de rede, incluindo 10GbE dual RJ45, com suporte a AOC adicionais, garantindo interoperabilidade com clusters existentes e redes de alta velocidade para HPC. Gestão e Automação Ferramentas Supermicro, como SSM, SUM e SuperCloud Composer, permitem monitoramento em tempo real, provisionamento automatizado e atualização segura de firmware, alinhando operações técnicas com objetivos de negócio. Melhores Práticas Avançadas Para extrair o máximo do SYS-820GP-TNAR+, recomenda-se: Monitoramento contínuo de temperatura e energia para prevenir throttling ou falhas de hardware. Uso de NVLink/NVSwitch otimizado conforme topologia de rede e tipo de workload. Implementação de políticas de segurança com TPM 2.0 e Root of Trust, garantindo compliance e proteção de dados. Planejamento de manutenção preventiva usando software de diagnóstico offline (SDO) e automação de alertas. Medição de Sucesso Indicadores para avaliar o desempenho do sistema incluem: Throughput de treinamento de modelos de IA (samples/segundo). Taxa de utilização de memória e GPU. Tempo de downtime e falhas detectadas pelo software de gestão. Eficiência energética (performance por watt), considerando fontes redundantes Titanium. Conclusão O SuperServer SYS-820GP-TNAR+ é uma solução estratégica para organizações que buscam liderança em HPC e IA. Com até 8 GPUs NVIDIA HGX A100, memória robusta e gerenciamento avançado, ele equilibra desempenho extremo e confiabilidade operacional. A adoção correta desse sistema permite acelerar projetos críticos de AI, reduzir riscos de downtime e otimizar custos de infraestrutura. Com práticas avançadas de implementação, monitoramento e manutenção, empresas garantem retorno sobre investimento em tecnologia de ponta. O futuro da computação empresarial de alta performance passa por sistemas integrados, escaláveis e confiáveis como o SYS-820GP-TNAR+. Organizações que antecipam essa tendência estarão prontas para suportar workloads massivos e manter vantagem competitiva sustentável.

Supermicro SYS-820GH-TNR2: Potência máxima em treinamento de IA com 8 Gaudi 2 Introdução O cenário atual de Inteligência Artificial (IA) empresarial exige plataformas de treinamento que combinem altíssimo desempenho computacional, escalabilidade flexível e confiabilidade de operação 24/7. Organizações que desenvolvem modelos de aprendizado profundo, incluindo visão computacional, processamento de linguagem natural e sistemas de recomendação, precisam de servidores capazes de processar grandes volumes de dados e fornecer throughput consistente para cargas massivas de treino. Entre os principais desafios enfrentados estão a limitação de interconexão entre CPUs e aceleradores, gerenciamento de memória em grande escala e a necessidade de redundância crítica para manter operações contínuas. A inação ou a adoção de soluções subdimensionadas pode resultar em atrasos de desenvolvimento, custos operacionais elevados e perda de competitividade no mercado. Este artigo apresenta uma análise aprofundada do Supermicro SYS-820GH-TNR2, uma plataforma 8U projetada para atender exatamente a esses requisitos, oferecendo até oito aceleradores Intel Gaudi®2, processadores Intel Xeon de 3ª geração e capacidades avançadas de rede e armazenamento. Problema Estratégico Desafios de Treinamento de IA em Escala Treinar modelos de IA de grande porte exige não apenas GPUs ou NPUs potentes, mas também uma arquitetura que minimize latências e maximize largura de banda entre processadores e aceleradores. Sem isso, as organizações enfrentam gargalos que prolongam significativamente o tempo de treinamento e aumentam custos de energia e infraestrutura. Além disso, ambientes corporativos demandam alta disponibilidade. Servidores tradicionais muitas vezes não suportam redundância de fonte de alimentação ou monitoramento de falhas com granularidade suficiente, o que torna críticos os incidentes de downtime que afetam linhas de produção, serviços financeiros ou pipelines de dados em tempo real. Consequências da Inação Não investir em uma infraestrutura adequada pode acarretar atrasos em projetos de IA, maior tempo de inferência em produção e risco de inconsistência nos resultados devido a falhas ou performance subótima. Custos com manutenção e consumo energético podem disparar, enquanto oportunidades de negócios podem ser perdidas para concorrentes que adotaram plataformas de alta performance. Fundamentos da Solução Arquitetura do SYS-820GH-TNR2 O SYS-820GH-TNR2 é um servidor 8U desenvolvido para IA em escala massiva, combinando até oito aceleradores Intel Gaudi 2 com dual Intel Xeon 3rd Gen Scalable Processors (Ice Lake). Essa combinação garante alto throughput computacional com suporte a modelos complexos e volumosos. O chipset Intel® C621A fornece integração robusta com a CPU e memória, enquanto 32 slots DIMM suportam até 8TB de ECC DDR4 3200MHz, garantindo consistência e confiabilidade em cálculos intensivos. A interconexão PCIe Gen4 x16 entre CPU e GPU assegura comunicação de baixa latência, crítica para treinamento paralelo de IA. Conectividade e Armazenamento Para cenários de scale-out, o sistema oferece 6 portas 400GbE QSFP-DD, permitindo integração eficiente com redes de alta velocidade e armazenamento distribuído. Em termos de armazenamento local, são disponibilizadas múltiplas configurações de bays hot-swap NVMe e SATA, incluindo até 16 unidades de 2.5” SATA com controladora adicional, possibilitando combinação de desempenho e capacidade. Redundância e Confiabilidade O servidor inclui até seis fontes de alimentação redundantes de 3000W com eficiência Titanium, além de 12 ventoinhas heavy-duty monitoradas individualmente. Recursos de segurança de hardware, como TPM 2.0, Root of Trust e firmware criptograficamente assinado, garantem integridade do sistema, protegendo dados sensíveis e operações críticas. Implementação Estratégica Considerações para Deployment A implementação de servidores de IA como o SYS-820GH-TNR2 exige planejamento detalhado do rack, distribuição de energia, resfriamento e integração com rede corporativa. A alta densidade de GPUs requer monitoramento contínuo da temperatura, além de políticas de manutenção preventiva e automação de updates via Supermicro Update Manager (SUM) e SuperCloud Composer®. Integração com Infraestrutura Existente É essencial mapear compatibilidade com storage distribuído, frameworks de IA (TensorFlow, PyTorch) e orquestração de workloads. A conectividade de 400GbE facilita a integração com clusters HPC ou sistemas de armazenamento NVMe compartilhado, garantindo que o potencial computacional do servidor seja totalmente aproveitado. Melhores Práticas Avançadas Otimização de GPU e Memória Alocar corretamente os aceleradores Gaudi 2 e balancear cargas entre CPU e memória ECC DDR4 reduz o risco de saturação de barramentos. Recomenda-se segmentar workloads por GPU, aproveitando interconexão de 21 links 100GbE PAM4 para minimizar latência entre aceleradores em operações de treinamento distribuído. Monitoramento e Manutenção Proativa Utilizar ferramentas como Supermicro SuperDoctor®5, Thin-Agent Service e Automation Assistant permite monitorar estado de hardware, prever falhas e automatizar respostas. Isso reduz downtime e aumenta a eficiência operacional, essencial em ambientes de IA empresarial que não toleram interrupções. Medição de Sucesso O sucesso da implementação pode ser medido por métricas como throughput de treinamento (samples por segundo), utilização de GPU e CPU, tempo médio entre falhas (MTBF), consumo energético por workload e capacidade de integração com clusters HPC existentes. Indicadores de SLA de rede e latência também são críticos para avaliar o desempenho em escala. Conclusão O Supermicro SYS-820GH-TNR2 representa uma solução completa para organizações que necessitam de desempenho extremo em treinamento de IA. Sua combinação de até oito aceleradores Intel Gaudi 2, CPUs Xeon escaláveis, memória ECC de alta capacidade, rede 400GbE e redundância avançada oferece uma plataforma confiável e escalável. Investir em infraestrutura de IA de ponta não é apenas uma questão de capacidade computacional, mas de garantir que modelos complexos sejam treinados de forma eficiente, segura e integrada ao ecossistema corporativo. O SYS-820GH-TNR2 cumpre essa função, mitigando riscos, aumentando performance e preparando a organização para futuras demandas de IA. Organizações interessadas devem planejar a implementação considerando integração de rede, balanceamento de workloads, monitoramento proativo e políticas de segurança de firmware, garantindo máxima eficácia e retorno sobre o investimento em inteligência artificial.

Supermicro SYS-821GE-TNMR2: Potência híbrida Intel e AMD para IA e HPC empresarial Introdução: O novo paradigma da infraestrutura híbrida para IA e HPC A evolução da inteligência artificial, da análise preditiva e do HPC (High Performance Computing) exige uma arquitetura de computação que combine alta densidade, eficiência energética e interoperabilidade entre processadores e aceleradores de última geração. Nesse cenário, o Supermicro GPU SuperServer SYS-821GE-TNMR2 se destaca como uma solução de infraestrutura híbrida que une o poder dos processadores Intel Xeon Scalable de 5ª geração à eficiência massiva das GPUs AMD Instinct™ MI300X. Projetado para cargas de trabalho intensivas em dados, como deep learning, modelagem climática, simulações financeiras, automação industrial e descoberta de fármacos, o SYS-821GE-TNMR2 redefine o padrão de desempenho e confiabilidade em servidores 8U corporativos. A negligência em adotar arquiteturas otimizadas para IA e HPC representa riscos claros: gargalos de throughput, ineficiência energética, subutilização de GPUs e aumento de custos operacionais. Este artigo explora em profundidade como o modelo SYS-821GE-TNMR2 supera essas limitações por meio de uma integração técnica robusta e uma visão arquitetônica orientada à eficiência. O problema estratégico: gargalos entre CPU e GPU em workloads modernos Em data centers corporativos modernos, o principal desafio de desempenho não está apenas na potência individual dos processadores ou GPUs, mas na eficiência da comunicação entre eles. Workloads de IA dependem de pipelines de dados contínuos, e qualquer latência entre CPU e GPU pode comprometer a escalabilidade do modelo de aprendizado. Tradicionalmente, a limitação da banda PCIe e a falta de interconexão direta entre GPUs criavam gargalos que impactavam significativamente o tempo de treinamento de redes neurais e simulações científicas. Isso se traduzia em aumento de custo por tarefa, maior consumo de energia e uso ineficiente de recursos de hardware de alto valor. O Supermicro SYS-821GE-TNMR2 foi projetado justamente para eliminar esses gargalos, utilizando o PCIe 5.0 x16 para interconexão CPU–GPU e o AMD Infinity Fabric™ Link para comunicação direta entre as GPUs MI300X, reduzindo latências internas e maximizando o desempenho coletivo. Consequências da inação: impacto da infraestrutura defasada Empresas que mantêm infraestruturas de GPU baseadas em gerações anteriores enfrentam desvantagens competitivas crescentes. A defasagem na capacidade de paralelismo e memória resulta em ciclos de treinamento mais longos, limitação na execução de modelos multimodais e dificuldade em escalar workloads para IA generativa. Além do custo de oportunidade associado à lentidão, há também implicações em consumo energético. A ausência de componentes como fontes redundantes Titanium Level 3000W e sistemas de ventilação com controle PWM pode levar ao superaquecimento e instabilidade térmica, reduzindo a confiabilidade do sistema a longo prazo. No contexto de HPC, essa defasagem também se manifesta na impossibilidade de integrar workloads híbridos de precisão mista, algo que o SYS-821GE-TNMR2 resolve ao adotar GPUs MI300X, otimizadas para FP64, FP32, FP16 e bfloat16 em arquiteturas unificadas. Fundamentos da solução: arquitetura híbrida Intel Xeon + AMD MI300X Integração CPU–GPU de próxima geração O coração do SYS-821GE-TNMR2 está na combinação de até dois processadores Intel Xeon Scalable de 5ª geração (LGA-4677), com até 64 núcleos e 128 threads cada, suportando até 350W TDP com resfriamento a ar. Essa base oferece alta largura de banda para as 8 GPUs AMD Instinct MI300X, interconectadas via PCIe 5.0 x16 dedicados. Essa topologia elimina congestionamentos de dados comuns em sistemas com multiplexação de barramentos, garantindo que cada GPU opere em comunicação direta com a CPU e com as demais GPUs via Infinity Fabric™. O resultado é uma eficiência de throughput excepcional para aplicações de IA distribuída e HPC. Memória e throughput massivo Com 32 slots DIMM e suporte a até 8TB DDR5 ECC RDIMM, o sistema é capaz de sustentar cargas de dados de larga escala em ambientes de simulação e aprendizado profundo. O suporte simultâneo a 5600MT/s (1DPC) e 4400MT/s (2DPC) permite flexibilidade entre desempenho e capacidade, fundamental para ajustar o balanceamento entre cache local e largura de banda global. A utilização de ECC DDR5 assegura integridade de dados em operações críticas, protegendo workloads científicos e financeiros contra erros de memória transitórios, o que é essencial para conformidade regulatória e estabilidade em operações 24/7. Eficiência energética e confiabilidade operacional O chassi 8U abriga seis fontes de alimentação redundantes Titanium Level de 3000W, com eficiência superior a 96%. Essa redundância garante continuidade operacional mesmo em falhas parciais, enquanto o gerenciamento térmico ativo com até dez ventiladores industriais mantém a temperatura estável sob cargas de processamento extremo. A arquitetura de energia do SYS-821GE-TNMR2 é complementada por controle PWM e monitoração dinâmica via Supermicro SuperDoctor® 5, que integra alertas proativos e otimização térmica automatizada. Implementação estratégica: integração e gestão em ambientes corporativos A implementação do SYS-821GE-TNMR2 em data centers empresariais requer planejamento de integração com plataformas de orquestração e monitoramento, como o SuperCloud Composer® e o Supermicro Server Manager (SSM). Essas ferramentas permitem controle unificado de múltiplos servidores GPU, gestão de firmware, diagnósticos e atualizações automatizadas. Em termos de segurança e governança, o modelo adota um conjunto robusto de mecanismos de proteção, incluindo TPM 2.0, Root of Trust compatível com NIST 800-193, Secure Boot e Firmware Recovery criptograficamente assinado. Essas funções atendem aos padrões de segurança corporativa exigidos em setores como finanças, saúde e defesa. A conectividade é configurável, com opções de 25GbE via Broadcom BCM57414 e 10GbE via Intel X710-AT2, assegurando compatibilidade com malhas de rede de alto throughput e baixa latência. Melhores práticas avançadas: escalabilidade e otimização Para maximizar o desempenho do SYS-821GE-TNMR2, recomenda-se a implementação de configurações simétricas de GPU e alinhamento de barramentos PCIe em topologia balanceada, reduzindo latências internas entre GPUs. A utilização do Infinity Fabric™ deve ser configurada para comunicação direta em pares de GPUs para workloads distribuídos. A integração com armazenamento NVMe de alta velocidade — até 16 baias hot-swap 2.5” — é outro ponto crítico de otimização, permitindo que datasets extensos sejam processados sem gargalos de I/O. A inclusão de dois slots M.2 NVMe dedicados ao sistema operacional libera as baias frontais para dados de projeto e treinamento. A compatibilidade com SuperServer Automation Assistant (SAA) e Supermicro Update Manager (SUM)

Supermicro 8U AI Training SuperServer SYS-822GA-NGR3: desempenho máximo para LLMs e HPC Introdução Em um cenário corporativo de inteligência artificial e modelagem de larga escala, a eficiência do hardware é determinante para competitividade. Organizações que investem em soluções de AI de ponta enfrentam desafios críticos relacionados à escalabilidade, throughput de dados e integração com frameworks avançados de aprendizado de máquina. O não acompanhamento dessas demandas pode resultar em atrasos significativos no desenvolvimento de modelos de IA, custos elevados de operação e perda de oportunidades estratégicas. O Supermicro 8U AI Training SuperServer SYS-822GA-NGR3 surge como uma solução robusta, projetada para maximizar desempenho em treinamentos de LLMs, HPC e aplicações multi-modal. Este artigo abordará em profundidade os fundamentos técnicos, implicações estratégicas, melhores práticas de implementação e métricas de sucesso para utilização eficaz do SuperServer SYS-822GA-NGR3 em ambientes empresariais exigentes. Desenvolvimento Problema Estratégico Empresas de AI enfrentam volumes massivos de dados e modelos complexos que exigem alto desempenho computacional. Servidores tradicionais podem apresentar gargalos em throughput de rede, comunicação GPU-GPU e memória, limitando a velocidade de treinamento e inferência de modelos. Para cenários de LLMs e HPC, a latência entre GPUs e CPUs, bem como a largura de banda de memória, impactam diretamente no tempo de entrega de resultados, custos de operação e escalabilidade de projetos de AI corporativos. Consequências da Inação Ignorar a necessidade de infraestrutura dedicada pode gerar ciclos de treinamento mais longos, aumento de custos energéticos e infraestruturas mais fragmentadas. Além disso, limita a capacidade de experimentar modelos mais complexos, comprometendo a inovação e competitividade empresarial. Falhas em integração de hardware e software podem levar a subutilização de recursos, interrupções de serviço e riscos de segurança, caso soluções robustas de gerenciamento e monitoramento não estejam implementadas. Fundamentos da Solução O SYS-822GA-NGR3 integra: Dual Intel® Xeon® 6900 series: até 128 núcleos por CPU, garantindo alta capacidade de processamento paralelo. 8 Gaudi® 3 OAM GPUs: aceleradores otimizados para treinamento de AI em larga escala, com interconexão de alta largura de banda PCIe Gen5 x16 e 24x 200GbE links PAM4. Memória DDR5 de até 6TB: suporta módulos RDIMM, LRDIMM e MRDIMM com latências mínimas, essencial para manipulação de datasets massivos. Armazenamento NVMe Gen5: 8 baias hot-swap 2.5” e 2 M.2 PCIe 5.0 x2, garantindo throughput elevado e baixa latência para datasets críticos. Rede de alta velocidade: 6 portas OSFP 800GbE, permitindo comunicação eficiente entre servidores em clusters HPC. Segurança de firmware e hardware: TPM 2.0, Silicon Root of Trust e Secure Boot, mitigando riscos de ataques em nível de plataforma. Estes componentes trabalham de forma integrada para reduzir gargalos, aumentar eficiência energética e permitir o processamento contínuo de workloads de AI, mantendo a confiabilidade necessária para operações críticas. Implementação Estratégica A implementação deve considerar layout físico em racks, refrigeração eficiente (10 fãs heavy-duty removíveis) e redundância energética com 8 fontes de 3000W Titanium. A configuração de rede deve otimizar o uso das 6 portas OSFP 800GbE, garantindo baixa latência e alta largura de banda entre nós de cluster. O SuperCloud Composer® e o Supermicro Server Manager permitem monitoramento centralizado de hardware, provisionamento de recursos e automação de manutenção preventiva, reduzindo riscos de downtime e maximizando a utilização dos recursos computacionais. Melhores Práticas Avançadas Para maximizar o desempenho de AI, recomenda-se: Distribuir cargas de treinamento de forma balanceada entre GPUs Gaudi® 3, evitando saturação de links PAM4. Configurar memória DDR5 em modos otimizados para latência mínima e maior throughput de dados. Implementar políticas de atualização segura de firmware utilizando recursos de Secure Boot e Automatic Firmware Recovery. Monitorar temperatura e tensão de CPUs e GPUs em tempo real para prevenir throttling e falhas térmicas. Integrar armazenamento NVMe Gen5 com sistemas de orquestração de dados para reduzir gargalos de I/O em datasets massivos. Medição de Sucesso Indicadores de eficácia incluem tempo médio de treinamento de modelos, utilização média de GPU e CPU, throughput de rede em clusters HPC e disponibilidade do sistema. Métricas de eficiência energética e redundância operacional também devem ser monitoradas para assegurar ROI positivo e confiabilidade corporativa. Conclusão O Supermicro 8U AI Training SuperServer SYS-822GA-NGR3 com 8 Gaudi® 3 é uma solução estratégica para empresas que buscam desempenho extremo em AI, HPC e LLMs. Sua arquitetura integrada de CPUs, GPUs, memória e rede permite alta escalabilidade e confiabilidade operacional. Organizações que adotarem essa plataforma estarão preparadas para enfrentar desafios de treinamento de modelos complexos, acelerar time-to-market e manter competitividade em um cenário tecnológico em rápida evolução. O investimento em infraestrutura robusta, gerenciamento avançado e práticas operacionais eficientes garantirá não apenas desempenho, mas também segurança e escalabilidade a longo prazo. Próximos passos incluem planejamento de cluster, otimização de workloads de AI, integração com sistemas existentes e monitoramento contínuo de métricas críticas para garantir que o investimento em tecnologia resulte em vantagem estratégica real.

Supermicro DP AMD 8U com AMD Instinct MI300X: desempenho máximo em IA e HPC O Supermicro A+ Server AS-8125GS-TNMR2 representa uma das plataformas mais avançadas do portfólio de servidores GPU da linha Gold Series. Projetado em formato 8U, o sistema combina 8 GPUs AMD Instinct™ MI300X e processadores AMD EPYC™ 9004/9005 para atender às mais exigentes cargas de trabalho em Inteligência Artificial (IA), High Performance Computing (HPC) e automação industrial. Este artigo analisa em profundidade sua arquitetura, interconexões, eficiência térmica e benefícios estratégicos para empresas que buscam consolidar desempenho e densidade computacional extrema. Contexto Estratégico e Relevância Empresarial No cenário atual, empresas que dependem de modelos de IA generativa, análise de dados em tempo real e simulações complexas enfrentam o desafio de equilibrar poder computacional com eficiência energética e escalabilidade. A Supermicro, em parceria com a AMD, responde a esse desafio com o DP AMD 8U System with AMD Instinct™ MI300X 8-GPU, uma solução que redefine o padrão de densidade e conectividade em servidores GPU. Mais do que potência bruta, esse sistema traz um ecossistema otimizado para interconexão direta GPU-GPU via AMD Infinity Fabric™ Link e suporte a até 6 TB de memória DDR5 ECC, fatores decisivos para cargas de trabalho de IA distribuída e HPC em escala de data center. Problema Estratégico: Escalabilidade e Interconexão de GPUs Os projetos de IA e HPC modernos exigem interconectividade eficiente entre múltiplas GPUs, o que determina diretamente a velocidade de treinamento de modelos e a largura de banda disponível para transferência de dados. Em arquiteturas tradicionais, limitações na comunicação entre GPUs e CPUs resultam em gargalos de desempenho e aumento de latência. O AS-8125GS-TNMR2 endereça esse problema com um design otimizado para RDMA direto entre GPUs (GPU direct RDMA 1:1) e interconexão PCIe 5.0 x16 de alta velocidade entre CPUs e GPUs. Isso elimina intermediários desnecessários e maximiza a eficiência de comunicação, fator crítico para aplicações como deep learning, simulações de fluidos e inferência de modelos de larga escala. Consequências da Inação: Gargalos, Consumo e Custo Operacional A ausência de infraestrutura GPU otimizada, especialmente em cargas paralelas massivas, pode levar a um desperdício significativo de recursos computacionais. Sistemas baseados em PCIe 4.0, por exemplo, limitam a largura de banda entre GPUs, retardando o desempenho em até 40% em comparação com topologias baseadas em PCIe 5.0 e Infinity Fabric. Além do impacto em desempenho, há implicações financeiras diretas: ciclos de treinamento mais longos aumentam custos energéticos e reduzem a eficiência por watt. Em ambientes de HPC, onde cada nó precisa entregar throughput previsível, a escolha de arquitetura torna-se um fator estratégico para o ROI do data center. Fundamentos da Solução: Arquitetura de Desempenho Extremo No núcleo da solução, o Supermicro A+ Server AS-8125GS-TNMR2 combina dois processadores AMD EPYC™ 9004/9005 com suporte a até 400W TDP e 8 GPUs AMD Instinct™ MI300X. Essa combinação é sustentada por um backplane PCIe 5.0 de baixa latência e topologia de interconexão que prioriza comunicação direta CPU-GPU e GPU-GPU. Memória e Largura de Banda Com até 24 slots DIMM DDR5 ECC, o sistema oferece até 6 TB de memória com velocidades de até 6000 MT/s, permitindo fluxos massivos de dados em aplicações de IA distribuída. A integridade é garantida por suporte a ECC e a robusta arquitetura de energia com reguladores de 7+1 fases. Armazenamento e Expansão O servidor suporta até 16 baias NVMe hot-swap de 2,5″ (12 padrão + 4 opcionais), além de 2 baias SATA dedicadas e slots M.2 NVMe para o sistema operacional. Essa flexibilidade é crucial para workloads que exigem throughput de I/O constante e latência mínima. Interconexão e Rede Com 8 NICs dedicadas para RDMA direto entre GPUs e opções flexíveis de rede PCIe 5.0 x16 LP ou FHFL, o sistema garante conectividade de baixa latência com clusters externos e redes InfiniBand. Essa característica posiciona o modelo como um backbone ideal para clusters de IA ou HPC com comunicação peer-to-peer intensa. Implementação Estratégica: Desempenho, Energia e Segurança Projetar uma infraestrutura com 8 GPUs MI300X requer um equilíbrio cuidadoso entre potência térmica e estabilidade operacional. O AS-8125GS-TNMR2 utiliza um conjunto de 10 ventiladores industriais com controle automático de rotação e 6 fontes redundantes de 3000W com certificação Titanium (96%), assegurando operação contínua mesmo sob carga total. Gestão e Orquestração A camada de gerenciamento é um diferencial do sistema. Ferramentas como SuperCloud Composer®, Supermicro Server Manager (SSM) e SuperDoctor® 5 permitem supervisão granular de recursos, automação de updates via Supermicro Update Manager (SUM) e diagnóstico offline com Super Diagnostics Offline (SDO). O novo SuperServer Automation Assistant (SAA) amplia essa automação para escala de rack, ideal para data centers com centenas de nós GPU. Segurança e Conformidade O servidor implementa uma cadeia de confiança baseada em hardware com TPM 2.0 e Silicon Root of Trust (RoT), em conformidade com a norma NIST 800-193. Isso garante firmware autenticado criptograficamente, atualizações seguras e proteção em tempo de execução via System Lockdown e Remote Attestation. Essa abordagem de segurança é essencial em ambientes HPC e IA que processam dados sensíveis ou modelos proprietários. Melhores Práticas Avançadas: Otimização e Governança Para maximizar a eficiência do sistema, recomenda-se configurar o cluster em topologia híbrida CPU-GPU balanceada, assegurando a utilização plena das linhas PCIe 5.0. A integração com redes de alta largura de banda (100/200 GbE ou InfiniBand) potencializa o desempenho em pipelines de treinamento distribuído. Do ponto de vista de governança, a infraestrutura deve incorporar políticas de firmware assinado e auditorias automáticas de integridade. O ecossistema Supermicro facilita isso com ferramentas de monitoramento contínuo e APIs abertas para integração com plataformas de observabilidade corporativas. Medição de Sucesso: Indicadores de Eficiência e ROI O sucesso da implementação deve ser medido por métricas como throughput de inferência por watt, tempo médio de treinamento e latência média GPU-GPU. Em benchmarks internos, sistemas baseados em PCIe 5.0 e MI300X demonstram ganhos substanciais em eficiência energética e densidade computacional por rack. Empresas que migram de soluções de geração anterior podem observar reduções de até 25% em consumo energético e aumentos de até 40% na velocidade

Introdução: desempenho extremo como alicerce da inovação em IA e HPC No atual cenário de inteligência artificial e computação de alto desempenho (HPC), a capacidade de processar volumes massivos de dados e treinar modelos complexos de deep learning é um diferencial competitivo decisivo. Organizações de pesquisa, instituições financeiras, laboratórios científicos e data centers corporativos exigem sistemas com densidade computacional e eficiência energética máximas. É neste contexto que a Supermicro apresenta o DP AMD 8U System with NVIDIA HGX H100/H200 8-GPU, um sistema certificado pela NVIDIA e projetado segundo os padrões OCP (Open Compute Project) para oferecer desempenho, confiabilidade e escalabilidade superiores. O desafio empresarial vai além da simples potência bruta: trata-se de alinhar arquiteturas de hardware avançadas — como CPUs AMD EPYC™ 9004, GPUs NVIDIA HGX e interconexões NVLink™ — à governança, eficiência energética e gestão centralizada. O custo da inação, nesse contexto, é claro: gargalos de performance, desperdício energético e incapacidade de escalar projetos de IA de forma previsível e segura. O desafio estratégico: escalar IA e HPC sem comprometer eficiência Empresas que investem em IA e HPC enfrentam um dilema constante: como aumentar a capacidade computacional sem elevar exponencialmente os custos operacionais e o consumo energético. Modelos de linguagem de larga escala (LLMs), simulações científicas e workloads de análise preditiva demandam infraestrutura com altíssima largura de banda entre GPU e CPU, suporte a memórias DDR5 e conectividade PCIe 5.0. Tradicionalmente, sistemas baseados em múltiplas GPUs sofrem com limitações de interconexão, atrasos de latência e gargalos no fluxo de dados. Em ambientes de HPC, isso representa perda direta de desempenho e aumento no tempo de execução das cargas. A Supermicro aborda esse problema com uma solução arquitetural de alta densidade e interconexão otimizada, eliminando o tradicional compromisso entre potência e eficiência térmica. O servidor AMD 8U com NVIDIA HGX H100/H200 é, portanto, uma resposta direta às exigências de IA moderna e computação científica em escala. Consequências da inação: quando a infraestrutura se torna o gargalo A ausência de uma infraestrutura otimizada para GPU pode gerar efeitos sistêmicos: atrasos na entrega de modelos de IA, aumento de custo energético e incapacidade de atender a padrões de confiabilidade exigidos por setores regulados. Workloads de treinamento distribuído em redes ineficientes causam desperdício de processamento — o que impacta diretamente o ROI de projetos de IA corporativa. Além disso, data centers que não adotam soluções de refrigeração e gerenciamento inteligente de energia enfrentam riscos de sobrecarga térmica e degradação prematura dos componentes. Por outro lado, o DP AMD 8U oferece 10 ventoinhas de alta capacidade com controle otimizado de velocidade, garantindo estabilidade térmica e desempenho contínuo. A combinação de seis fontes redundantes Titanium Level de 3000W (3+3) assegura alta disponibilidade mesmo em cargas intensas, reduzindo falhas operacionais e ampliando o ciclo de vida da infraestrutura. Fundamentos da solução: arquitetura de precisão para IA e HPC A base técnica do Supermicro DP AMD 8U é composta por duas colunas de força: Processadores AMD EPYC™ 9004 (até 128 núcleos/256 threads, 400W TDP) Plataforma NVIDIA HGX™ H100/H200 8-GPU com NVSwitch™ Essa combinação cria uma topologia de comunicação extremamente eficiente, permitindo interconexão GPU-GPU via NVLink™ e GPU-CPU via PCIe 5.0 x16. O resultado é uma redução drástica da latência e um aumento significativo na largura de banda entre as unidades de processamento. O sistema suporta até 6 TB de memória DDR5 ECC RDIMM 4800MT/s distribuída em 24 slots DIMM, garantindo consistência e velocidade em operações de inferência e treinamento. A ECC (Error Correction Code) mantém a integridade dos dados em tempo real, recurso crítico em ambientes de modelagem científica e automação industrial. Implementação estratégica: flexibilidade, segurança e governança A arquitetura de 8U foi projetada para integração em data centers de missão crítica. Com até 18 baias hot-swap, sendo 12 NVMe, 4 NVMe adicionais opcionais e 2 SATA, o sistema permite expansão modular e substituição sem downtime. No campo da segurança, o servidor implementa uma raiz de confiança de hardware (Silicon Root of Trust) compatível com o padrão NIST 800-193, além de TPM 2.0, firmware assinado criptograficamente, Secure Boot, e atestado remoto de cadeia de suprimentos. Essa abordagem garante que o ambiente de IA esteja protegido desde o firmware até o runtime operacional. A gestão centralizada é realizada via SuperCloud Composer®, Supermicro Server Manager (SSM) e SuperDoctor® 5 (SD5), que proporcionam visibilidade completa sobre saúde do sistema, consumo energético e controle térmico. Esses recursos simplificam a administração de clusters com múltiplos servidores GPU, otimizando custos operacionais. Melhores práticas avançadas: desempenho e eficiência em equilíbrio A operação eficiente do DP AMD 8U requer alinhamento entre hardware e políticas de orquestração de workloads. Em aplicações de treinamento distribuído, o uso do RDMA (Remote Direct Memory Access) — viabilizado por 8 NICs com conectividade direta GPU-a-GPU (1:1) — garante latência ultrabaixa entre nós de processamento. Do ponto de vista de eficiência energética, as fontes Titanium Level (96%) e o gerenciamento dinâmico de ventiladores reduzem o consumo sem comprometer o throughput. Em termos de manutenção, o design modular e o suporte a PCIe 5.0 permitem futuras atualizações sem reengenharia do sistema. Empresas que implementam políticas de automação via SuperServer Automation Assistant (SAA) ou Supermicro Update Manager (SUM) ampliam a resiliência operacional, garantindo que atualizações de firmware e diagnósticos offline sejam executados sem afetar a disponibilidade do ambiente. Medição de sucesso: avaliando desempenho e confiabilidade O sucesso na adoção do servidor AMD 8U com NVIDIA HGX H100/H200 pode ser mensurado por métricas como: Aceleração de treinamento de modelos de IA (comparando throughput por watt) Eficiência térmica e estabilidade operacional sob carga máxima Tempo médio entre falhas (MTBF) em operações de 24×7 Escalabilidade linear em clusters multi-nó com interconexão NVSwitch Essas métricas traduzem-se em ganhos tangíveis: redução de tempo de treinamento, melhor utilização de GPU e maior previsibilidade de custos. A arquitetura otimizada para PCIe 5.0 e NVLink permite que workloads de IA complexos sejam executados com mínima interferência entre dispositivos, garantindo escalabilidade consistente. Conclusão: o novo paradigma de performance para IA corporativa O Supermicro DP AMD 8U System with NVIDIA HGX H100/H200

Supermicro 8U GPU Server: Performance Extrema para IA e HPC Introdução No cenário empresarial atual, a demanda por processamento massivo de dados e inteligência artificial cresce exponencialmente. Organizações de pesquisa, centros financeiros e indústrias de manufatura avançada enfrentam desafios críticos para suportar workloads de IA, treinamento de modelos de deep learning e análises complexas em tempo real. A necessidade de performance extrema, confiabilidade e escalabilidade é estratégica para manter competitividade. A inação diante desses desafios pode resultar em atrasos em projetos de inovação, perda de vantagem competitiva e custos elevados de manutenção de infraestrutura insuficiente. Servidores tradicionais muitas vezes não suportam throughput e densidade de GPU necessários para modelos de IA de última geração. Este artigo explora o Supermicro SYS-821GE-TNHR, um servidor GPU 8U equipado com até 8 GPUs NVIDIA HGX H100/H200 e processadores Intel Xeon de última geração, detalhando arquitetura, implementação estratégica, trade-offs e melhores práticas para ambientes de alta performance. Desenvolvimento Problema Estratégico: Desafios em IA e HPC Empresas que operam com modelos de IA de larga escala e simulações HPC enfrentam limitações significativas em servidores tradicionais. O aumento exponencial de dados requer interconexões de alta largura de banda entre CPU e GPU, memória de baixa latência e armazenamento NVMe de alto desempenho. Sistemas não otimizados comprometem o tempo de treinamento de modelos e a performance analítica. O desafio estratégico é alinhar capacidade de processamento massivo com eficiência energética, resiliência e flexibilidade para diferentes workloads. Servidores subdimensionados implicam em ciclos de processamento prolongados e custo total de propriedade elevado. Consequências da Inação Não investir em infraestrutura GPU de alta performance resulta em atrasos em projetos de P&D, perda de competitividade em setores sensíveis à inovação e aumento de risco operacional. A execução de workloads intensivos em IA em servidores convencionais aumenta a latência, limita a escalabilidade e pode causar gargalos críticos em análise de dados. Além disso, a falta de redundância adequada e gerenciamento avançado aumenta o risco de downtime, comprometendo continuidade de negócios e expondo a organização a custos inesperados de manutenção e recuperação. Fundamentos da Solução: Arquitetura do SuperServer SYS-821GE-TNHR O Supermicro SYS-821GE-TNHR é projetado para workloads exigentes, integrando até 8 GPUs NVIDIA HGX H100/H200 conectadas via NVLink com NVSwitch, proporcionando interconexão GPU-GPU de altíssima largura de banda. O CPU-GPU interconnect é feito via PCIe Gen5 x16, garantindo throughput máximo para transferência de dados entre processador e aceleradores. O sistema suporta dual socket Intel Xeon de 4ª ou 5ª geração, com até 64 cores e 128 threads por CPU, memória DDR5 ECC de até 8TB e 32 slots DIMM. Essa configuração permite execução simultânea de múltiplos modelos de deep learning ou simulações HPC complexas sem degradação de performance. Em termos de armazenamento, o servidor oferece 12 bays NVMe hot-swap por padrão, expandidos até 16 NVMe e 3-8 bays SATA adicionais, permitindo arquiteturas híbridas de alto desempenho. O boot é gerenciado por 2 slots M.2 NVMe, garantindo inicialização rápida e confiável. O gerenciamento de sistema é robusto, com SuperCloud Composer, Supermicro Server Manager (SSM) e SuperDoctor 5, proporcionando monitoramento proativo, automação e diagnósticos offline, críticos para data centers corporativos e ambientes de IA sensíveis a falhas. Implementação Estratégica A implementação do SYS-821GE-TNHR requer planejamento de rack 8U, refrigeração adequada e configuração de fontes redundantes Titanium (até 6x 3000W). A distribuição das GPUs e memória deve considerar otimização de airflow e balanceamento de carga para evitar throttling térmico em workloads prolongados. Integração com redes de alta velocidade é fundamental. O servidor suporta múltiplas opções de 10GbE e 25GbE, permitindo interconexão eficiente com storage distribuído, clusters HPC e sistemas de ingestão de dados em tempo real. O alinhamento entre interconexões de rede, armazenamento NVMe e memória de alta capacidade é crítico para maximizar a performance de IA e HPC. Considerações de segurança incluem Silicon Root of Trust (RoT), firmware assinado, secure boot e attestation de supply chain, fundamentais para organizações que operam com dados sensíveis em setores como saúde, financeiro e pesquisa científica. Melhores Práticas Avançadas Para maximizar performance, recomenda-se segmentar workloads em grupos de GPU via NVLink, ajustando políticas de alocação de memória e otimização de I/O. Monitoramento contínuo da temperatura, voltagem e saúde de cada componente é crucial para evitar degradação de hardware. O uso de ferramentas de gerenciamento como SSM e SuperCloud Composer permite automação de provisionamento, atualizações de firmware seguras e monitoramento proativo de falhas, reduzindo downtime e custo operacional. O design modular do chassis 8U facilita upgrades futuros de GPUs, memória ou armazenamento NVMe, permitindo que organizações escalem conforme a necessidade sem substituir o servidor integralmente. Medindo o Sucesso A eficácia da implementação pode ser medida por métricas como throughput de treinamento de modelos IA (ex: imagens/segundo em deep learning), latência de I/O em NVMe, utilização de GPU e CPU, e tempo médio entre falhas (MTBF). Indicadores de eficiência energética, como desempenho por Watt, são críticos em ambientes corporativos para controlar custos operacionais. Além disso, monitoramento contínuo da integridade do firmware, velocidade de refrigeração e redundância de fontes de alimentação garante resiliência e disponibilidade do sistema, alinhando performance técnica a objetivos estratégicos de negócio. Conclusão O Supermicro SYS-821GE-TNHR representa uma solução robusta e escalável para ambientes corporativos que demandam processamento extremo de IA e HPC. Com até 8 GPUs NVIDIA HGX H100/H200, dual socket Intel Xeon, memória DDR5 de até 8TB e armazenamento NVMe de alta densidade, o servidor atende às necessidades de workloads críticos com confiabilidade e flexibilidade. O planejamento estratégico para implementação deve considerar refrigeração, interconexões PCIe e NVLink, segurança de firmware e gerenciamento proativo. Seguindo as melhores práticas, é possível maximizar desempenho, reduzir riscos e garantir escalabilidade futura. O investimento em infraestrutura de alta performance como o SYS-821GE-TNHR não apenas resolve desafios técnicos imediatos, mas posiciona a organização para inovação contínua, aceleração de IA e análise avançada de dados, fortalecendo a competitividade no mercado global.

Introdução O avanço das aplicações em inteligência artificial, aprendizado profundo e simulações científicas trouxe à infraestrutura computacional um novo paradigma: a convergência entre alta densidade de GPU, escalabilidade de interconexão e eficiência energética. Nesse contexto, o Supermicro SYS-A21GE-NBRT surge como uma solução projetada para cenários onde desempenho, confiabilidade e integração arquitetônica são fatores determinantes. Este servidor de 10U combina duas CPUs Intel Xeon de 5ª ou 4ª geração com um conjunto de 8 GPUs NVIDIA B200 SXM e interconexão NVLink, oferecendo 1,4 TB de memória HBM3e dedicada ao processamento de cargas de trabalho massivas. Trata-se de uma plataforma voltada para empresas e instituições que operam no limite da computação moderna — de centros de pesquisa e laboratórios farmacêuticos a provedores de nuvem e ambientes de IA generativa. A inação diante de demandas computacionais crescentes impõe riscos diretos à competitividade: projetos de IA que demoram para treinar, simulações que não escalam e custos energéticos que se tornam insustentáveis. O SYS-A21GE-NBRT endereça esses desafios ao integrar engenharia térmica, eficiência elétrica e gerenciamento centralizado, criando uma base sólida para arquiteturas de data center de próxima geração. Desenvolvimento Problema Estratégico: O Limite da Computação Convencional Ambientes corporativos e científicos modernos enfrentam uma barreira técnica clara: o volume e a complexidade dos modelos de IA e HPC já superam a capacidade das arquiteturas tradicionais baseadas apenas em CPU. Enquanto os processadores evoluem em eficiência por núcleo, a natureza paralela das cargas de IA exige milhares de threads simultâneas, algo só possível com a integração massiva de GPUs de alta largura de banda. Em projetos de deep learning ou modelagem molecular, o gargalo não está mais no cálculo, mas na movimentação e sincronização dos dados entre dispositivos. Sem uma arquitetura NVLink e NVSwitch, como a presente no HGX B200, os tempos de treinamento podem multiplicar-se, impactando prazos, custos e inovação. É justamente nesse ponto que o Supermicro 10U se diferencia — não apenas pela potência bruta, mas pela coerência entre CPU, GPU e interconexão. Consequências da Inação Ignorar a necessidade de infraestrutura de GPU de última geração pode significar, para empresas de tecnologia, perdas substanciais em velocidade de desenvolvimento e eficiência operacional. Modelos de IA generativa e aplicações de HPC baseadas em simulação dependem de throughput constante; sem hardware especializado, o tempo de iteração aumenta exponencialmente, reduzindo o retorno sobre o investimento em pesquisa e inovação. Além disso, a ausência de sistemas otimizados em consumo e densidade — como os 6 módulos de energia redundante de 5250W com eficiência Titanium Level — acarreta custos energéticos crescentes e maior dissipação térmica, comprometendo a sustentabilidade e o ciclo de vida da infraestrutura. Fundamentos da Solução: Arquitetura e Integração O Supermicro SYS-A21GE-NBRT é construído sobre o conceito de integração densa e interconexão inteligente. Seu chassi de 10U abriga: 8 GPUs NVIDIA HGX B200 SXM interligadas via NVLink e NVSwitch, garantindo baixa latência e largura de banda massiva entre GPUs. Duas CPUs Intel Xeon Scalable de 5ª/4ª geração (até 64 núcleos e 320 MB de cache por CPU), conectadas em topologia PCIe 5.0 x16. 32 slots DIMM DDR5 ECC com capacidade de até 8 TB de memória — combinando alta densidade e correção de erros crítica para cargas persistentes. 10 baias hot-swap NVMe U.2 PCIe 5.0 x4 para armazenamento de alta velocidade e redundância configurável via controladoras adicionais. Essa composição forma uma plataforma de computação heterogênea onde o paralelismo é explorado em todos os níveis: processamento, memória e interconexão. O uso do padrão PCIe 5.0 assegura largura de banda suficiente para comunicações CPU-GPU e expansão via placas adicionais em 8 slots LP e 2 slots FHHL. Implementação Estratégica e Gestão Operacional A operação eficiente de um sistema com essa densidade de GPU exige ferramentas de orquestração e monitoramento integradas. O SYS-A21GE-NBRT adota o ecossistema de software Supermicro Server Management Suite, composto por módulos especializados: SuperCloud Composer® – gestão unificada de recursos de data center. Supermicro Server Manager (SSM) – monitoramento e automação de hardware. SuperDoctor® 5 (SD5) e SUM – diagnóstico e atualizações remotas. SuperServer Automation Assistant (SAA) – automação de inicialização e provisionamento. Essas camadas reduzem a complexidade operacional, permitindo que equipes de TI mantenham dezenas de nós GPU sob políticas consistentes de energia, firmware e desempenho. O suporte ao TPM 2.0 e aos recursos de BIOS UEFI de 32 MB adiciona camadas de segurança, conformidade e auditabilidade — requisitos fundamentais para setores financeiro e governamental. Melhores Práticas Avançadas de Configuração O desempenho do SYS-A21GE-NBRT é maximizado quando equilibrado em três eixos: energia, resfriamento e balanceamento de I/O. O conjunto de até 15 ventoinhas de 80mm e 4 internas de 60mm cria redundância térmica para cargas de 350W por CPU e até 700W por GPU. A arquitetura de alimentação (3+3) com fontes hot-plug de 5250W assegura continuidade mesmo em caso de falha parcial. Em ambientes de HPC e IA distribuída, recomenda-se isolar o tráfego de dados e gerenciamento através das interfaces duais 10GbE RJ45 e IPMI dedicado. Essa separação reduz latências e aumenta a confiabilidade de clusters com múltiplos nós. O uso de módulos NVMe dedicados via M.2 PCIe 3.0 (com suporte a RAID por VROC) complementa o desempenho local, oferecendo IOPS elevados para caching de datasets. Medição de Sucesso e Indicadores de Eficiência A eficácia de uma implementação baseada no SYS-A21GE-NBRT deve ser medida por métricas integradas de desempenho e eficiência: Throughput computacional: ganho em FLOPS sustentados nas 8 GPUs NVLink interconectadas. Escalabilidade térmica: manutenção de temperatura operacional abaixo de 35°C em carga total. Eficiência energética: relação Watts/FLOP em nível de nó considerando fontes Titanium (96%). Uptime operacional: disponibilidade contínua em clusters com redundância de energia e ventilação. Essas métricas, combinadas a relatórios do SuperDoctor e SSM, fornecem base empírica para avaliar o retorno técnico e financeiro do investimento em GPU computing de alta densidade. Interoperabilidade e Conectividade O design modular do SYS-A21GE-NBRT permite integração fluida com infraestruturas existentes. A conectividade PCIe 5.0 oferece suporte direto a adaptadores de rede, controladoras de armazenamento e GPUs adicionais, viabilizando topologias flexíveis de expansão. A compatibilidade com o chassi

Introdução: Computação Acelerada em Escala Corporativa A transformação digital nas empresas atingiu um ponto em que a capacidade de processamento paralelo se tornou o alicerce da inovação. Modelos de IA generativa, simulações científicas complexas e treinamento de redes neurais profundas exigem infraestrutura capaz de lidar com volumes massivos de dados e processamento intensivo em GPU. Nesse contexto, o Servidor GPU 10U da Supermicro com NVIDIA HGX B200 e processadores AMD EPYC 9005/9004 representa o ápice da engenharia em computação de alto desempenho (HPC). Projetado para operações críticas em data centers corporativos e ambientes científicos, esse sistema entrega densidade computacional extrema, eficiência energética de classe Titanium e integração arquitetônica otimizada entre CPU, GPU, memória e rede. O artigo a seguir examina em profundidade como o design 10U com 8 GPUs NVIDIA B200 SXM e arquitetura AMD EPYC cria uma plataforma robusta para IA, aprendizado profundo e cargas de trabalho científicas avançadas — explorando fundamentos técnicos, desafios de implementação e implicações estratégicas para o negócio. O Problema Estratégico: Limites da Computação Convencional O avanço de modelos de IA com centenas de bilhões de parâmetros e simulações científicas de alta fidelidade impõe uma limitação clara às arquiteturas tradicionais baseadas apenas em CPU. Mesmo processadores de última geração atingem gargalos quando a tarefa exige milhares de operações matriciais simultâneas e grande largura de banda de memória. Empresas em setores como pesquisa científica, automação industrial, saúde e finanças enfrentam o dilema de escalar desempenho sem comprometer eficiência energética e custo operacional. A infraestrutura convencional não oferece interconexão de baixa latência entre múltiplas GPUs nem suporte a memória DDR5 de alta frequência com correção ECC. É nesse cenário que o sistema 10U com NVIDIA HGX B200 8-GPU redefine os limites, permitindo um salto quântico em paralelismo computacional e throughput. Ele oferece uma base sólida para projetos de IA corporativa e HPC, com confiabilidade e previsibilidade de desempenho. Consequências da Inação: Gargalos e Perda de Competitividade Ignorar a transição para plataformas aceleradas por GPU pode gerar consequências estratégicas severas. Modelos de aprendizado profundo demoram dias ou semanas para treinar em sistemas apenas com CPU, reduzindo a velocidade de inovação. Projetos científicos que exigem análise de dados climáticos, genômicos ou financeiros em tempo real tornam-se inviáveis. Além disso, há implicações diretas no custo de oportunidade. A incapacidade de processar grandes volumes de dados rapidamente impacta a tomada de decisão baseada em IA, reduzindo a vantagem competitiva em mercados altamente dinâmicos. O Servidor GPU 10U da Supermicro responde a esses desafios ao combinar 8 GPUs NVIDIA HGX B200 (180GB) com interconexão NVLink e NVSwitch, criando um tecido de comunicação interna de baixa latência e alta largura de banda. Esse design elimina gargalos típicos e maximiza o uso simultâneo dos recursos de GPU. Fundamentos da Solução: Arquitetura Integrada AMD + NVIDIA Processamento Híbrido de Alta Densidade O sistema adota duas CPUs AMD EPYC™ das séries 9005/9004, oferecendo até 384 núcleos e 768 threads, com suporte a 500W TDP por CPU. Essa configuração garante distribuição balanceada de threads e largura de banda PCIe 5.0 x16, essencial para comunicação direta CPU-GPU. Cada GPU NVIDIA B200 se beneficia de NVLink e NVSwitch, formando uma malha de interconexão que permite transferência massiva de dados entre GPUs sem intervenção da CPU. Isso é vital em workloads de IA e HPC, onde a sincronização entre GPUs define o tempo total de execução. Memória DDR5 ECC de Alta Velocidade Com 24 slots DIMM e suporte a até 6TB de memória DDR5 ECC RDIMM 6400 MT/s, o sistema oferece uma plataforma ideal para aplicações que demandam latência mínima e integridade total dos dados. O suporte ECC é fundamental em ambientes científicos e financeiros, onde erros de bit podem comprometer resultados e decisões. Eficiência Energética e Resiliência de Data Center O sistema conta com seis fontes redundantes de 5250W certificadas Titanium (96%), assegurando operação contínua com redução de consumo elétrico em larga escala. Essa eficiência é crucial para data centers corporativos, onde cada watt economizado se traduz em menor custo operacional e menor impacto ambiental. Implementação Estratégica: Desenho e Operação em Escala Infraestrutura Física e Térmica Com formato 10U e peso líquido de 133 kg, o servidor requer racks de alta capacidade estrutural e planejamento térmico rigoroso. O sistema inclui até 19 ventoinhas de 8 cm com controle PWM, otimizando a refrigeração de GPUs SXM de alto consumo. A implementação em data centers exige monitoramento contínuo de temperatura, voltagem e fluxo de ar, funções integradas via SuperDoctor® 5 e BMC com suporte a ACPI e System Lockdown. Essa abordagem garante estabilidade operacional sob cargas extremas. Gerenciamento e Automação Avançada A integração com o ecossistema Supermicro SuperCloud Composer®, SSM, SUM e SAA simplifica a administração em larga escala. O SuperServer Automation Assistant (SAA) permite provisionamento automatizado, reduzindo tempo de configuração e erros humanos — fator crítico em ambientes com dezenas de nós GPU interligados. Segurança de Firmware e Supply Chain O sistema inclui TPM 2.0, Secure Boot, Firmware Assinado e Recuperação Automática, além de Remote Attestation — elementos que fortalecem a segurança da cadeia de fornecimento, essencial em projetos governamentais e de pesquisa sensível. Esses mecanismos protegem o ambiente contra manipulações de firmware, ataques persistentes e alterações não autorizadas no BIOS ou BMC. Melhores Práticas Avançadas de Operação e Otimização A eficiência do Servidor GPU 10U com HGX B200 depende de uma integração cuidadosa entre hardware, software e rede. A seguir, abordam-se práticas fundamentais para maximizar desempenho e longevidade do sistema: 1. Balanceamento de Carga entre CPU e GPU Aplicações de IA devem aproveitar bibliotecas otimizadas para CUDA e cuDNN, garantindo que o processamento intensivo seja distribuído dinamicamente entre CPU e GPU. A arquitetura PCIe 5.0 x16 elimina gargalos de comunicação, mas requer tunning cuidadoso para evitar saturação de memória. 2. Escalabilidade Horizontal e Clustering Ao integrar múltiplos nós 10U via NVIDIA NVLink Switch e rede 10GbE Intel X710, é possível formar clusters para treinamento de modelos de IA distribuídos, alcançando escalabilidade quase linear. A interconectividade robusta reduz latência de sincronização e melhora o desempenho agregado. 3. Monitoramento Contínuo

Introdução No cenário atual de computação de alto desempenho (HPC) e inteligência artificial (IA), as demandas por eficiência, escalabilidade e integração entre CPU e GPU atingiram novos patamares. O avanço dos modelos de IA generativa e dos workloads científicos complexos exige uma infraestrutura capaz de sustentar cálculos massivamente paralelos e transferências de dados em altíssima velocidade. É nesse contexto que o Supermicro A+ Server AS-4124GQ-TNMI se posiciona como uma solução de referência. Baseado na arquitetura AMD Instinct MI250 OAM e nos processadores AMD EPYC 7003, o sistema foi projetado para maximizar o throughput computacional e otimizar a comunicação entre GPUs via Infinity Fabric Link. Seu design de 4U combina densidade, desempenho e confiabilidade, com foco em cargas de trabalho críticas de HPC, aprendizado profundo e análise científica. Organizações que negligenciam a modernização de seus clusters HPC enfrentam gargalos sérios: tempos de treinamento prolongados, consumo energético elevado e ineficiência na orquestração de workloads híbridos. Este artigo examina, em profundidade, como o servidor GPU AMD da Supermicro redefine a eficiência operacional e acelera o processamento de IA em escala empresarial. Problema Estratégico: o gargalo entre computação e comunicação A transição para workloads baseados em IA e análise preditiva tem revelado um desafio fundamental: a discrepância entre a velocidade de processamento dos aceleradores e a capacidade de transferência de dados entre componentes. Em arquiteturas convencionais, a latência entre GPU-GPU e CPU-GPU cria um gargalo que limita o desempenho real, mesmo em sistemas com alto poder teórico de FLOPs. Para data centers que executam aplicações como simulações moleculares, inferência em larga escala e modelagem financeira, essa limitação representa um custo direto. O atraso na comunicação interprocessos reduz o uso efetivo das GPUs, impactando o retorno sobre investimento (ROI) e ampliando os custos energéticos e operacionais. Além disso, a falta de um ecossistema unificado entre hardware e software torna a otimização uma tarefa complexa para equipes de TI corporativas. Consequências da Inação: riscos de obsolescência técnica e competitiva Ignorar a evolução das arquiteturas GPU modernas implica mais do que perda de desempenho: representa uma perda estratégica. Organizações que mantêm clusters baseados em interconexões legadas ou CPUs de gerações anteriores sofrem com escalabilidade limitada, maior latência e menor eficiência térmica. Esses fatores reduzem a competitividade em áreas como pesquisa científica, análise de dados e serviços de IA empresarial. Além do impacto técnico, há consequências econômicas. O custo por teraflop útil em sistemas desatualizados é significativamente superior devido à ineficiência energética e ao subaproveitamento de recursos. A ausência de recursos de segurança como TPM 2.0 e Silicon Root of Trust também amplia a vulnerabilidade do ambiente a ataques de firmware e violações de integridade. Fundamentos da Solução: arquitetura AMD Instinct e EPYC integrados O coração do sistema reside na sinergia entre as GPUs AMD Instinct MI250 e os processadores AMD EPYC 7003. A arquitetura MI250 baseia-se na interconexão Infinity Fabric™, que estabelece canais de comunicação de alta largura de banda entre GPUs, eliminando gargalos e permitindo escalabilidade quase linear em aplicações paralelas. Essa comunicação GPU-GPU via Infinity Fabric é complementada pelo PCIe 4.0 x16 para a interface CPU-GPU, garantindo baixa latência e suporte a transferências simultâneas de alto throughput. Com até 8TB de memória DDR4 ECC 3200MHz distribuída em 32 DIMMs, o sistema assegura estabilidade para workloads intensivos em dados e permite otimizações complexas em modelos de IA e simulações científicas. O design em 4U da Supermicro alia densidade e robustez, suportando até quatro GPUs OAM MI250 em um chassi compacto, com fonte redundante de 3000W (Titanium Level) e ventilação de alta capacidade. O resultado é um equilíbrio exemplar entre eficiência térmica, potência computacional e confiabilidade para operações críticas. Implementação Estratégica: alinhando desempenho e eficiência operacional Do ponto de vista de integração, o servidor A+ AS-4124GQ-TNMI foi concebido para interoperar de forma transparente com ecossistemas baseados em AMD e soluções de IA de múltiplos fornecedores. Seu suporte nativo ao Supermicro Server Manager (SSM), Power Manager (SPM) e SuperDoctor 5 facilita o monitoramento remoto, a atualização automatizada de firmware e o balanceamento térmico em clusters de grande escala. O uso de PCIe 4.0 x16 via PLX amplia as possibilidades de expansão, permitindo integração com NICs de alta velocidade ou aceleradores adicionais para aplicações de rede definida por software (SDN) e aprendizado distribuído. O gerenciamento via IPMI 2.0 e KVM-over-LAN proporciona visibilidade completa do hardware, reduzindo o tempo de resposta em manutenções preventivas e emergenciais. Na camada de segurança, o sistema implementa um conjunto robusto de medidas baseadas em hardware: TPM 2.0 garante armazenamento seguro de chaves criptográficas, enquanto o Silicon Root of Trust assegura a integridade do firmware desde a inicialização. Recursos como Secure Boot, Secure Firmware Updates e System Lockdown tornam o servidor adequado para data centers que exigem conformidade com o padrão NIST 800-193. Melhores Práticas Avançadas: otimização de desempenho e confiabilidade Para maximizar o desempenho do sistema, é essencial adotar práticas de balanceamento térmico e tuning de interconexão. O conjunto de cinco ventiladores hot-swap de 11,5K RPM garante operação estável sob cargas intensivas, mas a calibração do fluxo de ar deve considerar o perfil térmico das GPUs MI250 e a densidade de memória instalada. A implementação de topologias otimizadas de comunicação GPU-GPU, utilizando o Infinity Fabric, reduz significativamente o overhead em aplicações paralelas. Em workloads de IA distribuída, o uso de uma relação 1:1 entre GPU e NIC, suportada nativamente pelo design da Supermicro, elimina gargalos de rede e potencializa a performance de inferência em tempo real. Adicionalmente, a combinação de fontes redundantes 2+2 Titanium Level assegura continuidade operacional mesmo em caso de falha parcial de energia, e o uso de DIMMs ECC reduz erros de memória que podem comprometer simulações de longa duração. Essa arquitetura torna o servidor ideal para ambientes que demandam uptime superior a 99,99%. Medição de Sucesso: métricas e indicadores de desempenho A avaliação de sucesso em ambientes HPC e IA deve ser multidimensional. Para esse sistema, os principais indicadores incluem: Throughput computacional efetivo: medido em TFLOPs por watt, refletindo o equilíbrio entre potência e eficiência energética. Latência GPU-GPU: monitorada

Supermicro 4U GPU Server com HGX A100: Desempenho Máximo para HPC e Treinamento de IA Introdução No cenário atual de transformação digital, as organizações enfrentam demandas crescentes por processamento de dados em larga escala, inteligência artificial (IA) e simulações de alto desempenho. Para atender a esses requisitos, data centers corporativos necessitam de servidores GPU capazes de entregar desempenho extremo, confiabilidade e flexibilidade operacional. O Supermicro 4U GPU Server com NVIDIA HGX A100 4-GPU surge como uma solução estratégica para organizações que buscam maximizar a performance de suas cargas de trabalho de HPC e treinamento de IA. Os desafios enfrentados pelas empresas incluem a necessidade de acelerar cálculos científicos complexos, reduzir o tempo de treinamento de modelos de deep learning e garantir disponibilidade contínua em ambientes críticos. Qualquer falha na infraestrutura ou limitação de performance pode gerar atrasos significativos em projetos estratégicos e aumentar os custos operacionais. Além disso, a implementação inadequada de servidores GPU em larga escala pode resultar em desperdício de energia, problemas térmicos e subutilização de recursos. Este artigo apresenta uma análise aprofundada do Supermicro 4U HGX A100, explorando suas características técnicas, benefícios estratégicos, melhores práticas de implementação e métricas de sucesso para ambientes corporativos. Desenvolvimento Problema Estratégico Organizações modernas lidam com volumes de dados cada vez maiores e exigem sistemas que suportem cargas de trabalho intensivas em GPU, como simulações científicas, modelagem financeira, treinamento de redes neurais profundas e análise preditiva. Sistemas tradicionais de CPU não oferecem escalabilidade ou throughput necessário para esses cenários, resultando em gargalos de processamento e atrasos na entrega de insights críticos. Além disso, a complexidade da interconexão entre GPUs e CPUs impacta diretamente a eficiência de processamento paralelo. Sem uma arquitetura otimizada, as GPUs podem operar abaixo de sua capacidade, reduzindo o retorno sobre o investimento em hardware de alto desempenho. Consequências da Inação Ignorar a necessidade de servidores GPU especializados implica em custos operacionais mais altos, maior tempo de processamento e risco de perda competitiva. Projetos de IA e HPC podem sofrer atrasos de semanas ou meses, impactando diretamente na capacidade da organização de inovar, lançar produtos ou responder rapidamente a mudanças de mercado. Além disso, a falha em gerenciar eficiência energética e resfriamento pode resultar em sobrecarga térmica, falhas de hardware e interrupções não planejadas. Para ambientes corporativos que dependem de disponibilidade contínua, esses riscos representam perda financeira direta e danos à reputação. Fundamentos da Solução O Supermicro 4U GPU Server integra quatro GPUs NVIDIA HGX A100, conectadas via NVLink para comunicação de alta velocidade entre as unidades. Esta arquitetura permite throughput de dados excepcional e baixa latência na execução de cargas de trabalho distribuídas, fundamental para treinamento de modelos de IA e simulações complexas. O servidor é equipado com processadores Dual Socket P+ 3ª geração Intel Xeon Scalable, com suporte a até 40 núcleos e 80 threads por CPU, garantindo capacidade de processamento paralelo robusta e otimização do balanceamento CPU-GPU. Com 32 slots DIMM e suporte a até 8TB de memória ECC DDR4, o sistema oferece resiliência, alta capacidade de armazenamento temporário e desempenho consistente em cargas críticas. O armazenamento é altamente flexível, incluindo até 10 baias hot-swap de 2,5″ NVMe/SATA e um slot M.2 para boot. Essa configuração permite alta densidade de I/O, essencial para ambientes que demandam acesso rápido a grandes volumes de dados. Complementando, a gestão térmica avançada com cinco fans heavy-duty e quatro fontes redundantes Titanium Level de 3000W garante confiabilidade operacional e eficiência energética. Implementação Estratégica A implementação do Supermicro HGX A100 requer planejamento detalhado de data center, incluindo infraestrutura de rede, refrigeração e fornecimento de energia. A configuração de PCIe 4.0 x16 dual-root e NVLink otimiza o desempenho entre CPU e GPU, mas exige balanceamento cuidadoso de recursos para evitar saturação de barramentos ou gargalos de memória. Para maximizar a performance, recomenda-se alinhar workloads de HPC e IA com os recursos disponíveis, utilizando técnicas de paralelização de tarefas e otimização de memória. O gerenciamento do sistema pode ser centralizado com ferramentas como SuperCloud Composer e Supermicro Server Manager (SSM), que oferecem monitoramento de hardware, diagnóstico proativo e atualização de firmware segura. Além disso, a segurança é integrada com Trusted Platform Module (TPM) 2.0, Root of Trust (RoT) compatível com NIST 800-193, Secure Boot e firmware assinado criptograficamente, garantindo proteção contra ataques e integridade do sistema em ambientes corporativos sensíveis. Melhores Práticas Avançadas Para otimizar o retorno do investimento, é recomendável configurar clusters de servidores GPU com balanceamento de carga automatizado, utilizando ferramentas de orquestração compatíveis com workloads de deep learning e HPC. A integração de storage NVMe de alta velocidade permite reduzir latência e acelerar treinamento de modelos, enquanto a manutenção preventiva baseada em monitoramento contínuo de temperatura e desempenho garante disponibilidade máxima. O alinhamento entre capacidade de memória, throughput de rede e interconexão NVLink é crucial para workloads intensivos, permitindo escalabilidade horizontal sem comprometer performance. O ajuste fino de parâmetros de BIOS, ventilação e priorização de tarefas GPU é uma prática avançada que eleva significativamente a eficiência operacional. Medição de Sucesso Indicadores críticos para avaliar a eficácia da implementação incluem throughput de GPU, tempo de treinamento de modelos, utilização média de CPU e GPU, latência de I/O e eficiência energética do rack. Métricas de confiabilidade como MTBF (Mean Time Between Failures), tempo de recuperação e integridade do sistema também são essenciais para data centers corporativos. Além disso, a medição deve incluir análise de custo-benefício em relação a alternativas de CPU-only, considerando economia de tempo, redução de consumo energético e aumento de produtividade em projetos de IA e HPC. Conclusão O Supermicro 4U GPU Server com NVIDIA HGX A100 4-GPU oferece uma solução completa para ambientes de HPC e IA, combinando processamento de alto desempenho, interconexão NVLink de baixa latência, memória robusta e gestão avançada de energia e segurança. Implementar esta tecnologia com planejamento estratégico garante redução de riscos, maximização de desempenho e escalabilidade para projetos corporativos críticos. A adoção de servidores GPU especializados representa um diferencial competitivo, permitindo que organizações processem dados em larga escala, treinem modelos complexos e respondam rapidamente