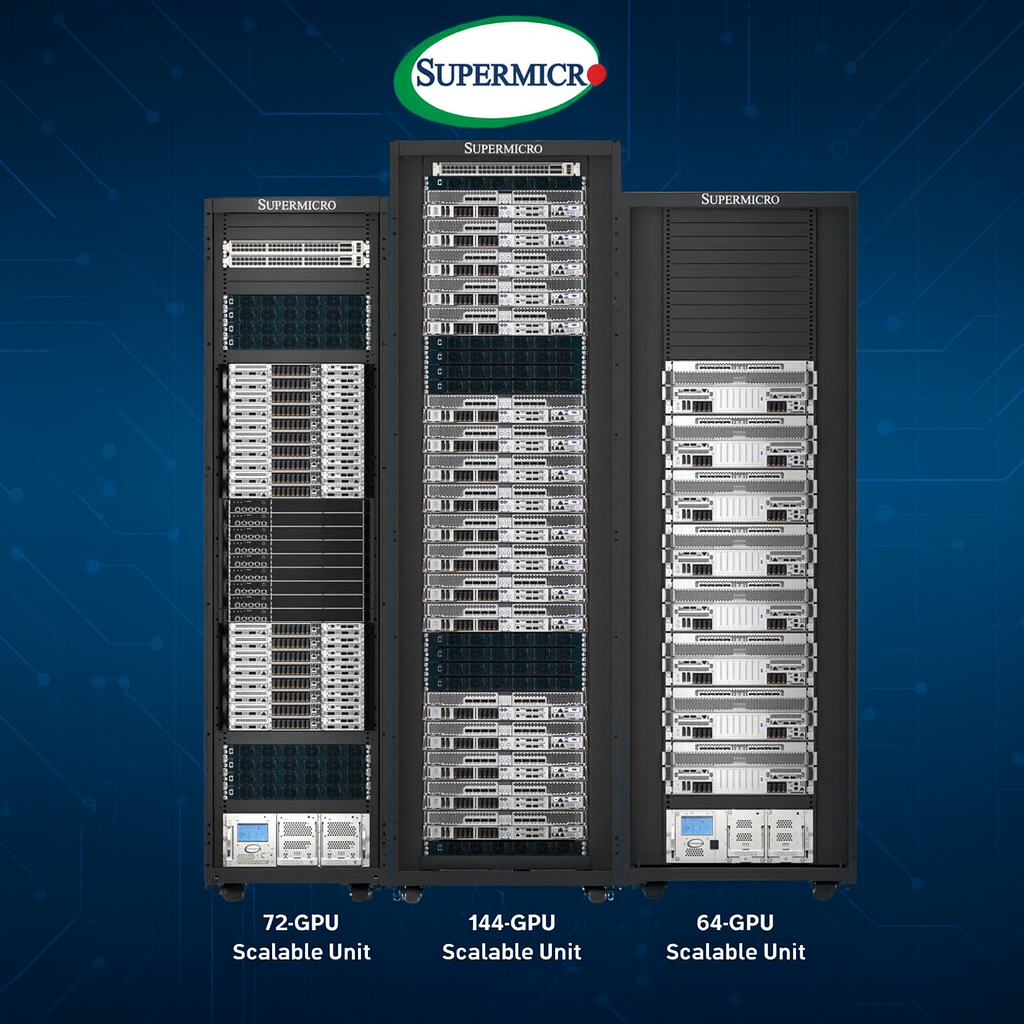

Supermicro HGX B300: Arquitetura Líquida e Escalável para AI Factories de Alta Densidade Introdução A aceleração da demanda global por infraestrutura de IA tem pressionado data centers a atingirem níveis inéditos de densidade computacional, eficiência energética e escalabilidade operacional. Nesse contexto, a expansão do portfólio NVIDIA Blackwell pela Supermicro — com os novos sistemas HGX B300 resfriados a líquido nas versões 4U e 2-OU (OCP) — representa uma inflexão estratégica para organizações que precisam treinar modelos maiores, operar agentes de IA mais complexos e construir AI factories realmente sustentáveis. O desafio central que estas organizações enfrentam não é apenas computacional: trata-se de equilibrar energia, resfriamento, densidade, capacidade de upgrade e interoperabilidade com redes avançadas. O custo da inação, especialmente em ambientes hyperscale, se traduz em desperdício energético, limitações de capacidade de expansão, aumento de latência interna e restrições para rodar modelos de última geração. Este artigo aprofunda como as novas plataformas HGX B300 da Supermicro atacam esses desafios através de engenharia térmica avançada, integração de rede de alta largura de banda, design modular e capacidade de escalar até níveis massivos — como 144 GPUs por rack e SuperClusters com 1.152 GPUs. Nos próximos tópicos, analisaremos a fundo os dilemas estratégicos para operações em escala, como o HGX B300 responde a eles e por que esses sistemas se tornam peças centrais no futuro das AI factories. O Problema Estratégico: Como Escalar IA Sem Aumentar Exponencialmente o Consumo Energético? Pressão por densidade computacional extrema Organizações que trabalham com IA de larga escala enfrentam uma pressão crescente para aumentar a densidade de GPUs por metro quadrado. Isso ocorre porque modelos maiores — especialmente em aplicações multimodais e agentes avançados — dependem de clusters extremamente grandes para treinamento e inferência. No entanto, atingir essa densidade aumenta dificuldades relacionadas à dissipação térmica, gerenciamento de energia e manutenção. Limitantes arquiteturais em racks tradicionais Sistemas de rack convencionais possuem limites intrínsecos de eficiência térmica, o que força data centers a investirem em infraestrutura de resfriamento cada vez mais cara. Isso impacta diretamente o OPEX. Para AI factories, onde centenas de GPUs trabalham continuamente em cargas intensivas, o resfriamento por ar se torna insuficiente e energeticamente inviável. Dependência de interconexões rápidas Modelos grandes não escalam apenas em número de GPUs — dependem de redes capazes de manter baixa latência e alta largura de banda em clusters distribuídos. Sem uma rede acelerada, mesmo centenas de GPUs podem operar abaixo de seu potencial. Consequências da Inação: Quando o Resfriamento e a Rede se Tornam Gargalos Aumento de custos de energia e infraestrutura Data centers que tentam lidar com densidade crescente usando técnicas tradicionais sofrem com custos energéticos explosivos, além da necessidade de chillers e compressores adicionais. Isso resulta em tempo de retorno de investimento mais longo e limitações futuras para expansão. Redução de desempenho efetivo Sem interconexão capaz de 800Gb/s, clusters de IA sofrem com subutilização, aumento de latência, e redução drástica na eficiência durante treinamento de modelos. Isso afeta diretamente prazos de projeto e competitividade. Dificuldade de escalar clusters e manter disponibilidade Soluções que dependem de racks convencionais e módulos sem modularidade de manutenção criam barreiras para upgrades, substituições, reparos e expansão em escala hyperscale. Fundamentos da Solução Supermicro HGX B300 Densidade máxima com arquitetura otimizada para IA A Supermicro introduz dois sistemas complementares: 2-OU OCP HGX B300 — para racks 21” ORV3 com até 144 GPUs por rack. 4U Front I/O HGX B300 — para racks padrão 19″ com até 64 GPUs por rack. Ambos foram projetados para incluir 8 GPUs NVIDIA Blackwell Ultra em cada nó, permitindo densidade competitiva tanto em ambientes OCP quanto em infraestruturas tradicionais. Resfriamento líquido avançado com DLC e DLC-2 O uso de resfriamento direto a líquido é o diferencial que resolve a barreira térmica dos sistemas de IA modernos. O modelo 4U utiliza tecnologia DLC-2 capaz de capturar até 98% do calor gerado pelo sistema, enquanto o sistema OCP utiliza um design com blind-mate manifold para encaixe automático no rack. Essas tecnologias eliminam dependência de água gelada, permitem operação com água morna a 45°C e reduzem o consumo energético do data center em até 40% segundo parâmetros da própria empresa. Interconexão de alto desempenho com 800Gb/s A eficiência da IA moderna depende da rede. Os HGX B300 usam NVIDIA ConnectX-8 SuperNICs integradas que dobram a largura de banda da malha para 800Gb/s. Essa capacidade é projetada para clusters com NVIDIA Quantum-X800 InfiniBand ou Spectrum-4 Ethernet — redes de última geração essenciais para modelos de larga escala. Implementação Estratégica em AI Factories Integrando sistemas 2-OU OCP HGX B300 O modelo OCP é desenhado para operações hyperscale e cloud providers que precisam maximizar densidade. Sua arquitetura modular permite que o rack ORV3 suporte até 18 nós, cada um com oito GPUs Blackwell Ultra. A combinação desses nós alcança 144 GPUs por rack, mantendo ao mesmo tempo modularidade e manutenção simplificada. Implementação do 4U HGX B300 em racks tradicionais Para empresas que utilizam racks de 19 polegadas, o sistema 4U oferece densidade competitiva com até 64 GPUs por rack, mantendo compatibilidade e facilidade de manutenção. A versão 4U prioriza serviceability através do acesso frontal e integração direta com a infraestrutura existente. Escalando para SuperClusters com 1.152 GPUs Um SuperCluster completo é composto por: 8 racks HGX B300 (computação) 3 racks de rede NVIDIA Quantum-X800 2 racks Supermicro com CDUs in-row de 1,8MW A soma dessas unidades resulta em um conjunto escalável de 1.152 GPUs, projetado para treinar modelos de última geração e sustentar operações de IA em escala industrial. Melhores Práticas Avançadas Padronização em formas de rack (19″ ou 21″) Organizações devem avaliar se seu ambiente de data center se beneficia mais do formato OCP 21” — ideal para densidade máxima — ou do padrão EIA 19”, normalmente mais compatível com ambientes corporativos. A seleção correta evita retrabalho estrutural e reduz CAPEX. Uso do ecossistema NVIDIA certificado Os sistemas HGX B300 fazem parte do ecossistema NVIDIA-Certified Systems, o que significa compatibilidade direta com: NVIDIA AI Enterprise NVIDIA Run:ai NVIDIA networking avançado Aproveitar esta certificação

NAS NVMe: Arquitetura, Desempenho e Estratégia para Ambientes Corporativos Modernos O avanço contínuo na criação e circulação de dados trouxe uma consequência inevitável para qualquer organização moderna: a necessidade de processar informações em tempo quase real. Esse cenário pressiona infraestruturas antigas e expõe o abismo entre a demanda digital atual e as limitações de arquiteturas tradicionais, especialmente aquelas baseadas em discos mecânicos e protocolos legados como SATA e AHCI. Nesse contexto, o NAS NVMe surge como uma resposta arquitetural projetada para superar gargalos históricos, eliminar latências que comprometem operações críticas e acelerar workloads que dependem de acesso imediato aos dados. A adoção dessa tecnologia redefine não apenas a velocidade de leitura e escrita, mas a própria forma como ambientes corporativos estruturam sua estratégia de armazenamento, continuidade operacional e competitividade. Este artigo aprofunda a fundo a arquitetura NVMe no contexto dos storages NAS corporativos, explorando sua relevância estratégica, suas bases técnicas, suas implicações no datacenter, seus riscos quando implementada sem planejamento e, principalmente, seus benefícios tangíveis para virtualização, bancos de dados, pipelines de IA, renderização 3D e fluxos de trabalho de alta simultaneidade. O Desafio Estratégico do Armazenamento Corporativo Moderno Com o aumento acelerado do volume mundial de dados, as empresas enfrentam um ponto de inflexão: ou modernizam suas infraestruturas de armazenamento para acompanhar as demandas das novas aplicações, ou inevitavelmente enfrentam lentidão sistêmica, gargalos invisíveis e perda de produtividade. A latência, que antes era tolerável em ambientes simples, torna-se hoje um vetor determinante de falhas operacionais. Ela impacta diretamente sistemas de ERP, plataformas de análise, rotinas de backup e workloads sensíveis como bancos de dados, VMs e edição de vídeo de alta resolução. Quando uma arquitetura tradicional baseada em SATA tenta operar sob essas condições, o resultado é sempre o mesmo: filas de requisição se acumulam, o tempo de resposta aumenta e o desempenho geral do negócio cai — mesmo quando o servidor parece ter “recursos sobrando”. Para empresas que dependem de agilidade, resposta imediata e estabilidade, esse cenário se torna inaceitável. É nesse ponto que a adoção de NAS NVMe deixa de ser um diferencial tecnológico e passa a ser um imperativo estratégico. Consequências da Inação e Custos Ocultos A manutenção de infraestruturas baseadas em tecnologias antigas produz efeitos colaterais que raramente são percebidos de imediato. O impacto econômico aparece gradualmente, por meio de atrasos cumulativos e aumento do tempo necessário para concluir tarefas críticas. No nível operacional, bancos de dados tornam-se menos responsivos, VMs demoram mais para inicializar e relatórios importantes passam a ser gerados com atraso. Um gargalo de armazenamento, mesmo pequeno, é capaz de degradar toda a cadeia produtiva da empresa. Em ambientes de alta concorrência — como e-commerce, setores financeiros e centros de mídia — segundos de latência podem representar perda de oportunidades, queda na satisfação do usuário e custos diretos associados à lentidão. Além disso, quanto mais processamento é exigido de um sistema baseado em disco, maior o desgaste físico, o consumo energético e a probabilidade de falhas. A ineficiência cria um ciclo vicioso que consome recursos e reduz a confiabilidade operacional. Fundamentos Arquitetônicos do NAS NVMe Eliminando os Limites do SATA O primeiro ponto fundamental para entender o poder do NAS NVMe é reconhecer o limite imposto historicamente pelo SATA. Essa interface, criada para gerir discos mecânicos, não foi projetada para lidar com o desempenho explosivo dos chips de memória flash modernos. Ao operar com uma única fila de comandos, e com profundidade reduzida, o SATA força os sistemas a trabalharem de forma sequencial e com grande dependência da capacidade de resposta do controlador. Isso se torna um gargalo crítico quando várias requisições simultâneas são feitas — algo comum em qualquer empresa. O Salto Arquitetural do NVMe O NVMe foi criado especificamente para memórias flash e rompe completamente com as restrições históricas. Ele utiliza o barramento PCIe e suporta até 64 mil filas de comandos simultâneas, cada uma igualmente capaz de operar com dezenas de milhares de requisições. Esse paralelismo massivo permite que aplicações corporativas lidem com múltiplos acessos concomitantes sem esperar ociosamente por uma resposta. Ela desbloqueia não apenas a velocidade, mas o potencial total dos processadores modernos. Diferentemente dos sistemas que emulam discos mecânicos, o NVMe comunica-se de forma direta com a CPU, reduzindo drasticamente a latência e eliminando intermediários que antes limitavam a performance. All-Flash vs. Cache NVMe Dentro dos projetos de NAS corporativos, o NVMe pode ser utilizado tanto como camada primária (all-flash) quanto como camada de aceleração (cache). No modelo all-flash, toda a capacidade é baseada em SSDs NVMe, oferecendo máxima velocidade para todas as operações e garantindo baixa latência constante. No modelo híbrido, os SSDs armazenam apenas os dados mais acessados, acelerando volumes mecânicos e reduzindo drasticamente o tempo de resposta para operações críticas. Latência e IOPS: Os Verdadeiros Indicadores de Performance É comum que administradores avaliem o desempenho de um storage apenas pela taxa de transferência. Mas em ambientes corporativos, especialmente bancos de dados e virtualização, o que realmente determina performance são IOPS e latência. NAS NVMe all-flash entregam milhares de operações por segundo, com latências de apenas alguns microssegundos. Esse comportamento é fundamental para workloads que dependem de resposta imediata. Com menor tempo entre cada solicitação e resposta, sistemas ERP tornam-se mais ágeis, relatórios são gerados instantaneamente e máquinas virtuais são colocadas online em segundos. A consistência também cresce: quedas de desempenho inesperadas desaparecem e o ambiente passa a operar de forma mais previsível — condição essencial para continuidade de negócios. Gargalos de Rede: O Obstáculo Invisível Um dos erros mais comuns ao adotar NVMe é esquecer que a rede pode se tornar o novo gargalo. Conectar um NAS NVMe a uma rede Gigabit Ethernet reduz automaticamente o potencial do hardware. Para que a arquitetura NVMe entregue seu valor total, a rede deve operar em 10GbE, 25GbE ou 100GbE. Esse é um princípio arquitetônico essencial. Além da velocidade, a qualidade do cabeamento e o suporte a agregação de links (Port Trunking) tornam-se fundamentais para garantir resiliência e distribuição eficiente do tráfego. Casos de Uso

NAS Rackmount ou Desktop: Como escolher o formato ideal para sua infraestrutura corporativa A decisão entre adotar um NAS Rackmount ou Desktop representa muito mais do que escolher um formato físico. Ela envolve impactos diretos na eficiência operacional, nos custos recorrentes, na segurança do ambiente e na capacidade de crescimento sustentável da infraestrutura corporativa. Em um cenário em que empresas lidam com volumes crescentes de dados e ciclos de atualizações cada vez mais exigentes, compreender profundamente a natureza de cada arquitetura torna-se fundamental para evitar erros estratégicos, desperdícios financeiros e interrupções operacionais. No contexto atual, organizações de diferentes portes buscam maior previsibilidade em suas operações de TI. Nesse ambiente, a escolha equivocada entre um chassi de mesa ou um equipamento montado em rack pode gerar desde ruído excessivo em áreas de trabalho até problemas de refrigeração que comprometem a vida útil do hardware. Além disso, questões como manutenção, segurança física e custos indiretos passam a ter peso decisivo no ciclo de vida da solução. Este artigo oferece uma análise aprofundada e orientada a decisões corporativas, conectando aspectos técnicos a consequências reais no negócio. Exploramos os fundamentos de cada modelo, seus impactos em espaço, ruído, organização, segurança e escalabilidade, sempre alinhando tecnologia e estratégia empresarial. O objetivo é fornecer clareza para que gestores, arquitetos de TI e profissionais técnicos determinem qual formato proporciona o melhor equilíbrio entre eficiência, custo e confiabilidade dentro da realidade da sua empresa. O que está em jogo na escolha entre NAS Rackmount ou Desktop À primeira vista, a diferença entre os dois formatos pode parecer meramente estética — uma unidade horizontal instalada em rack versus um gabinete vertical posicionado sobre a mesa. Mas, ao analisarmos o funcionamento interno, o comportamento térmico, a organização dos cabos, o acesso aos componentes e a segurança física, torna-se evidente que estamos diante de decisões estruturais que afetam diretamente a operação. O modelo desktop é intuitivo, silencioso e facilmente integrado ao ambiente comum. Já a versão rackmount assume um papel central em ambientes profissionalizados, predominando em data centers e salas técnicas dedicadas. Embora ambos executem o mesmo sistema operacional e ofereçam funcionalidades idênticas, a implantação em si exige abordagens completamente diferentes em termos de espaço, climatização, redundância e manutenção. Nessa análise, aprofundaremos os elementos críticos que determinam qual formato entrega o máximo desempenho e confiabilidade conforme o ambiente e as prioridades corporativas. Problema Estratégico: O ambiente como definidor de eficiência O primeiro grande desafio na escolha entre NAS Rackmount ou Desktop está no alinhamento entre o formato físico do equipamento e as condições reais do local onde ele será instalado. Pequenas empresas, escritórios compartilhados e ambientes domésticos quase nunca contam com salas de TI climatizadas, e isso muda completamente a lógica da decisão. A proximidade dos usuários com o equipamento transforma o ruído, a ventilação e o espaço disponível em variáveis críticas. Do outro lado, empresas com infraestrutura centralizada operam em salas técnicas onde a densidade de equipamentos, a organização do cabeamento e a redundância elétrica tornam o padrão rackmount quase obrigatório. Nessas organizações, adotar um NAS de mesa poderia comprometer a gestão térmica, dificultar a padronização e gerar riscos operacionais. A falta de alinhamento entre ambiente e formato gera impactos diretos no conforto, na produtividade dos funcionários, nos custos de refrigeração e no risco de falhas futuras. Por isso, o ambiente físico não é um detalhe — é o fator que define a viabilidade técnica e econômica da solução. Consequências da Inação: Custos ocultos e riscos estruturais Ignorar as diferenças entre NAS rackmount e desktop pode levar a um acúmulo de problemas ao longo do ciclo de vida do equipamento. Num escritório pequeno, por exemplo, instalar um servidor rackmount dentro da área comum cria um ambiente ruidoso e desconfortável, podendo até inviabilizar o uso contínuo do espaço. O desconforto auditivo está longe de ser um detalhe operacional: ele afeta produtividade, cria reclamações internas e obriga mudanças improvisadas de layout. Em ambientes corporativos mais complexos, a ausência de rack adequado implica má organização dos cabos, aquecimento excessivo e maior dificuldade na manutenção de componentes. Todos esses fatores levam ao aumento do downtime e, consequentemente, ao risco de indisponibilidade dos dados — fator crítico para empresas que dependem de seus sistemas 24 horas por dia. Além disso, negligenciar aspectos de segurança física pode transformar um equipamento desprotegido em alvo fácil de furtos, especialmente em locais de circulação intensa. A inação nesse ponto pode gerar perdas de hardware e, pior, o comprometimento dos dados estrategicamente armazenados. Fundamentos da Solução: Como funciona cada tipo de chassi Arquitetura física e lógica de uso O NAS desktop segue uma lógica semelhante a um computador pessoal vertical. Seu uso é orientado para ambientes comuns, com fácil integração ao mobiliário existente e sem necessidade de infraestrutura adicional. Internamente, esses modelos utilizam ventoinhas maiores, que giram mais devagar e oferecem operação silenciosa — característica essencial em locais onde o equipamento divide espaço com pessoas. Já o NAS rackmount adota o padrão industrial de 19 polegadas. Seu corpo horizontal e achatado foi projetado especificamente para montagem em trilhos dentro de armários fechados, onde compartilha o espaço com switches, nobreaks, servidores e outros sistemas. Seu foco é a densidade, não a operação discreta. Por isso, utiliza ventoinhas menores, que exigem rotação mais alta para garantir a circulação do ar quente. Engenharia térmica e comportamento acústico A diferença estrutural entre os dois formatos se evidencia no comportamento térmico. O rackmount, por ser compacto na altura, depende de ventiladores de alta rotação para manter o fluxo de ar constante. Isso produz níveis elevados de ruído, tornando impossível seu uso próximo a postos de trabalho. Assim, esse tipo de unidade deve estar isolado acusticamente — seja em racks fechados, seja em salas específicas. Os modelos desktop, com espaço interno mais generoso, conseguem utilizar ventoinhas de maior diâmetro. Com isso, deslocam mais ar com menos esforço, gerando menos calor e muito menos ruído. Esse design é ideal para ambientes integrados onde silêncio é requisito de operação. Conectividade, cabeamento e organização estrutural A organização dos

NAS corporativo: como escolher a infraestrutura ideal para proteger e escalar dados empresariais O avanço acelerado dos dados corporativos transformou o armazenamento em um pilar estratégico das operações. Em empresas de todos os portes, o volume crescente de informações deixou de ser apenas um desafio técnico para se tornar uma questão de continuidade de negócios. Nesse cenário, o NAS corporativo emerge como o elemento central para garantir disponibilidade, integridade e eficiência operacional. O problema, porém, nasce do equívoco comum: muitas organizações ainda tratam o armazenamento como um componente secundário, improvisando soluções com HDs externos ou computadores reaproveitados. Essa prática cria riscos profundos, desde corrupção lógica até falhas físicas, culminando em perdas que paralisam equipes, atrasam projetos e comprometem a reputação empresarial. A inação não é apenas arriscada — ela é financeiramente insustentável. Este artigo aprofunda, de forma estratégica e técnica, todos os componentes essenciais para escolher o melhor NAS corporativo, analisando capacidade, desempenho, segurança, escalabilidade e alinhamento às necessidades reais do ambiente de TI. A partir das informações do conteúdo original, vamos decodificar como cada decisão impacta diretamente a produtividade e a proteção da empresa. O que é um storage NAS corporativo Um NAS corporativo é um servidor dedicado ao armazenamento conectado à rede local da empresa. Ele centraliza arquivos e controla o acesso de múltiplos usuários, oferecendo segurança, organização e eficiência no fluxo de dados. Diferentemente de soluções improvisadas, o NAS possui sistema operacional próprio, suporta múltiplos discos simultâneos e implementa protocolos universais que garantem interoperabilidade com Windows, Linux e macOS. A lógica operacional desse sistema não se limita a armazenar arquivos: ele cria um ambiente inteligente de colaboração. A equipe acessa documentos compartilhados, edita arquivos em tempo real e realiza backups automáticos. Tudo isso sem depender de um computador central ligado continuamente. Sua eficiência energética e seu formato compacto também reduzem custos operacionais e simplificam a implementação. Ao funcionar como um “cofre digital inteligente”, o NAS não apenas guarda dados — ele preserva a continuidade operacional da empresa. Ele também estabelece um padrão de governança, garantindo que cada usuário acesse apenas o que é permitido, com registros completos para auditorias e conformidade legal. Capacidade e crescimento futuro: planejando o armazenamento estrategicamente Problema estratégico: subdimensionamento estrutural A avaliação equivocada de capacidade é um dos erros mais recorrentes na implementação de um NAS corporativo. A tentação de adquirir apenas o espaço necessário para o momento ignora a natureza expansiva dos dados modernos. Projetos multimídia, bancos de dados transacionais, sistemas de backup e colaboração intensiva crescem de forma acelerada e contínua. Quando a capacidade se esgota, a empresa se vê forçada a adquirir upgrades emergenciais, geralmente mais caros, e a migrar dados às pressas — um processo que pode interromper atividades críticas. O problema não é apenas técnico: é orçamentário e estratégico. Consequências da inação: paralisação e custos imprevistos A falta de espaço livre impede a execução de backups automáticos, inviabiliza projetos que dependem de arquivos grandes e gera risco de corrupção por falta de blocos disponíveis. O impacto pode ser imediato: desde atrasos em entregas até interrupção total de setores. Além disso, a empresa fica vulnerável a gastos não planejados, como aquisições emergenciais de hardware ou migrações em janelas críticas. Fundamentos da solução: escalabilidade como premissa Para evitar esses gargalos, o planejamento de capacidade deve considerar não apenas o volume atual, mas também o crescimento anual. A escolha de chassis com baias livres ou compatíveis com expansão externa é fundamental. Os módulos de expansão permitem ampliar o volume lógico sem alterar o NAS principal nem interromper as operações. Essa abordagem preserva o investimento inicial, garantindo longevidade ao projeto e alinhamento às necessidades futuras. Implementação estratégica A estratégia ideal envolve três etapas: medir o volume existente, estimar o crescimento anual e selecionar um NAS com escalabilidade nativa. Essa avaliação evita interrupções operacionais e assegura que o ambiente acompanhe o ritmo de produção e backup. Melhores práticas avançadas O uso de expansões externas deve ser considerado desde o início do projeto, especialmente para ambientes que lidam com vídeo, devops ou grande volume de snapshots. Essa previsibilidade melhora a governança e reduz riscos futuros. Indicadores de sucesso Entre as métricas essenciais estão: percentual médio de ocupação, taxa de consumo mensal de dados e número de operações de ampliação realizadas sem downtime. Processamento e memória: performance como vantagem competitiva Problema estratégico: saturação de recursos Os NAS corporativos modernos acumulam várias funções além do armazenamento. São usados para virtualização, vigilância, indexação de conteúdo, backups contínuos e até processamento de mídia. Cada uma dessas cargas exige processamento e memória significativos. Quando o hardware é subdimensionado, o resultado é imediato: lentidão generalizada, travamentos, tempos de resposta elevados e experiência negativa para os usuários. Consequências da inação: queda de produtividade A saturação dos recursos do NAS afeta todos os departamentos. Atrasos no acesso a arquivos, falhas em máquinas virtuais ou backups incompletos impactam diretamente entregas e prazos internos. Fundamentos da solução: processadores multicore e RAM adequada CPUs multicore aceleram transferências pesadas, processamento paralelo e indexação de dados. A RAM, por sua vez, gerencia múltiplas conexões simultâneas. Em ambientes complexos, somente processadores Intel ou AMD Ryzen conseguem manter a performance esperada sob carga. Além disso, serviços como virtualização ou vigilância precisam de margens adicionais de processamento e memória para evitar competição entre recursos. Implementação estratégica A abordagem ideal envolve mapear cada serviço que vai rodar no NAS e então dimensionar o hardware considerando picos de uso e cargas simultâneas. Isso evita gargalos e garante fluidez. Melhores práticas avançadas Ambientes heterogêneos — com bancos de dados, vídeo e VM rodando simultaneamente — devem considerar upgrades de memória logo na implantação. Medição de sucesso Indicadores como latência média, uso de CPU/RAM e tempo de indexação de arquivos mostram a adequação do hardware. Conexões de rede multi-gigabit: a infraestrutura como acelerador Problema estratégico: gargalos invisíveis Mesmo o NAS mais potente se torna lento se a rede não acompanhar a velocidade necessária. Portas padrão 1GbE se tornam insuficientes em ambientes com backups intensos, edição de vídeo ou compartilhamento simultâneo por vários usuários.

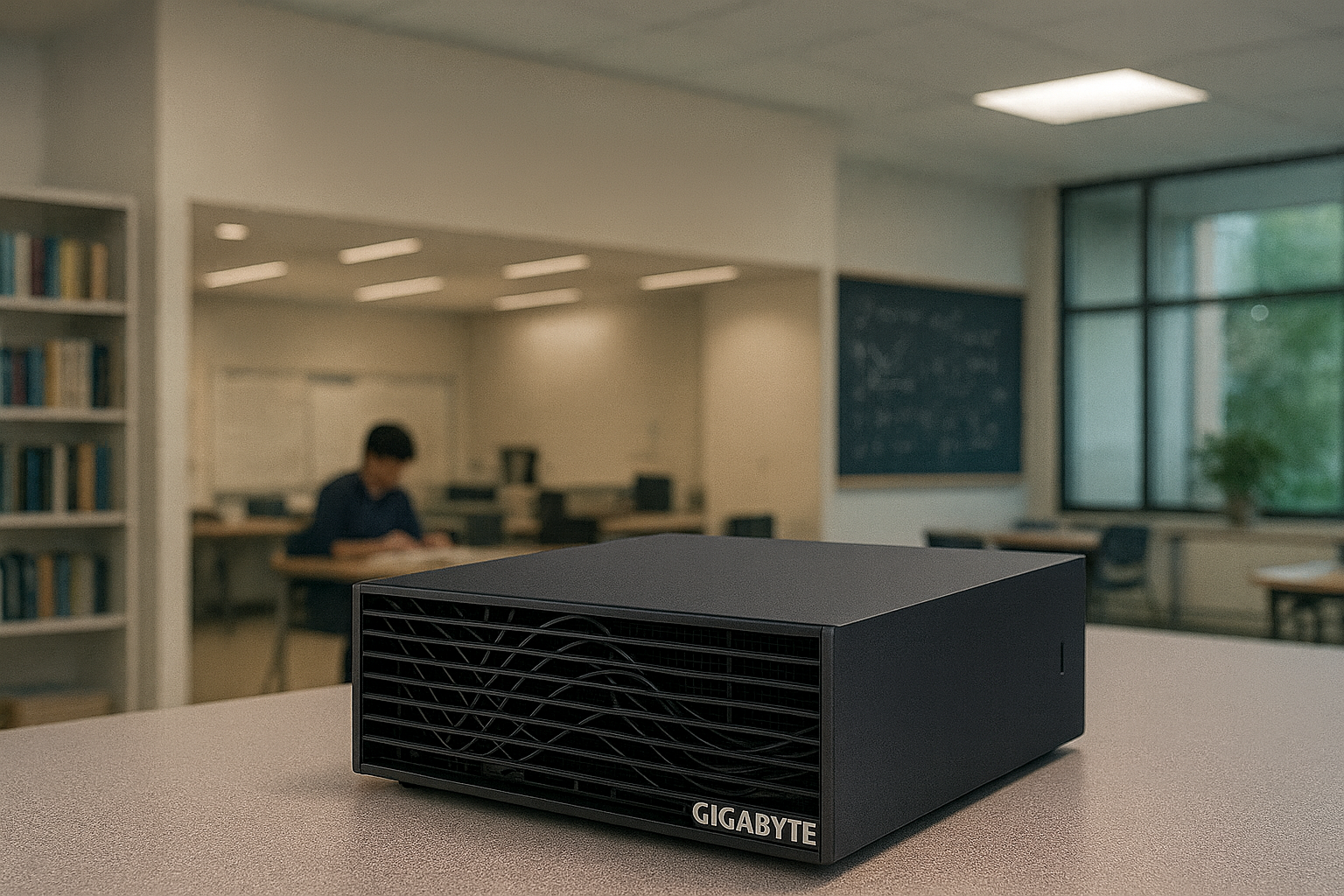

Introdução O avanço recente da computação de alta performance trouxe uma mudança profunda na forma como empresas e profissionais lidam com desenvolvimento, ajuste fino e execução de modelos de inteligência artificial. O que antes exigia grandes clusters, alto consumo energético e fortes investimentos em infraestrutura agora pode ser realizado diretamente na mesa do desenvolvedor, graças à combinação entre o GIGABYTE AI TOP ATOM e o ecossistema de software que o acompanha. No centro dessa transformação está o AI TOP Utility, uma plataforma que expõe capacidades essenciais de IA de forma simples, acessível e profundamente integrada ao hardware baseado no superchip NVIDIA GB10 Grace Blackwell. Em um contexto empresarial em que a velocidade de validação, a privacidade dos dados e a capacidade de iterar rapidamente tornaram-se fatores críticos, a possibilidade de treinar, ajustar e executar IA localmente reduz dependências externas e permite que equipes explorem fluxos completos de machine learning dentro de ambientes controlados. Esse movimento responde a um desafio crescente: como realizar experimentos de IA cada vez mais complexos sem depender exclusivamente da nuvem e sem comprometer segurança, custos e desempenho? A inação frente a essa mudança traz riscos significativos. Organizações que permanecem dependentes de infraestruturas remotas estão sujeitas a latência, custos recorrentes e limitações de privacidade. Além disso, projetos de IA que dependem de ambientes externos tendem a sofrer com gargalos de integração e lentidão no ciclo de experimentação. O AI TOP Utility, somado ao poder computacional do AI TOP ATOM, apresenta uma resposta clara: executar toda a jornada de IA — do download de modelos ao fine-tuning e inferência — em um único ambiente local. Ao longo deste artigo, exploraremos como essa combinação cria um ecossistema completo e otimizado para prototipagem, treinamento, ajuste fino, machine learning e RAG, sempre com foco em desempenho, simplicidade operacional e benefícios estratégicos. Examinaremos os fundamentos técnicos habilitados pelo NVIDIA GB10 Grace Blackwell Superchip, os fluxos de trabalho suportados pelo AI TOP Utility e os impactos reais para pesquisadores, estudantes, cientistas de dados e desenvolvedores avançados. O Problema Estratégico Projetos modernos de inteligência artificial enfrentam uma tensão constante entre performance, segurança e agilidade de desenvolvimento. Modelos cada vez maiores demandam maior largura de banda, mais memória unificada e maior capacidade de cómputo. Dependência excessiva de nuvem, por outro lado, adiciona custos imprevisíveis e limita a experimentação rápida. Os dados utilizados em fine-tuning ou treinamento, muitas vezes sensíveis, tornam-se vulneráveis a riscos de exposição quando operam fora do ambiente local. Além disso, desenvolvedores e pequenas equipes frequentemente encontram barreiras técnicas para montar ambientes robustos de IA. A necessidade de configurações complexas, instalação de frameworks, compatibilização de versões e gestão de dependências cria um overhead prejudicial ao ritmo de inovação. Isso afeta não apenas experimentos iniciais, mas todo o ciclo de desenvolvimento, incluindo testes, ajustes e implantação. O desafio se intensifica à medida que modelos de IA generativa crescem em tamanho e se tornam mais exigentes em termos computacionais. Executar modelos com centenas de bilhões de parâmetros, por exemplo, é impraticável em máquinas convencionais. A ausência de memória unificada, largura de banda insuficiente ou interconexões inadequadas torna a execução local inviável, mantendo equipes dependentes de provedores externos. Consequências da Inação Ignorar essa mudança tecnológica coloca organizações em clara desvantagem competitiva. Primeiramente, os custos de operação em nuvem podem aumentar significativamente à medida que os experimentos se tornam mais frequentes e mais pesados. A latência inerente às conexões externas compromete ciclos de teste, e a integração com sistemas locais torna-se lenta e ineficiente. Outro impacto crítico é a exposição de dados. Processos de fine-tuning que dependem de informações proprietárias tornam-se vulneráveis quando executados fora de ambientes internos. A falta de autonomia computacional impede empresas de manter confidencialidade e governança firme sobre seus dados estratégicos. Por fim, equipes sem capacidade local de experimentação acabam iterando menos, validando menos hipóteses e aprendendo mais lentamente. No ritmo acelerado da IA moderna, isso pode significar a perda de oportunidades de inovação e menor competitividade frente a concorrentes mais preparados. Fundamentos da Solução: A Arquitetura que Sustenta o AI TOP Utility A base que viabiliza a experiência completa do AI TOP Utility é o GIGABYTE AI TOP ATOM, equipado com o superchip NVIDIA GB10 Grace Blackwell, um componente desenhado especificamente para cargas de IA modernas. Sua capacidade de atingir até 1 petaFLOP de desempenho em FP4 permite que workloads intensivos sejam executados diretamente em um desktop compacto de apenas 1 litro de volume. A presença de 128GB de memória unificada desempenha um papel central. Diferentemente de arquiteturas fragmentadas, a memória unificada reduz movimentações e gargalos, permitindo que modelos grandes fluam sem penalidade entre CPU e GPU. Isso é especialmente relevante para tarefas de fine-tuning e inferência de modelos com até 200 bilhões de parâmetros — e até 405 bilhões quando dois sistemas são interligados via NVIDIA ConnectX-7 SmartNIC. O AI TOP Utility se beneficia diretamente dessa arquitetura ao fornecer um ambiente simplificado de acesso a modelos, workflows de machine learning e pipelines de inferência. A integração com a NVIDIA AI Software Stack garante que o desempenho seja consistente, previsível e otimizado para cargas generativas, RAG e pipelines tradicionais de ML. Implementação Estratégica com o AI TOP Utility Model Download O ponto de partida para qualquer projeto de IA é o acesso a modelos base. O AI TOP Utility incorpora um mecanismo que permite obter modelos diretamente, eliminando barreiras comuns como configuração manual de repositórios, incompatibilidades ou downloads fragmentados. Esse processo simplificado reduz tempo de preparação e minimiza erros, permitindo que equipes iniciem mais rapidamente o ciclo de experimentação. Inferência Local Com o hardware do AI TOP ATOM, inferência local se torna não apenas viável, mas altamente eficiente. A latência reduzida, o controle total do ambiente e a ausência de custos externos garantem uma experiência de execução fluida. Além disso, a inferência local permite testar modelos em cenários mais realistas, especialmente quando há necessidade de integração com sistemas internos ou dados corporativos. Retrieval-Augmented Generation (RAG) O suporte a RAG habilita fluxos de IA mais avançados, nos quais modelos podem consultar bases

Da Pesquisa ao Edge: Como o GIGABYTE AI TOP ATOM Acelera Aplicações Avançadas de IA A evolução da inteligência artificial avançada deixou de ser um privilégio exclusivo de datacenters e clusters massivos. Hoje, pesquisadores, engenheiros e equipes de desenvolvimento precisam de plataformas compactas, eficientes e profundamente integradas que permitam prototipar modelos, executar inferência de alto desempenho e levar aplicações de IA até o edge — tudo sem depender continuamente de infraestrutura remota. Dentro desse cenário, o GIGABYTE AI TOP ATOM emerge como um dispositivo singular: um sistema de 1 litro de volume, equipado com o superchip NVIDIA GB10 Grace Blackwell, capaz de entregar 1 petaFLOP de desempenho em IA, operando com memória unificada LPDDR5x de 128 GB e interfaces como ConnectX-7 e 10GbE. Este artigo aprofunda como essa plataforma compacta, porém extremamente poderosa, acelera tarefas reais e complexas — desde pesquisa e prototipagem até aplicações edge como robótica e visão computacional. O foco aqui não é apenas descrever componentes, mas analisar como sua arquitetura integrada transforma o fluxo de trabalho de IA em ambientes altamente exigentes. Introdução Contextualização Estratégica A crescente adoção de IA em ambientes corporativos ultrapassou o estágio experimental. Modelos se tornaram mais densos, pipelines mais sofisticados e o processamento de dados mais contínuo. Instituições de pesquisa, laboratórios de prototipagem, departamentos de engenharia e empresas orientadas a edge computing enfrentam um desafio comum: precisam de hardware local com capacidade real de acelerar workloads intensas sem depender de clusters centralizados ou da volatilidade de custos da nuvem. Em paralelo, a consolidação de arquiteturas unificadas, como a proposta pelo superchip NVIDIA GB10 Grace Blackwell, redesenha a forma como memória, processamento e interconexão cooperam. Essa integração torna possível trazer cargas de trabalho tradicionalmente restritas a supercomputadores para ambientes de mesa, permitindo que o desktop se comporte como um núcleo de IA altamente eficiente. Desafios Críticos Para tarefas avançadas como fine-tuning, data science aplicada, inferência intensiva ou aplicações de robótica e visão computacional, os desafios geralmente recaem em três eixos centrais: largura de banda de memória, eficiência computacional e capacidade de interconexão de alta velocidade. Sistemas convencionais não foram projetados para manter carregamentos contínuos de modelos, transferências rápidas de dados e execução de operações matriciais complexas de forma simultânea. Além disso, aplicações edge exigem deslocamento de processamento para o ponto de uso, reduzindo latência e dependência de cloud. Sem hardware adequado, prototipar localmente e implantar no edge se torna uma tarefa fragmentada e ineficiente. Custos e Riscos da Inação A ausência de uma solução local como o GIGABYTE AI TOP ATOM leva a riscos operacionais concretos. Pesquisadores perdem tempo com filas em clusters remotos. Cientistas de dados enfrentam gargalos em pipelines de treinamento e inferência. Equipes de robótica não conseguem testar modelos em tempo real com consistência. Ambientes industriais no edge sofrem com latências que inviabilizam decisões instantâneas. Cada atraso gera custos — operacionais, de oportunidade e competitivos. Sem um sistema compacto capaz de manter densidade computacional elevada, a organização torna-se dependente de infraestrutura externa, perdendo capacidade de reação, segurança e previsibilidade. Visão Geral do Conteúdo Este artigo analisará como o GIGABYTE AI TOP ATOM, com sua combinação de CPU Arm de 20 núcleos, memória unificada de 128GB LPDDR5x e aceleração Blackwell, atende a esses desafios. Serão abordadas aplicações práticas em pesquisa, prototipagem, fine-tuning, inferência, ciência de dados e workloads edge, explorando os fundamentos arquitetônicos que permitem esse nível de performance. 1. O Problema Estratégico: A Demanda Crescente por Potência Local Contexto Empresarial e Técnico À medida que a IA se torna o eixo central de inovação em setores como saúde, manufatura, varejo, finanças, logística e robótica, cresce a necessidade de executar cargas intensas de forma local e contínua. A dependência de nuvem, embora vantajosa para elasticidade, não resolve imediatamente desafios como latência, segurança de dados sensíveis, custos variáveis ou limitação de acesso quando múltiplos times competem pelos mesmos recursos. Em laboratórios de pesquisa e desenvolvimento, o ciclo de experimentação exige que modelos sejam carregados e testados repetidamente, muitas vezes em variações pequenas, demandando largura de banda de memória e desempenho computacional que ultrapassam o que laptops e workstations tradicionais oferecem. Robótica e visão computacional tornam esse desafio ainda maior: modelos precisam responder em tempo real, e cada milissegundo perdido pode comprometer a segurança ou o resultado da operação. As Limitações das Plataformas Comuns Plataformas tradicionais de desktop ou mobile workstation sofrem com gargalos claros: comunicação lenta entre CPU e GPU, ausência de memória unificada, interfaces de rede que limitam ingestão e despacho de dados e consumo energético que impede uso em ambientes edge. Sem integração arquitetônica profunda, fine-tuning, inferência intensiva e pipelines científicos tornam-se fragmentados e lentos. 2. Consequências da Inação Ignorar a necessidade de processamento local especializado cria um conjunto de consequências diretas para equipes técnicas. O desempenho inadequado durante prototipagem aumenta o tempo necessário para validação de modelos, impactando ciclos de desenvolvimento. Em aplicações industriais que dependem de inferência contínua, latências altas podem gerar falhas operacionais ou comportamentos imprecisos. No edge, a ausência de hardware compact o limita a execução de modelos simplificados, sacrificando produtividade e precisão. Cada limitação técnica representa um risco — seja em experimentação científica, automação, análise de dados ou interação homem-máquina. 3. Fundamentos da Solução: A Arquitetura do GIGABYTE AI TOP ATOM 3.1 O Superchip NVIDIA GB10 Grace Blackwell No centro do GIGABYTE AI TOP ATOM está o superchip NVIDIA GB10 Grace Blackwell — uma integração avançada que combina processamento Arm de alta densidade com aceleração Blackwell em uma arquitetura unificada. Essa arquitetura oferece benefícios críticos para workloads modernos, permitindo que CPU e aceleração de IA compartilhem a mesma memória LPDDR5x de 128 GB com largura de banda de 273 GB/s. Essa unificação elimina a necessidade de cópias redundantes entre GPU e sistema, reduzindo latência e otimizando a movimentação de dados, ponto crucial para treinamento leve, fine-tuning e inferência. O resultado é um fluxo de dados mais direto e eficiente, permitindo que modelos permaneçam carregados e acessíveis com agilidade. 3.2 1 PetaFLOP de Performance em IA O desempenho de 1 petaFLOP em tarefas de

Escalabilidade de IA no Desktop: Como o AI TOP ATOM Suporta Modelos de Até 405B Parâmetros Introdução A evolução dos modelos de Inteligência Artificial atingiu um ponto em que sua complexidade não pode mais ser tratada exclusivamente por infraestruturas centralizadas ou dependentes da nuvem. Mesmo organizações avançadas e equipes de pesquisa esbarram em barreiras ligadas à disponibilidade de recursos, privacidade de dados, custos operacionais e necessidade de experimentação rápida. Nesse cenário, a capacidade de executar modelos de grande porte diretamente no desktop deixa de ser um luxo tecnológico e se torna uma exigência estratégica. É nesse contexto que o GIGABYTE AI TOP ATOM se posiciona como uma solução singular. Descrito oficialmente como um “personal AI supercomputer”, o sistema reúne desempenho em escala de petaFLOP, arquitetura NVIDIA GB10 Grace Blackwell, memória unificada coerente de 128GB e até 4TB de armazenamento NVMe, tudo em um formato compacto de mesa. No entanto, seu diferencial mais transformador para aplicações de grande porte é a capacidade de escalar para suportar modelos de até 405 bilhões de parâmetros por meio do uso da SmartNIC NVIDIA ConnectX-7. Para pesquisadores, cientistas de dados e desenvolvedores de IA que lidam com modelos cada vez maiores, a escalabilidade não é apenas uma característica técnica — é a base da inovação. Quando a arquitetura permite que dois sistemas AI TOP ATOM atuem em conjunto através de comunicação de alta largura de banda e baixa latência, o desktop deixa de ser um ambiente limitado e passa a entregar capacidades normalmente associadas a clusters de data center. Porém, para que essa escalabilidade seja compreendida em profundidade, é necessário analisar os desafios que motivam essa evolução e as implicações de sua ausência. Neste artigo, exploraremos de forma detalhada e analítica como o AI TOP ATOM oferece um caminho claro para a execução e o desenvolvimento de modelos de até 405B parâmetros, respeitando estritamente as informações fornecidas no material original. Serão abordados desafios estratégicos, fundamentos de arquitetura, implicações técnicas e caminhos de implementação, sempre conectando aspectos técnicos à realidade de quem depende de modelos cada vez mais complexos para gerar avanço científico e inovação empresarial. O Problema Estratégico da Escalabilidade em IA Limitações de Execução de Modelos Grandes Modelos contemporâneos de IA, especialmente os generativos e multimodais, operam com quantidades massivas de parâmetros. O próprio material oficial do AI TOP ATOM destaca suporte a modelos de até 200 bilhões de parâmetros em configuração individual, e até 405 bilhões de parâmetros quando dois sistemas são interconectados via SmartNIC ConnectX-7. Esses valores ilustram um cenário no qual a capacidade local de execução está diretamente ligada à evolução da pesquisa e do desenvolvimento. A limitação mais evidente nesse contexto é a insuficiência de recursos tradicionais encontrados em desktops comuns. Processadores convencionais, arquiteturas fragmentadas de memória e soluções gráficas não projetadas para cargas de trabalho intensivas se tornam gargalos inevitáveis. Em contraste, o AI TOP ATOM fornece uma arquitetura otimizada para IA, incluindo um superchip Grace Blackwell e Tensor Cores de quinta geração, especificamente desenhados para cargas de trabalho complexas. Pressão por Execução Local e Independência da Nuvem A necessidade de executar modelos localmente não se limita ao desempenho. Há motivações estratégicas relacionadas à privacidade, controle sobre o ciclo de desenvolvimento e redução de custos recorrentes. O material destaca explicitamente que o sistema é ideal para prototipagem, fine-tuning, inferência e edge applications, reforçando que a independência operacional é um fator essencial. No entanto, a execução local de modelos de larga escala exige não apenas potência computacional bruta, mas também uma arquitetura que viabilize a expansão além de um único sistema — e é justamente nesse ponto que a escalabilidade proporcionada pela interconexão entre dois AI TOP ATOM torna-se relevante. Consequências da Inação na Escalabilidade Estagnação na Pesquisa e Desenvolvimento Ignorar a necessidade de escalar modelos grandes para execução local significa comprometer a capacidade de pesquisa, experimentação e inovação. Para pesquisadores e cientistas, trabalhar com limites rígidos de parâmetros impede a exploração plena de novas arquiteturas e técnicas modernas que dependem de modelos cada vez mais amplos. A ausência de escalabilidade local força a dependência da nuvem, o que introduz latência, risco de indisponibilidade e custos contínuos. Além disso, trabalhar com dados sensíveis em ambientes externos pode ser inviável em setores como saúde, jurídica e industrial, onde a proteção da informação é mandatória. Perda de Competitividade e Velocidade de Iteração Equipes que dependem exclusivamente de infraestruturas remotas para processar modelos grandes perdem velocidade na etapa mais crítica do ciclo de IA: a iteração. Sem capacidade local de ajuste fino, avaliação rápida e execução contínua, o tempo de desenvolvimento aumenta e a competitividade diminui. Ao contrário, o AI TOP ATOM foi projetado explicitamente para permitir desenvolvimento, prototipagem e execução local, com suporte completo ao stack NVIDIA AI e integração com a ferramenta AI TOP Utility. Isso assegura que a ausência de escalabilidade não se traduza em atrasos operacionais ou travamentos no fluxo de inovação. Fundamentos da Solução: Arquitetura e Escalabilidade Literalmente Descritas Desempenho Base: 1 PetaFLOP e Arquitetura Blackwell O AI TOP ATOM fornece até 1 petaFLOP de desempenho em precisão FP4, sustentado pelo superchip NVIDIA GB10 Grace Blackwell. Essa arquitetura de última geração combina um CPU Arm de 20 núcleos com Tensor Cores avançados, garantindo alta performance mesmo em modelos massivos. Esse desempenho é reforçado por 128GB de memória unificada coerente e largura de banda de 273GB/s, parâmetros que contribuem diretamente para viabilizar o processamento de modelos grandes descrito no material oficial. Escalabilidade Através do NVIDIA ConnectX-7 O elemento mais importante para os modelos de até 405 bilhões de parâmetros é o NVIDIA ConnectX-7 SmartNIC. O material afirma explicitamente que o sistema suporta: “Support up to 405B parameters w/ NVIDIA ConnectX-7.” Também explica que, ao conectar dois sistemas AI TOP ATOM, é possível escalar workloads de IA para modelos mais exigentes por meio de comunicação de alta largura de banda e baixa latência. Essas afirmações constituem a única base permitida para a análise técnica, e por isso a compreensão da escalabilidade deve partir delas exclusivamente. A conclusão direta é

Grace Blackwell GB10: A Arquitetura que Eleva o GIGABYTE AI TOP ATOM ao Patamar de IA de Supercomputadores Introdução A transformação acelerada do mercado de Inteligência Artificial está redefinindo a forma como organizações desenvolvem, treinam e implantam modelos avançados. À medida que a demanda por processamento cresce e os modelos de IA passam a exigir centenas de bilhões de parâmetros, a distância entre a capacidade real de hardware disponível e a necessidade operacional de desenvolvedores, pesquisadores e empresas se torna cada vez maior. Até recentemente, essa lacuna era preenchida por infraestruturas massivas em data centers, tecnologias caras e arquiteturas distribuídas complexas. No entanto, o surgimento de sistemas compactos, de baixo consumo e com desempenho de supercomputador redefine completamente esse cenário. Nesse contexto, o GIGABYTE AI TOP ATOM emerge como uma resposta estratégica, ao incorporar um componente central capaz de mudar o equilíbrio entre acessibilidade, desempenho e autonomia: o superchip NVIDIA GB10 Grace Blackwell. A presença desse superchip não representa apenas um incremento técnico. Ela reconfigura a lógica de desenvolvimento de IA ao trazer, para um formato de mesa, uma capacidade antes reservada a clusters de alta performance. A entrega de até 1 petaFLOP em formato compacto e eficiente em energia cria uma nova categoria de sistemas voltados para IA local, abrindo oportunidades que vão desde prototipação e fine-tuning até inferência avançada e aplicações de edge computing. Este artigo aprofunda a análise do papel do superchip Grace Blackwell GB10 dentro do GIGABYTE AI TOP ATOM, avaliando o impacto estratégico dessa arquitetura no uso empresarial da IA. Além disso, exploraremos como sua combinação com memória unificada, conectividade avançada e suporte a cargas de até 200 bilhões de parâmetros redefine o que significa executar IA de alto nível sem depender exclusivamente da nuvem. O Problema Estratégico: A Escalada das Exigências Computacionais em IA Modelos de IA contemporâneos evoluíram em direção a arquiteturas cada vez maiores, com centenas de bilhões de parâmetros e cargas de trabalho que exigem paralelismo massivo. Este cenário coloca pressão crescente sobre infraestruturas tradicionais, que frequentemente não conseguem acompanhar a escala de processamento necessária para prototipar, ajustar ou implantar esses modelos com eficiência. Os desafios não são apenas computacionais. Há também pressões relacionadas a privacidade, latência, custos recorrentes de nuvem e dependência de infraestrutura remota. Empresas que trabalham com dados sensíveis, pesquisadores que iteram rapidamente e desenvolvedores que buscam autonomia técnica frequentemente se veem limitados por essas barreiras estruturais. Assim, o problema central não está somente em “ter mais performance”, mas em ter performance acessível, local, responsiva e independente de data centers distantes. É justamente nessa lacuna estratégica que o superchip Grace Blackwell GB10 se posiciona como elemento transformador. Consequências da Inação Diante da Evolução da IA A não adoção de arquiteturas capazes de lidar com a nova geração de modelos traz impactos diretos para empresas e equipes de desenvolvimento. Em primeiro lugar, há o risco de lentidão operacional: modelos que levam horas para serem testados ou ajustados impedem a evolução natural de protótipos e a validação de hipóteses. Além disso, continuar dependente exclusivamente de ambientes de nuvem aumenta custos recorrentes, impede ciclos de iteração rápida e reduz a capacidade de inovação em contextos que exigem teste imediato. Cada latência adicional entre desenvolvedor e modelo impacta negativamente produtividade, criatividade e competitividade. Outro risco significativo está relacionado à soberania de dados. Organizações com requisitos rígidos de governança podem encontrar na computação local um pilar indispensável. A inação pode significar continuar exposto a riscos de conformidade e limitações regulatórias que afetam diretamente estratégias de IA. Por fim, há o custo da oportunidade perdida. Enquanto concorrentes adotam estruturas especializadas para IA local, empresas lentas em se adaptar podem perder vantagem competitiva, eficiência operacional e capacidade de inovação. Fundamentos da Solução: O Papel do NVIDIA GB10 Grace Blackwell no AI TOP ATOM O GIGABYTE AI TOP ATOM é construído em torno de um elemento fundamental: o superchip NVIDIA GB10 Grace Blackwell. Ele é a âncora que sustenta o desempenho de até 1 petaFLOP de processamento de IA, possibilitando que mesmo modelos de até 200 bilhões de parâmetros sejam manipulados com eficiência local. Essa capacidade é reforçada pelo uso de 128GB de memória unificada coerente, permitindo que o sistema opere grandes conjuntos de dados e modelos sem fragmentações entre CPU e componentes aceleradores. No contexto de IA, isso reduz gargalos e cria fluidez operacional para cargas que exigem alto volume de movimentação de dados. Outro elemento central é a presença de uma CPU Arm de 20 núcleos. Embora o conteúdo original não entre em detalhes sobre sua arquitetura interna, fica claro que esse componente é essencial para equilibrar operações de IA com tarefas de sistema, facilitando o fluxo de trabalho desde prototipação até inferência. Por fim, tecnologias como NVLink-C2C se destacam como pilares de comunicação de alta velocidade, ampliando o potencial do superchip GB10 dentro da plataforma. Mesmo sem detalhamento técnico no material original, sua simples presença evidencia um ecossistema projetado para cargas de IA modernas. Implementação Estratégica no Ambiente Empresarial A adoção do GIGABYTE AI TOP ATOM apoiado pelo superchip Grace Blackwell GB10 habilita empresas a deslocarem parte de suas operações de IA para infraestrutura local. Isso gera impacto direto em três dimensões estratégicas: desempenho, autonomia e governança. Em termos de desempenho, o sistema permite que prototipação e fine-tuning ocorram diretamente no desktop do desenvolvedor, reduzindo latências e acelerando ciclos iterativos. A eliminação de barreiras entre ideia, execução e validação impulsiona a produtividade das equipes de IA. Na dimensão da autonomia, a execução de modelos localmente reduz custos de nuvem e dependências externas. Organizações passam a ter controle direto sobre seu pipeline, desde datasets até versões de modelos. Isso é particularmente valioso para segmentos regulados ou projetos com dados sensíveis. Por fim, considerando governança e compliance, a computação local se torna elemento essencial para conformidade com normas de proteção de dados, garantindo que datasets internos não precisem sair do ambiente corporativo. Melhores Práticas Avançadas Para extrair o máximo da combinação entre o AI TOP ATOM e o superchip GB10, empresas devem estruturar suas

AI TOP ATOM: Supercomputação de IA Pessoal com 1 Petaflop para Desenvolvimento Local Introdução O avanço acelerado da Inteligência Artificial transformou a capacidade computacional em um dos principais diferenciais competitivos no cenário empresarial. Até poucos anos atrás, operar modelos avançados exigia clusters de GPU, ambientes de data center ou infraestrutura em nuvem com custos significativos e riscos relacionados à latência, privacidade e disponibilidade. Nesse contexto, o AI TOP ATOM surge como uma mudança estrutural: um supercomputador de IA em escala petaflop, projetado para uso pessoal e local, capaz de entregar desempenho de classe profissional em um formato compacto e altamente eficiente. As organizações enfrentam hoje um desafio duplo: precisam acelerar a inovação baseada em IA enquanto mantêm total controle sobre dados sensíveis, evitando exposição a provedores externos e reduzindo custos operacionais permanentes. A resposta estratégica para essa demanda está em soluções que combinam computação local de alta densidade, eficiência energética e capacidade de lidar com modelos generativos de larga escala — exatamente onde o AI TOP ATOM se posiciona. A inação nesse cenário representa perdas tangíveis: maior dependência da nuvem, aumento dos custos operacionais, riscos de compliance, limitações de desempenho e incapacidade de iterar rapidamente em projetos avançados. O AI TOP ATOM oferece uma alternativa clara ao permitir que o poder de um supercomputador — incluindo 1 petaflop de computação FP4 — esteja disponível diretamente no desktop do desenvolvedor, pesquisador ou cientista de dados. Neste artigo, vamos aprofundar os fundamentos técnicos e estratégicos do sistema, explorando como a combinação do NVIDIA® GB10 Grace Blackwell Superchip, a memória unificada de 128 GB, o SmartNIC ConnectX-7 e o ecossistema completo NVIDIA AI transformam o AI TOP ATOM em uma solução ideal para desenvolvimento, prototipagem, fine-tuning e inferência totalmente local. Vamos analisar desafios, riscos, implicações de negócio e oportunidades concretas habilitadas por esta arquitetura. O Problema Estratégico: A Limitação da Infraestrutura Convencional Desafio Empresarial e Técnico O crescimento dos modelos generativos — alguns ultrapassando centenas de bilhões de parâmetros — trouxe um desafio crítico: a infraestrutura necessária para treinar, ajustar ou mesmo inferir nesses modelos tornou-se proibitiva para ambientes tradicionais. Em empresas, laboratórios e equipes de inovação, isso se traduz em ciclos de experimentação mais lentos, alto custo de escalabilidade e forte dependência de serviços externos. Mesmo para workloads locais, desktops convencionais simplesmente não possuem a memória, largura de banda e integração necessárias para lidar com modelos avançados. Impactos na Operação e no Negócio A limitação computacional não é apenas um problema técnico; é um obstáculo direto à competitividade. Organizações que não conseguem iterar rapidamente ou manter modelos localmente acabam: – Aumentando riscos de segurança e privacidade ao enviar dados sensíveis para a nuvem. – Sofrendo com latência e limites de throughput em workloads críticos. – Gastando mais com infraestrutura remota, armazenamento e transferência de dados. – Reduzindo a capacidade de desenvolver soluções proprietárias, únicas e diferenciadas. Portanto, o gargalo computacional gera perda de eficiência, eleva custos e dificulta inovação em ritmo adequado às demandas de mercado. Consequências da Inação Empresas que dependem exclusivamente de infraestrutura remota acabam enfrentando uma série de desafios que se intensificam com o crescimento das aplicações de IA. A transferência de dados para ambientes externos implica aumento de exposição, maior complexidade regulatória e dependência de políticas de terceiros. Além disso, ferramentas de desenvolvimento baseadas em nuvem reduzem a autonomia da equipe técnica, tornando processos de prototipagem mais lentos e limitando a capacidade de experimentação intensiva. A ausência de um ambiente local de alta performance também impacta diretamente o ciclo de vida dos modelos. Ajustes de hiperparâmetros, testes rápidos de versões e simulações de cenários tornam-se mais caros e demorados, diminuindo a eficiência do time. Em setores como saúde, jurídico, finanças ou indústria, onde a privacidade do dado é crítica, depender exclusivamente da nuvem é um risco estratégico. Fundamentos da Solução: A Arquitetura do AI TOP ATOM A Base de Supercomputação em Formato Compacto O AI TOP ATOM redefine o conceito de estação de trabalho ao combinar potência de supercomputador com um formato compacto de apenas 1 litro. Seu núcleo é o NVIDIA® GB10 Grace Blackwell Superchip, que une capacidade massiva de processamento com alta eficiência energética — uma combinação essencial para ambientes locais. Esse superchip acelera cargas de trabalho de IA por meio de sua arquitetura híbrida, que inclui um CPU Arm de 20 núcleos (10 Cortex-X925 + 10 Cortex-A725) e Tensor Cores de quinta geração capazes de entregar até 1 petaflop de performance FP4. Essa escala de poder, antes restrita a data centers, agora está disponível diretamente sobre a mesa de trabalho do usuário. Memória Unificada de 128 GB Um dos pontos mais críticos em workloads modernos é a capacidade de manter grandes modelos em memória. O AI TOP ATOM oferece 128 GB de memória unificada LPDDR5x, operando com largura de banda de 273 GB/s. Isso elimina gargalos tradicionais entre CPU, GPU e barramento, permitindo que modelos de até 200 bilhões de parâmetros sejam executados localmente sem a fragmentação típica de arquiteturas convencionais. NVLink-C2C: Comunicação em Baixa Latência O suporte à tecnologia NVIDIA NVLink™-C2C garante comunicação de alta velocidade entre componentes internos, reduzindo latência e aumentando a eficiência em deep learning, especialmente em modelos generativos e multimodais. Essa arquitetura permite que workloads intensivos sejam processados com fluidez, sem interrupções ou quedas de performance. Armazenamento NVMe de Até 4 TB A capacidade de armazenamento também é alinhada às demandas modernas: até 4 TB de NVMe Gen5 14000 com criptografia nativa. Isso assegura desempenho consistente para datasets, checkpoints, embeddings e pipelines completos de machine learning. ConnectX-7: O Elo de Escalabilidade Para workloads avançados, especialmente envolvendo modelos acima de 200 bilhões de parâmetros, o AI TOP ATOM integra o NVIDIA® ConnectX-7 SmartNIC. Essa interface permite conectar dois sistemas AI TOP ATOM, ampliando a capacidade para suportar modelos de até 405 bilhões de parâmetros. Com isso, o usuário obtém um ambiente escalável que cresce conforme a maturidade das aplicações de IA. Implementação Estratégica da Tecnologia Ambiente de Desenvolvimento Local Completo O AI TOP ATOM não é apenas hardware. Ele integra

Network storage: arquitetura completa para desempenho, segurança e escalabilidade A transformação digital consolidou os dados como o núcleo operacional de praticamente todas as atividades empresariais. À medida que o volume de informações cresce em velocidade e diversidade, cresce também a exigência por sistemas capazes de armazenar, proteger e disponibilizar esses dados com precisão e consistência. Nesse cenário, o network storage se posiciona como um componente essencial: uma arquitetura projetada para centralizar, distribuir e preservar informações em ambientes locais ou remotos, atendendo tanto empresas quanto usuários domésticos. O desafio, entretanto, não está apenas na capacidade de acumular arquivos, mas em garantir disponibilidade contínua, segurança robusta e integração eficiente com sistemas dispersos. A realidade mostra que falhas de hardware, políticas de backup inconsistentes ou limitações de escalabilidade podem paralisar operações, gerar perdas financeiras relevantes e comprometer rotinas inteiras de trabalho. As exigências de mobilidade e colaboração multiponto elevam ainda mais a complexidade. Diante desse contexto, o network storage surge como um eixo estratégico para eliminar redundâncias manuais, consolidar dados dispersos, reduzir riscos e criar uma base resiliente para operações digitais. Este artigo aprofunda a arquitetura, a evolução, os problemas estruturais que ela resolve e os caminhos para sua adoção eficiente no ambiente corporativo. O problema estratégico do armazenamento distribuído Desconexão entre o crescimento dos dados e a infraestrutura legada O cenário mais comum em empresas de todos os portes é a fragmentação. Arquivos armazenados em desktops, notebooks, pendrives ou pastas locais criam uma cadeia de dependências que dificulta controle, visibilidade e governança. Com o crescimento acelerado de dados digitais, fluxos informacionais se tornam imprevisíveis e, sem centralização, escalam custos operacionais e riscos de perda. Esse aumento de volume exige sistemas que consigam acompanhar o ritmo, mas muitos ambientes ainda dependem de servidores legados ou soluções improvisadas incapazes de lidar com acesso simultâneo ou alta disponibilidade. A simples tentativa de expandir estruturas tradicionais gera interrupções, migrações complexas ou a necessidade de hardware adicional que nem sempre se integra bem ao ecossistema existente. Consequências da inação A falta de centralização e controle produz efeitos diretos na operação. Pequenas falhas de backup, ainda que isoladas, têm potencial de eliminar semanas de trabalho. A ausência de sincronização entre dispositivos aumenta o número de versões conflitantes de arquivos, empurra equipes para fluxos manuais improvisados e abre espaço para erros humanos. Além disso, a incapacidade de lidar com o aumento de demanda afeta performance, reduz produtividade e cria gargalos em atividades que exigem acesso contínuo e simultâneo. No plano estratégico, a ineficiência do armazenamento reduz competitividade e compromete a continuidade do negócio. Mesmo equipes domésticas enfrentam desafios semelhantes: fotos, vídeos e documentos armazenados sem organização ou redundância se tornam vulneráveis e difíceis de acessar em múltiplos dispositivos. Fundamentos técnicos do network storage Um repositório centralizado para múltiplas origens O network storage é definido como um sistema de armazenamento acessível via rede local ou internet, utilizando dispositivos como NAS, SAN ou servidores dedicados. Ele funciona como repositório unificado para estações de trabalho, notebooks, dispositivos móveis e aplicações de produção. O uso de protocolos como SMB, NFS ou iSCSI cria uma padronização no acesso e permite que sistemas distintos se conectem de forma consistente. Em um cenário típico de TI, a equipe instala storages em rack, define protocolos e cria permissões segmentadas. Em ambientes domésticos, o NAS conectado ao roteador oferece acesso simples a partir de qualquer dispositivo autorizado. Além de armazenar arquivos, o network storage incorpora recursos avançados como backup automático, sincronização com a nuvem e proteção via arranjos RAID. É uma evolução natural de servidores dedicados e unidades locais, agora com maior inteligência, escalabilidade e integração nativa com os serviços modernos. A evolução histórica do armazenamento em rede Primeira fase: servidores centralizados e fitas magnéticas Nos anos 80, o armazenamento compartilhado começa a se consolidar como ferramenta corporativa. Ainda dependente de servidores dedicados e fitas magnéticas, esse cenário tinha limitações claras: baixa velocidade, complexidade de expansão e custos elevados. Era uma infraestrutura restrita a grandes empresas. A ruptura dos anos 2000: consolidação do NAS acessível Com o avanço dos protocolos de comunicação e a popularização dos primeiros dispositivos NAS de baixo custo, o acesso centralizado se tornou possível para pequenas empresas e residências. Isso abriu um novo capítulo no armazenamento distribuído: agora qualquer usuário podia acessar arquivos a partir de múltiplos dispositivos de forma prática e segura. A era atual: SSDs, controladoras inteligentes e nuvem integrada A maturidade tecnológica elevou radicalmente o padrão. Os sistemas contemporâneos passaram a oferecer SSDs all-flash, interfaces de alta velocidade, controle inteligente de discos, integração completa com serviços de nuvem e interfaces web intuitivas. O resultado é uma plataforma que combina desempenho, flexibilidade e automação. Desempenho e escalabilidade em ambientes modernos Impacto de hardware e conectividade O desempenho de um network storage depende de componentes como tipo de disco, portas de rede e configuração RAID. A adoção de SSDs e portas 10GbE permite velocidades superiores a 1000 MB/s, fundamentais para aplicações como edição de vídeo em tempo real ou grandes rotinas de backup. Entretanto, gargalos externos podem limitar esses ganhos: switches antigos, cabeamento defasado e tráfego excessivo podem reduzir drasticamente o rendimento. Isso reforça que o desempenho é uma equação que envolve não apenas o NAS, mas toda a topologia de rede. Escalabilidade orientada pela demanda A expansão de capacidade é outro diferencial importante. Adicionar discos ou unidades de expansão dispensa migrações complexas ou longos períodos de indisponibilidade. Porém, a equipe de TI precisa monitorar continuamente o comportamento do sistema para ajustar configurações e garantir fluidez mesmo em cenários de crescimento acelerado. Segurança e resiliência: núcleo da continuidade operacional Proteção contra falhas físicas e acesso indevido A segurança é uma preocupação central em qualquer ambiente digital. A combinação de arranjos RAID, criptografia, autenticação em dois fatores e replicação remota forma a arquitetura básica de proteção oferecida por network storages modernos. Essas camadas mit igam riscos desde falhas mecânicas até acesso indevido. Sistemas que oferecem backup automático para nuvem e replicação entre unidades ampliam ainda mais a resiliência, funcionando como barreira contra perda

Soberania de Dados: Como o NAS ASUSTOR Garante Controle Total e Segurança Real Introdução A soberania de dados deixou de ser um conceito periférico para se transformar em um dos pilares da segurança digital moderna. Em um mundo onde informações circulam continuamente entre serviços de nuvem, dispositivos pessoais e ambientes corporativos, compreender quem realmente controla os dados tornou-se um imperativo estratégico. Essa discussão ganhou força globalmente à medida que empresas, governos e usuários comuns passaram a questionar se suas informações estão realmente protegidas quando armazenadas em nuvens públicas, muitas vezes sujeitas à legislação e aos interesses de outras jurisdições. Essa preocupação não nasce de um exagero, mas da realidade concreta de que dados armazenados em serviços internacionais podem ser acessados por terceiros ou até mesmo por governos estrangeiros, dependendo da legislação aplicável ao provedor. A partir desse ponto, surge uma dúvida crítica: é possível manter informações realmente soberanas quando se depende de infraestrutura de terceiros? Essa pergunta ganhou especial relevância em setores onde privacidade, sigilo e controle precisam ser absolutos — desde pequenas empresas até ambientes residenciais que passaram a lidar com volumes de dados sensíveis. Diante desse cenário, o NAS ASUSTOR se apresenta como um caminho sólido e estratégico para quem busca autonomia de dados. O armazenamento local oferece uma mudança radical no paradigma de controle: tudo permanece sob domínio direto do usuário, dentro da jurisdição onde os dados são gerados e utilizados. Esse modelo reduz a dependência de regulamentações internacionais, elimina riscos de acesso indevido por provedores externos e fortalece a proteção contra violações. Este artigo explora, em profundidade, como a ASUSTOR aborda o tema da soberania de dados e como funcionalidades como MyArchive, seu ecossistema ADM, camadas de segurança avançadas e preparação para criptografia pós-quântica (PQC) compõem uma arquitetura orientada para autonomia, proteção e resiliência. Também analisaremos os desafios, consequências da inação, fundamentos técnicos e recomendações práticas para implementação, de forma a capacitar organizações e usuários a tomar decisões mais estratégicas no gerenciamento de seus dados. Por que a soberania de dados se tornou uma questão estratégica? O problema empresarial e social A principal inquietação relacionada à soberania de dados emerge da incerteza jurídica e operacional ao confiar informações críticas a provedores internacionais. Quando os dados residem em uma nuvem pública, o proprietário real não é apenas quem gera ou utiliza essas informações, mas também o provedor que controla fisicamente e legalmente o ambiente onde elas se encontram. Isso cria uma fissura entre posse e controle, especialmente problemática quando leis externas podem autorizar acesso governamental ou coleta compulsória de dados, mesmo sem consentimento explícito do usuário. No contexto empresarial, o risco se amplia. Dados corporativos representam propriedade intelectual, relacionamentos comerciais, informações financeiras e registros confidenciais cuja exposição pode comprometer muito mais que a operação diária — pode afetar reputação, competitividade e até conformidade legal. Em muitos setores, confiar em serviços externos não é apenas arriscado, mas pode ser contrário a regulamentações específicas que exigem armazenamento sob determinadas jurisdições. Do ponto de vista de usuários domésticos, embora a escala seja menor, a natureza dos dados é igualmente sensível. Fotos pessoais, documentos privados e informações familiares tornam-se vulneráveis quando transferidas para provedores sobre os quais o usuário não exerce governança real. É nesse ponto que a soberania de dados se torna não apenas uma preocupação corporativa, mas uma necessidade universal. Consequências reais da inação Ignorar a soberania de dados significa assumir riscos substanciais — muitos deles invisíveis até que um incidente ocorra. Empresas podem enfrentar vazamentos que comprometam informações estratégicas e violem regulamentações locais. Além disso, decisões judiciais em outros países podem forçar provedores internacionais a fornecer dados armazenados por usuários brasileiros, mesmo que esses usuários nunca tenham consentido com tal ação. Há ainda impactos operacionais: a perda de disponibilidade, interrupções por falhas na nuvem ou mudanças unilaterais de políticas podem gerar dependências perigosas. Em cenários residenciais, a consequência mais comum é a perda total de dados quando contas são encerradas, serviços descontinuados ou quando ocorre um bloqueio indevido, algo comum em plataformas que aplicam algoritmos automáticos de verificação. Portanto, negligenciar a soberania de dados significa perder controle não apenas sobre o “onde”, mas também sobre o “como” e “por quem” seus dados podem ser acessados, manipulados ou interrompidos. Fundamentos técnicos da soberania de dados com NAS ASUSTOR Armazenamento local como pilar de soberania O NAS ASUSTOR oferece uma abordagem centrada no usuário, na qual o controle físico e lógico dos dados retorna integralmente ao proprietário. Como os dados são armazenados localmente, eles se tornam automaticamente sujeitos às leis da própria jurisdição do usuário. Isso elimina camadas intermediárias, reduz riscos jurídicos e fornece uma base robusta de governança digital. A vantagem estrutural do armazenamento local está na capacidade de evitar interferência externa. Ao contrário da nuvem, onde decisões de terceiros podem afetar acesso e disponibilidade, o NAS opera completamente sob comando direto do administrador. Isso inclui desde políticas de acesso até configurações de criptografia e gerenciamento de integridade. Em última instância, isso significa que “sua casa agora é seu país” — uma metáfora oferecida pela própria ASUSTOR para reforçar o conceito de soberania aplicada ao armazenamento local. Liberdade para planejar todo o ecossistema de armazenamento Um dos elementos mais estratégicos do NAS ASUSTOR é sua filosofia de autonomia total no ecossistema de hardware. Ao contrário de soluções proprietárias que limitam marcas de discos, impõem certificações exclusivas ou exigem aquisição de componentes específicos do fabricante, a ASUSTOR remove essas barreiras e devolve ao usuário a liberdade de projetar e expandir seu ambiente conforme necessidade real. Essa abordagem elimina custos desnecessários e evita aprisionamento tecnológico — um problema comum em plataformas que conectam soberania técnica à dependência de componentes. A capacidade de usar discos de qualquer marca fortalece tanto a acessibilidade quanto a longevidade do investimento, pois permite substituições rápidas, expansões flexíveis e adaptação orgânica do ambiente sem perda de compatibilidade. MyArchive: preservação independente e soberania extendida O recurso MyArchive representa um passo adicional na direção da soberania de dados, pois permite que discos rígidos sejam utilizados como unidades intercambiáveis