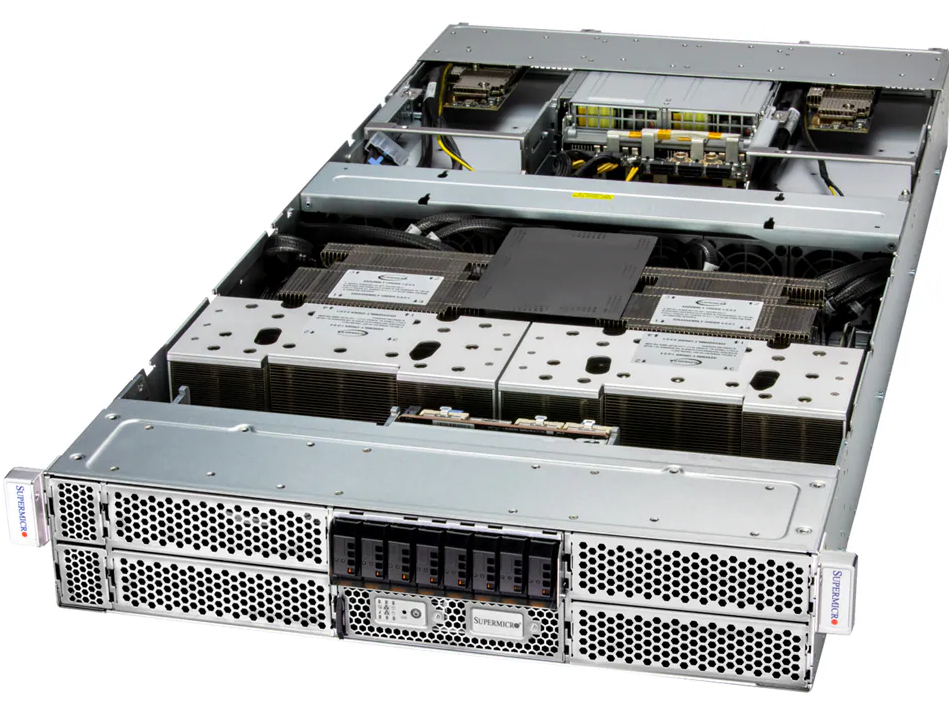

Servidor 8U Intel com NVIDIA HGX B300: Potência e Escalabilidade para IA Empresarial Introdução Em um cenário empresarial em que inteligência artificial, aprendizado profundo e computação de alto desempenho (HPC) definem competitividade, a infraestrutura de servidores se torna um fator crítico de sucesso. Organizações que trabalham com modelos de linguagem de larga escala (LLMs), simulações científicas ou veículos autônomos enfrentam a necessidade de sistemas capazes de processar enormes volumes de dados com alta eficiência e confiabilidade. A ausência de um servidor robusto e escalável pode resultar em gargalos de performance, atrasos em treinamentos de modelos de IA e riscos de indisponibilidade, afetando decisões estratégicas. Além disso, o custo de downtime e o consumo energético inadequado representam riscos financeiros e ambientais significativos. Este artigo explora detalhadamente o DP Intel 8U System com NVIDIA HGX B300 8-GPU, analisando suas capacidades técnicas, implicações de negócio, estratégias de implementação e melhores práticas para empresas que buscam máxima performance, confiabilidade e escalabilidade. Desenvolvimento Problema Estratégico Empresas de IA e HPC precisam lidar com processamento massivo e simultâneo de dados. Servidores convencionais não oferecem largura de banda suficiente, capacidade de memória ou interconexão entre GPUs para suportar cargas intensivas, o que limita treinamentos complexos e análises em tempo real. A falta de infraestrutura adequada impacta diretamente o time-to-market e a competitividade. Consequências da Inação Ignorar a necessidade de servidores especializados como o DP Intel 8U HGX B300 acarreta: atrasos em treinamentos de IA, aumento de custos operacionais, maior consumo energético por workload e riscos de falha em ambientes críticos. Para grandes LLMs, a indisponibilidade ou lentidão no processamento pode comprometer toda a pipeline de inferência e pesquisa. Fundamentos da Solução O DP Intel 8U System integra processadores Intel Xeon 6700 série com P-cores, suportando até 128 cores e 256 threads por CPU, oferecendo capacidade de processamento massivo. Suas 8 GPUs NVIDIA B300 Blackwell Ultra conectadas via NVSwitch garantem comunicação GPU-GPU de alta largura de banda, essencial para treinamento de modelos paralelos e HPC intensivo. O sistema possui 32 slots DIMM com até 8TB de memória ECC DDR5, garantindo tolerância a falhas e estabilidade em workloads críticos. A conectividade de rede de alta velocidade, com 8 NICs de 800GbE integradas, permite integração eficiente com storage e clusters, essencial para aplicações distribuídas de IA. Implementação Estratégica Para adoção eficaz, recomenda-se instalação em datacenters com resfriamento e energia adequados. A arquitetura modular com drives NVMe E1.S hot-swap e M.2 suporta expansão e manutenção sem downtime. Configurações de redundância de 6+6 fontes Titanium Level asseguram continuidade mesmo em falhas de energia, minimizando risco operacional. A implementação deve considerar integração com sistemas de gerenciamento, como SuperCloud Composer, Supermicro Server Manager e ferramentas de automação, garantindo monitoramento contínuo de saúde do sistema, uso de CPU, memória e status das GPUs. Melhores Práticas Avançadas Para otimização, é recomendada a utilização de balanceamento de carga entre GPUs, monitoramento proativo de temperatura via sensores de chassis e CPU, e atualização contínua de firmware seguro via TPM 2.0 e Root of Trust. Isso protege contra vulnerabilidades de supply chain e assegura integridade de workloads críticos. Empresas podem combinar este servidor com clusters distribuídos, integrando storage de alta velocidade e redes InfiniBand ou Ethernet, maximizando throughput e reduzindo latência para HPC e LLMs. Medição de Sucesso Indicadores críticos incluem: throughput de treinamento de modelos (ex. tokens/s para LLMs), uso de GPU e memória, disponibilidade do sistema, consumo energético por workload, tempo médio entre falhas (MTBF) e latência de comunicação inter-GPU. Monitoramento contínuo e dashboards integrados permitem ajustes estratégicos e antecipação de falhas. Conclusão O DP Intel 8U System com NVIDIA HGX B300 representa uma solução completa para empresas que buscam desempenho máximo em IA, HPC e LLMs. Sua combinação de CPU de alto desempenho, GPUs interconectadas via NVSwitch, memória expansível e conectividade ultrarrápida permite enfrentar desafios críticos de processamento e análise. A adoção estratégica deste servidor reduz riscos operacionais, otimiza custos energéticos e aumenta a capacidade de inovação. Organizações que implementam esta infraestrutura com boas práticas de monitoramento e redundância garantem vantagem competitiva significativa em ambientes de dados intensivos. Perspectivas futuras incluem integração com novas GPUs Blackwell, upgrades de memória DDR5 e redes de maior velocidade, permitindo evolução contínua do ambiente computacional. Empresas devem planejar escalabilidade modular e estratégias de atualização para acompanhar demandas crescentes de IA e HPC. Para adoção prática, recomenda-se planejamento de datacenter adequado, treinamento da equipe de TI e integração com sistemas de gerenciamento e automação, garantindo que a infraestrutura não apenas suporte, mas potencialize os objetivos estratégicos do negócio.

Introdução: a convergência entre IA, HPC e eficiência computacional O avanço da inteligência artificial (IA) e da computação de alto desempenho (HPC) redefiniu as exigências sobre infraestrutura empresarial. Ambientes que processam grandes volumes de dados, treinam modelos complexos de aprendizado profundo ou executam simulações científicas necessitam de servidores que unam densidade computacional, eficiência energética e escalabilidade arquitetural. Nesse contexto, o SuperServer AS-8126GS-TNMR da Supermicro representa um marco tecnológico ao combinar processadores AMD EPYC 9005/9004 de até 500W e até oito aceleradores AMD Instinct MI325X ou MI350X em um sistema de 8U de alta densidade. Projetado para cargas de trabalho críticas como treinamento de modelos de IA generativa, automação industrial, simulações climáticas e análise de dados em larga escala, o sistema entrega desempenho excepcional sem comprometer estabilidade, gerenciamento ou eficiência térmica. Organizações que hesitam em modernizar suas plataformas HPC com GPUs de última geração enfrentam custos ocultos significativos: perda de competitividade em modelagem preditiva, aumento de consumo energético e limitação de escalabilidade para novas aplicações baseadas em IA. Ao longo deste artigo, exploraremos a fundo os elementos técnicos e estratégicos do SuperServer AS-8126GS-TNMR, analisando sua arquitetura, interconexão CPU-GPU, eficiência de energia, gerenciamento inteligente e aplicabilidade real em ambientes corporativos e de pesquisa. O problema estratégico: o gargalo entre capacidade computacional e eficiência operacional Empresas e centros de pesquisa que operam cargas de IA ou HPC em escala frequentemente enfrentam um dilema entre desempenho máximo e controle de energia. Soluções com múltiplos GPUs e CPUs de alto consumo podem atingir o pico de desempenho, mas sacrificam eficiência térmica, densidade e custo operacional. Essa relação desequilibrada cria gargalos tanto no desempenho quanto na sustentabilidade do data center. O SuperServer AS-8126GS-TNMR foi projetado para resolver esse impasse. Sua arquitetura de 8U com refrigeração a ar otimizada e seis fontes de energia Titanium de 5250W garante estabilidade mesmo sob cargas intensas de até 96% de eficiência energética. O uso dos processadores AMD EPYC 9005/9004 — com até 384 núcleos e 768 threads — permite processar grandes volumes de dados paralelamente às GPUs AMD Instinct, reduzindo latências e maximizando throughput computacional. Ao contrário de configurações fragmentadas com múltiplos servidores menores, a consolidação de processamento e armazenamento no AS-8126GS-TNMR reduz a complexidade de rede e simplifica o gerenciamento de workloads, resultando em um TCO (Total Cost of Ownership) mais competitivo. Consequências da inação: os riscos de permanecer em arquiteturas defasadas Ignorar a evolução arquitetural das plataformas de HPC e IA pode resultar em graves desvantagens competitivas. Ambientes baseados em interconexões PCIe 3.0, memórias DDR4 e GPUs de gerações anteriores enfrentam limitações críticas em throughput e eficiência energética. Isso se traduz em maior tempo de treinamento de modelos, custos de energia exponenciais e redução da capacidade de escalabilidade futura. Com workloads de IA cada vez mais complexos — especialmente aqueles que envolvem LLMs (Large Language Models) e simulações em tempo real —, manter infraestruturas desatualizadas impede o uso eficiente de pipelines de dados e de técnicas avançadas de paralelismo. O AS-8126GS-TNMR elimina essas barreiras ao integrar PCIe 5.0 x16 em todas as conexões CPU-GPU, permitindo comunicação de altíssima largura de banda com latência mínima. Além disso, sua compatibilidade com o AMD Infinity Fabric Link garante interconexão direta entre GPUs, criando uma malha de comunicação interna que potencializa o desempenho de inferência e treinamento em larga escala. Empresas que negligenciam essas atualizações tecnológicas acabam com sistemas que consomem mais energia por FLOP entregue e comprometem sua competitividade técnica. Fundamentos da solução: arquitetura de desempenho e eficiência Integração total entre CPU e GPU O coração do SuperServer AS-8126GS-TNMR está na integração entre processadores AMD EPYC SP5 e GPUs AMD Instinct MI325X/MI350X. Cada CPU se conecta às GPUs via PCIe 5.0 x16, proporcionando interconexão direta de altíssima velocidade, essencial para cargas de IA distribuídas. Essa abordagem elimina gargalos de comunicação típicos de arquiteturas anteriores e aumenta o desempenho em tarefas de treinamento e inferência. Memória de alta capacidade e largura de banda Com suporte a até 24 slots DIMM DDR5 ECC e capacidade máxima de 6 TB de memória, o sistema garante estabilidade e consistência em operações críticas. A velocidade de 6400 MT/s (para CPUs EPYC 9005) representa um salto significativo em throughput de memória, o que é vital para pipelines de dados de aprendizado profundo e análises em tempo real. Armazenamento híbrido de baixa latência A configuração padrão inclui 8 baias NVMe e 2 SATA hot-swap, combinando velocidade e resiliência. Essa arquitetura permite segmentar dados de treinamento, cache e logs de inferência, otimizando a performance geral do sistema. Além disso, os dois slots M.2 NVMe dedicados oferecem flexibilidade adicional para inicialização rápida ou armazenamento de metadados. Gerenciamento e automação corporativa Com ferramentas como SuperCloud Composer, Supermicro Server Manager (SSM) e SuperDoctor 5, o AS-8126GS-TNMR entrega visibilidade total sobre desempenho térmico, uso de energia e integridade de componentes. O novo SuperServer Automation Assistant (SAA) introduz camadas de automação que simplificam o provisionamento e monitoramento, reduzindo custos de manutenção e tempo de resposta a falhas. Implementação estratégica: consolidando HPC e IA em um único sistema A adoção do SuperServer AS-8126GS-TNMR deve ser vista como uma decisão estratégica de consolidação. Em vez de dispersar workloads em múltiplos nós menores, organizações podem centralizar o processamento em uma unidade de 8U altamente densa, diminuindo o overhead de comunicação e reduzindo custos de energia e refrigeração. Em data centers voltados para IA generativa e deep learning, a densidade de GPUs (8x MI350X ou MI325X) permite rodar simultaneamente diversos modelos complexos, reduzindo o tempo total de treinamento. Já em ambientes de HPC científico, como climatologia e modelagem de fluidos, o uso do AMD Infinity Fabric Link proporciona comunicação GPU-GPU de baixa latência, fundamental para cálculos matriciais massivos. Outro aspecto estratégico está na eficiência energética: com seis fontes redundantes Titanium de 5250W, o sistema opera com eficiência de até 96%, suportando workloads intensas sem perda de estabilidade térmica. Essa característica é essencial para data centers que buscam certificações de sustentabilidade e redução de emissões. Melhores práticas avançadas de operação e otimização Para maximizar o desempenho do AS-8126GS-TNMR,

Servidor GPU 2U NVIDIA GH200 Grace Hopper: desempenho extremo para IA generativa e HPC A integração entre CPU e GPU chegou a um novo patamar com o lançamento do DP NVIDIA GH200 Grace Hopper Superchip System, uma plataforma projetada para cargas de trabalho de IA generativa e computação de alto desempenho (HPC). Este servidor 2U combina o poder de processamento massivo da GPU NVIDIA H100 Tensor Core com a eficiência e escalabilidade do processador Grace baseado em Arm Neoverse V2, estabelecendo um novo padrão para data centers corporativos e institutos de pesquisa. O desafio estratégico da integração CPU-GPU em larga escala Nos últimos anos, a computação heterogênea tornou-se a base para IA, aprendizado profundo e HPC. No entanto, a distância física e lógica entre CPU e GPU continua sendo uma das principais barreiras de desempenho. Em arquiteturas tradicionais, o tráfego de dados via PCIe cria gargalos que limitam a eficiência energética e a largura de banda total. Esse obstáculo é crítico em workloads de IA generativa e modelos de linguagem de larga escala, nos quais bilhões de parâmetros precisam ser processados simultaneamente com latência mínima. O Grace Hopper Superchip foi desenvolvido para eliminar essa limitação. Através do NVLink Chip-2-Chip (C2C), a NVIDIA alcança uma comunicação direta entre CPU e GPU a 900 GB/s, proporcionando até 7 vezes mais largura de banda que o PCIe 5.0. Isso transforma o paradigma de computação: os dados não são apenas transferidos — são compartilhados em um espaço de memória coerente entre processadores. Consequências da inação: o custo dos gargalos de dados Ignorar a integração CPU-GPU resulta em desperdício massivo de recursos. Modelos de IA que exigem movimentação constante de grandes matrizes de dados entre CPU e GPU perdem eficiência computacional e energia. Além disso, o aumento da latência reduz o throughput total e limita o tamanho dos modelos possíveis. Em setores como pesquisa científica, engenharia assistida e análise de risco, essa limitação traduz-se em prazos mais longos e custos operacionais exponencialmente maiores. Fundamentos da solução: a arquitetura Grace Hopper O DP NVIDIA GH200 Grace Hopper Superchip System combina dois Grace CPUs de 72 núcleos com duas GPUs H100 Tensor Core em um design de alta densidade 2U. Essa integração é possível graças ao NVLink-C2C, um barramento de interconexão de alta largura de banda e baixa latência que permite comunicação direta entre as unidades. O resultado é uma arquitetura unificada que reduz significativamente a sobrecarga de transferência de dados. Além da interconexão, o sistema oferece uma estrutura de memória revolucionária: até 1248 GB de memória coerente, incluindo 960 GB de LPDDR5X ECC e 288 GB de HBM3e. Essa memória unificada é especialmente vantajosa em aplicações de Large Language Models (LLM) e treinamento de redes neurais profundas, onde o volume de parâmetros exige alta largura de banda sustentada e baixa latência de acesso. Eficiência térmica e estabilidade operacional O sistema é mantido por até 6 ventoinhas de alto desempenho com controle de velocidade PWM e sensores de temperatura que monitoram CPU e ambiente do chassi. Aliado a isso, o conjunto de 4 fontes redundantes Titanium (96%) de 2000W garante operação contínua em regimes de alta carga térmica e energética, típicos de clusters de IA. Implementação estratégica: conectividade e expansão O GH200 2U foi projetado com uma abordagem de conectividade modular. Ele oferece 3 slots PCIe 5.0 x16 e 1 x4, com suporte a controladoras de rede NVIDIA BlueField-3 e ConnectX-7. Essa configuração permite implementar GPUDirect RDMA, reduzindo a latência entre nós em ambientes distribuídos e otimizando fluxos de dados entre servidores GPU. Para armazenamento, o sistema inclui 3 baias frontais E1.S NVMe e 2 slots M.2 NVMe, ideais para sistemas operacionais, caches de inferência e bancos de dados de embeddings. Essa flexibilidade é fundamental em implementações que alternam entre inferência, fine-tuning e workloads de HPC. Melhores práticas avançadas: alinhando IA e infraestrutura Ao implantar o GH200, as organizações devem considerar três pilares críticos: coerência de memória, otimização térmica e topologia de rede. O uso do NVLink-C2C exige balanceamento cuidadoso de threads e buffers, evitando sobrecarga de comunicação entre processadores. A refrigeração deve ser ajustada com base no regime térmico específico de cada workload. E a topologia de interconexão RDMA deve ser configurada para maximizar o throughput de GPU a GPU, especialmente em clusters multi-nó. Interoperabilidade com sistemas empresariais O GH200 é certificado pela NVIDIA, o que garante compatibilidade plena com o ecossistema CUDA e frameworks como PyTorch, TensorFlow e JAX. Essa interoperabilidade facilita a adoção em ambientes corporativos já otimizados para HPC e IA, reduzindo custos de integração e tempo de implementação. Medição de sucesso: métricas de desempenho e eficiência Para avaliar o sucesso da implementação, devem ser monitorados três indicadores principais: Throughput de treinamento e inferência: medido em tokens/s ou TFLOPS sustentados. Eficiência energética: relação entre desempenho e consumo (TFLOPS/Watt). Latência interprocessual: tempo médio de comunicação CPU-GPU e GPU-GPU. Essas métricas permitem quantificar o impacto do NVLink-C2C e da arquitetura de memória unificada na eficiência operacional do cluster. Conclusão: o novo patamar da computação de IA O DP NVIDIA GH200 Grace Hopper Superchip System consolida uma visão de computação unificada que redefine os limites entre CPU e GPU. Com largura de banda sem precedentes, memória coerente de até 1,2 TB e suporte a interconectividade avançada, o sistema é uma base sólida para IA generativa, HPC e aplicações científicas críticas. Em um cenário onde o volume de dados cresce exponencialmente e a demanda por eficiência computacional é constante, o GH200 2U representa o equilíbrio ideal entre densidade, escalabilidade e estabilidade operacional. É, ao mesmo tempo, uma plataforma de pesquisa e um acelerador de negócios, capaz de sustentar a próxima geração de inteligência artificial corporativa.

4U GPU Server Supermicro com NVIDIA HGX A100: Performance Máxima para IA e HPC O cenário atual de inteligência artificial (IA) e computação de alto desempenho (HPC) exige servidores que combinem escalabilidade massiva, throughput extremo e confiabilidade inquestionável. O 4U GPU Server Supermicro com NVIDIA HGX A100 8-GPU surge como uma solução estratégica para organizações que buscam executar cargas de trabalho críticas de deep learning, análise de dados em grande escala e simulações complexas, sem comprometer desempenho, segurança ou gerenciamento operacional. Contextualização Estratégica e Desafios Críticos Com a evolução acelerada das demandas de IA generativa e modelagem de HPC, empresas enfrentam desafios como alta latência em processamento paralelo, limitações de memória GPU e riscos de downtime que podem comprometer projetos de pesquisa ou pipelines de produção. Sistemas convencionais não oferecem comunicação direta eficiente entre múltiplas GPUs, gerando gargalos de performance e desperdício de investimento em infraestrutura. Além disso, a crescente complexidade regulatória em segurança de dados e governança exige que servidores corporativos suportem autenticação robusta, monitoramento ativo e resiliência de firmware, prevenindo vulnerabilidades que poderiam impactar dados sensíveis ou interromper operações críticas. Consequências da Inação Ignorar a atualização para uma infraestrutura GPU avançada implica custos ocultos significativos. Entre eles estão baixa eficiência computacional, maior consumo de energia devido a ciclos de processamento mais longos e risco de falhas críticas durante execuções simultâneas de modelos de deep learning. O tempo perdido em debugging e ajuste de software pode gerar atrasos em lançamentos de produtos, simulações científicas e análise de dados estratégicos. Organizações que não adotam servidores com interconexão de alto desempenho entre GPUs, como o NVLINK v3.0 e NVSwitch da NVIDIA, perdem vantagens competitivas, pois não conseguem executar treinamentos de modelos em grande escala de forma otimizada, impactando a capacidade de inovação e tomada de decisão baseada em dados. Fundamentos da Solução: Arquitetura do 4U GPU Server O 4U GPU Server Supermicro integra até 8 GPUs NVIDIA HGX A100, com 40GB (HBM2) ou 80GB (HBM2e) por GPU, oferecendo largura de banda de memória massiva para cargas intensivas. A arquitetura NVLINK v3.0, combinada com NVSwitch, garante comunicação ponto a ponto entre GPUs com latência mínima, eliminando gargalos típicos de interconexão PCIe padrão. O servidor é alimentado por processadores duplos AMD EPYC™ 7003/7002, compatíveis com tecnologia AMD 3D V-Cache™, permitindo throughput massivo de dados entre CPU e GPU. A memória principal suporta até 8TB DDR4 Registered ECC 3200MHz, distribuída em 32 DIMMs, garantindo integridade e correção de erros em cargas críticas. Expansão e Armazenamento NVMe O sistema oferece 6 baías hot-swap de 2,5″ NVMe, com opção de expansão para 10 drives via 4 baías traseiras adicionais. A integração de PCIe 4.0 x16 e x8 via switch e CPUs assegura compatibilidade com controladores de alta velocidade e placas de expansão (AIOM), permitindo configurar ambientes de armazenamento flash de altíssima performance para dados temporários e modelos em treinamento. Redes e Conectividade de Alto Desempenho Para workloads que demandam GPUDirect RDMA, o servidor fornece NICs dedicadas em razão 1:1 com cada GPU, eliminando overhead de CPU e aumentando throughput de rede. Isso é crucial para clusters de deep learning distribuído, onde múltiplos nós compartilham modelos e datasets massivos em tempo real. Implementação Estratégica e Considerações Operacionais Implantar um servidor deste porte requer atenção aos detalhes de resfriamento e energia. O modelo 4U utiliza até 4 ventiladores hot-swap de 11.500 RPM e fontes redundantes de 2200W Platinum (3+1), garantindo operação contínua e mitigando risco de downtime. Considerações ambientais incluem operação entre 10°C e 35°C, com umidade relativa entre 8% e 90%, além de compliance RoHS. O gerenciamento é facilitado via Supermicro Server Manager (SSM), Power Manager (SPM), Update Manager (SUM) e SuperDoctor® 5 (SD5), com suporte IPMI 2.0, KVM-over-LAN e monitoramento completo de saúde do sistema. Esse ecossistema de software permite operações proativas, automação de alertas e manutenção remota, reduzindo custo operacional e melhorando tempo de disponibilidade. Segurança e Conformidade A plataforma inclui Trusted Platform Module (TPM) 2.0, Silicon Root of Trust (RoT) conforme NIST 800-193, boot seguro e atualizações de firmware criptografadas. Essas funcionalidades mitigam riscos de intrusão, ataques a firmware e comprometimento de dados sensíveis, alinhando-se a políticas corporativas de governança e auditoria. Melhores Práticas Avançadas Para maximizar ROI, recomenda-se alinhar alocação de GPUs a workloads específicos, balanceando treinamento de IA, inferência e simulações HPC. O uso de NVMe para datasets temporários e cache de GPU minimiza latência, enquanto monitoramento contínuo de temperatura e performance permite ajustes dinâmicos de frequência e potência via Supermicro Power Manager. Implementações em cluster podem explorar interconexões NVSwitch para compartilhamento eficiente de modelos e redução de overhead de comunicação, enquanto a segregação de tráfego de rede usando RDMA dedicada assegura throughput constante para pipelines críticos de dados. Medição de Sucesso Métricas-chave incluem throughput de treinamento (samples/s), utilização média da GPU, latência de interconexão NVLINK/NVSwitch e disponibilidade do sistema. Indicadores de saúde do hardware, como monitoramento de tensão, temperatura e velocidade de ventiladores, garantem operação contínua sem degradação de performance. Relatórios de energia e eficiência de resfriamento ajudam a otimizar custo total de propriedade (TCO). Conclusão O 4U GPU Server Supermicro com NVIDIA HGX A100 8-GPU representa a convergência ideal de desempenho extremo, confiabilidade e segurança para ambientes de HPC e IA. Ao integrar GPUs de alta capacidade, interconexão NVLINK/NVSwitch, processadores AMD EPYC de última geração e memória ECC de alta densidade, o servidor permite executar cargas críticas com máxima eficiência. Organizações que adotam esta infraestrutura ganham vantagem competitiva em projetos de deep learning, simulações científicas e análise de grandes volumes de dados, mitigando riscos operacionais e garantindo compliance rigoroso. A flexibilidade de expansão, gerenciamento avançado e recursos de segurança tornam o 4U GPU Server uma escolha estratégica para ambientes corporativos e de pesquisa de ponta. Perspectivas futuras incluem integração com orquestração de clusters HPC, escalabilidade horizontal em datacenters de IA e otimização contínua de energia e desempenho para atender às demandas crescentes de workloads massivos. O próximo passo prático envolve planejar a configuração do servidor conforme o perfil de uso, avaliando quantidade de GPUs, memória e armazenamento para

Supermicro 1U GPU com Grace Hopper Superchip: Alta Densidade e Performance em IA Introdução No cenário atual de Inteligência Artificial (IA) e Computação de Alto Desempenho (HPC), a demanda por servidores altamente densos e eficientes tem se intensificado. Organizações que implementam modelos de grande escala, como Large Language Models (LLM) e aplicações de IA generativa, enfrentam desafios significativos de desempenho, consumo energético e gerenciamento térmico. A adoção de sistemas especializados, como o Supermicro 1U GPU com NVIDIA GH200 Grace Hopper Superchip, surge como solução estratégica para otimizar recursos e acelerar cargas críticas. As organizações que não atualizam sua infraestrutura podem sofrer de latência elevada, baixa eficiência computacional e custos operacionais excessivos. Falhas em suportar workloads de IA complexos podem resultar em atrasos no desenvolvimento de produtos, perda de competitividade e aumento do risco operacional. Este artigo explora em profundidade os recursos, arquitetura e implicações estratégicas deste sistema, oferecendo insights detalhados para decisões empresariais informadas. Serão abordados os seguintes tópicos: a arquitetura Grace Hopper Superchip, a integração CPU-GPU via NVLink-C2C, estratégias de resfriamento líquido, otimização de memória e armazenamento, implementação em data centers e métricas de desempenho para IA e HPC. Desenvolvimento Problema Estratégico: Demanda por Computação Intensiva e Alta Densidade Empresas que lidam com IA de última geração enfrentam cargas de trabalho massivas que exigem throughput elevado e latência mínima. Os LLMs modernos, por exemplo, demandam não apenas GPUs poderosas, mas também grande capacidade de memória coerente e interconexão eficiente entre CPU e GPU. Servidores tradicionais não conseguem acompanhar essas demandas sem aumentar significativamente o footprint físico e o consumo de energia. Além disso, a densidade computacional é limitada em racks padrão. Sistemas 2U ou 4U podem oferecer mais espaço, mas ocupam mais área no data center e geram complexidade de gerenciamento térmico e elétrico. Nesse contexto, soluções 1U com integração avançada de CPU e GPU, como o Supermicro GH200 Grace Hopper Superchip, tornam-se essenciais. Consequências da Inação A não adoção de servidores otimizados para IA pode resultar em: 1. Ineficiência operacional: Processamento fragmentado e transferência de dados lenta entre CPU e GPU afetam a velocidade de treinamento de modelos. 2. Aumento de custos: Maior consumo energético e necessidade de racks adicionais elevam o TCO (Total Cost of Ownership). 3. Perda de competitividade: Empresas incapazes de executar LLMs em alta performance ficam atrás em inovação e tempo de lançamento. Fundamentos da Solução: Arquitetura Grace Hopper Superchip O sistema integra a CPU NVIDIA Grace e a GPU H100 em um único Superchip, comunicando-se via NVLink Chip-2-Chip (C2C). Essa interconexão de alta largura de banda e baixa latência (900GB/s) permite que dados críticos sejam trocados entre CPU e GPU sem os gargalos tradicionais de PCIe, melhorando o desempenho de modelos LLM e cargas de IA generativa. A memória coerente de até 576GB por nó (480GB LPDDR5X + 96GB HBM3) oferece capacidade suficiente para treinar e inferir modelos complexos sem recorrer a swaps frequentes para armazenamento secundário, reduzindo latência e aumentando throughput. O design 1U, com resfriamento líquido Direct-to-Chip (D2C) e até 7 ventiladores heavy-duty, garante operação eficiente mesmo sob workloads intensos, mantendo temperaturas ideais e evitando throttling da GPU. A combinação de resfriamento líquido e ventilação controlada dinamicamente é crítica para manter estabilidade em aplicações HPC prolongadas. Implementação Estratégica Para a implementação eficaz em data centers, o sistema oferece: 1. Conectividade avançada: Suporte a 2x PCIe 5.0 x16 para placas NVIDIA BlueField-3 ou ConnectX-7, permitindo integração em redes de alta velocidade e aceleração de data pipelines. 2. Armazenamento direto ao processador: Dois drives E1.S NVMe conectados diretamente à CPU, garantindo I/O ultra-rápido para dados críticos de treinamento. 3. Gerenciamento e monitoramento: BIOS AMI, controle de ACPI e monitoramento de saúde de CPU, memória e ventiladores, facilitando manutenção preventiva e mitigação de falhas. Melhores Práticas Avançadas Para maximizar o desempenho do Supermicro 1U GH200, recomenda-se: Otimização de workloads: Distribuir tarefas de IA e HPC considerando a memória coerente e a capacidade da HBM3 da GPU para minimizar transferências desnecessárias. Configuração de resfriamento: Ajustar curvas de ventiladores via PWM e monitorar sensores térmicos para manter estabilidade sem sobrecarga energética. Planejamento de expansão: Avaliar integração de BlueField-3 ou ConnectX-7 para aceleração de rede, mantendo interoperabilidade com clusters existentes. Medição de Sucesso Indicadores chave incluem: Throughput de treinamento: Medido em tokens/s ou imagens/s dependendo da aplicação de IA. Eficiência energética: Avaliar desempenho por watt consumido em workloads sustentados. Uso de memória coerente: Monitorar percentuais de LPDDR5X e HBM3 em tempo real para evitar swap desnecessário. Disponibilidade do sistema: Tempo de operação contínuo sem throttling ou interrupções térmicas. Conclusão O Supermicro 1U GPU com NVIDIA GH200 Grace Hopper Superchip representa uma solução de ponta para organizações que buscam maximizar desempenho em IA generativa, LLMs e HPC, ao mesmo tempo em que minimizam footprint físico e consumo energético. Sua arquitetura unificada CPU-GPU, memória coerente e resfriamento líquido garantem execução eficiente e previsível de workloads críticos. Empresas que adotam essa infraestrutura obtêm vantagem estratégica ao reduzir latência, aumentar throughput e melhorar eficiência operacional. A escolha de sistemas 1U com integração avançada de hardware e gerenciamento inteligente de energia é fundamental para enfrentar os desafios futuros de IA e HPC em escala corporativa. O futuro da computação de alto desempenho e IA empresarial exige sistemas que combinem densidade, resfriamento eficiente e interconectividade de alta largura de banda. O Supermicro 1U Grace Hopper Superchip entrega exatamente isso, oferecendo base tecnológica sólida para inovação e crescimento sustentável.

Infraestrutura de IA e HPC com resfriamento líquido Supermicro HGX B200 O avanço da computação de alto desempenho e da inteligência artificial exige uma infraestrutura que vá além da mera potência de processamento. Em um cenário onde o treinamento de modelos generativos, a simulação científica e o processamento de dados financeiros se tornaram pilares da inovação, a Supermicro Gold Series com NVIDIA HGX B200 e resfriamento líquido OCP Inspired surge como um marco de engenharia. Este sistema 4U não é apenas um servidor — é uma plataforma completa de computação densa, projetada para IA, HPC e workloads científicos de próxima geração. Combinando duas CPUs Intel Xeon 6900 de até 128 núcleos com oito GPUs NVIDIA B200 SXM e interconexão NVLink/NVSwitch, o sistema alcança níveis de desempenho e eficiência térmica que redefinem o equilíbrio entre poder computacional e sustentabilidade. O design OCP Inspired garante interoperabilidade e escalabilidade em ambientes corporativos e institucionais que buscam densidade máxima e confiabilidade. O desafio estratégico da infraestrutura moderna de IA e HPC As empresas que operam em setores como pesquisa científica, finanças, bioinformática e veículos autônomos enfrentam um dilema crescente: como suportar o crescimento exponencial das cargas de trabalho de IA e HPC sem comprometer eficiência energética, estabilidade térmica e integridade de dados? O aumento da densidade computacional e da largura de banda de interconexão exige arquiteturas térmicas mais avançadas. O uso de GPUs de última geração, como a NVIDIA B200, que sozinha pode consumir centenas de watts sob carga, multiplica o desafio. O tradicional arrefecimento por ar já não é suficiente para manter estabilidade térmica e desempenho consistente em clusters de alta densidade. A ausência de um design orientado a resfriamento líquido direto (D2C) e a integração rack-scale pode gerar instabilidade térmica, degradação de desempenho e aumento significativo de custos operacionais. O resultado é um ciclo de ineficiência que compromete tanto o retorno sobre o investimento quanto a sustentabilidade operacional. Consequências da inação em ambientes de IA e HPC Ignorar a evolução térmica e arquitetural da infraestrutura tem implicações diretas. Em workloads de IA generativa ou treinamento de LLMs, qualquer flutuação térmica pode reduzir o clock efetivo das GPUs e CPUs, resultando em perda de performance por throttling térmico. Além disso, a dissipação ineficiente acelera o desgaste de componentes críticos e compromete a confiabilidade de longo prazo. No contexto de HPC e pesquisa científica, o custo de downtime ou falha de um nó em um cluster de simulação é exponencial. Cada segundo de indisponibilidade representa perda de produtividade computacional e impacto em cronogramas de pesquisa. Organizações que mantêm data centers baseados exclusivamente em arrefecimento a ar enfrentam também um problema de densidade: a limitação física da dissipação térmica impede a expansão horizontal sem reengenharia completa do ambiente. Por isso, a transição para infraestruturas líquidas — como o sistema 4U Supermicro — tornou-se um fator estratégico e não apenas técnico. Fundamentos da solução: arquitetura OCP e resfriamento líquido direto O DP Intel 4U Liquid-Cooled System with NVIDIA HGX B200 foi projetado com base em três pilares técnicos: integração completa em rack, arquitetura OCP Inspired e resfriamento líquido direto a chip (D2C Cold Plate). Essa combinação redefine a eficiência térmica e o desempenho sustentado. Com suporte a duas CPUs Intel Xeon 6900 — até 128 núcleos e 504 MB de cache por processador — e oito GPUs NVIDIA HGX B200 SXM com 1.4 TB de memória total, o sistema oferece uma densidade de computação que antes exigia múltiplos servidores. A interconexão entre GPUs via NVLink e NVSwitch elimina gargalos de comunicação interna, permitindo que os modelos de IA e HPC operem em escalas massivas de dados. O subsistema de memória também se destaca: 24 slots DDR5 ECC RDIMM/MRDIMM de até 8800 MT/s, garantindo integridade de dados e largura de banda de memória proporcional à escala de processamento. Esse equilíbrio entre CPU, GPU e memória é essencial para workloads como LLMs, simulações científicas e treinamento de modelos multimodais. Interconexão e expansão em nível de rack Com 10 slots PCIe 5.0 x16 LP e 2 FHHL, o sistema oferece flexibilidade para integrar redes de baixa latência, armazenamento NVMe adicional ou controladoras específicas. O design OCP Inspired garante interoperabilidade com soluções de rack líquido completas, permitindo que a infraestrutura seja entregue como um ecossistema pronto para operação, com cabeamento, bomba e manifold otimizados para fluxo térmico e redundância. Implementação estratégica: densidade, segurança e gerenciamento unificado Um diferencial crucial da Supermicro Gold Series é a integração de ferramentas de gerenciamento unificado — incluindo SuperCloud Composer, Server Manager (SSM) e SuperServer Automation Assistant — que proporcionam controle e automação de toda a infraestrutura, do nível de firmware até a camada de orquestração. Do ponto de vista de segurança, a plataforma é compatível com NIST 800-193, incorporando Silicon Root of Trust, Secure Boot, Firmware Assinado e Recuperação Automática. Em um contexto de IA e HPC, onde a integridade do firmware e da cadeia de suprimentos é crítica, esses recursos reduzem o risco de ataques persistentes e comprometimento de ambiente. A redundância energética também é parte da arquitetura estratégica. O sistema conta com quatro fontes Titanium Level de 6600W (2+2), com eficiência superior a 96%. Isso assegura estabilidade mesmo em operações contínuas de alta carga, mantendo consumo otimizado e confiabilidade em nível de missão crítica. Melhores práticas avançadas para operação líquida em larga escala A adoção de infraestrutura líquida requer uma abordagem metodológica que vai além da substituição de componentes. É essencial planejar o ciclo térmico completo — desde a temperatura de entrada do fluido até a dissipação no rack. A Supermicro, ao integrar o sistema completo, elimina as variáveis de risco mais comuns em implementações customizadas. Entre as práticas recomendadas estão: controle granular de temperatura por sensor, redundância hidráulica, validação de estanqueidade e calibração dinâmica das bombas em função da carga térmica. O sistema também é otimizado para operar entre 10°C e 35°C, assegurando desempenho linear mesmo sob variação de temperatura ambiente. Do ponto de vista de manutenção, o design hot-swap dos 8 drives NVMe U.2 e 2 M.2 frontais simplifica

QNAP TS-364: o NAS híbrido que redefine desempenho, virtualização e segurança empresarial Introdução No cenário atual de transformação digital, o armazenamento corporativo precisa equilibrar três pilares fundamentais: desempenho, confiabilidade e flexibilidade. O QNAP TS-364 surge como uma resposta técnica sofisticada a esse desafio, combinando arquitetura híbrida com cache NVMe, virtualização e redundância de dados avançada. Voltado para pequenas e médias empresas que exigem eficiência sem abrir mão de segurança e escalabilidade, o TS-364 redefine a categoria dos NAS compactos ao integrar hardware robusto com software empresarial maduro — o QTS 5 ou o QuTS hero, baseado em ZFS. Este artigo aprofunda-se nas razões pelas quais o TS-364 representa um novo patamar em armazenamento de rede, analisando seus fundamentos arquitetônicos, implicações de negócio e benefícios técnicos para ambientes que demandam confiabilidade contínua e alta performance. O problema estratégico: o gargalo do armazenamento em PMEs modernas À medida que pequenas e médias empresas adotam fluxos de trabalho baseados em nuvem, backup automatizado e colaboração remota, surgem novas exigências de desempenho e segurança. Soluções NAS convencionais, muitas vezes limitadas por barramentos lentos ou ausência de cache inteligente, tornam-se gargalos invisíveis que comprometem produtividade e disponibilidade. A complexidade aumenta quando workloads passam a incluir máquinas virtuais, servidores de arquivos intensivos e bancos de dados. Sem mecanismos de aceleração de leitura e escrita, os sistemas enfrentam latências elevadas, impactando a experiência do usuário e o tempo de resposta de aplicações críticas. O TS-364 foi projetado para atacar precisamente esses pontos de estrangulamento — oferecendo uma infraestrutura otimizada que combina discos SATA tradicionais com duas unidades SSD NVMe M.2 PCIe Gen3 para cache, entregando um salto significativo na responsividade do sistema. Consequências da inação: riscos da subutilização de arquitetura híbrida Empresas que mantêm infraestruturas de armazenamento baseadas exclusivamente em HDDs enfrentam custos ocultos expressivos. A degradação do desempenho em picos de demanda, o aumento do tempo de acesso a arquivos e o desgaste prematuro dos discos são sintomas diretos de ausência de cache otimizado e balanceamento inteligente de dados. Além disso, a falta de tolerância a falhas e redundância de metadados — características nativas do ZFS — expõe os dados corporativos a riscos de corrupção silenciosa, especialmente em backups incrementais ou cargas de trabalho com alta simultaneidade. Ignorar o potencial da arquitetura híbrida é, portanto, não apenas uma questão técnica, mas estratégica: implica renunciar à previsibilidade operacional e à confiabilidade que o ambiente corporativo exige para decisões críticas de longo prazo. Fundamentos da solução: a engenharia do QNAP TS-364 Arquitetura híbrida e aceleração NVMe O TS-364 combina três baias SATA de 3,5” com duas interfaces M.2 NVMe PCIe Gen3, criando uma estrutura híbrida capaz de operar tanto como cache de aceleração quanto como volume de armazenamento em camadas. Essa abordagem reduz significativamente a latência de acesso e melhora o desempenho de I/O aleatório — um fator crítico em operações de virtualização e bancos de dados. O uso inteligente de cache NVMe não apenas aumenta a performance, mas também reduz o desgaste dos HDDs, prolongando sua vida útil e diminuindo custos de manutenção. Essa sinergia entre velocidade e durabilidade é um exemplo claro de como engenharia de hardware e eficiência operacional convergem em benefício do negócio. Processamento Intel e eficiência de virtualização Equipado com um processador Intel Celeron N5095 de quatro núcleos e 2,9 GHz, o TS-364 oferece desempenho consistente para múltiplas tarefas simultâneas. Essa CPU integra gráficos Intel UHD, permitindo transcodificação de vídeo em tempo real, e suporta até 16 GB de RAM DDR4, garantindo fluidez em workloads de containers, máquinas virtuais e servidores de mídia. O suporte à Intel Virtualization Technology (VT-x) permite executar ambientes de virtualização com isolamento e segurança, essenciais para empresas que consolidam múltiplos serviços em um único hardware. No contexto empresarial, isso se traduz em menor consumo energético e maior densidade de serviços por dispositivo. Dupla pilha de software: QTS 5 e QuTS hero Um dos grandes diferenciais do TS-364 é o suporte tanto ao sistema QTS 5 — baseado em EXT4, voltado à versatilidade e usabilidade — quanto ao QuTS hero, que utiliza o arquitetura ZFS para máxima integridade de dados. O ZFS introduz funcionalidades avançadas como verificação de integridade em tempo real, compressão inline, snapshots e deduplicação. Esses recursos mitigam riscos de corrupção silenciosa e otimizam o uso de espaço, características fundamentais em ambientes corporativos onde cada gigabyte impacta custos de armazenamento. Com o QuTS hero, o TS-364 transcende o conceito tradicional de NAS doméstico e se aproxima de soluções empresariais de alta confiabilidade, tornando-se adequado para aplicações que exigem consistência de dados contínua. Implementação estratégica e interoperabilidade O TS-364 oferece conectividade 2.5GbE nativa, garantindo throughput até 2,5 vezes superior ao padrão Gigabit, além de suportar agregação de link e jumbo frames para redes corporativas de alta densidade. Essa compatibilidade com infraestruturas Ethernet modernas o torna ideal para ambientes de backup centralizado, sincronização remota e replicação. Sua interoperabilidade se estende a múltiplos protocolos — SMB, AFP, NFS, iSCSI e FTP — facilitando a integração em ecossistemas heterogêneos. O suporte ao Hybrid Backup Sync (HBS 3) permite replicação inteligente entre NAS, servidores e nuvens públicas, como AWS, Azure e Google Cloud. Melhores práticas avançadas Proteção de dados com snapshots e RAID Para assegurar continuidade operacional, o TS-364 suporta múltiplas configurações RAID — incluindo 0, 1, 5, 6 e 10 —, além de snapshots baseados em bloco para restauração instantânea. Essa abordagem combina redundância física com resiliência lógica, mitigando riscos de perda acidental ou ataques de ransomware. Otimização de desempenho com cache inteligente Em cenários empresariais, o cache SSD deve ser configurado com base em análise de padrão de I/O. O QTS permite monitorar métricas em tempo real e ajustar políticas de cache, priorizando workloads críticos. A abordagem híbrida do TS-364 é particularmente eficaz para empresas que executam múltiplos serviços simultaneamente, de bancos de dados a virtualização de desktops. Escalabilidade e expansão modular Quando a demanda por capacidade cresce, o TS-364 pode ser conectado a gabinetes de expansão QNAP, como o TR-004 ou TL-D800C, ampliando o armazenamento sem necessidade de

O futuro do armazenamento para HPC e IA: dados, estratégias e evolução tecnológica Por Vircos Insights Técnicos Introdução: A nova economia dos dados impulsiona o futuro do armazenamento O crescimento do mercado de armazenamento para HPC e IA não é apenas uma consequência do avanço tecnológico, mas um reflexo direto da transformação digital em larga escala. À medida que modelos de linguagem, simulações científicas e análises preditivas se tornam pilares da inovação, o armazenamento emerge como o elemento mais crítico – e desafiador – da infraestrutura de dados moderna. Empresas de todos os setores enfrentam um cenário em que o volume e a velocidade dos dados aumentam exponencialmente, e a eficiência com que esses dados são armazenados, acessados e processados pode definir a vantagem competitiva. Segundo a Hyperion Research, o armazenamento representa hoje cerca de 21% de todos os investimentos em HPC, superando inclusive a taxa de crescimento de outros componentes como computação e rede. Ignorar a evolução estrutural do armazenamento significa comprometer a base de desempenho e escalabilidade que sustenta aplicações de IA e HPC. Este artigo aprofunda os números, tendências e estratégias que estão redefinindo o setor, analisando desde o hardware até a camada de software e o impacto da migração para arquiteturas definidas por software e nuvem híbrida. O problema estratégico: crescimento explosivo e complexidade crescente O armazenamento sempre foi visto como um componente auxiliar da infraestrutura de alto desempenho. Hoje, essa visão está ultrapassada. O que antes era apenas uma questão de capacidade e custo por gigabyte tornou-se uma discussão sobre latência, throughput, topologia de camadas e integração com workloads de IA. De acordo com a Hyperion, o mercado de HPC investiu US$ 6,3 bilhões em armazenamento adicional em 2023, representando 21% de todo o gasto local. E esse percentual deve ultrapassar 22,4% até 2028. Em paralelo, o mercado global de armazenamento de dados – incluindo TI corporativa – movimentou US$ 218 bilhões em 2024 e deve chegar a US$ 774 bilhões até 2032, com um crescimento anual composto de 17,2%. Esse crescimento mais acelerado no setor de HPC e IA evidencia um ponto central: os sistemas de armazenamento tornaram-se o principal gargalo e o principal diferencial competitivo da era da IA. O desafio está na convergência de duas forças opostas: a necessidade de maior desempenho (para IA generativa e simulações de larga escala) e a pressão por redução de custo e consumo energético. Isso força fornecedores e empresas a repensarem a hierarquia de armazenamento – substituindo estruturas de duas camadas por arquiteturas de quatro ou cinco níveis, onde cada camada cumpre um papel específico no ciclo de vida do dado. Consequências da inação: gargalos, custos e riscos competitivos A inércia tecnológica em relação ao armazenamento é hoje uma das maiores ameaças à competitividade em ambientes de HPC e IA. Quando uma organização falha em alinhar a infraestrutura de dados ao perfil de suas cargas de trabalho, surgem gargalos que se manifestam em três dimensões: tempo de inferência, custo por operação e eficiência energética. Além disso, a falta de uma arquitetura escalável de armazenamento afeta diretamente o ciclo de desenvolvimento de IA, desde o treinamento até a inferência. Empresas que permanecem presas a modelos baseados apenas em HDDs ou em soluções monolíticas de NAS enfrentam prazos de execução prolongados e custos operacionais mais altos. A pressão sobre os fabricantes – com prazos de entrega de HDDs nearline ultrapassando 52 semanas, segundo a TrendForce – reforça a urgência de diversificar estratégias de suprimento e investir em tecnologias emergentes como SSDs NVMe e armazenamento definido por software (SDS). Fundamentos da solução: a ascensão do armazenamento híbrido e escalável O ponto de inflexão do setor é a transição do armazenamento giratório (HDD) para o estado sólido NVMe. Embora os SSDs ainda custem de quatro a cinco vezes mais por gigabyte, eles entregam taxas de transferência e latências que redefinem o padrão de desempenho. O mercado global de SSDs foi avaliado em US$ 19,1 bilhões em 2023 e deve atingir US$ 331 bilhões até 2034, com CAGR de 17,6%. Essa expansão não é apenas quantitativa, mas qualitativa: estamos vendo SSDs de até 128 TB, que alteram profundamente o design dos data centers de HPC e IA. Contudo, a adoção massiva de SSDs não significa o fim dos HDDs. Para cargas de trabalho de IA, especialmente no treinamento de modelos e checkpoints, os HDDs nearline continuam oferecendo um equilíbrio valioso entre custo e capacidade. Essa coexistência dá origem a uma arquitetura híbrida, onde cada camada – NVMe, SSD, HDD e fita – é utilizada de forma estratégica conforme o perfil de I/O e retenção. Além do hardware, cresce a importância do software de orquestração de dados. Soluções como Lustre, IBM Storage Scale e WekaFS oferecem sistemas de arquivos paralelos capazes de lidar com IOPS massivos, enquanto NAS escaláveis baseados em NFS e OneFS continuam relevantes para operações de acesso distribuído. Essa dualidade reflete a diversidade das cargas de trabalho modernas – entre dados científicos, inferência em tempo real e pipelines de treinamento intensivo. Implementação estratégica: integrando hardware e software sob uma mesma lógica de dados Os dados da Hyperion mostram que 75% dos sites de HPC e IA obtêm seu armazenamento local diretamente de fornecedores de sistemas integrados – como Dell Technologies (22,3%), IBM (19,1%), Lenovo (8,5%), Fujitsu (5,3%) e HPE Cray (5,3%). Entre os fornecedores independentes, a NetApp lidera com 8,5%, seguida pela DDN com 7,4%. Esse cenário reflete uma preferência clara por soluções turnkey, em que hardware e software são entregues como um ecossistema unificado e testado para workloads de alta intensidade. Para workloads em nuvem, a lógica muda. As cargas de HPC e IA hospedadas em provedores cloud dedicam mais de 33% do orçamento ao armazenamento, comparado a 21% nos ambientes locais. Essa diferença reflete o impacto direto de arquiteturas efêmeras e o custo da persistência de dados em ambientes virtualizados. O crescimento do armazenamento “scratch” – que saltou de 8% para quase 14% do gasto total – indica a importância crescente da performance temporária para pipelines

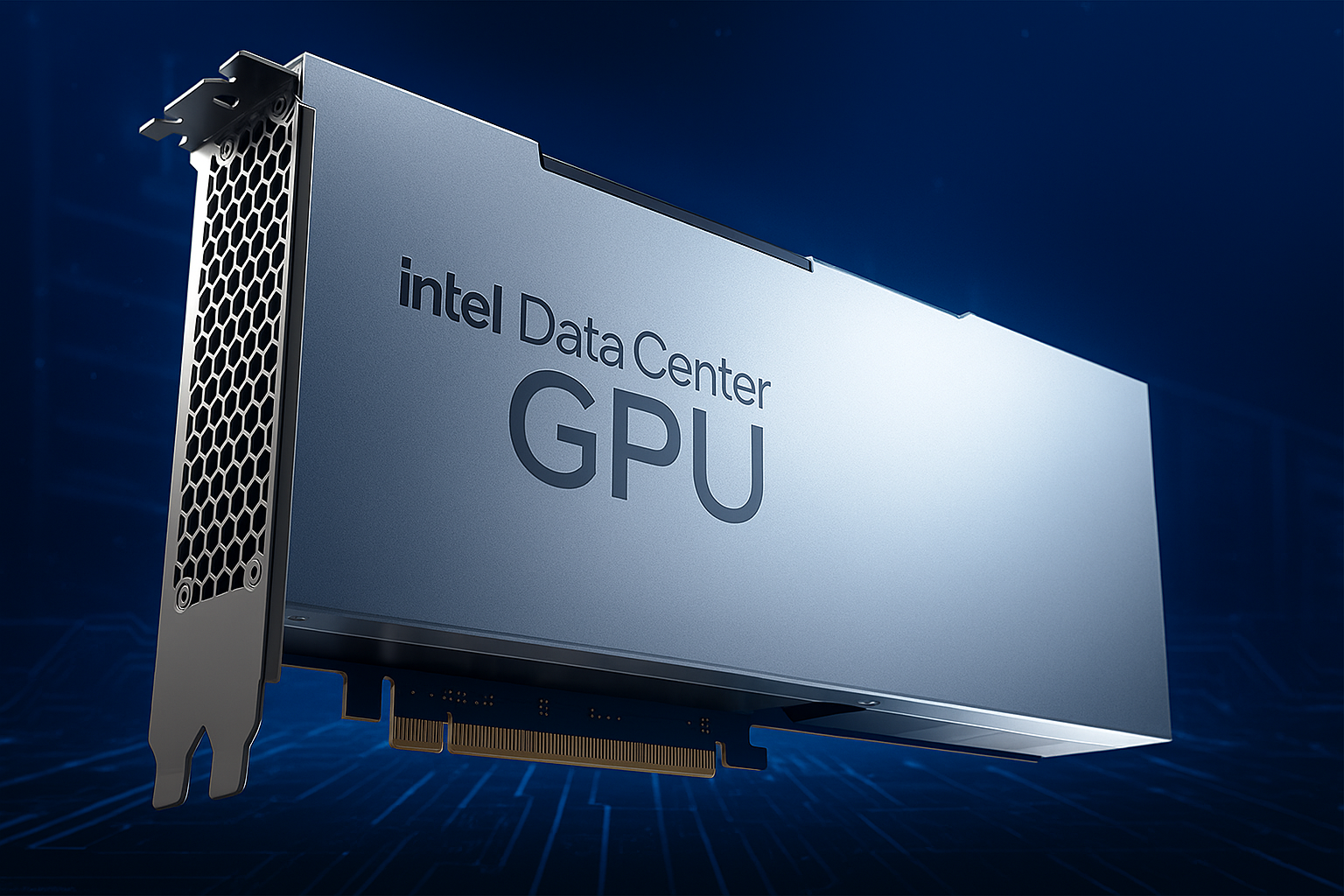

Introdução: a nova fronteira da eficiência em IA A revolução da inteligência artificial está passando por uma inflexão estratégica. Depois de anos de foco quase exclusivo no treinamento de modelos massivos, a indústria agora se volta para o próximo desafio: a inferência eficiente em larga escala. Neste novo cenário, a capacidade de processar volumes imensos de tokens, consultas e interações com o mínimo consumo energético possível tornou-se o novo campo de batalha da inovação em silício. É nesse contexto que a Intel apresenta a GPU Crescent Island, projetada com a microarquitetura Xe3P e equipada com 160 GB de memória LPDDR5X, um componente geralmente associado a dispositivos móveis e PCs. A decisão reflete uma mudança de paradigma: otimizar o desempenho por watt é agora tão importante quanto maximizar o throughput bruto. As empresas que operam data centers dedicados à IA sabem que cada watt conta. O consumo energético crescente dos aceleradores modernos, combinado com o custo de infraestrutura de resfriamento, está forçando uma revisão completa das estratégias de hardware. A Crescent Island surge como uma resposta pragmática a esse desafio — uma proposta que privilegia eficiência, escalabilidade e custo-benefício em um mercado onde o equilíbrio entre performance e sustentabilidade se tornou decisivo. O problema estratégico: a escalada de consumo energético na inferência de IA A transição da IA generativa para a inferência em tempo real trouxe consigo um novo tipo de pressão sobre as infraestruturas de data center. Se o treinamento de modelos exige poder computacional concentrado, a inferência exige distribuição massiva e disponibilidade contínua. Cada solicitação a um modelo de linguagem, cada resposta de um agente de IA, representa um ciclo computacional adicional. As GPUs tradicionais — otimizadas para o treinamento — foram projetadas para picos de desempenho, não para eficiência constante. Isso cria um problema estrutural: data centers enfrentam custos energéticos e térmicos exponenciais à medida que o uso da IA se populariza. O resfriamento de aceleradores de alta densidade tornou-se um gargalo operacional e econômico. A Intel reconhece esse desequilíbrio e, com a Crescent Island, propõe uma arquitetura que devolve a relação desempenho-energia ao centro da equação. A escolha de uma memória LPDDR5X, de baixo consumo, e uma microarquitetura Xe3P orientada à eficiência, reflete um novo realismo técnico: a IA precisa ser sustentável em escala. Consequências da inação: o custo de ignorar a eficiência Empresas que insistirem em utilizar aceleradores de treinamento para tarefas de inferência enfrentarão três consequências inevitáveis. Primeiro, ineficiência operacional, pois cada watt desperdiçado multiplica o custo de operação por rack. Segundo, restrições térmicas, que exigem sistemas de refrigeração mais caros e complexos, muitas vezes com resfriamento líquido. E terceiro, desequilíbrio de ROI, já que o custo de manter a infraestrutura supera o ganho obtido com as aplicações de IA. A inferência em escala global — como em assistentes inteligentes, IA agêntica ou análises em tempo real — não pode depender de arquiteturas que foram concebidas para o treinamento. A falta de eficiência energética não é apenas um problema técnico: é uma limitação de negócio. Ao propor a Crescent Island como uma GPU projetada para eficiência operacional contínua, a Intel reconhece que o futuro da IA não será movido apenas por potência, mas por inteligência na alocação de recursos computacionais. Fundamentos da solução: arquitetura Xe3P e memória LPDDR5X A arquitetura Xe3P é uma evolução direta da Xe3 — a base usada nas CPUs Panther Lake da Intel — mas adaptada para cargas de inferência em larga escala. A principal diferença está na otimização para desempenho por watt, uma métrica que se tornou central no design de chips voltados à IA. A GPU Crescent Island virá equipada com 160 GB de LPDDR5X, uma escolha que desafia o paradigma tradicional do uso de HBM (High Bandwidth Memory) em aceleradores de ponta. Enquanto a HBM4 domina o espaço das GPUs de treinamento, oferecendo até 1 TB de capacidade e larguras de banda colossais, seu custo e consumo energético são substancialmente mais altos. A LPDDR5X, por outro lado, foi originalmente projetada para dispositivos móveis e PCs, atingindo velocidades de até 14,4 Gbps por pino. Sua adoção em uma GPU de data center indica uma mudança filosófica: sacrificar largura de banda máxima em troca de eficiência e densidade energética otimizada. Essa decisão é tecnicamente audaciosa, mas estrategicamente sólida para workloads de inferência, onde o throughput é importante, mas o consumo energético é crítico. A Intel precisará, naturalmente, de uma topologia de interconexão inteligente para conectar múltiplos módulos LPDDR5X à GPU, garantindo paralelismo de acesso e integridade de dados. Essa implementação provavelmente se apoiará em técnicas já testadas com o EMIB (Embedded Multi-Die Interconnect Bridge) e o Foveros, tecnologias de empacotamento que a empresa dominou desde a GPU Ponte Vecchio. Implementação estratégica: eficiência e heterogeneidade Como destacou Sachin Katti, CTO da Intel, “escalar cargas de trabalho complexas requer sistemas heterogêneos que combinem o silício certo com a tarefa certa”. Essa visão orienta a arquitetura da Crescent Island: uma GPU especializada para inferência, inserida em um ecossistema de componentes interconectados que distribuem o trabalho de forma inteligente. Essa heterogeneidade é essencial para lidar com o novo paradigma de IA agêntica, em que múltiplas instâncias de IA interagem em tempo real, muitas vezes em dispositivos de borda e servidores distribuídos. Nessas condições, eficiência térmica e energética são tão estratégicas quanto a potência de cálculo. A implementação da Crescent Island em data centers corporativos exigirá uma revisão das práticas tradicionais de orquestração de workloads. O desafio não está apenas em integrar a GPU, mas em redesenhar as políticas de agendamento e alocação de recursos para maximizar o desempenho por watt. Plataformas abertas, como o OpenVINO da própria Intel, podem desempenhar papel fundamental nessa integração, ao permitir que os workloads de inferência sejam distribuídos de forma otimizada entre CPU, GPU e aceleradores dedicados. Melhores práticas avançadas: equilibrando largura de banda e consumo O trade-off central da Crescent Island é claro: menor largura de banda de memória em troca de maior eficiência energética. Para extrair o máximo dessa arquitetura, será necessário adotar práticas avançadas de

Resfriamento de precisão em IA: o que a manufatura aditiva dos semicondutores pode ensinar Por Scott Green — 15 de outubro de 2025 Introdução O avanço da inteligência artificial (IA) trouxe consigo uma pressão inédita sobre a infraestrutura de data centers. O aumento da densidade de potência, o uso massivo de GPUs e a demanda por alta performance colocam o gerenciamento térmico no centro das estratégias de engenharia de TI. Mas há um setor que domina a arte do controle térmico há décadas: a indústria de semicondutores. Ao observar o modo como o setor de equipamentos de capital de semicondutores (semicap) utiliza a manufatura aditiva (MA) para alcançar resfriamento de alta precisão, emerge um modelo que pode transformar a forma como projetamos e operamos infraestruturas de IA. Essa convergência entre manufatura de chips e data centers inteligentes representa mais que uma curiosidade tecnológica — é uma nova fronteira de eficiência e estabilidade operacional. Este artigo explora como os princípios de resfriamento e design térmico dos semicondutores podem ser aplicados à infraestrutura de IA, oferecendo um panorama técnico e estratégico sobre o futuro do gerenciamento térmico de precisão em ambientes de alta densidade computacional. O problema estratégico: calor como gargalo da evolução da IA A expansão acelerada das aplicações de IA, especialmente nos últimos 24 meses, criou um novo tipo de infraestrutura: o data center orientado à IA. Nele, os clusters de GPUs exigem uma densidade de potência por rack muito superior à de infraestruturas tradicionais, elevando os desafios de dissipação térmica a níveis críticos. Essa pressão térmica não é apenas uma questão de eficiência energética. O superaquecimento impacta diretamente a estabilidade do sistema, reduz a vida útil dos componentes e impõe limites à escalabilidade. À medida que os dies se tornam mais complexos e as velocidades de clock aumentam, o controle de temperatura passa de um detalhe de engenharia para uma variável estratégica de negócio. Em essência, o calor tornou-se o novo gargalo da inovação em IA. Organizações que não enfrentarem esse desafio com soluções precisas de engenharia térmica arriscam reduzir drasticamente o retorno sobre investimento (ROI) em infraestrutura de computação acelerada. Consequências da inação Ignorar a gestão térmica de precisão é comprometer a performance e a resiliência de toda a operação. Sistemas de resfriamento convencionais, baseados em ventoinhas e trocadores de calor genéricos, foram projetados para cargas distribuídas — não para clusters de IA com consumo energético e densidade térmica concentrados. O resultado é uma espiral de ineficiência: mais energia gasta em refrigeração, ciclos de manutenção mais curtos e degradação progressiva dos componentes. Em data centers que operam 24×7, uma pequena variação térmica pode representar milhares de dólares em perdas anuais de eficiência e desgaste prematuro de GPUs. Além do custo direto, há o impacto indireto na confiabilidade operacional. O controle térmico impreciso aumenta o risco de falhas intermitentes, acelera o envelhecimento de interconexões e reduz o desempenho sustentado em aplicações críticas de IA, como inferência em tempo real ou treinamento de modelos de larga escala. Fundamentos da solução: aprendendo com os semicondutores O setor de semicondutores domina há décadas o gerenciamento térmico de alta precisão. Máquinas de litografia, deposição e gravação operam em margens minúsculas, onde vibração e variação de temperatura de milésimos de grau podem comprometer um lote inteiro de produção. Para lidar com esse desafio, a indústria de semicap adotou a manufatura aditiva (MA) como pilar central de inovação. Essa abordagem permite projetar e fabricar sistemas de resfriamento sob medida, otimizados para geometria, fluxo e transferência de calor. Ao contrário de componentes convencionais, os trocadores de calor produzidos via impressão 3D permitem controle preciso do fluxo de fluidos diretamente pela forma física do componente. Em vez de depender de coletores ou válvulas externas, a própria estrutura interna — definida digitalmente e produzida em metal — direciona o fluxo térmico de maneira eficiente. Essa filosofia de design orientada pela geometria abre novas possibilidades para o resfriamento líquido e a dissipação térmica em larga escala, essenciais para data centers de IA. Implementação estratégica: manufatura aditiva aplicada ao resfriamento de IA Na infraestrutura de IA, o uso da manufatura aditiva em sistemas de resfriamento possibilita criar circuitos paralelos e independentes dentro de uma unidade de distribuição de refrigerante (CDU). Essa configuração descentralizada permite o balanceamento térmico dinâmico entre múltiplos trocadores de calor compactos, cada um ajustável conforme a demanda em tempo real. Ao integrar telemetria de GPU e sensores de temperatura, a CDU pode monitorar e redistribuir o resfriamento de forma inteligente. Isso reduz significativamente o desperdício energético, além de permitir a personalização do gerenciamento térmico conforme a carga de trabalho. Esse nível de controle é análogo ao gerenciamento térmico ativo já praticado nas máquinas de produção de chips, agora transposto para o ambiente do data center. Outro aspecto relevante é o avanço nos processos de manufatura. Técnicas como a Laser Powder Bed Fusion (LPBF) — fusão a laser em leito de pó — já permitem a fabricação de peças metálicas com quase 100% de densidade, eliminando antigos problemas de porosidade e tornando a impressão 3D de metais viável em escala industrial. Ligas de alumínio, aço inoxidável e titânio são amplamente utilizadas, com desempenho térmico e mecânico comprovados. Resfriamento paralelo e geometria otimizada O conceito de resfriamento paralelo em massa, habilitado pela geometria interna das peças impressas, oferece ganhos significativos. Em vez de canalizar o fluido de forma sequencial, como nos sistemas tradicionais, a manufatura aditiva permite distribuir o fluxo simultaneamente entre múltiplos canais microestruturados, otimizando a transferência de calor e reduzindo gradientes térmicos. Essa arquitetura elimina pontos quentes e aumenta a uniformidade térmica, um requisito essencial para manter a integridade de GPUs de alta densidade. O resultado é uma infraestrutura de IA mais estável, capaz de operar em regimes contínuos e sustentados de alta performance. Melhores práticas avançadas: engenharia de materiais e design térmico inteligente O material escolhido define não apenas a eficiência térmica, mas também a durabilidade e o custo de manutenção do sistema. Ligas de cobre e alumínio continuam predominantes, mas OEMs já exploram o

IA e HPC: o imperativo humano por trás da revolução computacional A convergência entre Inteligência Artificial (IA) e Computação de Alto Desempenho (HPC) marca um ponto de inflexão histórico na forma como ciência, indústria e governo produzem conhecimento e inovação. Essa transição, impulsionada por avanços em hardware, algoritmos e modelos generativos, exige mais do que infraestrutura: requer pessoas qualificadas, liderança estratégica e colaboração em escala nacional. Introdução: quando IA e HPC se tornam indissociáveis Vivemos um momento em que a capacidade computacional e a inteligência algorítmica se fundem, redefinindo as fronteiras do possível. À medida que a IA e o HPC convergem, surge uma nova paisagem onde a aceleração científica e o avanço tecnológico se tornam mutuamente dependentes. No entanto, essa fusão só pode gerar benefícios reais se for acompanhada por uma estratégia humana robusta — uma força de trabalho capacitada e alinhada aos objetivos nacionais de inovação e segurança. O desafio não é apenas técnico. É estrutural, educacional e organizacional. A história mostra que o progresso em computação avançada sempre foi fruto de investimentos contínuos e coordenação estratégica entre setores público e privado. Hoje, essa lógica se intensifica, pois o domínio da IA aplicada à HPC determinará o ritmo de descoberta científica e a soberania tecnológica das nações. Ignorar esse imperativo humano seria permitir que a própria tecnologia se tornasse um fim em si mesma — uma correnteza sem timoneiro. É exatamente essa metáfora que Doug Eadline traz: estamos diante de um rio de inovação turbulento, e navegar nele exige mais do que máquinas poderosas — exige tripulações preparadas. O problema estratégico: tecnologia sem pessoas é inovação sem direção O maior risco na corrida global pela liderança em IA e HPC não está na falta de hardware, mas na ausência de pessoas capazes de entender, integrar e direcionar seu potencial. O desenvolvimento de supercomputadores e modelos de IA de larga escala cria uma demanda exponencial por profissionais com domínio em aprendizado de máquina, engenharia de dados, física computacional e ética algorítmica. Historicamente, o Departamento de Energia dos Estados Unidos (DOE) tem sido o eixo desse ecossistema, impulsionando a pesquisa em energia de fusão, ciência dos materiais e segurança nacional. Mas a infraestrutura tecnológica criada pelo DOE só produziu impacto porque foi acompanhada de uma base humana sólida — cientistas, engenheiros e técnicos formados sob uma cultura de inovação colaborativa. O mesmo princípio se aplica à era da IA: a tecnologia avança apenas até onde a competência humana a conduz. Sem o desenvolvimento de competências multidisciplinares e a integração entre academia, indústria e governo, o avanço técnico pode se tornar fragmentado, com aplicações limitadas e pouco retorno científico ou econômico. Em outras palavras, IA e HPC sem pessoas qualificadas resultam em poder computacional desperdiçado. Consequências da inação: o custo do déficit humano em inovação Não investir no fator humano tem um custo invisível, mas devastador. Sistemas de IA e HPC exigem integração complexa entre hardware, software e dados — um ecossistema que depende da colaboração e da compreensão entre especialistas de diferentes áreas. A falta de investimento em capacitação e coordenação resulta em subutilização de recursos e atrasos em projetos estratégicos. Além disso, há uma consequência competitiva: nações que não estruturarem políticas robustas para formar e reter talentos em IA e HPC perderão sua posição na cadeia global de inovação. Em contextos como defesa, energia e pesquisa científica, essa defasagem se traduz em dependência tecnológica e vulnerabilidade estratégica. A IA não evolui de maneira autônoma em benefício da sociedade. Sem uma orientação humana clara, a tecnologia pode seguir caminhos desalinhados aos objetivos científicos e éticos. Portanto, a ausência de governança humana sólida transforma o potencial transformador da IA em risco sistêmico. Fundamentos da solução: o papel catalisador da colaboração A resposta estratégica passa pela união entre três forças: governo, indústria e academia. Essa tríade é o alicerce histórico da inovação tecnológica, e na era da IA e HPC, sua importância é ainda maior. O governo fornece a visão de longo prazo e o financiamento inicial; a academia gera conhecimento e forma talentos; e a indústria traduz inovação em impacto econômico e social. Nos Estados Unidos, o DOE exemplifica essa abordagem, financiando projetos que conectam laboratórios nacionais a universidades e empresas privadas. Essa integração cria um ciclo virtuoso em que avanços em hardware, software e metodologia se retroalimentam. Ao mesmo tempo, estabelece um padrão de interoperabilidade e governança que garante o uso ético e eficiente dos recursos computacionais. Em um contexto global, essa estratégia serve de referência para outras nações que buscam consolidar ecossistemas de inovação autossuficientes. A criação de programas nacionais de capacitação e pesquisa integrada é essencial para manter a relevância competitiva na nova economia da inteligência. Implementação estratégica: o humano no centro do ciclo tecnológico Implementar uma estratégia eficaz de IA e HPC exige colocar o elemento humano no núcleo das decisões técnicas. Isso significa repensar modelos educacionais, investir em formação prática e promover a interdisciplinaridade desde os níveis mais básicos de ensino. A formação de especialistas que compreendam tanto os fundamentos matemáticos da IA quanto a arquitetura de sistemas HPC é o diferencial competitivo do futuro. Ao mesmo tempo, a cultura organizacional deve evoluir. Ambientes de HPC e IA precisam de equipes que saibam colaborar em torno de objetivos científicos e tecnológicos complexos. A gestão desses times requer líderes com visão sistêmica — capazes de traduzir avanços técnicos em impacto real para o negócio ou para a ciência. Essa implementação também depende de políticas públicas coordenadas, capazes de alinhar investimento, infraestrutura e capacitação. A ausência de um plano integrado resulta em redundância de esforços e desperdício de capital intelectual. É o momento de transformar a corrida tecnológica em uma maratona sustentada por competências humanas duradouras. Melhores práticas avançadas: da infraestrutura à inteligência coletiva As organizações que desejam prosperar nessa nova era devem adotar práticas que unam infraestrutura de ponta a inteligência coletiva. Em HPC, isso significa projetar sistemas abertos e interoperáveis que possam evoluir junto com o ecossistema de IA. Em IA, implica em cultivar modelos

O futuro do armazenamento para HPC e IA: revolução arquitetônica e novos paradigmas empresariais Por que o armazenamento se tornou o novo eixo crítico da revolução em HPC e IA? O crescimento exponencial da inteligência artificial e da computação de alto desempenho (HPC) criou uma nova fronteira de exigência técnica, em que processadores e GPUs não são mais o único foco de inovação. Agora, a eficiência e a escalabilidade do armazenamento definem o sucesso operacional de toda a infraestrutura. À medida que data centers alcançam escalas de gigawatts e organizações competem para treinar modelos cada vez maiores, surge uma questão central: como manter fluxos de dados contínuos e eficientes para alimentar sistemas que processam bilhões de parâmetros por segundo? A resposta passa por uma reengenharia completa do armazenamento – em hardware, software e arquitetura de dados. Contextualização estratégica: da corrida das GPUs à revolução do armazenamento O cenário atual da computação empresarial é dominado por uma verdadeira corrida armamentista digital. A IA transformou GPUs e gigawatts em métricas estratégicas, mas sem uma camada de armazenamento adequada, mesmo os sistemas mais potentes se tornam gargalos de latência e throughput. A transformação do armazenamento é, portanto, um imperativo técnico e competitivo. Embora os discos de estado sólido NVMe dominem o mercado, a coexistência de discos mecânicos e fitas magnéticas demonstra que o desafio não é apenas de velocidade, mas de orquestração entre camadas. O novo paradigma é híbrido e multi-tiered, exigindo uma integração inteligente entre desempenho e custo por terabyte. O problema estratégico: a fome de dados na era da IA Modelos de IA em larga escala e cargas de HPC exigem movimentação massiva de dados com baixa latência. Entretanto, a maioria das organizações enfrenta uma lacuna entre a capacidade de processamento e o desempenho real de E/S. Segundo especialistas como Addison Snell, CEO da Intersect360 Research, a diferença entre o que os usuários precisam e o que os fornecedores oferecem está se ampliando. Essa desconexão impacta diretamente a produtividade: clusters de GPUs subutilizados, pipelines de treinamento ociosos e ciclos de inferência ineficientes. Quando 5% do orçamento total é destinado ao armazenamento, mas de forma incorreta, pode-se perder até 25% de desempenho global. Consequências da inação Ignorar a complexidade crescente do armazenamento significa comprometer toda a estratégia de IA corporativa. A falta de alinhamento entre camadas de dados e fluxos de inferência gera custos ocultos, atrasos de treinamento e aumento do consumo energético. Em escala de exabytes, cada segundo de latência multiplicado por milhares de GPUs representa milhões em desperdício operacional. Fundamentos técnicos da nova arquitetura de armazenamento A revolução no armazenamento para HPC e IA ocorre simultaneamente em três frentes: hardware, software e arquitetura de dados. Camadas e hierarquias de armazenamento O modelo tradicional de duas camadas (disco e fita) evoluiu para ambientes com cinco ou mais níveis, combinando memória NVMe, armazenamento em flash, HDDs de alta densidade e camadas de objeto em nuvem. Cada nível é otimizado para uma função específica — cache, burst buffer, arquivamento ou persistência — exigindo políticas sofisticadas de movimentação automática de dados. Essa hierarquização redefine o conceito de “desempenho”: não se trata apenas de largura de banda, mas de orquestração inteligente. O posicionamento adequado dos dados na camada correta determina a eficiência do cluster de IA. Protocolos e conectividade A predominância de Ethernet e InfiniBand, com suporte a RDMA (Remote Direct Memory Access), tornou-se a base para reduzir latência entre GPU e armazenamento. Tecnologias como GPUDirect da Nvidia e NVLink expandem a comunicação direta entre GPU e subsistemas de dados, removendo a CPU do caminho crítico da transferência. Sistemas de arquivos e abstrações de dados Os sistemas de arquivos paralelos clássicos — Lustre, PanFS e IBM Storage Scale — renascem na era da IA por sua capacidade de processar blocos grandes de dados com alta taxa de transferência. Paralelamente, sistemas baseados em NFS e pNFS continuam relevantes, principalmente quando integrados a armazenamento de objetos compatível com S3, uma demanda crescente para cargas de inferência. Essa convergência entre sistemas de arquivos e objetos reflete uma tendência de “unificação de dados”: o armazenamento deixa de ser apenas persistência e se torna um mecanismo de inteligência operacional, capaz de priorizar dados críticos conforme o contexto de uso. Implementação estratégica em ambientes corporativos Empresas que operam em larga escala, como Meta, OpenAI e Google, já estão construindo data centers com milhares de racks e clusters com centenas de milhares de GPUs. Nessas infraestruturas, a eficiência energética e o fluxo contínuo de dados são métricas de sucesso. O desafio não é apenas instalar mais armazenamento, mas integrar camadas heterogêneas com governança centralizada. Isso exige ferramentas capazes de rastrear dados e metadados entre ambientes on-premises e nuvem, preservando compliance, privacidade e residência de dados. O papel dos metadados e da governança O gerenciamento de metadados emergiu como um dos grandes gargalos técnicos. À medida que dados são fragmentados entre sistemas locais e remotos, catalogar e sincronizar metadados se torna crítico para consistência e rastreabilidade. Cada fornecedor implementa essa camada de forma distinta, tornando a interoperabilidade um ponto de atenção central. Molly Presley, da Hammerspace, sintetiza o dilema: “A IA quer acesso a todos os dados em todos os locais, e não é assim que o armazenamento foi projetado originalmente”. Essa realidade exige novos padrões de abstração e governança, em que o armazenamento se comporta como uma camada cognitiva de dados, e não apenas física. Melhores práticas avançadas: orquestração e otimização Buffers e caches inteligentes Os clusters modernos de IA utilizam buffers de burst — pequenas unidades de armazenamento em flash — para suavizar os picos de E/S durante o treinamento. Já na inferência, caches de chave-valor preservam estados e contextos de interação, otimizando respostas e reduzindo tempos de acesso. Essa abordagem transforma o armazenamento em parte ativa do pipeline de IA. Armazenamento como resultado, não como produto Segundo Shimon Ben-David, CTO da WEKA, o mercado está migrando de “vender armazenamento” para “vender resultados”. Em vez de prometer capacidade, fornecedores precisam demonstrar aceleração direta na inferência e no treinamento. Isso representa