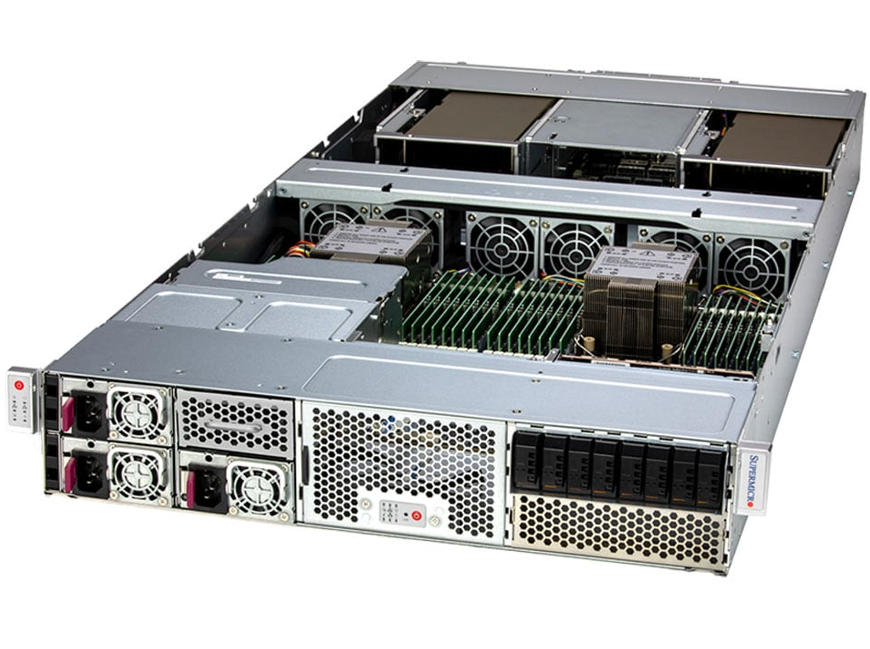

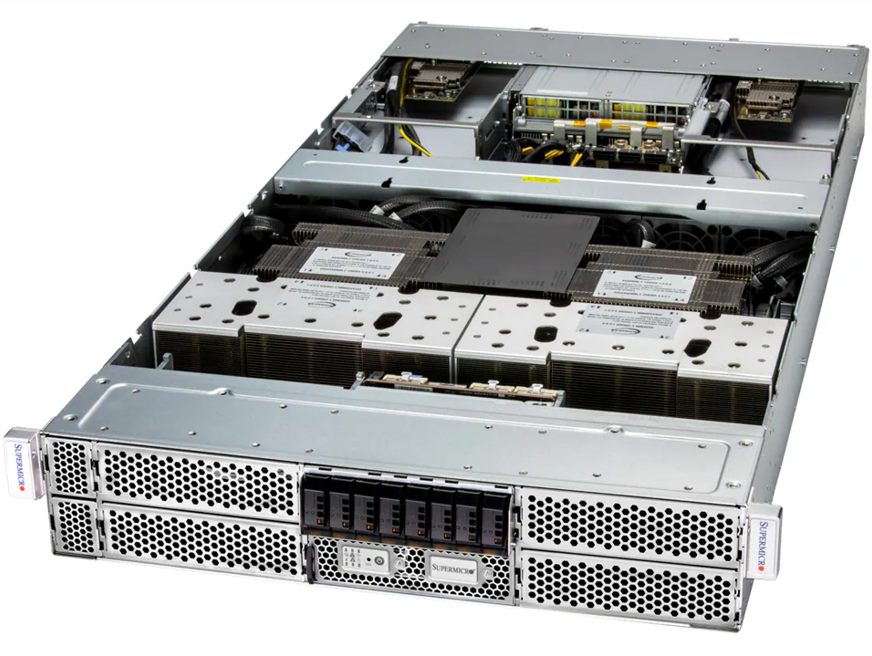

Introdução: o novo paradigma de densidade e eficiência em IA corporativa Nos data centers empresariais modernos, o avanço da inteligência artificial e da virtualização exige uma infraestrutura capaz de equilibrar desempenho extremo, eficiência energética e escalabilidade física. O Supermicro AS-2114GT-DNR surge nesse contexto como uma solução de engenharia de alta densidade: um sistema 2U dual-node, certificado pela NVIDIA, capaz de hospedar até 3 GPUs por nó e processadores AMD EPYC™ da série 7003/7002. Este artigo aprofunda-se na arquitetura técnica do AS-2114GT-DNR e explica como sua configuração dual-node, suporte a GPUs NVIDIA e AMD, e gerenciamento avançado de firmware o tornam um equipamento estratégico para IA, HPC e virtualização empresarial. O desafio estratégico: equilibrar desempenho de IA com densidade física À medida que modelos de IA, aprendizado de máquina e workloads de HPC se tornam mais complexos, as organizações enfrentam um dilema recorrente: como escalar o desempenho computacional sem expandir o espaço físico do data center. Soluções baseadas em GPUs de alta potência, como as NVIDIA RTX A6000 ou A100, exigem refrigeração e potência significativas. Ao mesmo tempo, arquiteturas monolíticas podem gerar gargalos de energia e manutenção. O Supermicro AS-2114GT-DNR aborda esse problema por meio de uma estrutura dual-node independente, permitindo que dois sistemas operem de forma isolada dentro de um único chassi 2U. Cada nó possui seu próprio processador AMD EPYC, memória dedicada e até 3 GPUs, criando um ambiente modular e balanceado para cargas intensivas de inferência e treinamento de IA. Consequências da inação: o custo da subutilização e da baixa densidade Ignorar a necessidade de densidade e eficiência computacional tem impactos diretos nos custos operacionais e na sustentabilidade do data center. Empresas que continuam operando em arquiteturas subutilizadas ou com servidores de baixa densidade enfrentam: Aumento no consumo energético, devido à baixa taxa de consolidação de workloads; Elevação dos custos de refrigeração, consequência da dissipação térmica ineficiente; Maior footprint físico, restringindo a expansão escalável do data center; Risco de obsolescência tecnológica, já que workloads de IA e automação industrial exigem GPUs e processadores de última geração. O AS-2114GT-DNR mitiga esses riscos ao condensar dois sistemas completos em apenas 2U, sem comprometer desempenho nem capacidade de expansão — um diferencial crítico para organizações que precisam maximizar throughput dentro de racks existentes. Fundamentos da solução: arquitetura dual-node com AMD EPYC e GPUs NVIDIA A base técnica do Supermicro AS-2114GT-DNR está em sua arquitetura simétrica de dois nós independentes, cada um com: 1 processador AMD EPYC™ série 7002/7003 (até 280W TDP), com suporte às versões 3D V-Cache para maior largura de banda de cache L3; 8 slots DIMM DDR4 3200MHz, totalizando até 2TB de memória ECC RDIMM/LRDIMM por nó; Até 6 slots PCIe 4.0 x16 (4 internos + 2 externos), garantindo conectividade de alta largura de banda com GPUs e placas de expansão; 2 slots M.2 PCIe 4.0 para SSDs NVMe de formato 2280 ou 22110; 2 baias hot-swap NVMe de 2.5″ para armazenamento direto de alta performance. Essa configuração assegura que cada nó opere como uma unidade computacional completa, ideal para workloads isoladas ou em cluster. O suporte a GPUs NVIDIA e AMD amplia a flexibilidade do sistema: NVIDIA PCIe: L40, RTX A6000, RTX A4500, A40, A16, A2, A100, A10 AMD PCIe: Instinct MI210 e MI100 Essa compatibilidade dual permite otimizar workloads específicas — desde inferência de IA e renderização até simulações HPC — sem depender de um único fornecedor de GPU. Implementação estratégica: modularidade e gestão autônoma por nó Um dos pontos mais críticos em implementações corporativas de IA é o gerenciamento independente de nós, permitindo upgrades, manutenção e escalonamento sem interrupção. No AS-2114GT-DNR, cada nó é hot-pluggable, o que significa que pode ser removido ou substituído sem desligar o sistema completo. Além disso, o servidor incorpora uma camada de gerenciamento de plataforma inteligente (IPMI 2.0) com suporte a KVM-over-LAN, virtual media e watchdog, possibilitando administração remota segura e responsiva. Os administradores podem utilizar ferramentas como: Supermicro Server Manager (SSM) Supermicro Power Manager (SPM) Supermicro Update Manager (SUM) SuperDoctor® 5 (SD5) Essas soluções unificam o controle sobre energia, firmware, atualizações e desempenho térmico, reduzindo custos operacionais e tempo de inatividade. Melhores práticas avançadas: eficiência térmica, segurança e energia redundante A eficiência do AS-2114GT-DNR vai além do desempenho bruto. Seu design 2U inclui 4 ventoinhas PWM hot-swap de 80mm com controle térmico dinâmico e duas fontes redundantes de 2600W com certificação Titanium (96%), assegurando operação contínua e eficiente mesmo sob cargas pesadas de IA ou HPC. A segurança é outro pilar da arquitetura. O sistema adota um Trusted Platform Module (TPM 2.0) com Silicon Root of Trust (RoT) em conformidade com o NIST 800-193, garantindo: Firmware autenticado criptograficamente; Secure Boot e atualizações seguras; Recuperação automática de firmware; System Lockdown contra alterações não autorizadas. Essas medidas fortalecem a resiliência contra ataques a firmware — uma ameaça crescente em ambientes corporativos e governamentais com operações críticas baseadas em IA. Medição de sucesso: desempenho, resiliência e sustentabilidade A avaliação de sucesso de uma infraestrutura dual-node como a do AS-2114GT-DNR deve considerar três dimensões principais: Desempenho Computacional (Throughput por U): O uso combinado de GPUs NVIDIA e processadores AMD EPYC 7003 com PCIe 4.0 garante taxa de processamento significativamente superior em tarefas de inferência, renderização e simulação. Eficiência Operacional: A densidade dual-node reduz o consumo energético e o espaço ocupado, enquanto o gerenciamento remoto via IPMI e Supermicro SSM minimiza o overhead administrativo. Sustentabilidade e Longevidade: Com suporte a CPUs de até 280W TDP e arquitetura escalável de memória e armazenamento, o servidor assegura compatibilidade futura com evoluções de software e frameworks de IA. Empresas que adotam esse modelo alcançam maior ROI por rack unit, mantendo o equilíbrio entre desempenho e custo total de propriedade (TCO). Conclusão: o valor estratégico do Supermicro AS-2114GT-DNR na era da IA corporativa O Supermicro AS-2114GT-DNR representa uma convergência rara entre densidade, modularidade e potência computacional, características essenciais para o avanço de projetos empresariais de IA, HPC e virtualização. Sua arquitetura dual-node em 2U, combinada com processadores AMD EPYC, suporte a múltiplas GPUs e sistemas de segurança de

Supermicro SYS-420GH-TNGR: infraestrutura GPU 4U para IA corporativa e deep learning em larga escala Em um cenário em que as empresas estão expandindo suas operações de inteligência artificial para modelos cada vez maiores e mais complexos, a infraestrutura de hardware tornou-se um diferencial competitivo estratégico. O Supermicro SYS-420GH-TNGR é um exemplo de engenharia voltada a essa nova era da computação intensiva: um servidor GPU 4U projetado para cargas de trabalho de treinamento de IA e deep learning em escala corporativa, combinando potência computacional, largura de banda massiva e arquitetura otimizada para eficiência térmica e energética. Organizações que lidam com modelos de linguagem de grande porte (LLMs), sistemas de recomendação, processamento de linguagem natural e visão computacional exigem plataformas que não apenas suportem múltiplas GPUs, mas que integrem o fluxo de dados, gerenciamento e segurança de forma coesa. O SYS-420GH-TNGR responde a essa demanda com um conjunto de tecnologias que equilibram desempenho, resiliência e escalabilidade. Desafio estratégico: escalar a IA com eficiência e consistência A expansão das aplicações de IA trouxe um desafio estrutural às empresas: como treinar modelos cada vez mais complexos sem comprometer a eficiência energética, o espaço físico do data center e a previsibilidade operacional. O aumento exponencial do volume de parâmetros nos modelos de deep learning demanda sistemas com densidade de GPU elevada e interconexão de altíssima largura de banda. Além do poder de processamento, há a questão da integração e orquestração. Projetos de IA corporativa não dependem apenas de GPU, mas também de uma base de CPU robusta, memória ECC de grande capacidade e canais de rede capazes de sustentar a troca constante de dados entre nós de treinamento. Nesse contexto, o SYS-420GH-TNGR se posiciona como uma peça central em infraestruturas de data centers voltadas para IA distribuída. Riscos da inação e limitações de infraestrutura legada Organizações que mantêm infraestrutura tradicional baseada em servidores genéricos enfrentam gargalos significativos quando escalam suas operações de IA. Sistemas sem suporte a GPUs de largura dupla, ou com interconexões limitadas, sofrem com latência e throughput insuficientes para lidar com treinamento paralelo. Além disso, a ausência de gerenciamento unificado e monitoramento térmico eficiente eleva os custos operacionais e reduz a confiabilidade. A não adoção de uma arquitetura otimizada como a do SYS-420GH-TNGR pode levar a desperdício energético, ciclos de treinamento mais longos e falhas de consistência em modelos críticos — problemas que afetam diretamente o retorno sobre investimento em projetos de IA. Fundamentos técnicos da solução Supermicro SYS-420GH-TNGR O servidor Supermicro SYS-420GH-TNGR é construído sobre uma base dual-socket com processadores Intel Xeon Scalable de 3ª geração (Ice Lake), com TDP de até 270W e suporte para até 40 núcleos e 80 threads por CPU. Essa configuração garante a sustentação necessária para alimentar até 8 GPUs de largura dupla, maximizando a eficiência em operações de treinamento e inferência em paralelo. Com 32 slots DIMM, o sistema suporta até 8TB de memória DDR4 ECC 3200MHz, elemento crítico para cargas de trabalho que exigem datasets massivos e buffer de alta velocidade entre CPU e GPU. O chipset Intel C621A oferece conectividade PCIe 4.0 integral, permitindo comunicação direta e sem gargalos entre dispositivos. Rede e interconectividade para escala horizontal Uma das características mais marcantes do SYS-420GH-TNGR é sua infraestrutura de rede integrada. São 6 interfaces QSFP-DD 400GbE, equivalentes a 2,4Tbps de throughput agregado, além de uma porta 10GbE para gerenciamento dedicado via IPMI. Essa capacidade de comunicação massiva é essencial para clusters de IA distribuída, onde múltiplos nós GPU precisam trocar gradientes e parâmetros com latência mínima. Essa configuração possibilita que o servidor seja integrado em topologias de data center voltadas para treinamento colaborativo de modelos de IA, suportando frameworks como Horovod, PyTorch Distributed e TensorFlow MultiWorkerMirroredStrategy. Em um cenário prático, isso se traduz em menor tempo de convergência de modelo e melhor utilização de GPUs em paralelo. Gerenciamento, segurança e resiliência A gestão do sistema é facilitada por um ecossistema de ferramentas Supermicro, incluindo SuperCloud Composer, Supermicro Server Manager (SSM) e SuperDoctor 5. Esses utilitários permitem monitoramento contínuo de temperatura, voltagem, consumo e desempenho dos componentes, além de atualizações automatizadas via Supermicro Update Manager (SUM). Em termos de segurança, o servidor incorpora um Trusted Platform Module (TPM) 2.0 e um Silicon Root of Trust conforme o padrão NIST 800-193. Esses recursos asseguram a integridade do firmware, habilitando Secure Boot, atualizações criptograficamente assinadas e recuperação automática em caso de corrupção de software — requisitos fundamentais para ambientes corporativos e institucionais que processam dados sensíveis. Implementação e engenharia térmica O design em formato 4U rackmount com chassi CSE-428G2 foi projetado para balancear densidade e refrigeração. Com até 5 ventoinhas de alta potência removíveis e fontes redundantes Titanium Level de 3000W, o sistema mantém estabilidade térmica mesmo sob carga máxima de GPU. Essa abordagem evita throttling e garante que o desempenho sustentado seja mantido em aplicações de longa duração. A arquitetura de energia suporta múltiplos modos de entrada (AC e DC), aumentando a compatibilidade com infraestruturas de energia de data centers modernos e soluções de energia limpa. O monitoramento detalhado de voltagem e temperatura via PWM e sensores internos permite ajustes dinâmicos de velocidade de ventoinhas, equilibrando desempenho e consumo energético. Armazenamento híbrido de alta velocidade O SYS-420GH-TNGR inclui 4 baias hot-swap 2.5” NVMe/SAS/SATA e 2 slots M.2 NVMe, permitindo uma arquitetura híbrida de armazenamento para dados temporários e modelos persistentes. Essa configuração facilita operações de caching de datasets e checkpoints de modelos em treinamento, reduzindo o tempo de leitura e escrita em pipelines de IA. Melhores práticas de integração e operação Para obter o máximo desempenho, a integração do SYS-420GH-TNGR deve considerar a compatibilidade entre GPU, CPU e topologia de rede. Em ambientes corporativos, a configuração ideal envolve emparelhamento com GPUs NVIDIA compatíveis com NVLink e interconexões 400GbE para minimizar latência entre nós. A utilização de software de orquestração como Kubernetes com plug-ins GPU Operator também potencializa o controle de recursos e balanceamento de carga. Do ponto de vista de manutenção, o ecossistema de monitoramento Supermicro permite detectar anomalias precocemente e aplicar atualizações de firmware

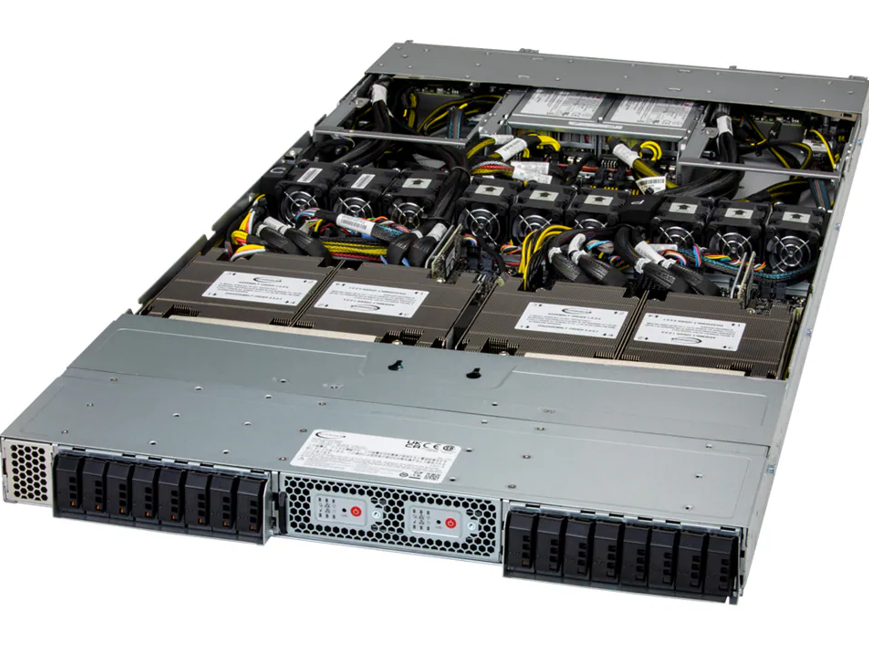

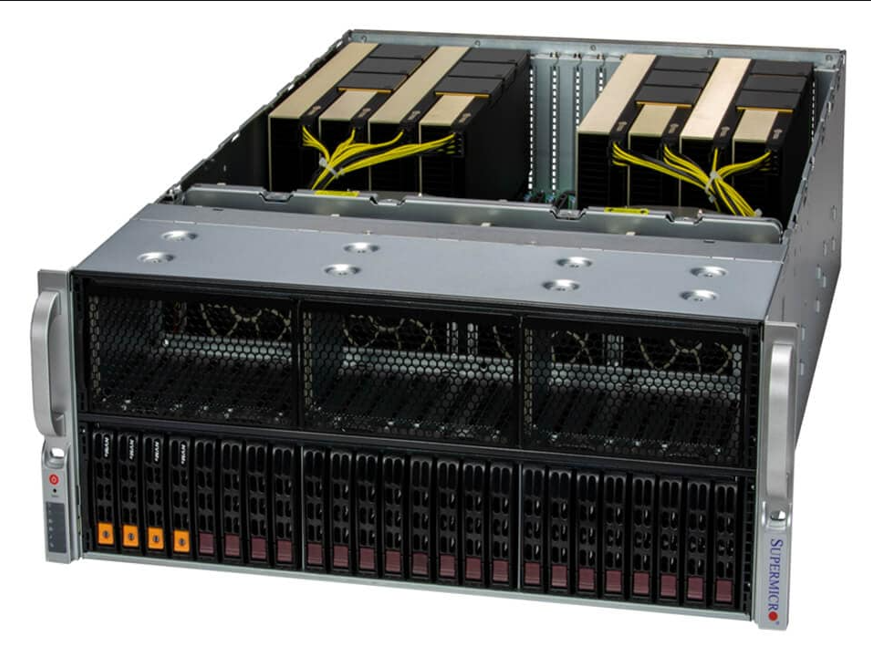

Servidor 4U AMD Dual-Root com 8 GPUs: Performance e Escalabilidade Empresarial No cenário atual de tecnologia empresarial, a demanda por soluções de computação de alto desempenho (HPC) e inteligência artificial (AI) está crescendo de forma exponencial. Organizações que atuam em setores como deep learning, simulações científicas complexas, molecular dynamics e cloud gaming precisam de servidores capazes de fornecer processamento massivo paralelo, alta largura de banda entre CPU e GPU e escalabilidade sem comprometer a confiabilidade. O Servidor 4U AMD Dual-Root com 8 GPUs da Supermicro surge como uma solução estratégica para empresas que enfrentam desafios críticos de desempenho e capacidade de processamento. Sua arquitetura com processadores AMD EPYC e suporte a GPUs duplas de alta performance permite lidar com cargas de trabalho intensivas, reduzindo o tempo de execução de projetos complexos e aumentando a competitividade organizacional. Ignorar ou subdimensionar a infraestrutura para HPC e AI pode gerar atrasos em pesquisas, perda de oportunidades de inovação e aumento de custos operacionais. Este artigo explora detalhadamente os fundamentos técnicos, estratégias de implementação e melhores práticas para maximizar o retorno sobre investimento (ROI) neste tipo de solução. Serão abordados: arquitetura do sistema, interconexão CPU-GPU, gerenciamento de memória, armazenamento, rede, segurança, resiliência e métricas de desempenho, permitindo uma visão completa para decisões estratégicas e técnicas. Desafios Estratégicos de Computação de Alto Desempenho Complexidade de cargas de trabalho HPC e AI Organizações que utilizam AI, deep learning e simulações científicas enfrentam desafios significativos relacionados à paralelização de tarefas, volume de dados e requisitos de latência. Processamentos tradicionais não conseguem acompanhar a complexidade de algoritmos de aprendizado profundo, modelagem molecular ou renderização gráfica em tempo real. O uso de múltiplas GPUs de alta capacidade, como o suporte a até 8 GPUs duplas neste servidor, permite distribuir operações massivamente paralelas, reduzindo gargalos de processamento e acelerando resultados. A interconexão via NVLink com NVSwitch maximiza a largura de banda GPU-GPU, essencial para tarefas que exigem compartilhamento intensivo de dados entre aceleradores. Riscos da infraestrutura inadequada Subestimar as necessidades de computação pode resultar em: atrasos de projeto, custos de energia mais altos, falhas em deadlines estratégicos e limitação na experimentação de modelos de AI. Servidores mal configurados podem gerar gargalos de memória, saturação de I/O ou falhas em tarefas de processamento distribuído. Fundamentos da Solução Supermicro AS-4124GS-TNR+ Arquitetura Dual-Root com AMD EPYC O sistema utiliza processadores AMD EPYC™ 7002/7003 em configuração dual SP3, suportando CPUs com até 280W TDP. Esta arquitetura oferece alta contagem de núcleos e threads, crucial para paralelismo em cargas de trabalho HPC e AI, permitindo processar múltiplas tarefas simultaneamente com eficiência energética. O design Dual-Root permite otimizar a comunicação interna e reduzir latência entre CPUs e GPUs, tornando o servidor altamente eficiente em operações complexas e de grande volume de dados. GPU e interconexão de alta performance O servidor suporta até 8 GPUs duplas ou simples, incluindo NVIDIA H100, A100, L40S, RTX 6000, entre outras, e AMD Instinct MI150. A interconexão via PCIe 4.0 x16 CPU-GPU e NVLink NVSwitch entre GPUs garante throughput máximo e baixa latência, essencial para deep learning, inferência de AI e simulações em escala. Memória e armazenamento escaláveis Com 32 slots DIMM, suporta até 8TB de ECC DDR4 3200MT/s, garantindo consistência e correção de erros em operações críticas. O armazenamento é flexível: até 24 baias hot-swap de 2.5″, combinando SATA e NVMe, e controladores RAID avançados permitem configuração de redundância e desempenho conforme a necessidade do projeto. Implementação Estratégica e Gestão de Infraestrutura Gerenciamento e software Supermicro O SuperServer vem com ferramentas como SuperCloud Composer, Supermicro Server Manager, SuperDoctor 5 e SuperServer Automation Assistant, permitindo monitoramento detalhado, diagnóstico proativo e automação de tarefas repetitivas. Esses recursos reduzem risco operacional e facilitam escalabilidade futura. Segurança e resiliência O sistema inclui TPM 2.0, Silicon Root of Trust e firmware criptograficamente assinado, garantindo integridade de inicialização e proteção contra ataques de baixo nível. Além disso, fontes redundantes Titanium Level 96% e monitoramento de ventiladores e temperatura asseguram disponibilidade contínua em operações críticas. Considerações de implementação Para maximizar desempenho, recomenda-se balancear GPU e CPU de acordo com perfil de workload, configurar memória em dual DIMM por canal (2DPC) e otimizar armazenamento NVMe/SATA conforme prioridade de I/O. A integração com redes 1GbE e AOC customizadas permite flexibilidade de comunicação e escalabilidade em datacenters. Melhores Práticas Avançadas Otimização de workloads HPC e AI Distribuir tarefas de treinamento AI entre GPUs com NVLink reduz overhead de sincronização. Aplicar técnicas de memory pooling e tuning de PCIe assegura que GPUs recebam dados na velocidade ideal, evitando subutilização do processamento paralelo. Redundância e continuidade operacional Configurar RAID 1 para drives críticos, empregar múltiplas fontes de alimentação redundantes e monitorar sensores de temperatura previne falhas inesperadas. Estratégias de failover podem ser implementadas via software de gerenciamento Supermicro, garantindo alta disponibilidade em datacenters corporativos. Medição de Sucesso Métricas de desempenho Indicadores como throughput PCIe, largura de banda NVLink, utilização de GPU, tempo médio de resposta e IOPS de armazenamento são cruciais para avaliar eficiência do servidor. Monitoramento contínuo permite ajustes finos e planejamento de expansão. Indicadores de ROI Redução de tempo de treinamento AI, menor latência em simulações, maior densidade computacional por rack e eficiência energética medem o retorno sobre o investimento. Implementações bem planejadas garantem escalabilidade sem comprometer custo operacional. Conclusão O Servidor 4U AMD Dual-Root com 8 GPUs é uma solução robusta e estratégica para organizações que buscam performance extrema em HPC, deep learning e simulações avançadas. Sua arquitetura balanceada entre CPU e GPU, memória massiva e armazenamento flexível proporciona confiabilidade, escalabilidade e segurança. Empresas que implementam esta infraestrutura ganham vantagem competitiva, capacidade de inovação acelerada e mitigam riscos operacionais associados a cargas de trabalho críticas. A integração com ferramentas de gerenciamento e monitoramento da Supermicro garante governança, compliance e continuidade operacional. Perspectivas futuras incluem expansão para novas gerações de GPUs e CPUs, integração com AI federada e otimizações de NVLink para workloads cada vez mais massivos, mantendo a solução alinhada com tendências de HPC e AI corporativa. Próximos passos incluem avaliação detalhada de workloads, planejamento de escalabilidade, configuração

Servidor GPU 4U Intel com 8x NVIDIA HGX A100 – Potência para AI e HPC O SuperServer SYS-420GP-TNAR+ da Supermicro representa um marco em capacidade de processamento para aplicações corporativas de alta performance, como inteligência artificial (AI) e computação de alto desempenho (HPC). Projetado para atender às demandas extremas de análise de dados e treinamento de modelos de aprendizado profundo, este servidor combina processadores Intel® Xeon® Scalable de 3ª geração com a tecnologia NVIDIA HGX A100, oferecendo uma arquitetura robusta que suporta até 8 GPUs de alto desempenho e até 8TB de memória DDR4 ECC, expansível com Intel® Optane™ Persistent Memory. Introdução Contextualização Estratégica Empresas que lidam com workloads intensivos em dados, como modelagem de AI ou simulações científicas, precisam de infraestrutura capaz de processar grandes volumes de informações com latência mínima. A escolha de servidores GPU de alta densidade, como o SYS-420GP-TNAR+, impacta diretamente a capacidade de inovação e competitividade, permitindo que projetos de AI e HPC sejam executados de forma mais rápida e eficiente. Desafios Críticos Organizações que utilizam servidores convencionais enfrentam limitações significativas: gargalos de memória, insuficiência de interconexão entre CPU e GPU e baixa escalabilidade para expansão futura. Esses desafios podem resultar em ciclos mais longos de treinamento de modelos, aumento de custos operacionais e incapacidade de atender a demandas emergentes de processamento. Custos e Riscos da Inação A não adoção de servidores GPU otimizados implica em perda de produtividade, maior consumo energético em configurações menos eficientes e riscos de não cumprir prazos críticos de projetos estratégicos. Além disso, a escalabilidade limitada pode forçar interrupções futuras para upgrades emergenciais, elevando custos e riscos de downtime. Visão Geral do Artigo Este artigo detalhará a arquitetura do SuperServer SYS-420GP-TNAR+, analisando componentes críticos, interconexões CPU-GPU, opções de memória, armazenamento e rede. Serão exploradas as melhores práticas de implementação, trade-offs estratégicos e métricas de sucesso para maximizar o retorno sobre o investimento em infraestrutura de AI e HPC. Desenvolvimento Problema Estratégico Em ambientes de AI e HPC, o throughput de dados entre CPU e GPU, bem como entre GPUs, é crucial. Servidores convencionais apresentam limitações de PCIe, memória e interconectividade, dificultando a execução de workloads distribuídos e altamente paralelos. Além disso, a integração com storage rápido e confiável é essencial para evitar gargalos que podem degradar o desempenho global do cluster. Consequências da Inação Manter servidores ineficientes acarreta maior tempo de treinamento de modelos de AI, impacto direto na competitividade e custos operacionais superiores. Projetos críticos podem sofrer atrasos, aumentando o risco de perda de oportunidades de negócio e comprometendo a confiabilidade dos resultados científicos ou analíticos. Fundamentos da Solução O SYS-420GP-TNAR+ utiliza processadores Dual Socket P+ Intel® Xeon® de 3ª geração, suportando até 40 núcleos por CPU e 8TB de memória DDR4 ECC com suporte a Optane Persistent Memory. Essa configuração garante capacidade de processamento massiva, tolerância a falhas em memória e baixa latência na transferência de dados. O uso do NVIDIA HGX A100 8-GPU com interconexão NVLink/NVSwitch maximiza o bandwidth entre GPUs, permitindo treinamento de modelos de AI em larga escala. O PCIe Gen 4 x16 fornece alta largura de banda para comunicação CPU-GPU, essencial para workloads híbridos e análise de grandes volumes de dados. O sistema também inclui 6 baias hot-swap de 2.5″ para NVMe/SATA/SAS e 2 slots M.2 para boot, oferecendo flexibilidade para armazenamentos de alto desempenho e redundância crítica para operação contínua. Implementação Estratégica Para implementar o SYS-420GP-TNAR+ de forma otimizada, recomenda-se planejar a distribuição de workloads entre GPUs e CPUs, alocando memória DDR4 ECC e Optane conforme necessidades de dados persistentes e cache de alto desempenho. O monitoramento via Supermicro Server Manager (SSM) e SuperCloud Composer® permite ajustes finos em tempo real, garantindo eficiência energética e desempenho consistente. Além disso, a configuração de redundância com fonte de alimentação Titanium de 3000W e gestão de ventoinhas heavy duty minimiza riscos de downtime e supera limitações térmicas comuns em servidores densos. Melhores Práticas Avançadas O uso de RAID em storage NVMe/SATA/SAS garante integridade de dados e performance otimizada. Para workloads de AI distribuídos, recomenda-se alinhar software de gerenciamento de cluster às capacidades NVLink/NVSwitch, maximizando comunicação entre GPUs. A adoção de TPM 2.0 e Root of Trust (RoT) atende requisitos de compliance e segurança crítica, garantindo proteção de dados sensíveis. Para expansão futura, a arquitetura OCP 3.0 e slots PCIe Gen 4 permitem integrar aceleradores adicionais e networking de alta velocidade sem comprometer operação existente. Medição de Sucesso A eficácia do servidor pode ser medida por métricas como throughput de treinamento de AI (TFLOPS), latência CPU-GPU, eficiência energética e uptime do sistema. Indicadores de performance de memória, interconexão NVLink/NVSwitch e taxa de transferência do storage também são críticos para validar a performance total da solução. Conclusão Resumo dos Pontos Principais O SuperServer SYS-420GP-TNAR+ combina alta densidade de GPU, memória massiva e opções flexíveis de storage e rede, tornando-o ideal para AI e HPC. Sua arquitetura Intel Xeon + NVIDIA HGX A100 oferece alto desempenho, escalabilidade e confiabilidade para workloads críticos. Considerações Finais A adoção de servidores GPU de alta densidade permite reduzir ciclos de treinamento, aumentar produtividade e garantir segurança e compliance. O planejamento estratégico de implementação, alinhado a monitoramento contínuo, maximiza o retorno sobre investimento e prepara a infraestrutura para evolução tecnológica. Perspectivas Futuras Com a evolução de AI e HPC, o SYS-420GP-TNAR+ está preparado para integrar futuras gerações de GPUs, memória persistente e aceleradores especializados, mantendo relevância em projetos críticos e clusters de alta performance. Próximos Passos Práticos Empresas devem avaliar demandas de AI e HPC, planejar configuração de GPUs e memória, integrar soluções de monitoramento e redundância, e alinhar com políticas de segurança e compliance para garantir operação contínua e escalável.

Servidor 4U AMD com 8 GPUs NVIDIA HGX A100 para HPC e AI Introdução No cenário atual de computação de alto desempenho (HPC) e inteligência artificial (AI), a demanda por sistemas com capacidade massiva de processamento paralelo está crescendo de forma exponencial. Organizações de pesquisa, laboratórios de dados e provedores de serviços de nuvem enfrentam desafios significativos para processar grandes volumes de dados em tempo hábil, enquanto mantêm eficiência energética e confiabilidade operacional. Um dos maiores desafios críticos é a comunicação eficiente entre GPUs em sistemas multi-GPU. Latência e largura de banda insuficientes podem se tornar gargalos severos em aplicações de deep learning e análise científica de grande escala. A implementação inadequada de sistemas HPC também pode gerar custos elevados de energia e manutenção, além de comprometer o desempenho e a escalabilidade. Este artigo aborda o DP AMD System com NVIDIA HGX A100 8-GPU, detalhando arquitetura, recursos avançados, integração com AI/Deep Learning e melhores práticas de implementação em data centers. Analisaremos impactos estratégicos, trade-offs técnicos e métricas de sucesso para organizações que buscam maximizar a performance em HPC e AI. Problema Estratégico Empresas e centros de pesquisa enfrentam um dilema: como escalar cargas de trabalho de HPC e AI mantendo eficiência energética e consistência de desempenho entre GPUs. Sistemas tradicionais multi-GPU frequentemente sofrem com limitações de interconexão, tornando o processamento distribuído ineficiente. Além disso, a integração com infraestrutura existente, gerenciamento térmico e redundância de energia representam riscos críticos. Falhas nestes pontos podem comprometer a continuidade operacional e gerar perdas financeiras significativas. Comunicação entre GPUs A largura de banda de interconexão entre GPUs é um fator determinante. Sem tecnologia adequada, como NVLink v3 e NVSwitch, o sistema sofre gargalos em workloads que exigem alta transferência de dados entre GPUs, impactando treinamento de modelos de AI complexos. Gerenciamento de Recursos O gerenciamento de memória e CPU é outro ponto crítico. CPUs AMD EPYC dual, suportando até 280W TDP, combinadas com 32 DIMMs DDR4 ECC 3200MHz, proporcionam desempenho robusto, mas exigem monitoramento contínuo para evitar throttling e maximizar eficiência em workloads paralelos. Consequências da Inação Ignorar a escolha de arquitetura apropriada para HPC e AI pode resultar em tempos de processamento mais longos, desperdício de energia e limitação na escalabilidade. Organizações podem enfrentar atrasos críticos em pesquisas, análises preditivas e treinamento de modelos de IA de larga escala. Falhas em redundância e gerenciamento térmico podem gerar downtime significativo, comprometendo SLAs e aumentando custos operacionais. Além disso, sistemas com baixa interoperabilidade podem exigir reconfigurações constantes, impactando produtividade e retorno sobre investimento. Fundamentos da Solução Arquitetura de GPU e Interconexão O DP AMD System integra 8 GPUs NVIDIA HGX A100 com 40GB HBM2 ou 80GB HBM2e, interconectadas via NVLink v3 e NVSwitch. Este design oferece comunicação de alta largura de banda, essencial para treinamento de modelos de AI e workloads HPC que dependem de transferência massiva de dados. O suporte a GPUDirect RDMA permite comunicação direta entre GPUs e NICs, reduzindo latência e overhead de CPU, essencial em ambientes de AI/Deep Learning distribuído. Processamento e Memória Dual AMD EPYC 7002/7003 com 32 DIMMs DDR4 3200MHz ECC registradas oferecem capacidade de memória de 8TB, garantindo consistência e integridade em cálculos de alta precisão. A tecnologia AMD 3D V-Cache™ em modelos EPYC 7003 aumenta desempenho em workloads dependentes de cache, mas requer BIOS 2.3 ou superior. Gerenciamento e Segurança O sistema oferece Supermicro Server Manager (SSM), Power Manager (SPM) e SuperDoctor 5, possibilitando monitoramento em tempo real de CPUs, memória, ventiladores e temperatura do chassis. Recursos de segurança incluem TPM 2.0, Silicon Root of Trust, Secure Boot e firmware assinado, mitigando riscos de ataques a nível de hardware. Implementação Estratégica Integração com Data Center Com formato 4U e 4x 2200W redundantes (3+1), o sistema é adequado para racks de alta densidade, mantendo eficiência energética e redundância de energia. Monitoramento de temperatura e controle de ventiladores PWM garantem operação estável em ambientes críticos. Configuração de Storage O DP AMD System suporta até 10 bays NVMe 2.5″, combinando frontais hot-swap e traseiros, permitindo escalabilidade de armazenamento de alta velocidade. NVMe adicional requer controladora ou cabos específicos, destacando a importância de planejamento de infraestrutura. Melhores Práticas Avançadas Otimização de Workloads AI Para workloads de AI distribuído, é recomendada a configuração 1:1 de NIC para GPU via GPUDirect RDMA, minimizando latência e maximizando throughput. Balanceamento de carga entre CPUs e GPUs é essencial para evitar estrangulamento de pipelines de dados. Monitoramento Proativo Utilizar SSM, SPM e SD5 para análise contínua de performance permite ajustes de ventilação, clock e consumo energético. A aplicação de políticas de firmware seguro garante mitigação de vulnerabilidades e continuidade operacional. Medição de Sucesso O sucesso da implementação pode ser medido através de métricas como throughput em treinamento de AI, latência de comunicação entre GPUs, eficiência energética (PUE), tempo de disponibilidade (uptime) e integridade de dados em memória ECC. Benchmarks de workloads reais oferecem indicadores confiáveis para avaliação de performance e ROI. Conclusão O DP AMD System com NVIDIA HGX A100 8-GPU é uma solução robusta para HPC e AI, combinando alto desempenho de processamento, interconexão eficiente e recursos avançados de segurança. Sua arquitetura 4U dual AMD EPYC com 32 DIMMs DDR4 e suporte a NVLink v3 + NVSwitch garante comunicação rápida entre GPUs, essencial para workloads críticos. A adoção estratégica deste sistema reduz riscos de downtime, otimiza performance em AI/Deep Learning e oferece escalabilidade de memória e armazenamento NVMe. A implementação cuidadosa e monitoramento proativo asseguram alinhamento com objetivos de negócio e eficiência operacional. Perspectivas futuras incluem expansão de capacidade de GPU e armazenamento, integração com novas tecnologias NVIDIA e aprimoramentos em gerenciamento inteligente de data centers. Organizações que buscam liderança em HPC e AI devem considerar esta plataforma como base para crescimento sustentável e competitivo.

Servidor 4U com AMD MI300A: Performance Máxima para IA e HPC O avanço da Inteligência Artificial (IA), modelos de linguagem de larga escala (LLM) e cargas de trabalho de High Performance Computing (HPC) exige infraestrutura computacional robusta, escalável e eficiente. O servidor 4U com quatro aceleradores AMD Instinct™ MI300A surge como uma solução estratégica para centros de dados, provedores de nuvem e laboratórios de pesquisa que buscam unir desempenho extremo com flexibilidade operacional. Desafios Críticos no Cenário Atual Empresas e instituições enfrentam desafios significativos ao implementar soluções de HPC e IA: necessidade de throughput massivo de memória, interconexões rápidas entre GPUs, latência mínima e gerenciamento eficiente de energia. Servidores convencionais muitas vezes não conseguem atender simultaneamente às demandas de capacidade computacional, largura de banda e resfriamento, resultando em gargalos de desempenho e custos operacionais elevados. Consequências da Inação A ausência de uma infraestrutura otimizada para IA e HPC pode gerar atrasos no desenvolvimento de modelos, aumento de consumo energético e maior tempo de processamento de dados críticos. Além disso, limita a capacidade de expansão para novas tecnologias e compromete a competitividade, especialmente em ambientes de pesquisa e cloud providers que dependem de rápida entrega de resultados. Fundamentos Técnicos da Solução Arquitetura de Processamento O servidor conta com quatro aceleradores AMD Instinct™ MI300A APU, cada um com até 512GB de memória HBM3 unificada onboard, permitindo operações massivamente paralelas com alta eficiência energética. A interconexão entre GPUs é garantida pelo AMD Infinity Fabric™ Link, reduzindo latência e maximizando o throughput em cargas de trabalho de IA e HPC. Configurações PCIe e Armazenamento Flexibilidade é um ponto-chave: o servidor oferece múltiplas configurações PCIe 5.0, com até oito slots x16 e opções adicionais via AIOM compatível com OCP NIC 3.0. O armazenamento também é versátil, com oito baias NVMe padrão, expansível até 24 baias SAS/SATA via placa adicional, além de dois slots M.2 NVMe/SATA. Essa arquitetura suporta tanto pipelines de dados de alta velocidade quanto grandes volumes de armazenamento local. Memória e Resfriamento O sistema embarca 512GB de HBM3 onboard, eliminando gargalos de memória e melhorando a performance em cargas paralelas. Para manter estabilidade térmica, utiliza dez ventoinhas pesadas com controle de velocidade otimizado e air shroud, garantindo operação segura mesmo sob cargas intensas e prolongadas. Implementação Estratégica Considerações de Energia e Redundância O servidor possui quatro fontes redundantes Titanium de 2700W, assegurando resiliência e continuidade operacional em cenários críticos. Essa configuração minimiza risco de downtime e protege investimentos em workloads de alta prioridade. Gestão e Segurança Ferramentas de gerenciamento como SuperCloud Composer®, Supermicro Server Manager e Supermicro Update Manager permitem monitoramento proativo, atualizações seguras e automação de processos críticos. A segurança é reforçada com TPM 2.0, Root of Trust e firmware criptograficamente assinado, alinhando-se a requisitos de compliance corporativo e regulamentações internacionais. Melhores Práticas Avançadas Para maximizar o desempenho do servidor 4U MI300A, recomenda-se balanceamento de cargas entre CPUs e GPUs, otimização de tráfego de memória HBM3 e utilização de interconexões PCIe e AIOM conforme perfil de aplicação. Monitoramento contínuo de temperatura e consumo energético previne degradação de hardware, enquanto estratégias de expansão incremental permitem atualização sem impacto operacional. Medição de Sucesso O sucesso da implementação pode ser medido por métricas como: throughput de processamento (TFLOPS), latência em comunicação entre GPUs, utilização de memória HBM3 e eficiência energética (PUE). Além disso, indicadores de disponibilidade e tempo de resposta operacional são essenciais para validar ROI em projetos de IA, HPC e LLM. Conclusão O servidor 4U com quatro AMD Instinct™ MI300A representa uma solução estratégica para organizações que demandam computação de alta performance, memória de largura massiva e interconexões rápidas. Sua arquitetura avançada, combinada com redundância, gerenciamento centralizado e segurança robusta, garante operações confiáveis e escaláveis para workloads críticos. Ao adotar essa solução, empresas e laboratórios podem acelerar o desenvolvimento de IA e HPC, reduzir riscos de downtime e maximizar o retorno de investimentos em infraestrutura de ponta. A evolução tecnológica futura, com novas gerações de aceleradores e memória de alta velocidade, será facilmente incorporada graças à flexibilidade e escalabilidade do design 4U MI300A.

SuperServer SYS-221GE-NR: Potência Intel e NVIDIA para HPC e IA Empresarial O SuperServer SYS-221GE-NR da Supermicro representa a convergência entre processamento de alta performance e aceleração de workloads de inteligência artificial. Projetado para ambientes empresariais que exigem HPC, treinamento de deep learning e execução de LLMs, este sistema 2U entrega flexibilidade e escalabilidade, aproveitando o poder de até quatro GPUs NVIDIA e processadores Intel Xeon de 4ª e 5ª geração. Introdução: Cenário Estratégico e Desafios Empresariais No contexto atual de data centers corporativos e pesquisa avançada, a capacidade de processar grandes volumes de dados com baixa latência é crítica. Organizações que lidam com IA generativa, simulações científicas ou analytics em tempo real enfrentam desafios significativos relacionados à comunicação entre CPU e GPU, armazenamento ultrarrápido e gerenciamento térmico. A implementação inadequada de servidores GPU pode resultar em subutilização de hardware, aumento de custos operacionais e perda competitiva. Este artigo explora como o SYS-221GE-NR aborda essas questões, detalhando arquitetura, interconexões PCIe/NVLink, suporte a memória DDR5 ECC, opções de armazenamento NVMe e estratégias de gerenciamento avançado, conectando cada recurso ao impacto nos negócios. Problema Estratégico: Desafios em HPC e IA Empresarial Workloads de AI e HPC exigem throughput massivo entre CPUs e GPUs. Sistemas tradicionais muitas vezes criam gargalos de memória e I/O, limitando o desempenho mesmo com GPUs de última geração. Além disso, operações críticas dependem de alta confiabilidade, redundância e gerenciamento eficiente, áreas onde servidores de alta densidade devem se destacar. Implicações Técnicas e Comerciais Sem arquitetura adequada de interconexão, o custo por operação aumenta e o ROI do investimento em hardware de ponta é comprometido. O SYS-221GE-NR mitiga esses riscos com PCIe 5.0 x16 para CPU-GPU e opcional NVLink GPU-GPU, garantindo comunicação eficiente e escalabilidade para múltiplos workloads simultâneos. Consequências da Inação Falhas em implementar sistemas GPU otimizados podem levar a: Subutilização de GPUs: gargalos de I/O reduzem throughput e eficiência computacional. Aumento de custos operacionais: maior consumo energético e necessidade de mais servidores para workloads iguais. Risco de falhas críticas: ausência de redundância em energia ou armazenamento pode interromper operações empresariais. Fundamentos da Solução: Arquitetura e Recursos O SYS-221GE-NR combina: Até 4 GPUs NVIDIA PCIe (H100, H100 NVL, L40, L40S) com suporte opcional NVLink para interconexão de alta largura de banda. Processadores Intel Xeon 4ª/5ª geração, até 64 cores/128 threads por CPU, suportando TDP de até 350W. Memória DDR5 ECC, até 8TB, com 32 slots DIMM, garantindo alta confiabilidade e throughput consistente. Armazenamento NVMe E1.S hot-swap, até 8 drives frontais, e suporte a M.2 adicional, entregando I/O ultra-rápido. Implementação Estratégica Para maximizar a performance, recomenda-se configurar GPUs balanceadas entre PCIe 5.0 e NVLink, ajustando BIOS e firmware Supermicro para otimizar consumo energético e resfriamento. A redundância de 3 fontes de 2000W Titanium Level garante continuidade em operações críticas, enquanto ferramentas de gerenciamento como SSM, SD5 e IPMI 2.0 oferecem controle granular de hardware e monitoramento remoto. Melhores Práticas Avançadas O uso de perfis de ventilação dinâmicos, criptografia de firmware e Trusted Platform Module 2.0 permite ambientes HPC e AI seguros, reduzindo risco de ataque a nível de hardware. Estratégias de monitoramento de temperatura e controle de RPM asseguram longevidade dos componentes mesmo sob carga máxima. Medição de Sucesso Indicadores críticos incluem utilização de GPU (% de ocupação), IOPS de NVMe, latência de CPU-GPU, consumo energético por operação e uptime geral do servidor. Métricas devem ser monitoradas via SSM ou Redfish API para ajustes contínuos. Conclusão O SuperServer SYS-221GE-NR é um sistema 2U projetado para entregar desempenho extremo em HPC e IA, conectando recursos técnicos avançados a impactos diretos no negócio. Sua arquitetura equilibrada, redundância energética, gerenciamento de temperatura e suporte a múltiplas GPUs NVIDIA garante eficiência, escalabilidade e segurança operacional. Organizações que adotarem esta solução estarão preparadas para workloads críticos e cenários de alta demanda computacional, reduzindo riscos e otimizando ROI.

Supermicro ARS-121L-DNR: desempenho extremo com NVIDIA Grace CPU Superchip para HPC e nuvem hyperscale O avanço das arquiteturas de computação de alto desempenho redefine constantemente o equilíbrio entre densidade, eficiência energética e conectividade. O Supermicro ARS-121L-DNR emerge nesse contexto como uma solução projetada para maximizar o poder de processamento em espaços mínimos, integrando o NVIDIA Grace™ CPU Superchip e suporte a interconexões de alta largura de banda como o NVLink® Chip-2-Chip (C2C). Este artigo analisa em profundidade como o design dual-node em 1U impulsiona cargas de trabalho intensivas em dados, como High Performance Computing (HPC), aplicações hyperscale e análise avançada. Contexto e Desafio Estratégico Os datacenters modernos enfrentam uma pressão crescente por maior densidade computacional e eficiência térmica, especialmente em ambientes voltados a HPC e cloud hyperscale. O desafio está em equilibrar desempenho extremo com economia de energia e escalabilidade modular — elementos muitas vezes contraditórios na prática. O ARS-121L-DNR foi projetado exatamente para resolver essa equação, condensando dois nós completos com CPUs Grace em apenas 1U de altura. Em contextos como simulações científicas, análises de dados em tempo real e processamento paralelo massivo, a latência entre unidades de processamento se torna um gargalo crítico. A integração do NVLink C2C no ARS-121L-DNR, com 900 GB/s de interconexão bidirecional entre os processadores, elimina esse gargalo e garante que ambos os nós trabalhem em sinergia total. Consequências da Inação Ignorar a transição para plataformas otimizadas por arquitetura Grace pode resultar em desperdício de energia e limitações de throughput em cargas de HPC e IA. Sistemas baseados em arquiteturas tradicionais x86 enfrentam maior consumo energético e menor eficiência de interconexão, o que se traduz em custos operacionais mais altos e maior latência em tarefas paralelas. Além disso, em ambientes hyperscale e de análise de dados, cada microssegundo de latência impacta o custo total de propriedade (TCO). O atraso na adoção de sistemas baseados em Grace CPU Superchip reduz a competitividade frente a infraestruturas que já exploram a integração CPU-to-CPU via NVLink e memórias LPDDR5X de alta eficiência. Fundamentos da Solução Arquitetura NVIDIA Grace CPU Superchip O coração do ARS-121L-DNR é o NVIDIA Grace™ CPU Superchip, composto por duas CPUs de 72 núcleos interconectadas via NVLink C2C. Essa arquitetura elimina a dependência de controladores externos, reduzindo latência e maximizando a coerência de cache entre núcleos. O resultado é um processamento homogêneo e otimizado para tarefas paralelas em HPC, IA e data analytics. Com suporte a até 480 GB de memória LPDDR5X ECC por nó, o sistema entrega largura de banda excepcional e resiliência a falhas, garantindo integridade de dados em operações contínuas. Essa abordagem não apenas melhora o desempenho bruto, mas também contribui para a redução de consumo energético por operação computacional — um fator crítico em infraestruturas sustentáveis. Design Dual-Node em 1U O design 1U com dois nós independentes diferencia o ARS-121L-DNR no portfólio de HPC da Supermicro. Cada nó é isolado, com sua própria controladora, armazenamento, conectividade e subsistema de resfriamento, permitindo balanceamento de carga ou redundância. Isso aumenta a eficiência de rack e simplifica a manutenção sem comprometer o desempenho agregado. Essa arquitetura é particularmente vantajosa em clusters de HPC e plataformas hyperscale, onde a densidade física impacta diretamente o custo operacional por unidade de rack. Com dois servidores completos em uma única unidade de altura, a eficiência por watt e por U atinge níveis de excelência. Conectividade e Expansão de Alto Desempenho Cada nó suporta duas portas PCIe 5.0 x16, compatíveis com adaptadores NVIDIA BlueField-3 ou ConnectX-7. Essa capacidade permite configurar interconexões inteligentes (DPU) ou redes de baixa latência com largura de banda superior a 400Gb/s, ampliando o potencial do sistema em data centers orientados a IA, edge computing e virtualização de rede. O sistema também integra suporte a até 4 E1.S NVMe drives hot-swap e 4 slots M.2 NVMe por nó, oferecendo ampla flexibilidade para arquiteturas de armazenamento all-flash de baixa latência. Implementação Estratégica Eficiência Térmica e Gerenciamento Inteligente Com até 9 ventoinhas de 4 cm com controle PWM e sensores térmicos independentes, o ARS-121L-DNR mantém desempenho estável mesmo sob cargas extremas. O sistema monitora temperatura de CPU, chipset e ambiente interno, ajustando dinamicamente a rotação das ventoinhas para maximizar a eficiência térmica e reduzir ruído. O gerenciamento é suportado por AMI BIOS de 32MB SPI Flash e controladora BMC dedicada com porta LAN de 1 GbE, garantindo integração total com plataformas de monitoramento remoto e automação de datacenter. Fontes de Alimentação Redundantes Titanium Level O sistema conta com duas fontes redundantes de 2000W certificadas Titanium (96% de eficiência), oferecendo operação contínua mesmo em caso de falha de um módulo. Essa redundância é essencial em ambientes mission-critical e reduz o risco de downtime não planejado. Melhores Práticas Avançadas Integração com Ambientes Hyperscale O ARS-121L-DNR é ideal para arquiteturas em larga escala que exigem performance previsível e isolamento de carga. A segmentação dual-node permite configurar workloads independentes ou distribuir tarefas paralelas de forma coordenada, mantendo latência mínima entre nós via NVLink. Essa configuração é especialmente eficiente em clusters Kubernetes, ambientes de virtualização intensiva e soluções de AI inferencing distribuído. Governança e Confiabilidade O suporte a ECC Memory e monitoramento abrangente de saúde do sistema proporcionam conformidade com políticas corporativas de resiliência e integridade de dados. O design robusto e a gestão térmica automatizada minimizam falhas por sobreaquecimento — uma das principais causas de indisponibilidade em data centers de alta densidade. Escalabilidade Linear Graças à modularidade por nó, é possível expandir gradualmente a infraestrutura conforme a demanda computacional cresce, sem necessidade de substituição completa de chassis. Isso permite um modelo de crescimento previsível, ideal para empresas que priorizam custo operacional otimizado (OpEx). Medição de Sucesso Os indicadores de sucesso para implementações com o ARS-121L-DNR devem incluir métricas de eficiência energética por teraflop, latência interprocessos (NVLink) e throughput agregado de rede. Além disso, o monitoramento de disponibilidade e consumo térmico médio por nó fornece visibilidade sobre a maturidade operacional da infraestrutura. Empresas que substituem sistemas x86 tradicionais por plataformas Grace CPU Superchip relatam ganhos significativos em densidade de rack e redução

2U NVIDIA Grace Superchip: Desempenho Extremo para HPC e IA Empresarial Em um cenário empresarial marcado por demandas exponenciais de processamento, análise de dados e inteligência artificial, a escolha de infraestrutura computacional torna-se decisiva. O sistema 2U NVIDIA Grace Superchip emerge como uma solução de ponta, integrando CPUs Grace altamente eficientes e GPUs NVIDIA de última geração para atender workloads complexos em HPC, AI, treinamento de modelos de linguagem (LLM) e processamento de dados de alto desempenho. Introdução Contextualização Estratégica Organizações modernas enfrentam um crescimento acelerado de dados e necessidades de processamento paralelo. O gerenciamento eficiente desses recursos é essencial para competitividade. Sistemas convencionais muitas vezes apresentam gargalos em memória, interconectividade CPU-GPU e consumo energético. O 2U NVIDIA Grace Superchip aborda essas limitações, oferecendo uma arquitetura densa e otimizada para máxima eficiência de throughput e latência mínima. Desafios Críticos Os desafios incluem a execução de modelos de IA de larga escala, simulações científicas e workloads analíticos intensivos. Sistemas com CPUs tradicionais podem limitar o desempenho devido à largura de banda de memória restrita e baixa densidade de núcleos. Além disso, a interconectividade GPU-GPU e CPU-GPU é fundamental para acelerar cargas distribuídas, especialmente em ambientes que dependem de treinamentos de deep learning e inferência em tempo real. Custos e Riscos da Inação Ignorar a necessidade de infraestrutura otimizada pode resultar em atrasos críticos na entrega de projetos, aumento do custo total de propriedade e vulnerabilidades operacionais. A incapacidade de processar grandes volumes de dados com eficiência reduz a competitividade e compromete decisões estratégicas baseadas em insights analíticos. Sistemas subdimensionados podem levar a falhas em simulações complexas, degradação de performance de IA e restrições no desenvolvimento de LLMs. Visão Geral do Artigo Este artigo detalha os fundamentos técnicos do 2U NVIDIA Grace Superchip, suas vantagens estratégicas, considerações de implementação, práticas recomendadas, métricas de sucesso e implicações de negócios, fornecendo uma análise aprofundada para gestores de TI e engenheiros de infraestrutura. Desenvolvimento Problema Estratégico Empresas que dependem de computação intensiva enfrentam limitações significativas em termos de densidade de processamento, consumo energético e escalabilidade. Sistemas tradicionais não oferecem largura de banda suficiente entre CPU e GPU, nem suporte a memória de alta velocidade para workloads críticos. Isso impacta diretamente prazos de entrega, capacidade de análise e competitividade em setores que demandam inovação rápida, como AI, análise de dados e modelagem científica. Consequências da Inação Manter infraestruturas desatualizadas aumenta o risco de gargalos computacionais, falhas de processamento e atrasos em projetos de AI e HPC. A falta de memória rápida e de interconexão PCIe de última geração reduz eficiência energética e aumenta custos operacionais. Organizações podem experimentar atrasos no treinamento de LLMs, lentidão em simulações HPC e limitação de análise em tempo real, resultando em perda de oportunidades estratégicas. Fundamentos da Solução O 2U NVIDIA Grace Superchip integra CPU Grace de 144 núcleos com até 960GB de memória ECC LPDDR5X, garantindo baixa latência e alto desempenho por watt. Suporta até 2 GPUs NVIDIA H100 NVL ou L40S conectadas via PCIe 5.0 x16, permitindo interconectividade de alta velocidade entre CPU e GPU, bem como comunicação eficiente GPU-GPU. O sistema possui 4 bays NVMe E1.S hot-swap e slots M.2 PCIe 5.0 x4, oferecendo armazenamento ultra-rápido para workloads exigentes. A arquitetura 2U permite densidade elevada sem comprometer resfriamento ou redundância. Com até 3 fontes de 2000W Titanium Level (96% de eficiência), o sistema mantém confiabilidade energética e operação contínua em ambientes críticos. O design modular facilita upgrades de memória e GPUs, garantindo escalabilidade para atender demandas futuras. Implementação Estratégica A implementação requer alinhamento com objetivos de performance e eficiência energética. A seleção de GPUs (H100 NVL vs L40S) deve considerar workloads específicos de AI ou HPC. O gerenciamento do sistema pode ser realizado via IPMI 2.0, Redfish API ou Supermicro Update Manager, garantindo monitoramento detalhado de CPU, memória, temperatura e ventilação. Para integração eficiente, recomenda-se planejamento de conectividade PCIe e NVMe, além de testes de resfriamento para workloads máximos. Considerações de segurança incluem uso de TPM onboard, monitoramento contínuo via KVM-over-LAN e políticas de governança para manutenção de firmware atualizado e compliance. Melhores Práticas Avançadas Otimizações avançadas incluem balanceamento de workloads entre CPUs Grace e GPUs, priorização de memória ECC LPDDR5X para tarefas críticas e utilização de slots M.2 para cache de alta velocidade. Configurações de resfriamento devem ser ajustadas dinamicamente via controle de fan PWM, evitando hotspots e mantendo eficiência energética máxima. Para workloads de IA distribuída, a configuração PCIe e interconectividade GPU-GPU são cruciais. Técnicas de particionamento de memória e pipelines paralelos aumentam throughput sem comprometer integridade de dados. Ferramentas de monitoramento e alerta antecipado minimizam riscos de falha em produção. Medição de Sucesso Indicadores incluem desempenho por watt, latência de memória, throughput PCIe, tempo de treinamento de LLMs e eficiência de resfriamento. Métricas de confiabilidade abrangem uptime do sistema, falhas de ventiladores, consistência de temperatura e integridade de memória ECC. Avaliações periódicas permitem ajustes finos, garantindo alinhamento contínuo entre performance técnica e metas de negócio. Conclusão Resumo dos Pontos Principais O 2U NVIDIA Grace Superchip representa uma solução robusta para empresas que demandam HPC e AI de alta performance. Combina CPU Grace de 144 núcleos, memória ECC LPDDR5X de até 960GB, GPUs NVIDIA de ponta e armazenamento NVMe ultra-rápido, garantindo densidade, eficiência energética e escalabilidade. Considerações Finais Investir em infraestrutura de ponta reduz riscos de falhas, aumenta competitividade e permite exploração de workloads complexos, desde simulações HPC até treinamento de modelos de AI. A implementação estratégica, monitoramento contínuo e práticas avançadas de otimização são essenciais para extrair máximo valor do investimento. Perspectivas Futuras Com a evolução de LLMs e workloads distribuídos, a demanda por sistemas densos, eficientes e altamente interconectados continuará crescendo. O 2U NVIDIA Grace Superchip posiciona empresas para adoção de tecnologias emergentes, mantendo performance e eficiência energética. Próximos Passos Práticos Organizações devem realizar auditoria de workloads atuais, identificar gargalos em CPU-GPU e memória, planejar upgrades moduláveis e implementar monitoramento avançado para assegurar que o sistema opere com performance ideal. Considerar integração com soluções de AI e HPC distribuídas maximiza retorno sobre investimento.

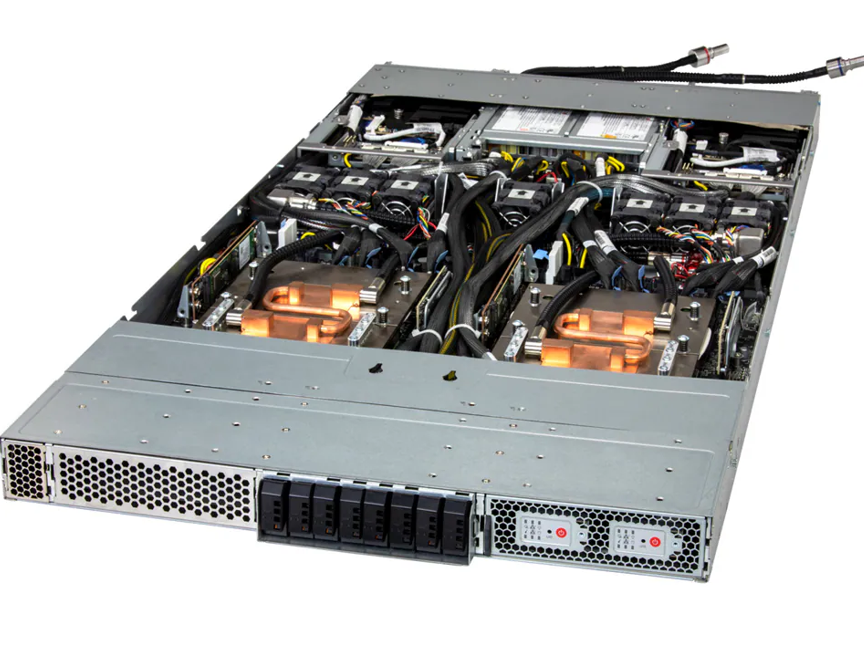

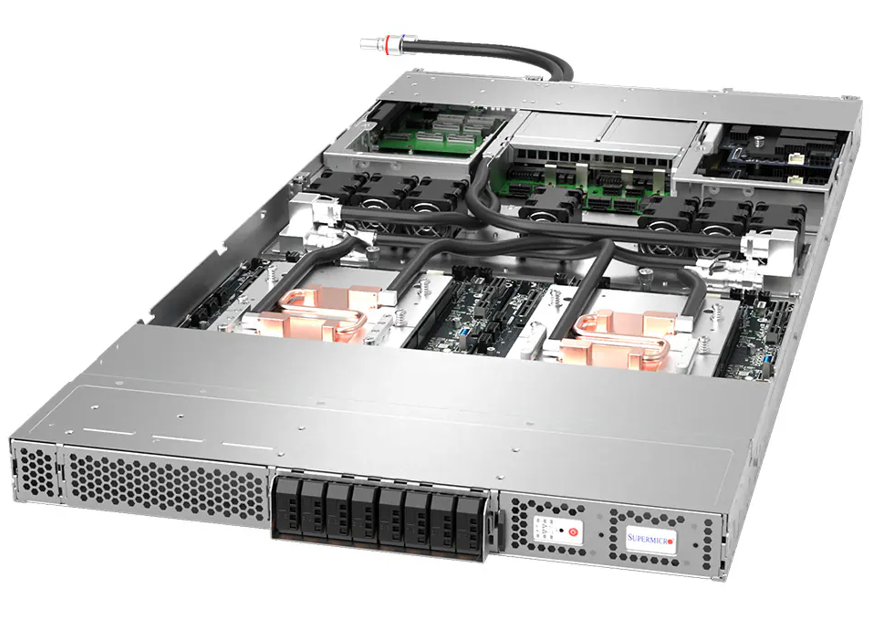

1U 2-Node NVIDIA GH200 Grace Hopper Superchip: Performance AI e HPC Avançada No cenário empresarial atual, a demanda por processamento de alto desempenho para Inteligência Artificial (AI), Machine Learning e Large Language Models (LLMs) cresce de forma exponencial. Organizações que não adotam sistemas otimizados para HPC (High Performance Computing) enfrentam limitações críticas de capacidade, escalabilidade e eficiência, impactando diretamente sua competitividade e tempo de entrega de insights estratégicos. O 1U 2-Node NVIDIA GH200 Grace Hopper Superchip surge como uma solução de vanguarda, oferecendo integração de CPU Grace e GPU H100, além de suporte para armazenamento E1.S de alta velocidade. Sua arquitetura compacta e líquida refrigerada permite densidade máxima sem comprometer performance ou confiabilidade. Este artigo explora profundamente os aspectos técnicos, estratégicos e operacionais do sistema, detalhando como ele resolve desafios críticos de infraestrutura, otimiza workloads de AI e HPC, e oferece retorno mensurável para empresas que dependem de alto desempenho computacional. Desafio Estratégico em HPC e AI Limitações de Infraestrutura Tradicional Servidores tradicionais de rack não conseguem sustentar workloads intensivos de AI e LLM devido à limitação de memória, largura de banda e densidade de GPU. A falta de integração estreita entre CPU e GPU aumenta a latência e reduz o throughput, impactando diretamente o desempenho de treinamento de modelos complexos e inferência em tempo real. Implicações para Negócios Organizações que não atualizam sua infraestrutura enfrentam aumento de custos operacionais, menor velocidade de inovação e risco de ficar atrás da concorrência em mercados que dependem de insights baseados em AI. Fundamentos da Solução: Arquitetura 1U 2-Node NVIDIA GH200 Integração Grace CPU + H100 GPU Cada nó do sistema conta com o Grace Hopper Superchip da NVIDIA, integrando CPU de 72 núcleos e GPU H100. Essa integração reduz latência de comunicação, melhora throughput em workloads HPC e AI, e possibilita execução simultânea de múltiplos pipelines de processamento sem comprometimento de performance. Memória e Armazenamento de Alta Performance O sistema suporta até 480GB de ECC LPDDR5X por nó, com GPU adicional de até 96GB ECC HBM3. O armazenamento E1.S NVMe em hot-swap oferece IOPS extremamente altos, essencial para treinamento de modelos de AI que manipulam grandes volumes de dados. Esta configuração reduz gargalos de I/O e melhora a eficiência energética, conectando diretamente performance técnica com redução de custos operacionais. Design Compacto e Refrigerado a Líquido O 1U 2-Node permite densidade sem comprometer o resfriamento. O sistema líquido refrigerado D2C (Direct to Chip) mantém TDPs de até 2000W por CPU, garantindo operação estável em workloads críticos. Além disso, o monitoramento de CPU, memória, ventoinhas e temperatura oferece governança e compliance operacional em data centers exigentes. Implementação Estratégica Considerações de Integração O sistema é altamente compatível com infraestruturas existentes em data centers, oferecendo slots PCIe 5.0 x16 para expansão adicional e conectividade com NVIDIA BlueField-3 ou ConnectX-7. Isso permite integração com redes de alta velocidade e soluções de armazenamento distribuído, mantendo interoperabilidade e escalabilidade. Gerenciamento e Monitoramento O BIOS AMI de 64MB e ferramentas de gerenciamento avançadas permitem configuração detalhada de ACPI, monitoramento de saúde do sistema e controle de ventoinhas via PWM, garantindo que cada componente opere dentro de parâmetros ideais. Essa abordagem reduz riscos operacionais e aumenta a confiabilidade. Melhores Práticas Avançadas Otimização de Workloads AI Para maximizar performance em treinamento de modelos, recomenda-se balancear cargas entre CPU e GPU, monitorar consumo de memória HBM3, e ajustar configuração de armazenamento E1.S NVMe para otimizar throughput. Estratégias de cooling e gerenciamento de energia devem ser implementadas para prevenir throttling em picos de demanda. Segurança e Governança O sistema permite segmentação de rede via BlueField-3, proporcionando isolamento de workloads críticos. Além disso, a redundância de fontes de 2700W Titanium garante continuidade operacional e segurança contra falhas elétricas, atendendo requisitos de compliance de data centers corporativos. Medição de Sucesso Métricas de Performance Indicadores-chave incluem throughput de treinamento de modelos AI, latência de inferência, utilização de memória LPDDR5X e HBM3, IOPS de armazenamento E1.S, e eficiência energética medida por performance por Watt. Monitoramento contínuo permite ajustes proativos e melhoria contínua. ROI e Impacto no Negócio Empresas que implementam o 1U 2-Node NVIDIA GH200 experimentam redução de tempo de treinamento de modelos, aceleração de pipelines de AI, maior densidade computacional e menor custo total de operação por unidade de processamento, conectando diretamente tecnologia a vantagem competitiva estratégica. Conclusão O 1U 2-Node NVIDIA GH200 Grace Hopper Superchip representa um avanço significativo para empresas que buscam alto desempenho em AI, Deep Learning e HPC. Sua arquitetura integrada, resfriamento líquido e suporte de memória/armazenamento de última geração resolvem desafios críticos de infraestrutura e performance. Ao adotar esta solução, organizações aumentam sua capacidade de inovação, reduzem riscos de operação e garantem competitividade em setores que dependem de processamento intensivo de dados. A implementação estratégica do sistema permite extração máxima de valor de cada componente, conectando performance técnica a resultados tangíveis de negócio. Com a evolução contínua de AI e HPC, o 1U 2-Node NVIDIA GH200 está posicionado como plataforma futura-proof, capaz de suportar demandas emergentes e expandir conforme necessidades corporativas crescem.

1U 2-Node NVIDIA GH200: Desempenho Máximo em HPC e IA Empresarial O avanço das demandas de High Performance Computing (HPC) e Inteligência Artificial (IA) exige soluções de hardware que combinem densidade, escalabilidade e eficiência energética. O sistema 1U 2-Node NVIDIA GH200 Grace Hopper Superchip surge como resposta a essa necessidade, oferecendo desempenho extremo em um espaço físico compacto, ideal para data centers corporativos que buscam maximizar capacidade computacional sem comprometer espaço ou eficiência. Introdução Contextualização Estratégica Empresas líderes em setores de pesquisa científica, finanças e modelagem preditiva estão cada vez mais dependentes de sistemas capazes de processar grandes volumes de dados em paralelo. A integração do NVIDIA GH200 Grace Hopper Superchip em um formato 1U de alta densidade permite que organizações aumentem significativamente a capacidade de processamento, mantendo operações de data center enxutas e controlando custos de energia e refrigeração. Desafios Críticos Os desafios técnicos incluem gerenciamento térmico, latência de comunicação entre CPU e GPU e integração com infraestrutura existente. Sem uma arquitetura otimizada, a performance de cargas de trabalho críticas de IA e LLM pode ser seriamente limitada, impactando prazos de entrega e eficiência operacional. Custos e Riscos da Inação A não atualização de sistemas para plataformas modernas como a 1U 2-Node NVIDIA GH200 pode resultar em custos elevados de oportunidade, maior consumo de energia, menor throughput em análise de dados e perda de competitividade frente a empresas que adotam soluções HPC avançadas. Visão Geral do Artigo Este artigo detalhará o desafio estratégico de alta densidade computacional, explorará as consequências da inação, apresentará os fundamentos técnicos do GH200, abordará a implementação estratégica e práticas avançadas, e finaliza com métricas de sucesso para avaliar a eficácia da solução. Desenvolvimento Problema Estratégico Organizações que dependem de processamento intensivo de IA enfrentam gargalos significativos em infraestrutura tradicional. A comunicação entre CPU e GPU é um fator crítico: latências elevadas podem degradar o desempenho em tarefas de treinamento de LLM ou inferência em deep learning. Soluções convencionais de 2U ou 4U podem ocupar mais espaço, aumentar consumo de energia e complicar a manutenção física do data center. Consequências da Inação Manter sistemas legados implica menor densidade de computação, maior consumo energético por operação e aumento do risco de falhas térmicas. Além disso, a incapacidade de processar workloads de IA em tempo real pode resultar em atrasos na entrega de insights estratégicos, afetando diretamente decisões de negócio e inovação. Fundamentos da Solução O 1U 2-Node NVIDIA GH200 combina dois nós em um único rack 1U, cada um equipado com: CPU NVIDIA Grace de 72 núcleos, integrando processamento de IA e gerenciamento de memória eficiente. GPU NVIDIA H100 Tensor Core, on-board, com interconexão NVLink Chip-2-Chip (C2C) de alta largura de banda (900GB/s) para comunicação ultra-rápida entre CPU e GPU. Memória onboard LPDDR5X de até 480GB ECC, mais até 96GB ECC HBM3 dedicada à GPU. Armazenamento direto E1.S NVMe, além de slots M.2 NVMe, permitindo I/O de altíssima performance. Essa arquitetura permite throughput elevado, baixa latência e maior eficiência energética, crucial para workloads de treinamento de deep learning e inferência em LLMs. Implementação Estratégica A implantação exige avaliação do layout físico do data center, garantindo fluxo de ar adequado e refrigeração eficiente, especialmente quando a opção de resfriamento direto ao chip (D2C) é utilizada. O gerenciamento de energia, com fontes redundantes Titanium 2700W, assegura continuidade operacional mesmo em cenários críticos. Integração com sistemas de rede existentes deve considerar compatibilidade com NVIDIA BlueField-3 ou ConnectX-7 para maximizar desempenho de interconexão e permitir virtualização de recursos de GPU quando necessário. Melhores Práticas Avançadas Para workloads distribuídos, recomenda-se balancear tarefas entre os dois nós para otimizar utilização da memória ECC e throughput NVLink. A monitoração constante via BIOS AMI e ferramentas de gerenciamento permite ajustes dinâmicos em ventoinhas, temperatura e consumo, prevenindo degradação de performance ou falhas térmicas. Além disso, o planejamento de expansão deve considerar slots PCIe 5.0 x16 FHFL e M.2 adicionais, garantindo escalabilidade sem comprometer densidade 1U. Medição de Sucesso Métricas críticas incluem: Throughput em operações de treinamento de IA (TFLOPS ou operações por segundo). Latência entre CPU e GPU via NVLink C2C. Eficiência energética medida em desempenho por watt. Taxa de utilização de memória ECC e HBM3. Disponibilidade e uptime do sistema com monitoramento contínuo de temperaturas e voltagens. Esses indicadores fornecem visão clara da performance operacional e retorno sobre investimento em ambientes empresariais de alta demanda. Conclusão Resumo dos Pontos Principais O 1U 2-Node NVIDIA GH200 oferece solução compacta, eficiente e de altíssimo desempenho para HPC, IA e LLM, integrando Grace CPU, H100 GPU, NVLink C2C e memória ECC avançada. Sua arquitetura aborda gargalos críticos de latência, densidade e escalabilidade. Considerações Finais Investir em plataformas de alta densidade como o GH200 é estratégico para organizações que buscam maximizar capacidade computacional, reduzir custos de energia e acelerar inovação em IA e deep learning. Perspectivas Futuras A evolução de arquiteturas 1U com integração CPU-GPU tende a se expandir, com maior densidade de memória, interconexões de mais alta largura de banda e suporte a workloads ainda mais complexos de IA e LLM. Próximos Passos Práticos Empresas devem avaliar suas demandas de processamento, planejar a infraestrutura de refrigeração e energia, e preparar a integração de rede e armazenamento para adotar sistemas 1U 2-Node GH200 de forma eficiente e segura.

Servidor 1U NVIDIA GH200 Grace Hopper: Alta performance em IA e HPC empresarial Introdução Em um cenário corporativo cada vez mais orientado por dados e inteligência artificial, a demanda por servidores de alta densidade e desempenho extremo tornou-se crítica. Organizações que buscam acelerar projetos de High Performance Computing (HPC) ou treinar modelos avançados de IA e LLMs enfrentam desafios significativos relacionados à latência, largura de banda de memória e consumo energético. A inação ou a adoção de soluções inadequadas pode resultar em atrasos de projeto, custos operacionais elevados e perda de competitividade em setores que dependem de análise avançada de dados. Neste contexto, o 1U GPU Server NVIDIA GH200 Grace Hopper surge como uma solução de ponta, oferecendo integração entre CPU e GPU com NVLink de alta largura de banda e memória coerente de até 576GB. Este artigo detalhará os principais desafios empresariais, fundamentos técnicos do servidor, estratégias de implementação e métricas de sucesso, oferecendo uma visão estratégica para empresas que buscam excelência em HPC e IA. Desenvolvimento Problema Estratégico O aumento exponencial de dados e a complexidade dos modelos de IA exigem servidores que combinem processamento massivo, baixa latência e alta largura de banda de memória. Servidores convencionais frequentemente sofrem gargalos entre CPU e GPU, limitando o desempenho em aplicações críticas como LLMs e treinamento de redes neurais profundas. Além disso, a densidade física dos data centers impõe restrições quanto a consumo de energia e gerenciamento térmico. O 1U padrão apresenta espaço limitado para dissipação de calor e armazenamento rápido, criando um desafio adicional para arquiteturas de alto desempenho. Consequências da Inação Ignorar essas necessidades pode levar a projetos de IA com tempos de treinamento prolongados, maior consumo energético e risco de falhas em workloads críticos. Empresas podem enfrentar atrasos em iniciativas estratégicas, perda de insights competitivos e custos operacionais elevados. A falta de integração eficiente entre CPU e GPU também limita a escalabilidade de aplicações corporativas de IA. Fundamentos da Solução O 1U GPU Server NVIDIA GH200 integra a CPU Grace e GPU H100 no mesmo chip, utilizando o NVLink Chip-to-Chip (C2C) com 900GB/s de largura de banda, reduzindo drasticamente a latência e maximizando a transferência de dados. A memória coerente de até 480GB LPDDR5X e 96GB HBM3 permite manipular grandes modelos de IA sem depender de memória adicional externa, crucial para treinamentos de LLM. O sistema ainda suporta drives E1.S NVMe diretamente conectados à CPU, garantindo armazenamento de alta velocidade com baixa latência, enquanto o resfriamento líquido D2C assegura estabilidade térmica mesmo em cargas extremas. Implementação Estratégica Para maximizar os benefícios deste servidor, recomenda-se configuração do sistema com monitoramento ativo de CPU, GPU e sensores de chassis via BMC, garantindo que as operações de HPC e IA permaneçam dentro das especificações térmicas e de consumo de energia. O gerenciamento de energia via ACPI permite recuperação automática após falhas de energia, essencial para operações críticas 24/7. A escolha de drives E1.S NVMe alinhados com workloads específicos, juntamente com otimização da memória LPDDR5X e HBM3, permite que empresas ajustem o desempenho segundo diferentes cenários de treinamento e inferência de modelos de IA. Melhores Práticas Avançadas 1. Planejamento térmico avançado: utilizar sensores de PWM e controle inteligente de ventiladores combinados com resfriamento líquido D2C para maximizar densidade computacional em 1U. 2. Gerenciamento de memória: balancear cargas entre LPDDR5X e HBM3 para reduzir latência em treinamento de LLM. 3. Otimização de interconexão: explorar NVLink C2C para cargas de trabalho híbridas CPU/GPU, garantindo throughput máximo e minimizando gargalos. Medição de Sucesso Indicadores críticos incluem tempo de treinamento de modelos de IA, throughput de dados entre CPU e GPU, utilização eficiente de memória e estabilidade térmica sob carga máxima. Métricas como consumo energético por operação, latência de interconexão e IOPS de armazenamento NVMe também devem ser monitoradas para validar o retorno do investimento. Conclusão O 1U GPU Server NVIDIA GH200 Grace Hopper representa uma solução estratégica para empresas que buscam alto desempenho em IA, LLM e HPC. Sua arquitetura integrada, memória coerente e resfriamento avançado permitem superar limitações de servidores tradicionais, oferecendo eficiência, escalabilidade e confiabilidade. Ao adotar esta solução, organizações podem reduzir tempos de treinamento de IA, aumentar a densidade computacional em racks 1U e minimizar riscos operacionais. A implementação cuidadosa de monitoramento, otimização de memória e gerenciamento térmico assegura que a tecnologia entregue todo seu potencial estratégico. Perspectivas futuras incluem a expansão da integração de CPU-GPU em chips únicos e evolução de tecnologias de memória de alta largura de banda, permitindo que empresas mantenham vantagem competitiva em workloads críticos.