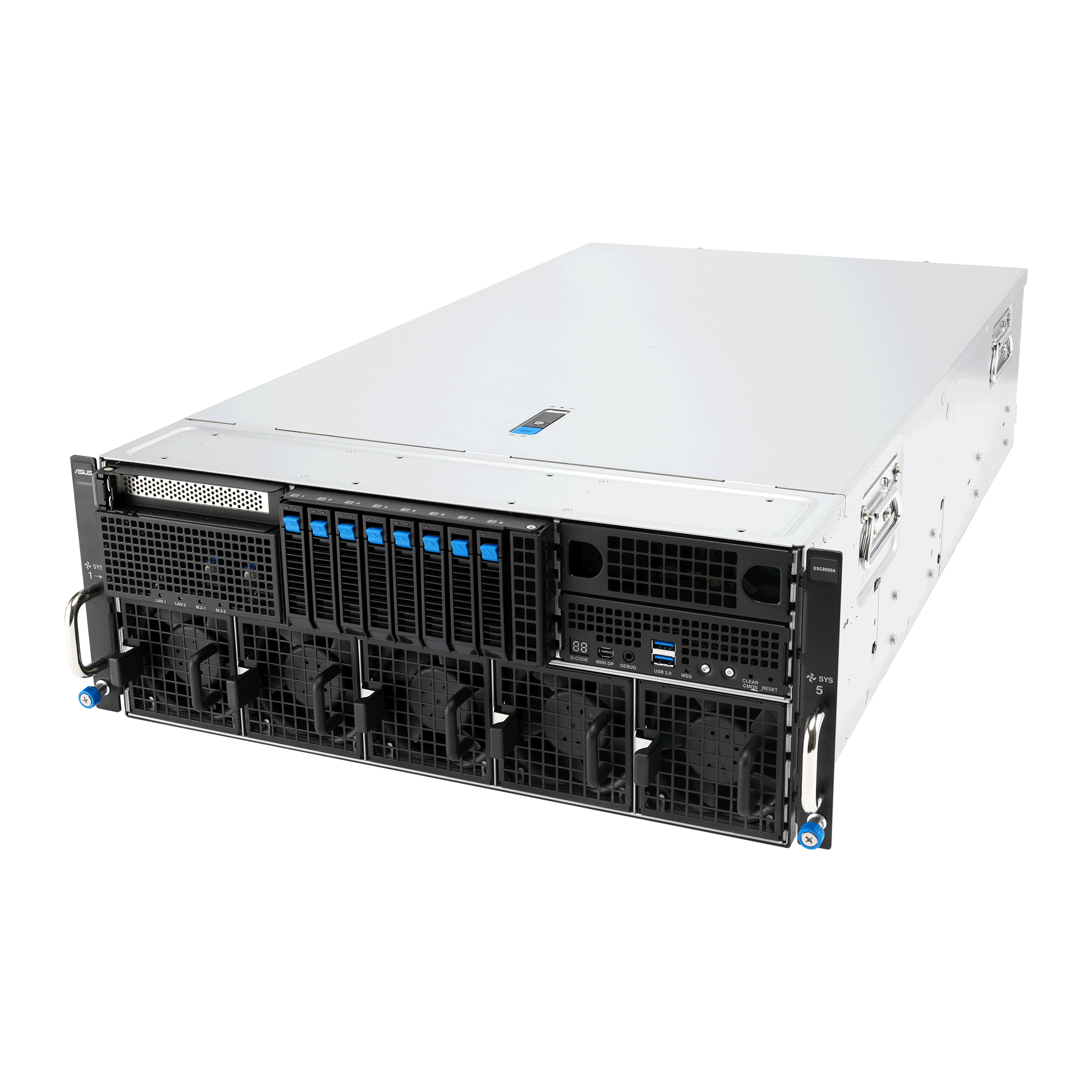

ASUS ESC8000A-E13: servidor GPU AMD EPYC 9005 para IA e HPC em larga escala Introdução O avanço das arquiteturas de inteligência artificial e de computação de alto desempenho (HPC) está redefinindo os parâmetros de eficiência e escalabilidade nos data centers modernos. Nesse cenário, o ASUS ESC8000A-E13 surge como um marco tecnológico: um servidor GPU 4U de alta densidade, projetado para maximizar desempenho computacional com suporte aos processadores AMD EPYC™ 9005 e até oito GPUs NVIDIA H200 ou RTX PRO™ 6000 Blackwell Server Edition. Com sua engenharia de hardware voltada para cargas de trabalho massivamente paralelas e análises de dados complexas, o ESC8000A-E13 atende a demandas empresariais que vão desde treinamento de modelos de IA generativa até simulações científicas e renderização 3D em larga escala. Este artigo analisa, sob uma perspectiva técnica e estratégica, como o servidor da ASUS se posiciona como uma solução de próxima geração para ambientes corporativos e institucionais de alta exigência. Custos e riscos da inação nesse contexto incluem perda de competitividade, gargalos de processamento e limitações na adoção de frameworks de IA cada vez mais complexos. Implementar infraestrutura baseada em processadores e GPUs de última geração, como a do ESC8000A-E13, é mais do que uma atualização técnica — é uma decisão estratégica de continuidade operacional e de inovação. Nos próximos tópicos, exploraremos a arquitetura, recursos, implicações e melhores práticas relacionadas ao uso do ASUS ESC8000A-E13 em ambientes de missão crítica. O problema estratégico: a escalabilidade computacional em ambientes de IA e HPC A computação empresarial vive um ponto de inflexão. Modelos de IA, especialmente os de linguagem e multimodais, cresceram em tamanho e complexidade exponenciais. Isso impõe desafios de infraestrutura que vão além da capacidade tradicional de CPU. A necessidade de processar grandes volumes de dados com mínima latência e máxima eficiência energética torna os servidores GPU essenciais para manter a competitividade e reduzir o custo por operação. Empresas que continuam baseadas em arquiteturas convencionais enfrentam limitações em throughput, gargalos de rede e baixa eficiência energética. O impacto disso é direto: ciclos de treinamento mais longos, atrasos na entrega de resultados e aumento no custo total de propriedade (TCO). A transição para servidores otimizados para IA e HPC — como o ASUS ESC8000A-E13 — é, portanto, uma resposta estratégica a uma pressão de mercado e tecnológica simultânea. Consequências da inação: perda de eficiência e escalabilidade Ignorar a evolução das arquiteturas computacionais baseadas em GPU representa um risco operacional e competitivo. Ambientes corporativos que mantêm infraestruturas desatualizadas enfrentam custos crescentes com energia e refrigeração, bem como baixa densidade de processamento por rack. Além disso, há limitações de compatibilidade com frameworks de IA modernos, que demandam interconectividade de alta largura de banda entre GPU e CPU. No contexto de HPC e IA, onde a latência e a paralelização são fatores críticos, cada segundo perdido em processamento impacta diretamente a produtividade e o ROI. O ASUS ESC8000A-E13 elimina esses gargalos ao oferecer suporte direto a até oito GPUs de 600 W conectadas via PCIe 5.0 de alta largura de banda, garantindo comunicação direta entre CPU e GPU sem estrangulamento de dados. Fundamentos técnicos da solução ASUS ESC8000A-E13 Arquitetura de Processamento: AMD EPYC™ 9005 No coração do ESC8000A-E13 estão dois soquetes SP5 (LGA 6096), compatíveis com processadores AMD EPYC 9005 de até 500W TDP cada. Esses processadores, baseados na arquitetura Zen 5c, oferecem até 192 núcleos e 384 threads, suportando memória DDR5 em 12 canais por CPU. Essa configuração assegura throughput massivo e largura de banda suficiente para alimentar múltiplas GPUs em paralelo. A compatibilidade com DDR5 6400 MHz e suporte a até 3 TB de memória RAM permite que o servidor gerencie conjuntos de dados de escala petabyte em aplicações de IA e HPC. Essa combinação reduz significativamente o tempo de acesso à memória e melhora o desempenho em tarefas de aprendizado profundo e análise preditiva. Suporte a GPU e interconexão PCIe 5.0 O ESC8000A-E13 foi desenvolvido para atender ambientes de densidade máxima de GPU. Ele suporta oito placas duplas NVIDIA H200 ou RTX PRO 6000 Blackwell, cada uma operando com até 600W. A infraestrutura de 11 slots PCIe 5.0 inclui conexões diretas à CPU para minimizar latência e maximizar throughput de dados. Essa arquitetura é ideal para cenários como treinamento de modelos LLMs, simulações de engenharia e visualização científica, onde a sinergia entre CPU e GPU determina o desempenho final. A conectividade direta entre processadores e GPUs elimina intermediários de rede, reduzindo latência e potencializando a eficiência computacional. Armazenamento e expansão Em termos de armazenamento, o servidor oferece oito baias hot-swap de 2.5”, com suporte a até seis drives NVMe U.2 via backplane configurável conforme o controlador RAID/HBA instalado. Essa flexibilidade é essencial para aplicações que exigem armazenamento híbrido de alta performance, como cache local de modelos de IA e bancos de dados em memória. Com suporte a PCIe Gen5, o servidor pode incorporar NICs e DPUs de alta largura de banda, fundamentais para operações distribuídas em clusters de IA. A presença de um design toolless da ASUS simplifica a manutenção e reduz o tempo de parada, característica crítica em ambientes de produção contínua. Implementação estratégica e integração corporativa O sucesso de uma implementação baseada no ASUS ESC8000A-E13 depende da integração equilibrada entre processamento, armazenamento e gerenciamento. O servidor é acompanhado pelo ASUS Control Center Enterprise, que permite monitoramento e administração centralizada em múltiplos nós — ideal para data centers empresariais e laboratórios de pesquisa distribuídos. Além disso, o módulo ASMB12-iKVM oferece gerenciamento fora de banda (BMC AST2600), viabilizando controle remoto completo e mitigando riscos de downtime. Essa camada de gerenciamento duplo — in-band e out-of-band — eleva o padrão de confiabilidade e governança da infraestrutura. Melhores práticas avançadas Para maximizar a eficiência do ESC8000A-E13, recomenda-se uma abordagem orientada a workloads. Configurações de GPU devem ser alinhadas às características de cada modelo de aplicação, considerando consumo energético, resfriamento e largura de banda de interconexão. O uso de fontes redundantes 3+1 de 3200W 80 PLUS Titanium garante estabilidade sob carga máxima e contribui para eficiência energética acima de

ASUS ESC8000-E12: Potência em IA e HPC com arquitetura GPU 4U O ASUS ESC8000-E12 representa o mais alto nível de engenharia em servidores para cargas de trabalho de inteligência artificial (IA), treinamento de modelos generativos e computação de alto desempenho (HPC). Com suporte a até oito GPUs de última geração, processadores Intel Xeon 6 e arquitetura PCIe 5.0, o sistema foi projetado para data centers que demandam escalabilidade, eficiência térmica e confiabilidade operacional. Em um cenário em que a IA generativa redefine fluxos de trabalho empresariais, o ESC8000-E12 se destaca por oferecer densidade de GPU em 4U com eficiência energética e arquitetura otimizada para reduzir latência e maximizar throughput. Este artigo analisa em profundidade sua relevância estratégica, fundamentos técnicos e aplicações críticas. Contexto Estratégico: Desempenho Computacional como Pilar da IA Empresarial O avanço da IA generativa e dos modelos de linguagem de larga escala (LLMs) exige uma infraestrutura capaz de processar trilhões de parâmetros com eficiência e estabilidade. Data centers empresariais enfrentam o desafio de equilibrar poder computacional com consumo energético e densidade física. O ASUS ESC8000-E12 surge nesse contexto como uma plataforma convergente para treinamento, inferência e HPC híbrido. Sua compatibilidade com GPUs NVIDIA H200, RTX PRO 6000 Blackwell e Intel Gaudi 3 o torna versátil em diferentes cenários — de pesquisa científica e simulações 3D a ambientes corporativos com IA embarcada em aplicações de negócio. Problema Estratégico: Limitações dos Ambientes de IA Tradicionais Grande parte das infraestruturas corporativas enfrenta gargalos de desempenho ao escalar aplicações de IA. O uso de sistemas legados ou servidores GPU convencionais gera: Latência elevada entre GPU e CPU devido à falta de interconexões PCIe otimizadas. Baixa eficiência térmica em configurações densas sem design de resfriamento escalável. Limitada largura de banda de memória e incapacidade de suportar processadores com TDP elevado. Essas restrições impactam diretamente a viabilidade de projetos de IA generativa e HPC em larga escala. O ASUS ESC8000-E12 foi desenvolvido para superar esses limites, oferecendo uma arquitetura moderna, escalável e otimizada para cargas computacionais simultâneas. Consequências da Inação: Competitividade e Eficiência em Risco Ignorar a modernização da infraestrutura pode resultar em: Custos operacionais crescentes devido à ineficiência energética e manutenção complexa. Perda de competitividade frente a concorrentes que adotam GPUs de nova geração com maior eficiência por watt. Tempo de treinamento excessivo em modelos de IA, impactando diretamente o time-to-market de inovações. Com o ESC8000-E12, a ASUS oferece uma resposta técnica a esses desafios, aliando densidade de GPU, eficiência térmica e conectividade PCIe 5.0 para ambientes empresariais de missão crítica. Fundamentos da Solução: Arquitetura Técnica do ASUS ESC8000-E12 1. Potência de Processamento com Intel Xeon 6 O servidor é equipado com dois processadores Intel Xeon 6 em soquetes LGA 4710, suportando até 350W TDP por CPU. Essa configuração fornece desempenho extremo em tarefas paralelas e operações intensivas em memória, essenciais para cargas de IA, análise de dados e HPC. Com suporte a até 32 slots DIMM DDR5 (8 canais por CPU), o sistema atinge até 4TB de memória, operando em frequências de até 6400MHz (1DPC). Essa arquitetura de memória de alta largura de banda garante que as GPUs possam operar em máxima eficiência, eliminando gargalos entre CPU e memória principal. 2. Densidade de GPU em 4U O design 4U do ESC8000-E12 comporta até oito GPUs duplas de alta performance, incluindo as novas NVIDIA H200 e RTX PRO 6000 Blackwell Server Edition, cada uma com até 600W de consumo. Essa densidade permite compactar poder computacional maciço em um único chassi, otimizando espaço e consumo por rack. 3. Conectividade PCIe 5.0 e Interconexões Diretas Com múltiplos slots PCIe Gen5 x16, o servidor garante conexões diretas entre CPU, GPU e NIC/DPU, reduzindo latência e aumentando throughput. O suporte a dual M.2 Gen5 permite boot rápido e armazenamento local ultrarrápido para cargas críticas de inicialização e cache. Implementação Estratégica: Infraestrutura Otimizada para IA e HPC Integração de GPU e Rede de Alta Velocidade O ESC8000-E12 oferece suporte dedicado para interfaces de rede de alta largura de banda, como NICs e DPUs baseadas em NVIDIA BlueField-3, permitindo integração direta com clusters InfiniBand e redes Ethernet aceleradas. Essa configuração possibilita a criação de pods de IA escaláveis com comunicação GPU-GPU de baixa latência. Gerenciamento e Segurança Corporativa O sistema incorpora o ASUS Control Center Enterprise para gerenciamento in-band e o módulo ASMB12-iKVM para controle out-of-band via BMC AST2600, proporcionando monitoramento em tempo real e controle remoto completo. Essa dupla camada de gestão permite reduzir downtime e aumentar a resiliência operacional. Complementando a segurança, o servidor conta com um Root-of-Trust em hardware, reforçando a integridade do firmware e prevenindo ataques de cadeia de suprimentos, um requisito crítico para data centers corporativos e ambientes de nuvem híbrida. Melhores Práticas Avançadas: Eficiência, Escalabilidade e Manutenção Design Toolless e Manutenção Simplificada O chassi incorpora um design toolless (sem ferramentas) exclusivo da ASUS, permitindo substituição rápida de componentes e GPUs sem interromper operações. Essa característica reduz custos de manutenção e aumenta a disponibilidade do sistema — essencial em operações 24×7 de HPC e IA. Escalabilidade e Redundância Energética Com uma fonte redundante 3+1 de 3200W 80 PLUS Titanium, o ESC8000-E12 garante estabilidade mesmo sob carga total de GPU. O suporte a entrada elétrica de 20 a 240 Vac assegura compatibilidade global e eficiência energética excepcional. Gestão Térmica Avançada O sistema foi projetado para operar de forma estável entre 10°C e 35°C, utilizando fluxo de ar otimizado e controle térmico inteligente. Essa gestão térmica permite o uso de GPUs de alto consumo em ambientes densos sem risco de throttling. Medição de Sucesso: Indicadores de Desempenho e Eficiência O sucesso de uma implementação baseada no ESC8000-E12 pode ser avaliado por métricas como: Throughput GPU total (TFLOPS agregados em operação sustentada). Eficiência energética por watt considerando o consumo combinado CPU+GPU. Disponibilidade operacional (uptime > 99,99%) em ambientes críticos. Escalabilidade horizontal em clusters de IA com comunicação GPU-GPU otimizada. Esses indicadores demonstram o equilíbrio entre desempenho extremo e sustentabilidade operacional, posicionando o ESC8000-E12 como uma escolha ideal para instituições de pesquisa, provedores de nuvem e corporações

ASUS ESC NB8-E11: desempenho máximo com NVIDIA Blackwell para IA empresarial Introdução O avanço da inteligência artificial empresarial exige uma infraestrutura de computação cada vez mais especializada, capaz de lidar com modelos de larga escala, processamento paralelo e latências mínimas entre GPUs. Nesse contexto, a ASUS apresenta o ESC NB8-E11, um servidor 10U NVIDIA® Blackwell HGX™ B200 de oito GPUs, projetado para operar como o coração computacional de uma AI Factory corporativa. O cenário atual de IA corporativa não é apenas uma corrida por poder de processamento, mas uma disputa por eficiência energética, escalabilidade e interoperabilidade entre aceleradores. A dificuldade de escalar modelos generativos ou inferências em larga escala sem gargalos de I/O e consumo extremo de energia tem levado muitas empresas a reavaliar suas arquiteturas. O ASUS ESC NB8-E11 surge exatamente nesse ponto crítico: uma plataforma projetada para oferecer equilíbrio entre densidade de GPU, eficiência térmica e integração de rede de alta velocidade, pronta para cargas de trabalho de IA generativa, treinamento de LLMs e HPC corporativo. Este artigo explora em profundidade o design técnico e estratégico do ESC NB8-E11, abordando desafios, fundamentos arquitetônicos, metodologias de implementação e práticas avançadas de operação em ambientes empresariais. O Problema Estratégico: IA em Escala e o Colapso da Infraestrutura Tradicional À medida que as empresas adotam IA generativa e modelos de linguagem de bilhões de parâmetros, os data centers convencionais enfrentam limitações estruturais. As topologias PCIe tradicionais e arquiteturas baseadas em CPU não conseguem mais fornecer a largura de banda e a conectividade necessárias entre múltiplas GPUs. Isso resulta em ineficiências de treinamento, desperdício de energia e aumento do tempo de inferência — problemas que impactam diretamente o time-to-value dos projetos de IA. Além disso, o crescimento exponencial dos conjuntos de dados torna o trânsito interno entre GPUs um gargalo crítico. Nesse cenário, empresas que não investem em infraestruturas otimizadas para IA enfrentam riscos competitivos significativos: lentidão em desenvolvimento de modelos, custos de energia insustentáveis e incapacidade de integrar pipelines de IA em escala corporativa. Consequências da Inação: Custo Competitivo e Risco Tecnológico Ignorar a evolução da infraestrutura de IA pode levar a um colapso operacional. Organizações que mantêm sistemas baseados em GPU convencionais, sem interconexão dedicada ou resfriamento otimizado, enfrentam: Consumo energético desproporcional, com custos de TCO (Total Cost of Ownership) elevados. Bottlenecks entre GPUs, limitando o throughput de dados. Baixa eficiência térmica, exigindo sistemas de refrigeração mais caros e menos sustentáveis. Obsolescência tecnológica acelerada, especialmente diante da rápida evolução das arquiteturas NVIDIA Blackwell e Intel Xeon 5ª geração. O resultado é uma infraestrutura incapaz de sustentar treinamento contínuo de modelos de IA, comprometendo tanto a inovação quanto a rentabilidade. Fundamentos da Solução: Arquitetura NVIDIA Blackwell e Intel Xeon 5ª Geração Integração Total com NVIDIA HGX B200 O ESC NB8-E11 utiliza o módulo NVIDIA HGX™ B200, um design de referência para servidores de oito GPUs Blackwell interligadas via NVLink™, oferecendo 1.800 GB/s de largura de banda direta GPU-to-GPU. Essa interconectividade elimina o gargalo de comunicação típico em ambientes PCIe puros, permitindo escalabilidade quase linear em cargas de IA distribuída. Cada GPU Blackwell é capaz de processar modelos de múltiplos trilhões de parâmetros, combinando eficiência energética superior e aceleração nativa para operações FP8 e FP16 — essenciais em treinamento de IA generativa e simulações científicas. Potência de Processamento com Intel Xeon 5ª Geração Com duas CPUs Intel® Xeon® Scalable de 5ª geração (até 350W cada), o ESC NB8-E11 proporciona alto throughput de dados e suporte a DDR5 5600 MHz em 32 slots DIMM — até 8 canais por CPU. Essa arquitetura entrega até 8 TB de memória total, reduzindo latências em inferência e treinamento local. Além disso, o suporte à 5ª geração de barramento PCIe Gen5 multiplica a largura de banda disponível para NICs, DPUs e controladoras NVMe, assegurando máxima sinergia entre CPU e GPU. Topologia Um-para-Um GPU–NIC Diferente de implementações tradicionais, o ASUS ESC NB8-E11 adota uma topologia 1 GPU : 1 NIC, com suporte a até oito interfaces de rede dedicadas. Essa arquitetura garante máximo throughput e baixa latência em workloads distribuídas, essenciais em treinamentos de IA em múltiplos nós. Implementação Estratégica: Design, Energia e Escalabilidade Eficiência Térmica Avançada com Engenharia de Fluxo de Ar Dedicado O ESC NB8-E11 apresenta um sistema térmico otimizado, com túneis de fluxo de ar independentes para CPUs e GPUs, assegurando refrigeração eficiente em configurações de alta densidade. Esse design maximiza a confiabilidade do sistema mesmo em ambientes de alta carga contínua. A estrutura 10U possibilita manutenção simplificada e integração em racks padrão de data centers empresariais, sem necessidade de soluções líquidas complexas. Energia com Redundância e Eficiência 80 PLUS Titanium Equipado com seis fontes redundantes (5+1) de 3000W cada, o sistema atinge o nível 80 PLUS® Titanium, o padrão mais alto de eficiência energética do setor. Essa certificação assegura redução significativa no desperdício de energia e maior confiabilidade operacional, reduzindo o risco de downtime em operações críticas de IA. Capacidade de Expansão e Interoperabilidade O servidor oferece até 11 slots PCIe, incluindo 10 PCIe Gen5 x16 e 1 Gen4 x8, garantindo compatibilidade com DPUs NVIDIA BlueField-3, controladoras RAID, adaptadores de rede de baixa latência e placas de expansão NVMe. Esse nível de flexibilidade permite às empresas configurar topologias específicas de interconexão e armazenamento, otimizadas conforme o tipo de workload — seja treinamento, inferência, ou HPC híbrido. Melhores Práticas Avançadas: Operação e Otimização Gerenciamento Unificado com ASUS Control Center O ESC NB8-E11 integra o ASUS Control Center (ACC) e o módulo ASMB11-iKVM, permitindo gerenciamento remoto de todo o sistema com monitoramento em tempo real de consumo, temperatura, falhas e estado das GPUs. Essa visibilidade granular permite mitigar falhas antes que se tornem incidentes críticos, além de otimizar o balanceamento de carga térmica e energética em clusters de IA. Integração com NVIDIA AI Enterprise e BlueField DPUs A compatibilidade nativa com o NVIDIA AI Enterprise Stack e a capacidade de incluir DPUs BlueField-3 criam uma plataforma ideal para AI Factories — ambientes empresariais que integram computação, rede e armazenamento em uma única malha otimizada. Essa

Introdução: a nova geração de servidores GPU para IA empresarial Com o avanço da inteligência artificial generativa, do aprendizado profundo e das simulações de alto desempenho (HPC), o papel dos servidores GPU de nova geração tornou-se estratégico. O ASUS ESC8000-E12P representa a síntese entre densidade computacional extrema e arquitetura aberta, combinando processadores Intel Xeon 6 com a plataforma NVIDIA MGX — um padrão projetado para acelerar o desenvolvimento e a padronização de servidores voltados para IA e nuvem de larga escala. No cenário corporativo atual, empresas enfrentam o desafio de equilibrar desempenho, eficiência e escalabilidade em suas infraestruturas de IA. Soluções proprietárias, embora poderosas, limitam a flexibilidade. É nesse contexto que a ASUS se destaca com o ESC8000-E12P, oferecendo uma arquitetura aberta, modular e totalmente compatível com as GPUs mais avançadas do mercado — de NVIDIA H200 e RTX PRO 6000 Blackwell até o Intel Gaudi 3 PCIe AI Accelerator. Ignorar a evolução dessa categoria de servidores significa perder competitividade em um mercado onde o tempo de treinamento e a eficiência energética definem margens e diferenciais estratégicos. O ESC8000-E12P surge como uma plataforma de referência para empresas que buscam consolidar suas operações de IA e HPC com previsibilidade, segurança e compatibilidade futura. Este artigo aprofunda os fundamentos técnicos e estratégicos dessa solução, detalhando sua arquitetura MGX, seus diferenciais em conectividade PCIe Gen5, a integração com Intel Xeon 6 e as implicações práticas para data centers empresariais. O problema estratégico: escalar IA e HPC com flexibilidade e padronização A evolução das cargas de trabalho de IA trouxe um novo paradigma: o modelo de hardware precisa acompanhar ciclos de inovação cada vez mais curtos. Modelos generativos, simulações físicas e inferências multimodais exigem infraestrutura escalável, de alta largura de banda e com densidade térmica controlada. Empresas que ainda dependem de servidores GPU de gerações anteriores enfrentam gargalos sérios — desde limitações de barramento PCIe até ineficiências térmicas que restringem o uso simultâneo de GPUs de alto TDP. Além disso, a falta de compatibilidade entre plataformas de hardware e frameworks de IA reduz a agilidade no deployment de novos modelos. O desafio é duplo: manter compatibilidade com diferentes aceleradores (NVIDIA, Intel, AMD) e, ao mesmo tempo, sustentar padrões de desempenho e confiabilidade corporativos. É aqui que o conceito de NVIDIA MGX se torna decisivo, e o ESC8000-E12P se posiciona como uma resposta técnica e estratégica a esse impasse. Consequências da inação: risco operacional e obsolescência acelerada Ignorar a necessidade de atualizar infraestruturas GPU em tempos de IA generativa é uma forma de obsolescência antecipada. Organizações que continuam operando em arquiteturas anteriores à geração PCIe 5.0 enfrentam taxas de transferência inferiores, latências elevadas e limitações na comunicação GPU-GPU — o que se traduz diretamente em custos maiores por ciclo de treinamento. Além disso, a ausência de compatibilidade com arquiteturas MGX implica em dependência de soluções proprietárias, dificultando upgrades graduais e forçando substituições completas de chassis. Isso eleva o TCO (Total Cost of Ownership) e compromete a flexibilidade de roadmap tecnológico da empresa. Do ponto de vista energético, servidores não otimizados para GPUs de até 600 watts também sofrem penalidades térmicas e de eficiência, afetando tanto a estabilidade quanto a vida útil do equipamento. O resultado é um ciclo vicioso de manutenção, ineficiência e custo de oportunidade perdido. Fundamentos técnicos: arquitetura MGX e Intel Xeon 6 Compatibilidade total com NVIDIA MGX A arquitetura MGX é o pilar técnico do ESC8000-E12P. Ela define um padrão modular e escalável para servidores de IA, permitindo que fabricantes como a ASUS integrem GPUs, DPUs e processadores de múltiplos fornecedores com interoperabilidade total. Isso significa que o mesmo chassi pode acomodar tanto GPUs NVIDIA H200 quanto aceleradores Intel Gaudi 3 — um avanço em flexibilidade sem precedentes. Processadores Intel Xeon 6: equilíbrio entre densidade e eficiência Equipado com dois processadores Intel Xeon 6, o ESC8000-E12P oferece até 86 núcleos por CPU e suporte para memória DDR5 de 6400 MHz, em oito canais, com TDP de até 350 watts por soquete. Essa configuração permite entregar throughput extremo em pipelines de inferência e simulação, com ganho significativo em eficiência energética por watt. Infraestrutura PCIe 5.0 de alta largura de banda Com cinco slots PCIe 5.0 adicionais, o servidor suporta NICs de alta velocidade, DPUs e interconexões para escalar clusters GPU de forma linear. Essa flexibilidade é essencial para ambientes que demandam topologias complexas, como redes InfiniBand e malhas NVLink interligadas, otimizando o desempenho em workloads distribuídas. Implementação estratégica: eficiência e escalabilidade no data center A implementação do ASUS ESC8000-E12P em um ambiente corporativo exige considerar tanto aspectos físicos (energia, refrigeração, espaço) quanto lógicos (orquestração, segurança e manutenção). A ASUS simplifica esse processo com um design toolless que facilita o acesso a componentes internos e acelera manutenções, reduzindo significativamente o tempo de parada operacional. Em termos de gerenciamento, o servidor é integrado ao ASUS Control Center, uma solução de administração unificada que permite monitorar consumo energético, temperaturas, alertas e status de GPUs e DIMMs. Essa integração de hardware e software cria uma camada de governança técnica essencial para ambientes de missão crítica. O uso de soluções de gerenciamento com Root-of-Trust em nível de hardware adiciona uma camada adicional de segurança, protegendo a integridade do firmware e garantindo conformidade com políticas de segurança corporativas e regulamentações de data centers sensíveis. Melhores práticas avançadas e otimizações Gerenciamento térmico para GPUs de 600 W O ESC8000-E12P foi projetado para suportar até oito GPUs de 600 watts, o que exige um sistema térmico de alto desempenho. A ASUS emprega engenharia de fluxo de ar otimizada e sensores térmicos distribuídos para garantir a estabilidade mesmo sob carga máxima — um fator crítico para clusters de IA contínuos. Escalabilidade horizontal com interconexões PCIe A presença de cinco slots PCIe 5.0 adicionais possibilita a expansão de rede com adaptadores InfiniBand e DPUs de última geração. Essa capacidade é vital para ambientes que pretendem crescer em topologias em malha (mesh) ou fat-tree, otimizando a comunicação GPU-GPU entre múltiplos nós. Gerenciamento inteligente via ASUS Control Center O ASUS Control Center oferece visibilidade

Servidor ASUS XA NB3I-E12 com NVIDIA HGX B300: desempenho extremo para IA empresarial e CSPs Introdução: a nova era da computação acelerada No cenário atual de inteligência artificial e computação em larga escala, o poder de processamento deixou de ser apenas uma questão de desempenho bruto e passou a representar a capacidade de transformar dados em vantagem competitiva. O ASUS XA NB3I-E12 com NVIDIA HGX B300 surge como um marco nesse contexto — uma plataforma arquitetada para cargas de trabalho intensivas de IA generativa, aprendizado profundo e HPC, projetada para atender desde provedores de nuvem (CSPs) até grandes corporações, instituições de pesquisa e setores como financeiro e automotivo. Mais do que um servidor, o XA NB3I-E12 representa a materialização de uma visão: a convergência entre desempenho extremo, eficiência energética e escalabilidade modular. Com 8 GPUs NVIDIA Blackwell Ultra integradas em uma placa HGX B300, conectividade InfiniBand embutida e processadores Intel Xeon 6 de última geração, ele redefine o padrão de computação acelerada no data center moderno. Nas seções a seguir, exploramos em profundidade os fundamentos técnicos, a lógica de design e as implicações estratégicas dessa arquitetura para ambientes corporativos e de pesquisa que dependem de IA em escala. O problema estratégico: os limites da infraestrutura convencional de IA Modelos de IA generativa e LLMs de última geração, como os com centenas de bilhões de parâmetros, desafiam as infraestruturas tradicionais. O gargalo não está apenas na capacidade de processamento, mas na interconexão entre GPUs, na latência de comunicação e na eficiência energética de clusters cada vez mais densos. Empresas e provedores de nuvem enfrentam o dilema de como equilibrar desempenho, consumo energético e custo operacional. As soluções anteriores baseadas em arquiteturas Hopper ou Ampere já atingiam seu teto de escalabilidade quando o volume de dados e o tamanho dos modelos ultrapassavam limites práticos de throughput e interconexão. É nesse ponto que o ASUS XA NB3I-E12 com HGX B300 se diferencia — não apenas pela força computacional, mas pela coesão entre GPU, CPU, memória e rede, formando uma base homogênea para IA empresarial em escala. Consequências da inação: custo e obsolescência tecnológica Ignorar a evolução das plataformas aceleradas implica riscos significativos. Ambientes que mantêm infraestrutura baseada em GPUs de gerações anteriores enfrentam tempos de treinamento até 4 vezes maiores e custos energéticos que inviabilizam o TCO (Total Cost of Ownership) a médio prazo. Além disso, a ausência de interconexões de alta largura de banda limita o paralelismo entre GPUs, reduzindo a eficiência em workloads distribuídos. Em um mercado em que o tempo de inferência e o custo por token processado determinam vantagem competitiva, permanecer com hardware legado representa não apenas perda de performance, mas de relevância estratégica. Fundamentos da solução: arquitetura HGX B300 e o equilíbrio entre potência e eficiência O coração do ASUS XA NB3I-E12 é o módulo NVIDIA HGX B300, equipado com GPUs Blackwell Ultra. Essa geração marca uma ruptura com o paradigma anterior, integrando a segunda geração do Transformer Engine com núcleos Tensor otimizados e suporte nativo a FP8, o que permite ganhos de até 4x no treinamento e até 11x na inferência em comparação à geração Hopper. O diferencial técnico está na interconexão NVLink de 5ª geração, que atinge impressionantes 1,8 TB/s de largura de banda GPU a GPU. Esse backbone interno elimina gargalos de comunicação, permitindo que as 8 GPUs operem como um único sistema lógico coerente — essencial para o treinamento de modelos de larga escala e workloads intensivos de inferência. Complementando o conjunto, o sistema incorpora dois processadores Intel Xeon 6 com arquitetura P-core e suporte a DDR5 6400 MHz, garantindo um canal de dados amplo e consistente para as GPUs. O suporte a 32 DIMMs e até 4 TB de RAM oferece base sólida para lidar com datasets complexos e pipelines de IA em tempo real. Com até 10 unidades NVMe de baixa latência, a arquitetura também elimina gargalos de I/O, mantendo o fluxo contínuo de dados do armazenamento para as GPUs — requisito essencial em treinamentos com grandes volumes de dados. Implementação estratégica: modularidade e escalabilidade no data center A arquitetura do XA NB3I-E12 foi projetada com modularidade e escalabilidade como princípios centrais. O chassi suporta 5 slots PCIe Gen 5 (4×16 + 1×8), garantindo flexibilidade para adicionar aceleradores, controladoras de rede adicionais ou unidades de expansão conforme o crescimento das demandas. O elemento distintivo é a integração de 8 portas InfiniBand CX8 diretamente em cada GPU, com suporte a até 800G/s por SXM. Essa integração reduz drasticamente a dependência de NICs adicionais e simplifica a topologia de rede interna, reduzindo latência, cabos e consumo energético. É uma mudança estrutural que redefine como clusters de IA são conectados e escalados. Essa simplificação física e lógica tem impacto direto em TCO e eficiência operacional. Menos cabos significam menor dissipação térmica e menos falhas de conexão — fatores críticos para CSPs e data centers corporativos que operam 24/7. Melhores práticas avançadas: desempenho sustentável e serviço contínuo Além da potência bruta, o ASUS XA NB3I-E12 se destaca pela abordagem integrada de sustentabilidade. Seu design térmico otimizado e o uso de fontes redundantes de 3200W com certificação 80 Plus Titanium permitem até 20% de ganho em desempenho por TCO em comparação com a geração anterior (HGX B200), especialmente em cenários baseados em modelos como Llama MoE 10T (128K GPU). Essa eficiência não é apenas um argumento ambiental, mas uma vantagem competitiva: em larga escala, o custo energético e o resfriamento representam parcela significativa do custo operacional. O XA NB3I-E12 entrega alto desempenho com menor impacto ambiental, promovendo uma operação sustentável sem comprometer throughput. Em termos de manutenção, o design ergonômico e modular com parafusos sem ferramenta, riser-cards de engate rápido e tampas de liberação simples garantem intervenções mais seguras e rápidas. O resultado é menor tempo de inatividade e maior eficiência operacional em ambientes críticos. Medição de sucesso: indicadores de desempenho e eficiência Os resultados mensuráveis do XA NB3I-E12 se refletem em métricas de desempenho diretamente relacionadas ao valor empresarial: Até 11x mais desempenho

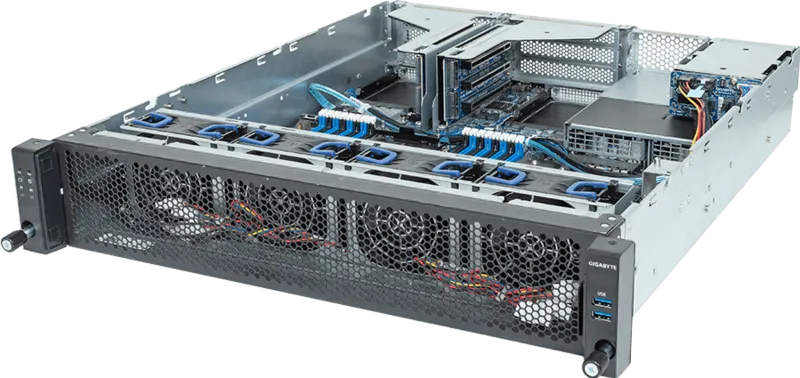

GIGABYTE W533-W30-AA01: potência, silêncio e eficiência para estações de trabalho corporativas Introdução No cenário empresarial atual, onde a convergência entre performance computacional, eficiência energética e gestão centralizada é determinante para a produtividade, a GIGABYTE W533-W30-AA01 se posiciona como uma solução de workstation robusta e silenciosa, ideal para profissionais que operam com cargas de trabalho intensivas em processamento gráfico e computacional. Este modelo foi concebido para unir a potência da arquitetura Intel® Core™ de 14ª/13ª/12ª geração à flexibilidade de expansão PCIe Gen5, oferecendo um equilíbrio raro entre desempenho bruto e estabilidade térmica em ambientes corporativos. Organizações que dependem de renderização 3D, simulações de engenharia, processamento de imagens médicas ou modelagem de dados complexos enfrentam desafios constantes em performance e confiabilidade. Uma workstation incapaz de sustentar alta densidade de carga, ou com limitação térmica, impacta diretamente os fluxos de trabalho e a produtividade. Nesse contexto, a W533-W30-AA01 foi projetada para garantir desempenho contínuo sob estresse, com ruído reduzido e gestão remota integrada, suprindo as exigências de equipes de engenharia, pesquisa e design corporativo. Ao longo deste artigo, exploraremos as características arquitetônicas, soluções térmicas, mecanismos de segurança e gerenciamento remoto que tornam a GIGABYTE W533-W30-AA01 uma escolha estratégica para empresas que exigem performance sustentável e governança tecnológica eficiente. O desafio estratégico: performance versus estabilidade Empresas que executam workloads intensivos, como renderização CAD, visualização científica ou análise de dados volumosos, enfrentam um dilema recorrente: como obter alto desempenho sem comprometer o conforto térmico e acústico dos ambientes de trabalho. A W533-W30-AA01 responde a essa demanda combinando tecnologias de ponta e design orientado à confiabilidade. Arquitetura híbrida Intel® Core™ de 14ª geração O suporte aos processadores Intel® Core™ de 14ª, 13ª e 12ª geração proporciona uma base flexível que equilibra desempenho e eficiência energética. A arquitetura híbrida introduz núcleos de performance e eficiência (P-cores e E-cores), coordenados pelo Intel Thread Director, que otimiza a distribuição das cargas de trabalho em tempo real. Isso permite que a workstation atinja máxima produtividade em tarefas paralelas, ao mesmo tempo em que preserva o consumo energético sob cargas leves. Essa abordagem é particularmente relevante para fluxos de trabalho híbridos — como ambientes de desenvolvimento que alternam entre compilação, simulação e renderização gráfica. A capacidade de adaptação dinâmica da arquitetura Intel, aliada à interface PCIe Gen5, garante que a plataforma suporte GPUs e aceleradores de nova geração sem gargalos de comunicação. Expansão e conectividade de última geração A W533-W30-AA01 incorpora 2 slots PCIe Gen5 (x16 e x8) e um slot adicional PCIe Gen3 x4, abrindo espaço para configurações com GPUs profissionais, placas de captura ou módulos de aceleração AI. A presença de 4 slots M.2 PCIe Gen4 x4 — incluindo um conectado diretamente ao processador — viabiliza a instalação de SSDs NVMe de alta velocidade, reduzindo significativamente o tempo de leitura e gravação em projetos que manipulam grandes volumes de dados. Complementando a infraestrutura, a presença de até 8 baias SATA 3.5″/2.5″ assegura a combinação entre armazenamento quente (hot data) em NVMe e armazenamento frio (cold data) em SATA, permitindo uma arquitetura de dados hierarquizada e eficiente para diferentes tipos de workload. Eficiência térmica e silêncio operacional Um dos diferenciais da série W5 é sua atenção à acústica e controle térmico. Projetada com o conceito “Insistence of Low Noise”, a GIGABYTE W533-W30-AA01 mantém níveis de ruído abaixo de 50 dB mesmo sob carga máxima com GPUs como a NVIDIA RTX A6000. Esse desempenho é resultado de um sistema de ventilação otimizado e da integração do módulo GIGABYTE Selected FAN com o controle inteligente GSM Smart FAN Speed Control. Em ambientes corporativos, o controle de ruído não é apenas uma questão de conforto, mas de ergonomia cognitiva. Ambientes com níveis sonoros elevados prejudicam a concentração e reduzem a produtividade. Assim, o projeto térmico da W533 não apenas protege o hardware contra degradação, mas também favorece o bem-estar dos profissionais em escritórios e laboratórios de alta densidade computacional. Design térmico profissional O sistema de ventilação passa por verificação térmica GIGABYTE, garantindo que a dissipação de calor seja equilibrada entre CPU, GPU e armazenamento, sem criar zonas de calor que impactem a longevidade dos componentes. Essa arquitetura é crucial para suportar aceleradores multi-slot e garantir estabilidade contínua em cargas intensivas de renderização e IA. Fundamentos da solução: desempenho validado e segurança integrada As workstations da série W5 foram testadas e validadas em uma ampla gama de cargas de trabalho, incluindo renderização 3D, aprendizado profundo e computação científica. A compatibilidade com GPUs profissionais como a NVIDIA RTX A6000 e AMD Radeon PRO W7900 confirma sua vocação para ambientes que exigem processamento paralelo intensivo. Em cenários como engenharia assistida por computador (CAD), diagnóstico médico digital (DME) e pesquisa científica, a integração entre CPU, GPU e subsistemas de armazenamento é determinante. A W533 entrega essa sinergia, assegurando que dados fluam sem gargalos, com latência mínima entre memória, armazenamento e aceleradores gráficos. Hardware Security com TPM 2.0 A segurança de dados em nível de hardware é reforçada pela disponibilidade de um módulo TPM 2.0 opcional. Esse componente atua como um cofre criptográfico, armazenando chaves, senhas e certificados digitais para evitar acesso não autorizado. Em aplicações corporativas, o TPM é essencial para conformidade com normas de segurança, autenticação baseada em hardware e proteção de identidades digitais de endpoints. Gestão corporativa e manutenção inteligente A GIGABYTE diferencia-se pela oferta de um ecossistema de gestão robusto e sem custo adicional, baseado em uma arquitetura com processador dedicado à administração de sistemas. GIGABYTE Management Console (GMC) O GIGABYTE Management Console permite o monitoramento e controle em tempo real por interface gráfica via navegador, sem necessidade de agentes externos. Compatível com o protocolo IPMI, o GMC integra métricas de desempenho, alertas de falha e logs automáticos de eventos — incluindo gravações pré-falha de 30 segundos, o que acelera a análise de incidentes. Essa abordagem facilita o gerenciamento remoto de pequenas infraestruturas ou clusters de estações, reduzindo custos operacionais e tempo de inatividade. Além disso, o GMC permite integrar o monitoramento de dispositivos SAS, SATA e NVMe, além de controladoras Broadcom MegaRAID,

Introdução No cenário atual de computação visual e inteligência artificial aplicada a ambientes corporativos, as estações de trabalho profissionais deixaram de ser simples ferramentas de criação e se tornaram elementos estratégicos de produtividade. A GIGABYTE W733-W30-AA01 representa esse novo paradigma — uma workstation que combina potência bruta com design térmico inteligente e capacidades de gerenciamento corporativo avançadas. Empresas que operam em áreas como engenharia, CAD, ciência de dados, inferência de IA e criação de conteúdo 3D enfrentam desafios crescentes em termos de desempenho, confiabilidade e dissipação térmica. A incapacidade de alinhar hardware e cargas de trabalho pode gerar gargalos críticos, perda de eficiência e custos elevados em manutenção. Neste artigo, exploramos em profundidade a arquitetura, inovações e implicações estratégicas da W733-W30-AA01, detalhando como sua combinação de hardware de ponta e design industrial otimizado permite às organizações elevar o nível de eficiência e confiabilidade em fluxos de trabalho visuais complexos. O Desafio Estratégico: Potência Computacional e Estabilidade Operacional Contexto Empresarial e Necessidades Técnicas À medida que o uso de modelagem 3D, simulações físicas e inferência de IA se expande para setores como manufatura, medicina e arquitetura, o papel da workstation evolui para um nó crítico de computação local. Ela precisa processar grandes volumes de dados com latência mínima e sem comprometer a confiabilidade. O desafio está em equilibrar potência e controle térmico, garantindo operação contínua mesmo sob cargas intensas. A W733-W30-AA01 responde a essa exigência ao oferecer compatibilidade com processadores Intel Core de 14ª, 13ª e 12ª geração, suporte a PCIe 5.0 e arquitetura térmica otimizada. Essa base técnica permite lidar com aplicações de renderização, CAD, DME e IA com desempenho previsível e consistente. O Papel da Arquitetura Híbrida Intel Core A inclusão de processadores Intel Core de 14ª geração com arquitetura híbrida de desempenho e Intel Thread Director garante uma distribuição eficiente de threads entre núcleos de alta performance e eficiência. Essa abordagem não apenas melhora o throughput de tarefas simultâneas, mas também otimiza o consumo energético, uma preocupação crescente em ambientes corporativos de longa duração. Além disso, a presença de gráficos integrados Intel UHD com arquitetura Xe amplia a flexibilidade da estação em tarefas que demandam processamento visual leve, liberando a GPU dedicada para workloads mais pesados. Consequências da Inação: O Custo de Infraestruturas Obsoletas Workstations desatualizadas são fontes recorrentes de perda de produtividade e risco operacional. Em ambientes de engenharia e design, cada segundo de renderização impacta o tempo de entrega e o custo do projeto. A ausência de suporte a PCIe 5.0 e NVMe Gen4 limita a largura de banda disponível para GPUs e SSDs, criando gargalos que reduzem o ROI dos investimentos em software e talento humano. Outro risco crítico é o aquecimento excessivo e o ruído operacional. Sistemas mal projetados comprometem a integridade dos componentes, elevam o consumo de energia e afetam o conforto em escritórios abertos. A GIGABYTE abordou essas limitações com um sistema de ventilação otimizado, que mantém níveis de ruído abaixo de 50 dB mesmo sob carga total, garantindo ambiente produtivo e silencioso. Fundamentos da Solução: Arquitetura Técnica e Inovação Estrutural Design e Eficiência Térmica Avançada A W733-W30-AA01 incorpora um design industrial robusto e funcional, com malhas de ventilação reforçadas, furos amplos para dissipação de calor e dutos de ar dedicados para separar os fluxos de CPU e GPU. Esse projeto reduz o acúmulo de calor interno e maximiza a eficiência dos ventiladores modulares GIGABYTE, ajustados dinamicamente via GSM Smart FAN Speed Control. Além do desempenho térmico, o design adota uma estética corporativa refinada — um equilíbrio entre presença visual e praticidade operacional. Recursos como travas físicas e painéis reforçados refletem a preocupação da marca com segurança física e integridade dos dados. Capacidade Computacional e Expansibilidade Com 2 slots PCIe Gen5 (x16 e x8) e 1 slot PCIe Gen3 x4, a workstation permite integrar GPUs de última geração, como NVIDIA RTX A6000, Radeon PRO W7900 e GeForce RTX 4080. Essa flexibilidade é vital para empresas que precisam escalar entre fluxos de trabalho de renderização, simulação e IA. Em termos de armazenamento, a presença de 4 slots M.2 PCIe Gen4 e até 8 baias SATA viabiliza arquiteturas híbridas de armazenamento, com camadas NVMe para dados quentes e SATA para arquivamento. Essa estrutura oferece um balanceamento natural entre desempenho e custo, sem depender de soluções externas de storage. Gerenciamento Corporativo e Segurança de Hardware Um dos diferenciais estratégicos da W733-W30-AA01 é a integração de recursos típicos de servidores corporativos, como TPM 2.0 para autenticação segura e o GIGABYTE Management Console (GMC), que oferece monitoramento remoto e registro automático de eventos do sistema. Empresas podem ainda adotar o GIGABYTE Server Management (GSM), um conjunto de ferramentas que inclui CLI, Agente local, interface Web e aplicativo móvel — permitindo gestão centralizada de clusters de estações ou servidores. Essa camada de gestão reduz significativamente o tempo de resposta de TI em ambientes distribuídos, além de melhorar a rastreabilidade e a conformidade regulatória. Implementação Estratégica: Integração e Adoção Empresarial A adoção de uma workstation como a W733-W30-AA01 exige análise multidimensional: perfil da carga de trabalho, integração com pipelines existentes e políticas de segurança corporativa. Empresas de engenharia e pesquisa, por exemplo, podem distribuir tarefas entre GPU dedicada e CPU híbrida, maximizando o throughput total e reduzindo latência. A integração com plataformas de virtualização e gerenciamento remoto também é direta, graças ao suporte IPMI e Redfish. Isso permite incorporar a workstation em clusters de computação híbrida, ampliando a escalabilidade sem perda de controle. A abordagem modular da GIGABYTE garante compatibilidade de longo prazo com novos componentes, um fator crítico em contextos onde o ciclo de vida do hardware ultrapassa 5 anos. Melhores Práticas Avançadas: Otimização, Escalabilidade e Confiabilidade Balanceamento térmico ativo — manter as zonas de ventilação livres e calibrar o GSM Smart FAN conforme perfil de uso. Estratégia de armazenamento híbrido — priorizar M.2 NVMe para dados de acesso contínuo e SATA para backups locais. Gerenciamento remoto integrado — habilitar o GMC e GSM Server para monitoramento preditivo e controle de firmware. Validação de GPU e drivers

Servidor GIGABYTE R243-E33-AAL1: Eficiência Energética e Desempenho Avançado com AMD EPYC 8004 Introdução O avanço das tecnologias de borda (edge computing) e o crescimento exponencial da demanda por infraestrutura de alto desempenho redefiniram os requisitos para servidores empresariais. Nesse contexto, o GIGABYTE R243-E33-AAL1 surge como um marco na integração entre eficiência energética, desempenho escalável e confiabilidade operacional, oferecendo uma resposta concreta aos desafios de custo e sustentabilidade enfrentados por empresas que operam em ambientes de missão crítica. A transição global para arquiteturas otimizadas para IA, telecomunicações e cloud híbrida exige soluções que conciliem densidade computacional com eficiência térmica e elétrica. O R243-E33-AAL1, equipado com o processador AMD EPYC™ 8004, traduz essa necessidade em uma proposta técnica consistente: maximizar performance por watt e reduzir o Total Cost of Ownership (TCO) sem comprometer a estabilidade e a escalabilidade. Empresas que negligenciam essa transição enfrentam custos operacionais crescentes, ineficiência energética e limitações de performance que comprometem sua competitividade digital. Este artigo analisa, em profundidade, como a arquitetura do R243-E33-AAL1 redefine o equilíbrio entre potência, eficiência e confiabilidade — pilares fundamentais para o futuro dos data centers corporativos. Problema Estratégico: Eficiência e Sustentabilidade em Infraestruturas Críticas O dilema da densidade computacional e do consumo energético A busca por maior densidade de processamento levou à saturação energética em muitos data centers. À medida que cargas de trabalho baseadas em IA e virtualização se expandem, o consumo elétrico e a dissipação térmica tornam-se obstáculos críticos. Organizações enfrentam o desafio de aumentar o poder de cálculo sem elevar proporcionalmente os custos energéticos ou a pegada de carbono. Nesse contexto, a arquitetura tradicional de servidores baseada em processadores generalistas não consegue atender simultaneamente a requisitos de desempenho, escalabilidade e eficiência térmica. Surge, portanto, a necessidade de soluções otimizadas em nível de silício e plataforma — como o AMD EPYC 8004 — capazes de equilibrar potência computacional e economia operacional. Consequências da Inação: Custo e Obsolescência Operacional Ignorar a otimização energética e arquitetural na infraestrutura de TI pode gerar impactos financeiros e competitivos severos. O aumento contínuo de consumo energético eleva o OPEX, enquanto limitações de hardware reduzem a vida útil do investimento em servidores. Empresas que mantêm infraestruturas baseadas em arquiteturas anteriores a PCIe Gen5 e DDR5 enfrentam gargalos de throughput, maior latência e custos crescentes de refrigeração. Além disso, o não alinhamento com padrões emergentes como CXL 1.1+ e OCP 3.0 reduz a interoperabilidade e a capacidade de expansão, comprometendo futuras atualizações e integração com workloads modernos. O resultado é uma infraestrutura estagnada, incapaz de suportar aplicações de IA, inferência e análises em tempo real — requisitos já presentes em operações edge e telco de nova geração. Fundamentos da Solução: Arquitetura AMD EPYC 8004 e Plataforma GIGABYTE Eficiência e densidade com a microarquitetura Zen 4c O AMD EPYC 8004, baseado na arquitetura de 5 nm “Zen 4c”, representa um avanço substancial em densidade computacional e eficiência por watt. A alta integração de transistores em menor espaço físico permite aumentar o número de núcleos sem elevar o consumo térmico — uma vantagem decisiva para data centers de alta densidade e edge computing. O uso do socket SP6 reduz o custo de materiais (BOM) mantendo compatibilidade futura, uma decisão estratégica que favorece sustentabilidade e longevidade de plataforma. Além disso, o suporte a DDR5 ECC RDIMM com 12 slots e 6 canais de memória garante largura de banda superior e maior integridade de dados, essencial para cargas críticas. Expansão e conectividade PCIe Gen5 Com três slots PCIe Gen5 x16 FHFL dedicados a GPUs e duas interfaces OCP 3.0 Gen5, o R243-E33-AAL1 está preparado para workloads de IA, inferência e visual computing. Essa estrutura modular amplia as possibilidades de integração com aceleradores de nova geração, garantindo maior throughput de dados (até 128 GB/s) e reduzindo gargalos de comunicação. A adoção do padrão PCIe 5.0 também é um fator estratégico de longevidade, permitindo que o servidor suporte futuras gerações de GPUs e NICs sem substituir a infraestrutura principal. Gestão de energia e redundância inteligente Um dos diferenciais técnicos mais relevantes é a implementação de Cold Redundancy, um recurso que desativa automaticamente uma das fontes redundantes (1+1 2700 W 80 PLUS Titanium) quando a carga total do sistema cai abaixo de 40%. Essa lógica proporciona até 10% de aumento na eficiência energética global, reduzindo perdas em cenários de baixa utilização. O sistema de controle automático de ventiladores ajusta dinamicamente a velocidade com base em sensores térmicos, otimizando a dissipação de calor e prolongando a vida útil dos componentes. Isso demonstra uma abordagem integrada de eficiência térmica e elétrica, essencial para data centers que operam 24×7. Implementação Estratégica: Edge e Telecom como Vetores de Adoção Design compacto e robusto para edge computing A crescente integração do 5G à vida moderna impulsiona a necessidade de servidores com formato compacto e profundidade reduzida, capazes de operar em locais não tradicionais. O R243-E33-AAL1 atende precisamente a essa exigência, combinando robustez industrial e footprint otimizado, ideal para estações de borda e ambientes de telecomunicações descentralizados. Sua arquitetura foi projetada para minimizar o TCO por meio de alta eficiência energética e manutenção simplificada — fatores críticos para implementações em larga escala fora de data centers convencionais. Alta disponibilidade com SmaRT e SCMP A confiabilidade é reforçada por tecnologias proprietárias da GIGABYTE, como Smart Ride Through (SmaRT) e Smart Crises Management and Protection (SCMP). O SmaRT assegura continuidade operacional durante falhas de energia, utilizando capacitores que fornecem energia por 10–20 ms — tempo suficiente para acionar uma fonte reserva. Já o SCMP reduz o clock da CPU em situações de sobreaquecimento ou falha de PSU, evitando desligamentos abruptos e protegendo dados e componentes. Essas abordagens representam mecanismos de autoproteção inteligente, alinhados às exigências de uptime contínuo de provedores de telecom e empresas de missão crítica. Segurança e governança de hardware O suporte ao TPM 2.0 garante autenticação de hardware e proteção de chaves criptográficas, atendendo requisitos de compliance e segurança corporativa. Isso é especialmente relevante em cenários de edge, onde os dispositivos operam fora do perímetro tradicional de segurança

Introdução No atual cenário de transformação digital, a convergência entre computação de borda (Edge Computing), redes 5G e cargas de trabalho intensivas em IA redefine as exigências sobre a infraestrutura de TI corporativa. Organizações buscam soluções compactas, eficientes e capazes de operar fora do ambiente tradicional de data centers, sem comprometer desempenho ou confiabilidade. Nesse contexto, o GIGABYTE E243-E30-AAV1 emerge como uma resposta tecnológica robusta e estrategicamente otimizada. Equipado com o processador AMD EPYC™ 8004, este servidor Edge foi projetado para maximizar a eficiência energética e reduzir o Custo Total de Propriedade (TCO), atendendo a aplicações críticas em telecom, nuvem híbrida, IA e visual computing. Ao longo deste artigo, exploraremos em profundidade a arquitetura, os diferenciais técnicos e a visão estratégica que posicionam o E243-E30-AAV1 como uma solução de próxima geração para ambientes empresariais que demandam alto desempenho, resiliência e sustentabilidade operacional. O problema estratégico: eficiência e densidade no Edge As infraestruturas tradicionais de TI foram concebidas para operar em data centers centralizados, com controle ambiental rigoroso e recursos energéticos abundantes. Entretanto, com a disseminação do Edge Computing e a integração de aplicações de baixa latência, as empresas precisam processar volumes crescentes de dados in loco, próximos à origem da informação. Esse deslocamento cria um desafio estratégico: como oferecer a mesma capacidade de computação de um servidor de rack completo em um formato compacto, energeticamente eficiente e capaz de operar em locais com restrições de espaço, refrigeração e energia? Para provedores de telecomunicações, indústrias e ambientes de IoT distribuídos, a ineficiência energética e o superaquecimento são ameaças diretas à continuidade operacional. É nesse contexto que o GIGABYTE E243-E30-AAV1, com o processador AMD EPYC 8004, redefine o equilíbrio entre potência computacional, densidade e sustentabilidade. Consequências da inação: custo operacional e obsolescência tecnológica Ignorar a necessidade de eficiência energética no Edge implica mais do que um simples aumento na conta de energia. A longo prazo, isso se traduz em custos exponenciais com refrigeração, substituição de hardware e interrupções de serviço — especialmente em infraestruturas distribuídas de telecom e nuvem privada. Além disso, a dependência de arquiteturas antigas, baseadas em interfaces PCIe 3.0 ou DDR4, limita a capacidade de processamento de dados em tempo real, inviabilizando a adoção de novas aplicações de IA e análise preditiva. Organizações que mantêm servidores legados enfrentam, portanto, um duplo obstáculo: custos crescentes e perda de competitividade. A atualização para plataformas como a do AMD EPYC 8004 oferece uma alternativa concreta — combinando arquitetura de 5 nm, suporte ao PCIe 5.0 e à memória DDR5 ECC para garantir throughput elevado, integridade de dados e otimização do desempenho por watt. Fundamentos da solução: arquitetura AMD EPYC 8004 e design GIGABYTE Eficiência energéticaquitetura Zen 4c de 5 nm A base do E243-E30-AAV1 é o processador AMD EPYC 8004, construído sobre a arquitetura Zen 4c de 5 nm, que aumenta a densidade de transistores e melhora o desempenho por watt de forma expressiva. O resultado é um processador de baixo TDP que entrega performance equivalente a modelos de maior consumo energético, mas com menor impacto térmico e menor custo de operação. Compatibilidade SP6 e redução de custos O uso do soquete SP6 reduz significativamente o custo de material (BOM) e simplifica futuras atualizações, permitindo escalabilidade dentro da mesma plataforma. Essa compatibilidade estratégica é vital para empresas que planejam ciclos de atualização progressivos sem reinvestimentos estruturais elevados. Suporte avançado a DDR5 ECC e PCIe 5.0 Com suporte a 6 canais DDR5 RDIMM e até 12 DIMMs, o servidor garante maior largura de banda e integridade de dados, essencial para cargas críticas como IA, inferência e virtualização. Já as interfaces PCIe Gen5 x16 dobram a taxa de transferência em relação à geração anterior, atingindo 128 GB/s de largura de banda total — viabilizando GPUs de última geração e placas OCP 3.0. Desempenho em computação acelerada O E243-E30-AAV1 suporta até duas GPUs de slot duplo Gen5, atendendo aplicações de treinamento e inferência de IA, renderização gráfica e computação visual. Essa flexibilidade torna o modelo ideal para empresas que buscam infraestrutura híbrida de Edge + IA, com escalabilidade horizontal baseada em workloads específicos. Implementação estratégica: design para Edge e Telecom Compactação e refrigeração inteligente Projetado para ambientes de profundidade reduzida, o E243-E30-AAV1 é otimizado para gabinetes compactos, permitindo implantação em edge sites e ambientes não convencionais. O controle automático de velocidade das ventoinhas ajusta o fluxo de ar com base em sensores térmicos distribuídos, maximizando a eficiência térmica e minimizando ruído e consumo. Redundância fria e continuidade operacional A função Cold Redundancy é um diferencial essencial: quando a carga do sistema cai abaixo de 40%, uma das fontes redundantes entra em modo de espera, aumentando a eficiência energética em até 10%. Além disso, o recurso Smart Ride Through (SmaRT) garante operação contínua em caso de falhas de energia momentâneas, utilizando capacitores internos para manter o sistema ativo durante a transição para fonte reserva. Proteção inteligente e arquitetura de alta disponibilidade A funcionalidade Smart Crises Management and Protection (SCMP) protege o sistema de falhas críticas em fontes de energia não redundantes, reduzindo dinamicamente o consumo da CPU e evitando desligamentos inesperados. Já a arquitetura de ROM dupla assegura recuperação automática do BIOS e do BMC, garantindo máxima disponibilidade mesmo após falhas de firmware. Melhores práticas avançadas: segurança, modularidade e gestão Segurança baseada em hardware O suporte a TPM 2.0 permite autenticação baseada em hardware e armazenamento seguro de chaves de criptografia, senhas e certificados digitais. Essa camada adicional de segurança é crucial em ambientes Edge distribuídos, onde a exposição física do hardware é mais provável. Design modular e OCP 3.0 A compatibilidade com OCP NIC 3.0 facilita a expansão de rede e personalização de conectividade sem necessidade de abrir o chassi. O design modular reduz o tempo de manutenção e aprimora a escalabilidade, tornando o servidor apto a evoluir com as demandas da rede 5G e aplicações de IA distribuídas. Gerenciamento centralizado com GIGABYTE Management Suite O GIGABYTE Management Console (GMC) e o GIGABYTE Server Management (GSM) oferecem controle completo sobre a infraestrutura. O GMC

Rack Server R264-S33-AAL1: Desempenho Extremo com Intel Xeon 6 e GPUs Gen5 No cenário atual da computação empresarial, a convergência entre inteligência artificial, análise de dados e virtualização intensiva exige uma infraestrutura que ofereça poder computacional denso, eficiência energética e escalabilidade. O Rack Server R264-S33-AAL1, desenvolvido pela GIGABYTE, representa uma resposta direta a essas demandas com sua arquitetura baseada nos processadores Intel® Xeon® 6 e suporte para até três GPUs PCIe Gen5 de slot duplo. Este artigo analisa em profundidade as bases técnicas, implicações estratégicas e benefícios empresariais dessa plataforma de última geração. Contextualização Estratégica no Cenário Empresarial Empresas que operam em setores como IA, computação visual, HPC (High Performance Computing) e cloud híbrida enfrentam um ponto de inflexão tecnológico: o crescimento exponencial das cargas de trabalho e a necessidade de respostas em tempo real colocam à prova as arquiteturas tradicionais de servidores. O R264-S33-AAL1 surge como uma peça crítica para organizações que buscam acelerar pipelines de IA, consolidar workloads virtualizados e garantir desempenho previsível em escala de rack. Com o avanço dos processadores Intel Xeon 6, que introduzem uma divisão entre Performance-cores (P-cores) e Efficient-cores (E-cores), a GIGABYTE reposiciona sua linha de servidores para oferecer equilíbrio entre densidade computacional e consumo energético. Isso permite que o servidor seja otimizado tanto para aplicações de inferência e treinamento de IA quanto para workloads de nuvem e edge computing com múltiplos perfis de uso. Desafio Estratégico e Implicações Técnicas O principal desafio enfrentado por arquitetos de data centers hoje é o de combinar alto throughput computacional com eficiência operacional. O crescimento das cargas de IA e machine learning exige plataformas com GPUs poderosas e interconexões de alta largura de banda. Entretanto, a dissipação térmica, a confiabilidade e a interoperabilidade com diferentes sistemas tornam essa tarefa complexa. O R264-S33-AAL1 foi projetado para endereçar essas variáveis críticas. Seu chassi de 2U abriga até três GPUs PCIe Gen5 em slots FHFL x16, suportando unidades de expansão de última geração e conectividade de alta velocidade. Ao integrar um único processador Intel Xeon 6700/6500-series, o servidor oferece o equilíbrio ideal entre desempenho bruto e eficiência térmica — uma consideração estratégica em ambientes densos. Consequências da Inação Empresas que continuam operando em infraestruturas baseadas em gerações anteriores de servidores enfrentam aumento nos custos operacionais e risco de obsolescência tecnológica. A incapacidade de suportar padrões como PCIe Gen5 e CXL 2.0 limita o acesso a aceleradores de nova geração e reduz a competitividade em workloads de IA, renderização e simulação. Além disso, arquiteturas antigas com DDR4 e sem suporte a MRDIMM não conseguem acompanhar as demandas de throughput de memória necessárias para modelos de IA generativos ou bancos de dados analíticos. Fundamentos Técnicos da Solução O Rack Server R264-S33-AAL1 fundamenta-se na mais recente arquitetura da Intel, com 8 ou 12 canais de memória DDR5 RDIMM/MRDIMM e até 136 lanes de PCIe 5.0. Esse conjunto garante largura de banda sem precedentes para interconexão entre CPU, GPU e armazenamento. A inclusão de suporte a CXL 2.0 permite utilizar memória DDR5 e CXL como uma região unificada, aumentando a flexibilidade de provisionamento em ambientes de nuvem e virtualização. Além disso, a GIGABYTE integra recursos como Dual ROM Architecture, que assegura redundância entre BMC e BIOS, e módulos TPM 2.0 opcionais para autenticação baseada em hardware. Esses elementos elevam o nível de segurança e disponibilidade operacional — um requisito fundamental em data centers modernos. Refrigeração e Eficiência Energética A eficiência térmica é um diferencial crucial. O R264-S33-AAL1 adota um sistema de ventilação com controle automático de velocidade baseado em sensores distribuídos, ajustando o fluxo de ar de acordo com a temperatura de cada componente. Essa abordagem, somada às fontes de alimentação redundantes 1+1 de 2700W com certificação 80 PLUS Titanium, reduz desperdício energético e aumenta a vida útil dos componentes internos. Implementação Estratégica e Interoperabilidade A arquitetura do R264-S33-AAL1 foi concebida para integração fluida em ecossistemas de IA corporativa, edge e nuvem privada. O suporte nativo ao padrão OCP 3.0 amplia a modularidade da plataforma, permitindo substituição e manutenção de NICs sem abrir o chassi — recurso essencial para operações 24/7. Em termos de interoperabilidade, o servidor suporta drives Gen5 NVMe/SATA/SAS-4 e até 12 baias hot-swap, o que facilita a implementação de soluções de armazenamento de alto desempenho. A presença de uma porta LAN Intel I210-AT e slot M.2 PCIe Gen5 x2 garante conectividade robusta e escalabilidade de I/O para futuras atualizações. Gerenciamento Unificado e Observabilidade A GIGABYTE disponibiliza duas camadas de gestão: o GIGABYTE Management Console (GMC) e o GIGABYTE Server Management (GSM). O GMC oferece administração baseada em navegador com monitoramento em tempo real, gravação automática de eventos e integração com controladoras Broadcom MegaRAID. Já o GSM atua em nível de cluster, com suporte a IPMI, Redfish, CLI e aplicações móveis, oferecendo controle total sobre ambientes distribuídos. Essa estrutura de gerenciamento reduz a complexidade operacional e melhora a visibilidade sobre consumo, desempenho e falhas — pontos críticos em infraestruturas multi-GPU e ambientes de HPC. Melhores Práticas e Estratégias de Otimização Para maximizar o desempenho do Rack Server R264-S33-AAL1, recomenda-se adotar práticas como: Balanceamento térmico proativo: uso de perfis automáticos de fan control para minimizar hotspots em ambientes de GPU intensa. Atualização coordenada de BIOS e BMC: utilizando a arquitetura Dual ROM para evitar downtime durante upgrades. Configuração de RAID com NVMe Gen5: potencializando throughput para pipelines de IA e renderização. Cada uma dessas otimizações contribui para reduzir o TCO (Total Cost of Ownership) e prolongar a eficiência operacional, consolidando o investimento no longo prazo. Alta Disponibilidade e Segurança de Hardware O servidor incorpora tecnologias de continuidade como Smart Ride Through (SmaRT) e Smart Crises Management and Protection (SCMP). Essas funções garantem operação contínua mesmo durante falhas de energia ou superaquecimento, reduzindo o risco de perda de dados e interrupção de serviços críticos. Em cenários corporativos sensíveis — como bancos, pesquisa científica e IA médica —, essa resiliência é vital. Além disso, o TPM 2.0 assegura que chaves de criptografia e certificados digitais permaneçam isolados do sistema operacional, protegendo informações confidenciais

Introdução O GIGABYTE E264-S30-AAJ1 representa uma nova geração de servidores edge empresariais, desenhado para atender às demandas mais exigentes de inteligência artificial (IA), análise de dados, computação em nuvem e ambientes de borda. Com base na arquitetura Intel® Xeon® 6, o sistema combina desempenho escalável com eficiência energética, suportando até duas GPUs PCIe Gen5 de alto desempenho e até 16 módulos DDR5 RDIMM/MRDIMM. Mais do que uma plataforma de hardware, o E264-S30-AAJ1 incorpora o avanço da engenharia da GIGABYTE em design térmico, eficiência energética e gerenciamento remoto, permitindo que empresas implantem infraestruturas distribuídas de alto desempenho sem comprometer estabilidade ou segurança. Este artigo analisa em profundidade o papel deste servidor no contexto estratégico da computação moderna. Desafio Estratégico: Desempenho Computacional na Borda As organizações enfrentam um dilema constante: levar poder computacional próximo à fonte dos dados sem sacrificar desempenho, confiabilidade ou custo. Ambientes de borda (edge computing) demandam servidores capazes de executar inferência de IA, processamento em tempo real e análises complexas em espaços limitados e com restrições energéticas. O GIGABYTE E264-S30-AAJ1 surge como resposta direta a esse desafio. A introdução dos processadores Intel Xeon 6 redefine o equilíbrio entre densidade computacional e eficiência, oferecendo arquiteturas híbridas com Performance-cores (P-cores) e Efficient-cores (E-cores). Essa combinação permite adaptar o consumo e a potência de acordo com a carga de trabalho, otimizando o desempenho tanto em IA quanto em cargas cloud-native. Impacto nos Negócios Para empresas que operam com IA distribuída, veículos autônomos, monitoramento industrial ou redes 5G, o servidor edge torna-se o elo entre a operação física e a inteligência digital. A ausência de infraestrutura otimizada nesse ponto crítico gera latência, gargalos e custos operacionais. O E264-S30-AAJ1 mitiga esses riscos ao oferecer alta disponibilidade e eficiência energética em formato 2U compacto, ideal para data centers modulares e implantações em campo. Consequências da Inação: Riscos Operacionais e Competitivos Ignorar a evolução para plataformas híbridas de alto desempenho acarreta consequências sérias. Empresas que permanecem presas a arquiteturas de CPU monolíticas enfrentam limitações de escalabilidade e custos energéticos crescentes. Além disso, a falta de suporte a PCIe 5.0 e CXL 2.0 limita a integração com aceleradores modernos, reduzindo o potencial de expansão e interoperabilidade. Com o avanço das aplicações de IA generativa, análise preditiva e automação industrial, cada milissegundo de atraso e cada watt de desperdício energético impactam diretamente a competitividade. A adoção de servidores edge como o E264-S30-AAJ1 garante a base necessária para sustentar operações críticas, mantendo alta disponibilidade e reduzindo tempo de resposta. Fundamentos Técnicos da Solução O design do GIGABYTE E264-S30-AAJ1 é centrado na integração otimizada entre processador, memória e conectividade. Com suporte a até 136 lanes PCIe 5.0, o servidor permite múltiplas configurações de GPUs, controladoras de rede e armazenamento NVMe, sem comprometer largura de banda. Arquitetura Intel Xeon 6: P-cores e E-cores O Intel Xeon 6 introduz uma arquitetura híbrida inspirada no conceito de eficiência heterogênea. Os P-cores priorizam desempenho de thread único, essenciais para cargas de trabalho intensivas em computação, como renderização 3D ou treinamento de IA. Já os E-cores maximizam a densidade e eficiência energética, ideais para aplicações em nuvem e ambientes hyperscale. Essa flexibilidade permite que o mesmo sistema suporte desde tarefas de inferência de IA até execução massiva de contêineres. Memória DDR5 e MRDIMM Com suporte a até 16 slots DDR5 RDIMM/MRDIMM e canais de memória expandidos (8 ou 12, conforme CPU), o E264-S30-AAJ1 entrega largura de banda superior para cargas intensivas em dados. O uso de módulos MRDIMM aumenta a frequência e reduz a latência, essencial para bancos de dados em memória e aplicações de IA que exigem transferência contínua de dados entre CPU e GPU. Conectividade PCIe 5.0 e CXL 2.0 A compatibilidade com PCIe Gen5 oferece até o dobro da taxa de transferência da geração anterior, viabilizando o uso de GPUs duplas, controladoras NVMe Gen5 e módulos de expansão OCP 3.0. Já o suporte a CXL 2.0 permite a unificação de memória DDR5 e dispositivos CXL em um mesmo espaço de endereçamento, simplificando o gerenciamento e aumentando a eficiência de workloads dinâmicos. Implementação Estratégica: Eficiência, Resiliência e Escalabilidade Em ambientes de produção, o desempenho do hardware depende não apenas da potência bruta, mas da estabilidade térmica, eficiência energética e capacidade de manutenção. A GIGABYTE integra ao E264-S30-AAJ1 recursos avançados de gestão e resiliência que garantem continuidade operacional mesmo em condições adversas. Controle Térmico e Eficiência Energética O sistema de controle automático de velocidade dos ventiladores ajusta dinamicamente o fluxo de ar conforme a temperatura interna, reduzindo ruído e consumo de energia. Aliado às fontes redundantes 1+1 de 2000W 80 PLUS Titanium, o servidor atinge excelente eficiência energética, reduzindo custos de operação e prolongando a vida útil dos componentes. Alta Disponibilidade e Proteção de Dados O E264-S30-AAJ1 implementa tecnologias proprietárias da GIGABYTE como Smart Ride Through (SmaRT) e Smart Crises Management and Protection (SCMP). Essas funções mantêm o sistema ativo durante falhas de energia ou superaquecimento, reduzindo a carga e prevenindo perda de dados. A arquitetura Dual ROM adiciona redundância ao BIOS e BMC, permitindo recuperação automática em caso de falha de firmware. Gerenciamento Inteligente: GIGABYTE Management Console O servidor vem com o GIGABYTE Management Console pré-instalado, compatível com IPMI e Redfish. A solução permite monitoramento em tempo real, registro automático de eventos e integração com dispositivos SAS, SATA e NVMe. Para ambientes de larga escala, o GIGABYTE Server Management (GSM) oferece uma suíte completa de controle remoto via interface gráfica, CLI e aplicativos móveis. Melhores Práticas Avançadas Para maximizar o potencial do E264-S30-AAJ1, recomenda-se planejar a implantação considerando a natureza híbrida das cargas de trabalho. A separação de tarefas entre P-cores e E-cores deve refletir a criticidade de cada aplicação. Workloads sensíveis à latência devem ser priorizados em P-cores, enquanto operações paralelas e distribuídas podem residir nos E-cores. O uso combinado de MRDIMMs e CXL 2.0 pode ampliar a capacidade de memória total do sistema sem sacrificar desempenho, especialmente em aplicações de inferência e aprendizado de máquina. A integração com GPUs Gen5 deve ser feita com atenção à disposição térmica e