GPU NVIDIA L40S para data centers: potência, eficiência e avanços para IA e computação visual A transformação dos data centers modernos está diretamente ligada à capacidade das organizações de processar volumes massivos de dados, executar cargas de trabalho complexas e acelerar fluxos de trabalho de inteligência artificial (IA) em escala. Nesse contexto, a GPU NVIDIA L40S para data centers, fornecida pela PNY, surge como uma peça arquitetural crucial para empresas que buscam desempenho superior, eficiência energética e suporte avançado para aplicações de IA, computação visual e análise de dados. Este artigo aprofunda os fundamentos técnicos e estratégicos da solução, detalhando seu impacto em ambientes corporativos de alta demanda e a relevância de sua arquitetura para modelos operacionais críticos. Ao longo deste conteúdo, exploraremos como a arquitetura NVIDIA Ada Lovelace, os núcleos Tensor otimizados, a precisão FP32/INT8, os núcleos RT de terceira geração e os 48 GB de memória GDDR6 se combinam para compor uma GPU preparada para cargas de trabalho avançadas. Mais do que uma descrição funcional, examinaremos o papel dessas características na eficiência operacional, na consolidação de infraestrutura e na aceleração de pipelines de IA e computação visual em data centers. Introdução O crescimento exponencial de aplicações baseadas em IA, modelos de linguagem, simulações avançadas e workloads de análise intensiva tem pressionado os data centers a reestruturar suas arquiteturas internas. Não basta mais depender exclusivamente de processadores tradicionais: é preciso empregar GPUs com capacidade paralela massiva, inteligência embarcada e otimizações específicas para cargas de trabalho modernas. Nesse cenário, a GPU NVIDIA L40S para data centers destaca-se como uma solução projetada para maximizar produtividade e reduzir gargalos. Os desafios enfrentados pelas organizações incluem latência elevada em pipelines de IA, capacidade limitada de renderização em ambientes criativos e dificuldade de escalar modelos de aprendizado profundo. Além disso, a crescente dependência de dados estruturados e não estruturados exige aceleração de análise em larga escala, algo inviável sem hardware especializado. Esses obstáculos tornam evidente a necessidade de GPUs robustas, capazes de fornecer baixa latência, alta largura de banda e confiabilidade contínua. A inação diante desses desafios resulta na perda de competitividade, aumento de custos operacionais e limitação da inovação interna. Empresas que não otimizam a infraestrutura para IA tendem a enfrentar ciclos de desenvolvimento mais lentos, incapacidade de lidar com grandes volumes de dados e falhas em processos críticos que dependem de computação paralela. Diante disso, a adoção de GPUs avançadas não é apenas uma escolha tecnológica: é uma decisão estratégica. Este artigo apresenta uma análise aprofundada da NVIDIA L40S, com foco em seus impactos arquitetônicos, benefícios de negócio e implicações técnicas. A partir disso, avaliaremos as melhores práticas, os trade-offs operacionais e as perspectivas futuras desta tecnologia em ambientes empresariais. O Problema Estratégico A demanda por processamento de IA aumentou substancialmente devido ao crescimento de modelos de aprendizagem profunda e aplicações que exigem inferência rápida e eficiente. Setores como saúde, finanças e sistemas autônomos dependem de aceleração computacional para suportar diagnósticos, análise algorítmica e tomada de decisão em tempo real. Entretanto, muitas infraestruturas corporativas permanecem restritas a arquiteturas tradicionais, incapazes de oferecer throughput adequado ou baixa latência para workloads modernos. Em computação visual, por exemplo, fluxos de trabalho profissionais que envolvem renderização 3D, produção virtual e design em alta resolução enfrentam limitações severas quando processados em hardware inadequado. Designers, artistas e engenheiros ficam impedidos de iterar de forma rápida, gerando atrasos que afetam diretamente cronogramas e orçamentos corporativos. No contexto de análise de dados, a incapacidade de processar grandes volumes de informação limita a descoberta de insights estratégicos, atrasando decisões de negócio baseadas em dados e prejudicando processos de otimização de supply chain, pesquisas científicas e modelagem avançada. Consequências da Inação A ausência de uma GPU especializada como a L40S gera impactos significativos em múltiplas frentes. A primeira é o custo operacional: workloads de IA e visualização executados em hardware inadequado consomem mais tempo e energia, aumentando a ineficiência global da operação. Quanto maior o tempo de processamento, maior o impacto financeiro. A segunda consequência é a perda de agilidade. Em ambientes que dependem de rápida iteração — especialmente setores criativos e de automação baseada em IA — atrasos reduzem a capacidade da organização de entregar produtos competitivos dentro do prazo. Isso afeta tanto a inovação quanto a velocidade de entrada no mercado. Em segurança e confiabilidade, a falta de recursos como ECC e inicialização segura expõe organizações a riscos de corrupção de dados e vulnerabilidades operacionais, especialmente em workloads críticos ou sensíveis. Fundamentos Técnicos da Solução Arquitetura NVIDIA Ada Lovelace A NVIDIA L40S é construída sobre a arquitetura Ada Lovelace, que eleva o padrão de eficiência e desempenho em GPUs para data centers. Essa arquitetura oferece avanços diretos na capacidade de lidar com cargas massivas de IA, aprendizado profundo e computação visual. Um dos principais diferenciais é o suporte a precisão FP32 e INT8, que permite lidar com diferentes tipos de operações matemáticas sem comprometer eficiência ou velocidade. Núcleos Tensor e Núcleos RT Os núcleos Tensor aprimorados tornam a L40S altamente capaz em tarefas de treinamento e inferência. A vantagem estratégica é clara: empresas que dependem de pipelines de IA reduzem radicalmente o tempo de execução de modelos, acelerando todo o ciclo de desenvolvimento. Para aplicações de visualização, os núcleos RT de terceira geração dobram o desempenho de ray tracing em relação à geração anterior, o que transforma a viabilidade de fluxos de trabalho interativos em alta fidelidade. 48 GB de memória GDDR6 e largura de banda A combinação de alta largura de banda e grande capacidade de memória oferece estabilidade em tarefas que consomem recursos massivos de dados, como simulações complexas e análises científicas. Essa característica diferencia a L40S de GPUs convencionais que sofrem com limitações sérias ao lidar com Big Data. Implementação Estratégica A adoção da GPU NVIDIA L40S deve ser acompanhada por uma abordagem estruturada. Organizações devem avaliar quais workloads se beneficiarão mais da aceleração e como integrá-la aos sistemas existentes. Nas áreas de IA, a GPU acelera etapas de treinamento, inferência e ajuste fino, especialmente em

Alice Recoque: o supercomputador em exaescala que inaugura a nova era das fábricas de IA na Europa Introdução A evolução da computação de alto desempenho sempre foi marcada por saltos tecnológicos que redefinem o que a ciência e a indústria podem alcançar. No entanto, a transição atual vai além da busca por mais poder bruto. Em um cenário onde inteligência artificial, simulação avançada e fluxos de dados massivos convergem, a infraestrutura deixa de ser apenas uma plataforma de processamento para se tornar um ecossistema capaz de sustentar operações contínuas, densas e altamente integradas. É nesse contexto que o Alice Recoque emerge como um marco para a Europa e para o mundo. As organizações enfrentam hoje um desafio estrutural profundo: cargas de trabalho de IA em grande escala deixaram de ser exceção e se tornaram regra. Treinamento distribuído, gêmeos digitais e simulações híbridas exigem arquiteturas que não só alcancem exaescala, mas que também mantenham eficiência energética e estabilidade. O custo e o risco da inação podem ser severos. Infraestruturas que não acompanham essa transição tornam-se gargalos, limitando a competitividade de países, empresas e centros de pesquisa. É nesse ambiente de crescente complexidade técnica e estratégica que AMD e Eviden apresentam o Alice Recoque, um supercomputador em exaescala criado explicitamente como uma “fábrica de IA”. Mais do que um conjunto de racks capazes de entregar um exaflop de HPL, ele representa uma nova abordagem arquitetural: simulação, dados e IA funcionando lado a lado, sustentados por GPUs MI430X, CPUs EPYC “Venice”, memória e largura de banda otimizadas e um design construído diretamente para eficiência. Ao longo deste artigo, será explorado como o Alice Recoque redefine o paradigma de HPC e IA integrados, quais problemas estratégicos resolve, que riscos mitiga e como sua arquitetura estabelece um novo padrão para a infraestrutura científica e industrial do continente europeu. O Problema Estratégico: IA e HPC superando infraestruturas tradicionais Cargas de trabalho que ultrapassam a capacidade de arquiteturas legadas À medida que os modelos de IA se expandem e se tornam cada vez mais interconectados a simulações científicas e análises de dados em grande escala, as arquiteturas clássicas de HPC se mostram insuficientes. O gargalo não está mais apenas no processamento, mas na incapacidade de alimentação de dados em tempo real. Quando a largura de banda ou a memória falham em acompanhar, até mesmo o hardware mais poderoso se torna subutilizado. Esse desafio tem impacto direto em pesquisas críticas, especialmente em domínios como clima, energia e saúde. Modelos massivos exigem um fluxo constante de dados para treinar, validar e inferir. Em um cenário tradicional, a capacidade computacional cresce, mas a infraestrutura de suporte (memória, rede, resfriamento e energia) não acompanha, criando um desequilíbrio sistêmico. O impacto na competitividade científica e industrial Enquanto empresas e países ampliam investimentos em IA, aqueles que operam com arquiteturas limitadas enfrentam custos crescentes, janelas de execução mais longas e reduções substanciais na precisão e no ritmo de inovação. O efeito acumulado é uma perda de competitividade. Projetos que dependem de execução paralela massiva tornam-se financeiramente e operacionalmente inviáveis. A necessidade de ambientes integrados para IA, dados e simulação As fronteiras entre HPC e IA estão se dissolvendo. Treinar um modelo de IA para prever padrões climáticos, por exemplo, requer tanto simulação física quanto análise estatística avançada. Inovações em energia exigem o mesmo tipo de integração. Resolver esse problema exige uma arquitetura onde IA e HPC compartilham o mesmo “solo”, e não sistemas isolados que disputam recursos. Consequências da Inação: custos, riscos e limitações competitivas Infraestruturas que consomem mais e produzem menos Ignorar a necessidade de eficiência energética em ambientes exaescale resulta em sistemas mais caros, menos sustentáveis e com impacto ambiental ampliado. Em um mundo onde o consumo energético é um componente central do CAPEX e OPEX de data centers, operar máquinas exascale sem otimização se torna proibitivo. Janelas de treinamento inviáveis e limitações operacionais Treinos de larga escala exigem estabilidade térmica e energética. Sem infraestrutura adequada, janelas de treinamento se estendem, tarefas falham e a produtividade cai. Em cargas de IA distribuídas, esse efeito se amplifica exponencialmente, provocando atrasos significativos em programas científicos ou industriais. Dependência tecnológica de terceiros países A ausência de plataformas próprias com capacidade exaescale deixa países e centros de pesquisa dependentes de infraestrutura alheia, o que limita sua autonomia e capacidade estratégica de inovação. Em setores sensíveis — saúde, energia, defesa — essa dependência cria riscos evidentes. Fundamentos da Solução: a arquitetura do Alice Recoque Uma fábrica completa de IA, não apenas um supercomputador O Alice Recoque foi concebido para ir além da entrega de processamento bruto. Ele opera como uma fábrica de IA onde treinamento, inferência e simulação coexistem e compartilham a mesma arquitetura central. Essa integração elimina silos, reduz latência e cria um fluxo contínuo entre ingestão de dados, modelagem e inteligência artificial. GPUs Instinct MI430X e CPUs EPYC “Venice” como núcleo da computação Com base nas GPUs AMD Instinct MI430X e nas CPUs EPYC “Venice”, o sistema combina o melhor da computação massivamente paralela com processamento otimizado para IA. Essa combinação permite executar simultaneamente cargas heterogêneas, mantendo performance consistente mesmo sob estresse. Construído sobre o sistema BullSequana XH3500 da Eviden O hardware baseia-se no BullSequana XH3500, arquitetado para densidade, eficiência e escalabilidade. Segundo as empresas, o Alice Recoque ultrapassa 1 exaflop de HPL com 25% menos racks do que sistemas tradicionais de mesma categoria, reduzindo o espaço físico e o consumo total. Memória e largura de banda como prioridades arquitetônicas Um dos pontos frequentemente negligenciados em supercomputadores é a velocidade com que dados se movem e a quantidade de informação que pode ser mantida em memória ativa. O Alice Recoque foi projetado para minimizar esses gargalos, garantindo que o processamento não fique limitado pela alimentação dos chips. Isso é particularmente crítico quando modelos são distribuídos em milhares de nós. Implementação Estratégica: eficiência, resfriamento e energia Operação dentro de um limite de 12 megawatts Ao fixar a operação em até 12 MW, o sistema demonstra uma abordagem centrada em eficiência energética e previsibilidade de

HPC Clusters Supermicro: Infraestrutura Avançada com Liquid Cooling e DCBBS As demandas associadas ao crescimento exponencial da inteligência artificial, da modelagem científica e das aplicações avançadas de computação de alto desempenho (HPC clusters) estão impondo um novo patamar de exigência sobre data centers empresariais e institucionais. A Supermicro, reconhecida globalmente como fornecedora de soluções completas de TI, apresenta em 2025 um portfólio profundamente alinhado a esse novo cenário. Durante o Supercomputing 2025 (SC25), a empresa demonstra como inovações em resfriamento líquido, integração rack-scale e arquiteturas avançadas como DCBBS estão redefinindo a forma como organizações projetam e operam suas infraestruturas críticas. Neste artigo, analisamos em profundidade essas soluções — incluindo plataformas baseadas em NVIDIA GB300 NVL72, HGX B300, FlexTwin, SuperBlade, MicroBlade, sistemas multi-node, além de tecnologias como Rear Door Heat Exchangers e Sidecar CDUs. A abordagem segue rigorosamente o Prompt Definitivo Vircos 2025, conectando cada avanço técnico a implicações estratégicas, riscos da inação e caminhos práticos de implementação. O objetivo é permitir que arquitetos, CTOs e engenheiros de infraestrutura compreendam não apenas a tecnologia, mas o impacto sistêmico que ela representa para ambientes de missão crítica. Introdução O avanço de HPC clusters e infraestrutura de IA tem acelerado uma transformação estrutural nos data centers. A convergência entre cargas científicas, simulações complexas, inferência de larga escala e treinamento multimodal exige densidades computacionais nunca vistas em ambientes corporativos. A Supermicro, ao apresentar sua linha para o SC25, evidencia como essa nova geração de infraestrutura não pode mais ser tratada como uma simples evolução incremental, mas como uma mudança arquitetural profunda que redefine desempenho, eficiência e escalabilidade. Os desafios enfrentados pelas organizações são múltiplos: limites térmicos de servidores tradicionais, aumento contínuo do TDP de CPUs e GPUs, pressão por eficiência energética, necessidade de ambientes mais densos e integrados, além de janelas de implantação cada vez menores. Sistemas de ar condicionado tradicional tornam-se insuficientes para dissipar cargas de 50kW, 80kW ou mais por rack — sendo substituídos progressivamente por sistemas avançados de liquid cooling e resfriamento híbrido. Ignorar essas mudanças implica aumento de custos operacionais, riscos de thermal throttling, incapacidade de suportar novas gerações de GPUs como NVIDIA Blackwell, e perda de competitividade em setores onde tempo de treinamento e performance determinam vantagem estratégica. Este artigo analisa esses aspectos e apresenta uma visão detalhada das soluções da Supermicro, destacando seu papel na construção de data centers preparados para o futuro. O Problema Estratégico dos HPC Clusters Modernos Limites térmicos e computacionais À medida que cargas de IA e HPC escalam, as limitações térmicas se tornam o principal gargalo arquitetural. GPUs de última geração, como as presentes no NVIDIA GB300 Blackwell Ultra, operam com centenas de watts cada, enquanto racks completos podem superar facilmente 80kW. Soluções tradicionais de ar forçado não acompanham essa escalada, provocando risco de redução automática de frequência dos processadores (thermal throttling) e perda significativa de desempenho. HPC clusters também demandam baixa latência e interconexões de alta velocidade, que dependem de ambientes termicamente estáveis para manter consistência. Isso faz com que alternativas como rear door heat exchangers, CDUs laterais e resfriamento direto ao chip deixem de ser opcionais e se tornem componentes fundamentais da arquitetura. Crescimento exponencial da IA generativa e multimodal A transição para modelos multimodais de larga escala pressiona não só CPU e GPU, mas a estrutura completa de interconexão, memória HBM e I/O. Rack-scale architectures, como a GB300 NVL72 da Supermicro, surgem para atender essa exigência, integrando 72 GPUs e 36 CPUs Grace em uma única solução otimizada. A densidade computacional se torna elemento-chave — e, sem liquid cooling, esse tipo de ambiente seria inviável. Escalabilidade e tempo de implantação Empresas enfrentam não apenas a necessidade de maior performance, mas também de acelerar time-to-online. Instalações complexas, com múltiplas dependências externas de infraestrutura térmica, podem atrasar projetos estratégicos de IA e HPC. A abordagem da Supermicro com DCBBS e CDUs autônomas reduz essa dependência, simplificando instalações e permitindo que clusters inteiros sejam ativados mais rapidamente. Consequências da Inação Ignorar a evolução tecnológica dos HPC clusters e de suas demandas térmicas e operacionais gera impactos diretos na competitividade. Perda de desempenho por throttling Em ambientes de ar insuficientemente resfriados, GPUs e CPUs reduzem automaticamente sua frequência para evitar danos. No caso de cargas de IA ou simulações científicas, isso pode multiplicar o tempo de execução e aumentar significativamente custos operacionais. Ataques ao TCO e consumo energético Data centers tradicionais já enfrentam pressões energéticas severas. Sem tecnologias como liquid cooling e heat exchange, a necessidade de ar frio adicional eleva sobremaneira os custos. Rear door heat exchangers de 50kW e 80kW, como os destacados no SC25, reduzem drasticamente essa dependência. Impossibilidade de adoção de GPUs modernas CPU e GPU de 500W — como Xeon 6900, EPYC 9005 e GPUs Blackwell — simplesmente não são suportáveis em arquiteturas térmicas antigas. Empresas que não evoluírem sua infraestrutura serão incapazes de adotar a nova geração de IA. Fundamentos da Solução Supermicro DCBBS: Integração completa de computação, armazenamento e rede A arquitetura Data Center Building Block Solutions (DCBBS) é um dos pilares da abordagem da Supermicro. Ela integra não apenas servidores, mas também armazenamento, networking e gestão térmica em um ecossistema unificado. Essa padronização acelera a implantação e permite escalar HPC clusters de forma previsível e replicável. Liquid cooling de terceira geração As soluções apresentadas no SC25 — como CDUs laterais com até 200kW de capacidade — permitem capturar 95% do calor diretamente no chip. Isso garante estabilidade térmica, reduz necessidade de refrigeração ambiental e possibilita densidades antes inviáveis. Arquiteturas rack-scale com NVIDIA GB300 NVL72 O sistema NVL72 demonstra claramente a migração para arquiteturas integradas: 72 GPUs Blackwell Ultra, 36 CPUs Grace e 279GB HBM3e por GPU. É um cluster completo dentro de um único rack. Implementação Estratégica Avaliação da carga de trabalho Antes de adotar soluções como FlexTwin, SuperBlade ou GB300 NVL72, a empresa deve avaliar se suas cargas são CPU-bound, GPU-bound ou híbridas. O portfólio Supermicro projeta cada plataforma para um cenário específico, evitando superdimensionamento ou escolhas inadequadas. Integração térmica CDUs, rear door heat

Supermicro, Intel e Micron: infraestrutura recordista para STAC-M3 e trading quantitativo A transformação digital na indústria financeira ampliou a pressão por arquiteturas de computação capazes de lidar com volumes massivos de dados, analisar micro variações de mercado e responder em latências cada vez menores. Em cenários onde microsegundos podem representar ganhos ou perdas milionárias, a eficiência da infraestrutura deixa de ser apenas um fator técnico e passa a determinar diretamente a competitividade das instituições. É nesse contexto que o benchmark STAC-M3 se tornou uma das principais referências globais para avaliar o desempenho de plataformas utilizadas em trading quantitativo, backtesting e análise de risco em tempo real. A Supermicro, em colaboração com Intel e Micron, apresentou resultados inéditos no STAC-M3, redefinindo os padrões de desempenho para cargas financeiras. A solução foi baseada em servidores Petascale all-flash equipados com processadores Intel Xeon 6, memória DDR5 e SSDs NVMe Micron 9550, combinados ao banco de dados KX kdb+ — amplamente utilizado no mercado financeiro por sua capacidade de lidar com séries temporais e análises estruturadas sobre grandes volumes de dados. Este artigo aprofunda o significado técnico e estratégico desses resultados, explorando o impacto da arquitetura, os desafios que ela resolve e por que a combinação Supermicro + Intel + Micron estabelece um novo patamar para trading quantitativo de alta performance. O Problema Estratégico: Latência, Volume e Complexidade na Análise Financeira Moderna O desafio das instituições financeiras Organizações como bancos, bolsas, firmas de trading quantitativo e hedge funds operam rotineiramente com bilhões de pontos de dados de mercado, coletados e analisados em janelas de tempo extremamente curtas. O objetivo não se resume apenas a executar operações mais rapidamente, mas também a compreender padrões, antecipar movimentos e consolidar decisões complexas com precisão quase instantânea. Essas demandas pressionam sistemas tradicionais, que frequentemente não conseguem lidar simultaneamente com grandes volumes de dados históricos e cargas intensas de consultas em tempo real. Além disso, os ambientes de trading operam com múltiplos usuários concorrentes, onde cada consulta pode determinar uma estratégia de execução, mensuração de risco ou resposta a condições emergentes do mercado. Os limites das infraestruturas convencionais A combinação de latência imprevisível, throughput insuficiente e falta de escalabilidade impõe limites diretos às estratégias de trading. Sempre que um sistema falha em responder a tempo, três consequências se tornam críticas: 1) perda imediata de oportunidade de execução, 2) redução da capacidade de backtesting de novas estratégias, 3) aumento do risco operacional causado por dados desatualizados. O STAC-M3 é justamente projetado para medir a capacidade de uma plataforma em enfrentar esse conjunto de desafios, avaliando desde o desempenho em consultas de séries temporais até a resiliência sob múltiplos utilizadores simultâneos. Consequências da Inação: Competitividade e Risco Ignorar gargalos de infraestrutura em ambientes de trading quantitativo significa aceitar riscos amplificados e perda de competitividade. À medida que mais empresas avançam para operações baseadas em análises de granularidade crescente — como variações de microssegundos no comportamento de ativos e correlação entre milhares de títulos — a infraestrutura passa a ser fator decisivo para extrair “alpha”. Sem plataformas de alto desempenho, instituições enfrentam custos crescentes de execução, menor capacidade de prever cenários e maior probabilidade de decisões erradas. Além disso, em mercados regulados e altamente auditáveis, a capacidade de demonstrar consistência e precisão nos cálculos é fundamental, e infraestruturas lentas ou instáveis podem prejudicar processos de compliance. Fundamentos da Solução: O STAC-M3 e a Arquitetura Petascale Supermicro O que o STAC-M3 realmente mede O STAC-M3 é um benchmark de “pilha completa”, englobando compute, armazenamento, redes e software. Ele simula operações típicas de trading quantitativo e backtesting usando bid-ask, price ticks e dados históricos amplos. Dois conjuntos de testes são utilizados: Antuco: simula cargas com dataset menor para medir comportamento em consultas intensivas. Kanaga: utiliza um dataset 20x maior, com número elevado de usuários simultâneos, refletindo ambientes reais. O fato de a nova solução ter quebrado 19 de 24 recordes de latência média do Kanaga e todos os 10 de 10 recordes de 50 e 100 usuários significa que a infraestrutura é capaz de sustentar cargas extremamente complexas com respostas mais rápidas e previsíveis que qualquer solução anterior auditada. O papel técnico da arquitetura Supermicro Petascale Os servidores testados foram seis unidades Supermicro SSG-222B-NE3X24R, um sistema de armazenamento all-flash de 2U com foco em workloads de dados massivos. Essa arquitetura oferece: • dual Intel Xeon 6 6700 series, • até 32 RDIMMs DDR5, • 32 bays NVMe E3.S PCIe Gen 5, • e até 5 slots PCIe para redes ou GPUs. Essa combinação permite que a infraestrutura equilibre I/O e processamento de modo eficiente. O PCIe Gen 5 amplia o throughput entre CPU, memória e SSDs, eliminando gargalos comuns em workloads financeiros. A integração total do fluxo — da consulta ao armazenamento até o retorno da resposta — reduz significativamente o tempo necessário para cada operação. O impacto dos componentes Intel e Micron Os processadores Intel Xeon 6 demonstraram capacidade notável em cargas imprevisíveis, executando o benchmark de 100 usuários 36% mais rápido que o recordista anterior, mesmo usando 62% menos núcleos de CPU. Isso evidencia não apenas aumento de performance, mas eficiência significativamente aprimorada. Os SSDs Micron 9550 NVMe complementam esse desempenho com latência altamente previsível, mesmo sob operações misturadas de leitura intensiva e cálculos pesados. A performance determinística é vital em trading quantitativo, onde qualquer variação pode afetar modelos de risco. A memória DDR5 RDIMM da Micron fornece velocidade de 6400 MT/s, suportando operações em larga escala com estabilidade e latência mínima. O uso de DDR5 é determinante para absorver o volume de dados processados pelo kdb+. Implementação Estratégica: Como Essa Arquitetura Sustenta Workloads Financeiros A configuração testada utilizou apenas 12U de rack para um conjunto de seis servidores, consumindo metade ou até um quarto do espaço físico de recordistas anteriores (21U e 44U). Apesar disso, ofereceu a maior capacidade total de armazenamento já registrada para o teste: 1.6 PiB de NVMe de alta performance. Essa densidade permite que instituições financeiras ampliem capacidade e throughput sem expandir seu footprint físico, reduzindo

Infraestrutura de IA para Governo: Avanços Supermicro e NVIDIA para 2026 A rápida evolução das tecnologias de inteligência artificial está redefinindo as capacidades e exigências de organizações federais. À medida que governos avançam na adoção de recursos de IA para segurança, risco, análise de dados e aplicações científicas de alta complexidade, cresce também a demanda por plataformas arquitetadas especificamente para cumprir normas rigorosas de conformidade, soberania de dados, eficiência operacional e integridade de fabricação. Nesse contexto, a colaboração entre Supermicro e NVIDIA representa um marco estratégico para instituições públicas que precisam combinar desempenho massivo, segurança reforçada e confiabilidade operacional dentro dos limites regulatórios dos Estados Unidos. Este artigo analisa, com profundidade técnica e visão estratégica, os principais avanços apresentados pela Supermicro no GTC em Washington, incluindo a adoção das futuras plataformas NVIDIA Vera Rubin NVL144 e CPX, a consolidação da fabricação TAA-compliant nos EUA e a ampliação do portfólio de IA para governo com sistemas como o HGX B300, o Super AI Station GB300 e o rack-scale GB200 NVL4. A partir dessa análise, discutimos não apenas os aspectos técnicos, mas também as implicações para resiliência, governança e competitividade no setor público. Ao longo do conteúdo, exploramos fundamentos arquiteturais, impactos estratégicos, riscos da inação, melhores práticas e alinhamento com modelos de referência como o NVIDIA AI Factory for Government. O objetivo é fornecer ao leitor uma visão aprofundada das mudanças que moldarão o cenário de infraestrutura de IA governamental nos próximos anos. Introdução A transformação digital no setor público alcançou um estágio em que a adoção de inteligência artificial não é apenas uma vantagem competitiva — é uma necessidade operacional. Governos lidam com ameaças cibernéticas cada vez mais sofisticadas, quantidades massivas de dados sensíveis e demandas crescentes por respostas rápidas, precisas e seguras. Nesse cenário, a construção de uma infraestrutura de IA para governo, alinhada a normas federais, torna-se um eixo estratégico para garantir soberania tecnológica e resiliência institucional. No entanto, essa jornada não é trivial. Os desafios incluem restrições legais como a Trade Agreements Act (TAA) e o Buy American Act, que exigem que sistemas utilizados por órgãos federais sejam produzidos e validados em território americano. Além disso, workloads governamentais — de detecção de ameaças a simulações científicas — demandam plataformas de altíssimo desempenho, escalabilidade e confiabilidade. A ausência de uma estratégia sólida de IA é, hoje, um risco sistêmico. Sem infraestrutura adequada, as organizações enfrentam perda de eficiência, vulnerabilidades de segurança, dependência tecnológica externa e incapacidade de responder às demandas emergentes. Como veremos, os avanços anunciados pela Supermicro em parceria com a NVIDIA representam uma resposta concreta a esses desafios. Ao longo deste artigo, analisaremos o panorama completo: dos problemas estratégicos enfrentados por entidades governamentais até as soluções arquitetadas para atender a requisitos rigorosos de conformidade, desempenho e segurança. O Problema Estratégico na Infraestrutura de IA para Governo Exigências Regulatórias e Integridade da Cadeia de Suprimentos Instituições governamentais trabalham dentro de um conjunto rigoroso de normas de segurança, confiabilidade e procedência de hardware. A conformidade TAA e o Buy American Act impõem que sistemas críticos sejam fabricados, validados e testados nos Estados Unidos. Isso limita drasticamente as opções de infraestrutura de IA disponíveis no mercado, pois muitas soluções de alto desempenho utilizam cadeias de suprimento distribuídas globalmente. Esse cenário cria um dilema estratégico: como garantir acesso a tecnologias de ponta em IA sem comprometer requisitos legais e sem abrir mão da segurança da cadeia produtiva? A resposta passa por fabricantes com capacidade de design, produção e validação local, algo que a Supermicro fortalece com sua manufatura baseada em San Jose, Califórnia. Crescimento Exponencial da Complexidade Computacional Aplicações modernas do setor público — de modelagem climática a análise de riscos — demandam volumes de computação que ultrapassam os limites das gerações anteriores de GPUs e arquiteturas convencionais. A dependência crescente de modelos multimodais e algoritmos que ultrapassam trilhões de parâmetros torna essencial uma infraestrutura capaz de sustentar IA de grande escala. Essa necessidade leva a dois desafios centrais: densidade computacional e eficiência energética. Ambientes governamentais precisam de arquiteturas compactas, porém escaláveis, que aproveitem GPUs de interconexão de baixa latência como as que compõem as plataformas Blackwell e Vera Rubin discutidas neste artigo. Consequências da Inação A falta de uma estratégia moderna de infraestrutura de IA para governo traz implicações mais profundas do que simplesmente perder competitividade. Em muitos casos, representa um risco direto à segurança nacional e à integridade operacional. Entre os impactos mais críticos, destacam-se: Vulnerabilidade Operacional Sem plataformas projetadas especificamente para workloads governamentais, órgãos públicos ficam expostos a falhas de desempenho e escalabilidade. Modelos incapazes de operar em grande escala criam gargalos, atrasam respostas e amplificam riscos — especialmente em áreas como cibersegurança e análise de ameaças. Dependência Tecnológica Externa Infraestruturas fabricadas fora do território nacional podem gerar riscos de cadeia de suprimentos e dificultar auditorias de segurança. Órgãos que dependem de fornecedores sem presença de manufatura local enfrentam limitações para atender às exigências de compliance federal. Limitações Científicas e de Inovação Sem hardware apropriado, instituições governamentais, laboratórios e universidades ficam limitados na execução de simulações e pesquisas avançadas, prejudicando áreas como meteorologia, energia, defesa e saúde. Fundamentos da Solução Apresentada pela Supermicro e NVIDIA Fabricação TAA-Compliant e Buy American Act-Capable A Supermicro destaca seu diferencial estratégico: sistemas desenvolvidos, construídos e validados nos EUA, atendendo às exigências federais. Toda a manufatura governamentalmente orientada ocorre em San Jose, Califórnia. Essa abordagem garante segurança da cadeia de suprimentos, maior transparência no processo de produção e confiança institucional. Para o setor público, isso significa que infraestruturas críticas de IA podem ser implantadas sem comprometer requisitos legais, com rastreabilidade total e alto nível de confiabilidade operacional. Próxima Geração de Plataformas NVIDIA para Governo Entre as inovações anunciadas para 2026 estão: NVIDIA Vera Rubin NVL144 e Vera Rubin CPX. Essas plataformas prometem mais de 3x de aceleração em workloads de atenção comparadas à geração Blackwell Ultra, habilitando modelos maiores, mais rápidos e mais eficientes para ambientes federais. A evolução representa um salto arquitetural para aplicações governamentais que dependem de inferência de alta

Introdução No contexto de transformação acelerada dos data centers e da crescente demanda por eficiência operacional e densidade computacional, o Supermicro MicroBlade 6U com AMD EPYC 4005 surge como uma solução disruptiva. Desenvolvido sobre a arquitetura Building Block da Supermicro, este sistema modular redefine o equilíbrio entre performance, eficiência energética e custo por nó, características fundamentais para provedores de serviços em nuvem, empresas de hospedagem e workloads corporativos intensivos. A pressão por redução de TCO (Total Cost of Ownership) e o avanço da virtualização em larga escala tornaram insuficientes os modelos tradicionais de servidores 1U. Nesse cenário, a densidade e a eficiência passam a ser indicadores críticos de competitividade. O MicroBlade 6U responde a esse desafio oferecendo até 160 servidores em um único rack 48U, com gerenciamento unificado de energia, rede e refrigeração — uma abordagem que transforma a economia de escala em vantagem estratégica. Este artigo analisa em profundidade a proposta técnica e estratégica do MicroBlade 6U alimentado pelos processadores AMD EPYC 4005 Series, detalhando como a arquitetura, a eficiência energética e a integração de rede convergem para redefinir o futuro dos data centers modulares. O Problema Estratégico: Limites da Escalabilidade Tradicional Ambientes de nuvem pública, hospedagem dedicada e infraestrutura de VDI enfrentam hoje uma limitação estrutural: o modelo 1U tradicional consome espaço, energia e cabos em proporção crescente à expansão da carga. Cada rack adicional implica novos investimentos em switches, cabeamento e sistemas de refrigeração, impactando diretamente o custo operacional e a pegada ambiental. À medida que os data centers buscam consolidar milhares de instâncias de servidores, a necessidade de densidade computacional torna-se imperativa. Essa densidade, porém, não pode comprometer a eficiência térmica, a gestão centralizada nem a redundância. O desafio reside em manter performance e resiliência enquanto se reduz complexidade e consumo energético. Consequências da Inação A manutenção de infraestruturas convencionais, mesmo com upgrades incrementais, resulta em um modelo insustentável no médio prazo. O desperdício de energia, a dificuldade de gerenciamento e o aumento do custo por watt reduzem a competitividade de provedores e corporações. Além disso, data centers com topologias fragmentadas enfrentam riscos maiores de downtime e vulnerabilidades de gestão. Sem modernização, o ciclo de vida dos equipamentos torna-se curto, e o ROI (Return on Investment) dos investimentos em TI cai drasticamente. Empresas incapazes de otimizar densidade e eficiência perdem agilidade para escalar serviços de IA Inference, web hosting ou workloads de escritório virtual, comprometendo margens e sustentabilidade. Fundamentos da Solução: Arquitetura MicroBlade e AMD EPYC 4005 A proposta do Supermicro MicroBlade 6U com AMD EPYC 4005 é eliminar os gargalos estruturais dos servidores 1U, adotando uma arquitetura modular integrada. Em um chassi 6U único, é possível acomodar até 20 blades independentes, dois switches Ethernet 10 GbE, dois módulos de gerenciamento redundantes e fontes de alimentação Titanium Level com até 96% de eficiência. Essa abordagem reduz até 95% do cabeamento interno e entrega uma economia de espaço de 70%, além de até 30% de economia energética. O resultado é uma infraestrutura compacta, de alta densidade, ideal para implantações em larga escala que exigem eficiência operacional e custos otimizados por nó. No núcleo da solução estão os processadores AMD EPYC 4005 Series, baseados na arquitetura “Zen 5”. Cada blade suporta um processador com até 16 núcleos e 32 threads, operando com TDP a partir de 65 W. Essa configuração garante o equilíbrio ideal entre performance, consumo e custo, tornando-a atraente tanto para provedores de serviços quanto para empresas que buscam virtualização intensiva, inferência de IA ou hospedagem dedicada. Integração e Eficiência de Rede O MicroBlade 6U integra switches 10 GbE de duas portas que simplificam topologias complexas e eliminam a necessidade de cabeamento externo redundante. Essa integração não apenas melhora a eficiência de rede, mas também reduz a latência e o custo de operação. Ao consolidar switching, gerenciamento e energia dentro de um único chassi, o sistema cria uma infraestrutura coesa e escalável. Gestão Unificada e Automação Os módulos de gerenciamento redundantes utilizam interfaces IPMI abertas e APIs Redfish, permitindo integração com plataformas de orquestração e monitoramento já existentes. Essa padronização reduz a complexidade operacional e facilita a automação de tarefas críticas como provisioning, updates e controle térmico. Em ambientes multi-rack, a administração centralizada transforma-se em um vetor direto de eficiência e segurança. Implementação Estratégica: Do Projeto à Operação O sucesso na adoção de uma infraestrutura baseada em MicroBlade exige uma abordagem integrada entre engenharia térmica, topologia de rede e políticas de governança. A densidade de 20 nós por 6U demanda planejamento cuidadoso de energia e refrigeração, embora o design da Supermicro otimize o fluxo de ar e a eficiência de dissipação. Com fontes Titanium Level de 96% de eficiência, a arquitetura reduz o desperdício energético e contribui para metas de sustentabilidade corporativa. Já o suporte a TPM 2.0 e AMD Infinity Guard adiciona camadas de proteção de hardware e criptografia, ampliando a confiança para workloads sensíveis. Na prática, a migração para MicroBlade 6U traz ganhos operacionais tangíveis: mais instâncias por rack, menor complexidade de cabos, e administração simplificada. Provedores podem consolidar múltiplos racks 1U em um único 48U com até 160 servidores, reduzindo dramaticamente o espaço físico e o custo por servidor instanciado. Melhores Práticas Avançadas e Cenários de Aplicação Computação em Nuvem e Web Hosting Provedores de nuvem e hospedagem podem usar o MicroBlade 6U para maximizar densidade e automatizar provisionamento. Cada blade opera de forma independente, suportando virtualização densa e gerenciamento centralizado, reduzindo o tempo de implantação de novos serviços. VDI e Ambientes Corporativos Em ambientes de VDI (Virtual Desktop Infrastructure), a combinação do AMD EPYC 4005 com DDR5 e 10 GbE permite alta responsividade e redução de custos operacionais. A densidade por rack viabiliza escalabilidade horizontal com mínimo overhead de refrigeração. IA Inference e Processamento Gráfico Cada blade suporta GPUs duais FHFL, tornando o sistema adequado para cargas de inferência de IA e processamento gráfico em larga escala. Essa flexibilidade é essencial para empresas que buscam consolidar inferência local, evitando dependência de nuvem pública. Segurança e Conformidade O suporte nativo a TPM

ASUS ESC4000-E10: Servidor GPU 2U com alto desempenho e eficiência para IA empresarial Introdução O ASUS ESC4000-E10 representa uma das arquiteturas mais equilibradas e avançadas da linha de servidores GPU da ASUS. Desenvolvido para ambientes de alta densidade e cargas intensivas de processamento, ele combina a potência dos processadores Intel Xeon Scalable de 3ª geração com um design otimizado para GPUs, alcançando excelência em aplicações de inteligência artificial (IA), aprendizado de máquina, renderização e computação científica. No cenário atual, as organizações enfrentam o desafio de equilibrar desempenho, eficiência energética e escalabilidade. Projetos de IA, simulações 3D e análises em tempo real exigem não apenas GPUs de alto desempenho, mas também um ecossistema de hardware capaz de sustentar throughput elevado e latências mínimas. O ESC4000-E10 surge como resposta a essas demandas, integrando tecnologias de ponta e recursos de gerenciamento corporativo avançado. Este artigo analisa em profundidade a arquitetura do ASUS ESC4000-E10, seus diferenciais técnicos, implicações estratégicas para data centers modernos e como sua configuração otimizada para GPUs eleva o padrão de eficiência e confiabilidade no processamento paralelo corporativo. O desafio estratégico no processamento de IA e HPC Empresas que operam cargas de trabalho de IA e HPC (High-Performance Computing) enfrentam desafios críticos de escalabilidade e custo operacional. A execução de modelos complexos, como redes neurais profundas, depende da interação fluida entre CPU, GPU e subsistemas de memória e armazenamento. A limitação de throughput PCIe, gargalos em I/O e ineficiências térmicas podem comprometer a disponibilidade e o custo total de propriedade (TCO). Nesse contexto, o ESC4000-E10 da ASUS oferece uma resposta arquitetural robusta, integrando onze slots PCIe 4.0 e suporte a até quatro GPUs de slot duplo, maximizando a largura de banda e a performance de dados. Consequências da inação e limitações de hardware tradicional Empresas que permanecem em plataformas com PCIe 3.0 ou design térmico limitado enfrentam uma crescente ineficiência energética e custos de manutenção mais elevados. Isso impacta diretamente a viabilidade de workloads modernos de IA, que exigem transferências de dados massivas entre CPU e GPU. Sem uma infraestrutura otimizada, modelos de treinamento podem levar horas a mais, reduzindo a produtividade e comprometendo o time-to-market. Além disso, a falta de redundância energética e controle térmico pode aumentar o risco de downtime — um fator inaceitável em ambientes de missão crítica. Fundamentos da solução: arquitetura e design inteligente O coração do ASUS ESC4000-E10 é seu design 2U dual-socket, equipado com dois soquetes LGA 4189 para processadores Intel Xeon Scalable de 3ª geração, com TDP de até 205W por soquete. Essa configuração oferece até 16 slots DIMM DDR4 3200MHz e suporte a Intel Optane Persistent Memory, ampliando a capacidade total de memória para até 6TB. O chassi 2U foi projetado para otimizar a densidade computacional sem comprometer a refrigeração, permitindo acomodar até quatro GPUs de slot duplo ou oito GPUs de slot simples, conforme o SKU. Essa flexibilidade torna o sistema ideal tanto para inferência e treinamento de IA quanto para workloads de simulação e visualização 3D. Outro ponto de destaque é a presença de onze slots PCIe 4.0, que oferecem largura de banda duplicada em relação à geração anterior, habilitando maior throughput em aplicações com múltiplas GPUs ou aceleradores de rede. A integração de um slot OCP 3.0 adicional, disponível em algumas versões, garante compatibilidade com placas de rede de alta velocidade e soluções personalizadas de interconexão. Implementação estratégica em data centers e IA empresarial A implementação do ESC4000-E10 deve ser vista não apenas como uma atualização de hardware, mas como uma decisão estratégica de infraestrutura. Sua capacidade de combinar GPUs de alto desempenho com grande volume de memória e múltiplos caminhos PCIe 4.0 faz dele uma base sólida para plataformas de IA, renderização e análise de dados em larga escala. A ASUS incorpora o módulo ASMB10-iKVM baseado no controlador ASPEED AST2600, que fornece gerenciamento out-of-band (OOB) completo, permitindo administração remota, monitoramento de sensores, controle de energia e atualização de firmware sem interrupção. Essa funcionalidade reduz custos operacionais e eleva o nível de governança técnica do ambiente. Além disso, o servidor conta com ASUS Control Center Enterprise para gestão in-band, possibilitando integração com soluções de orquestração corporativas e automação de tarefas de manutenção e provisionamento. Essa combinação OOB + in-band garante visibilidade total da infraestrutura e maior resiliência operacional. Melhores práticas avançadas para desempenho e eficiência Para explorar o potencial máximo do ESC4000-E10, é essencial alinhar configuração, fluxo de ar e gerenciamento de energia. A ASUS introduz um sistema de ventilação modular com ventoinhas hot-swap, que permite substituição sem downtime e garante redundância térmica. Essa abordagem é fundamental em operações contínuas, onde interrupções significam perdas significativas de produtividade. Outro ponto crítico é a eficiência energética. Com fontes de alimentação redundantes 80 Plus Platinum ou Titanium, o servidor atinge alta eficiência sob carga variável, reduzindo o PUE (Power Usage Effectiveness) do data center e contribuindo para metas de sustentabilidade corporativa. Além da performance, a integridade do firmware é protegida por um módulo PFR FPGA (Platform Root of Trust), que assegura resiliência contra ataques de firmware e corrupção de BIOS — uma exigência cada vez mais relevante em ambientes regulados e certificações de segurança empresarial. Medição de sucesso e indicadores de desempenho A avaliação do sucesso na implementação do ESC4000-E10 envolve métricas multidimensionais. No plano técnico, destaca-se a eficiência de throughput GPU-CPU, a latência de interconexão e o tempo de execução de cargas intensivas. No plano operacional, indicadores como tempo médio entre falhas (MTBF) e tempo médio de recuperação (MTTR) tornam-se fundamentais. Empresas que migraram para servidores GPU de 4ª geração PCIe, como o ESC4000-E10, observam redução expressiva no tempo de treinamento de modelos e no consumo energético por tarefa concluída. Esses ganhos não apenas otimizam a produtividade, mas também elevam a competitividade ao reduzir custos de energia e refrigeração. Conclusão O ASUS ESC4000-E10 é mais que um servidor GPU 2U — é uma plataforma de computação escalável e resiliente projetada para impulsionar o avanço da IA e da computação científica nas empresas. Seu design otimizado para densidade, eficiência térmica e redundância

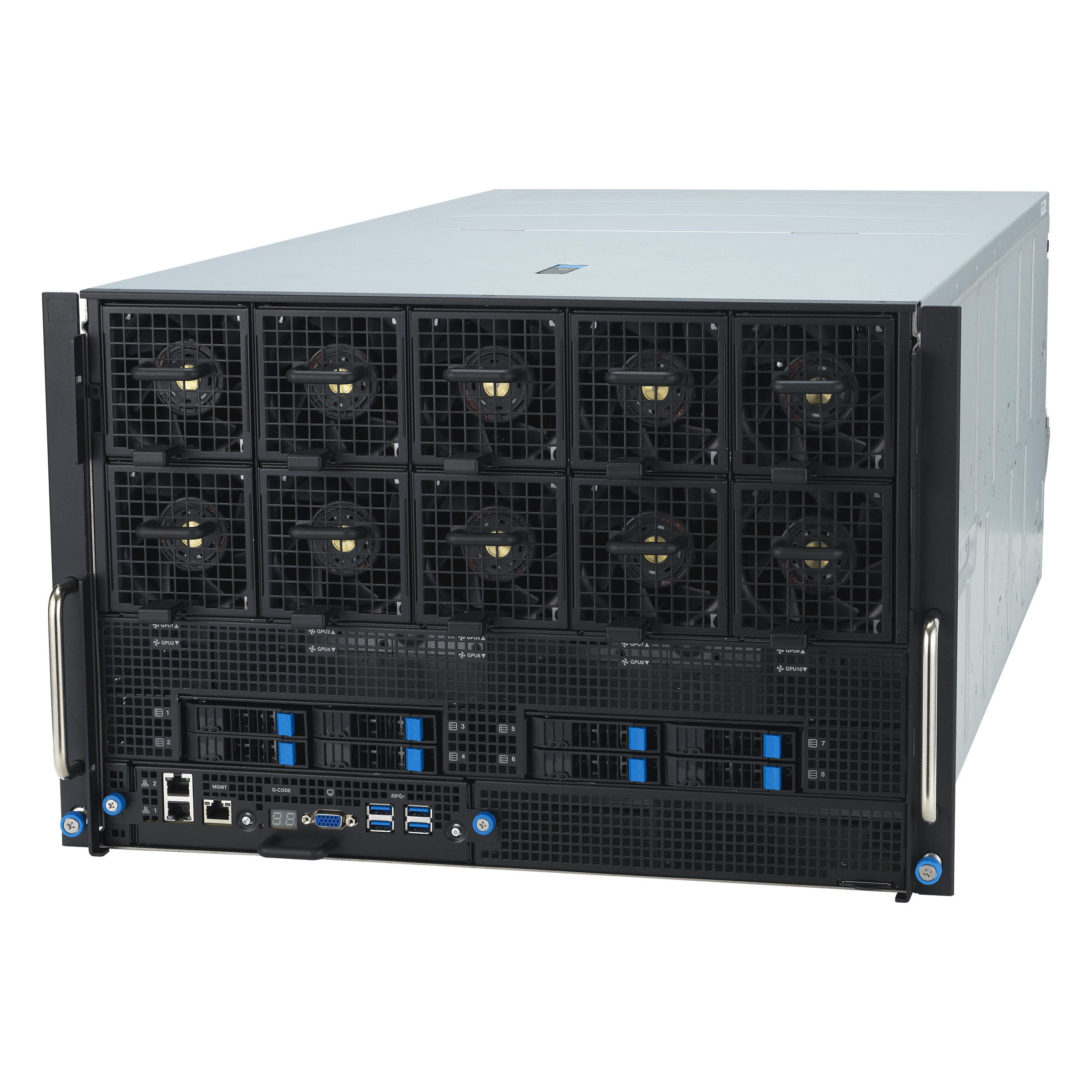

Servidor ASUS ESC N4A-E11: Arquitetura de Alto Desempenho para IA e HPC Empresarial O ASUS ESC N4A-E11 representa um marco na engenharia de servidores corporativos voltados para cargas de trabalho de Inteligência Artificial (IA), High Performance Computing (HPC) e análise de dados avançada. Equipado com quatro GPUs NVIDIA A100 Tensor Core e um processador AMD EPYC 7003, o sistema foi projetado para oferecer máxima densidade de computação, eficiência energética e confiabilidade em data centers de missão crítica. No contexto atual, em que empresas precisam processar volumes exponenciais de dados e treinar modelos de IA complexos, a arquitetura do ESC N4A-E11 torna-se um pilar essencial. Ele oferece interconexões NVLink de até 200 GB/s, gerenciamento remoto via ASMB10-iKVM e uma infraestrutura otimizada para energia e refrigeração, garantindo desempenho contínuo sob cargas intensas. Desafios Estratégicos no Processamento de IA e HPC O crescimento da IA corporativa e da simulação científica impôs novos limites à infraestrutura de TI. As empresas enfrentam gargalos relacionados à largura de banda, eficiência térmica e custo operacional. Soluções baseadas em CPU tradicional já não oferecem o throughput necessário para cargas de trabalho como deep learning, modelagem física e renderização 3D. É nesse cenário que o ESC N4A-E11 surge como resposta, alinhando arquitetura de hardware avançada e design térmico otimizado para suportar GPUs de 400 W. Sem uma plataforma dedicada a IA e HPC, organizações correm o risco de enfrentar ineficiências no processamento, tempo excessivo de treinamento de modelos e limitações em análise preditiva. Além disso, a falta de integração entre CPU e GPU pode gerar gargalos que comprometem a escalabilidade de ambientes híbridos. Consequências da Inação e Limitações de Infraestruturas Convencionais Ignorar a modernização da infraestrutura computacional representa uma perda competitiva significativa. Em setores como pesquisa médica, finanças e engenharia, atrasos no processamento significam custos diretos em inovação. Um ambiente HPC inadequado pode causar degradação de desempenho, falhas térmicas e aumento de consumo energético — resultando em TCO elevado e baixa eficiência operacional. Além disso, a ausência de conectividade direta entre GPUs e o uso de interconexões PCIe de baixa largura de banda tornam-se um gargalo crítico. O resultado é a limitação do potencial de paralelização de tarefas, o que impacta diretamente o desempenho em aplicações de IA distribuída. Fundamentos Técnicos da Solução ASUS ESC N4A-E11 O ESC N4A-E11 combina elementos técnicos que definem o padrão de servidores GPU de nova geração. No núcleo, um AMD EPYC 7003 de até 280 W de TDP alimenta o sistema com ampla capacidade de threads e suporte à memória de alta largura de banda. Este processador atua como coordenador das quatro GPUs NVIDIA A100 Tensor Core — cada uma capaz de até 80 TFLOPS de FP64 para HPC de precisão dupla. O sistema utiliza NVLink para interconexão direta GPU a GPU, entregando até 200 GB/s de largura de banda bidirecional. Essa topologia elimina gargalos e permite escalabilidade horizontal eficiente, essencial para IA distribuída e modelagem massiva. A eficiência térmica é outro pilar do design. A ASUS implementou um sistema de fluxo de ar independente para CPU e GPU, garantindo estabilidade térmica sem comprometer a densidade computacional. Essa abordagem reduz o consumo energético e aumenta a longevidade dos componentes — um diferencial estratégico em data centers que operam 24/7. Capacidade de Armazenamento e Expansão Com quatro baias de 3,5” e um slot M.2 onboard, o ESC N4A-E11 integra-se facilmente a arquiteturas de dados de alta performance. O suporte ao NVIDIA GPU Direct Storage minimiza a latência entre GPU e subsistema de armazenamento, acelerando cargas de trabalho de IA e big data. Além disso, três slots PCIe 4.0 permitem a inclusão de NICs Mellanox HDR InfiniBand de 200 GB, ampliando o throughput de rede e o potencial de clusters HPC. Gestão, Segurança e Confiabilidade O servidor é equipado com o ASUS ASMB10-iKVM, baseado no controlador ASPEED AST2600, que fornece gerenciamento remoto fora de banda. Isso viabiliza administração segura, atualizações de firmware e monitoramento proativo — recursos indispensáveis para data centers modernos. Além disso, a presença do PFR FPGA (Platform Root-of-Trust) reforça a integridade do firmware, prevenindo ataques e corrupção de BIOS. Essa arquitetura de segurança embarcada estabelece uma base confiável para ambientes empresariais sob rigorosas exigências de compliance. Implementação Estratégica em Ambientes Corporativos A adoção do ESC N4A-E11 deve considerar três dimensões críticas: integração, otimização e governança. Em projetos de IA, o servidor pode atuar como nó central de treinamento em clusters GPU, aproveitando o NVLink e o GPU Direct Storage para maximizar throughput. Em HPC, é ideal para simulações científicas que demandam precisão de ponto flutuante FP64. Empresas que já operam com arquiteturas híbridas baseadas em CPU x86 podem integrar o ESC N4A-E11 via PCIe 4.0 e InfiniBand, mantendo compatibilidade e ampliando a capacidade de processamento paralelo sem necessidade de reestruturação completa do data center. Melhores Práticas Avançadas de Operação Para extrair o máximo desempenho, recomenda-se um planejamento térmico detalhado do ambiente físico, garantindo fluxo de ar direcionado e temperatura estável. O uso de energia deve ser balanceado por meio da fonte 80 PLUS Titanium de 3000 W, que assegura eficiência superior e reduz custos operacionais de longo prazo. Na camada de software, a combinação de drivers NVIDIA, bibliotecas CUDA e frameworks de IA deve ser otimizada conforme a aplicação — seja TensorFlow, PyTorch ou cargas de HPC tradicionais. A integração com plataformas de orquestração, como Kubernetes ou Slurm, amplia a eficiência e facilita o escalonamento dinâmico de tarefas. Mitigação de Falhas e Alta Disponibilidade Uma estratégia eficaz envolve redundância elétrica, monitoramento proativo via iKVM e replicação de dados entre nós. A abordagem modular da ASUS permite substituição simplificada de componentes críticos, minimizando tempo de inatividade. Em ambientes de pesquisa ou finanças, onde interrupções podem gerar prejuízos substanciais, essa confiabilidade representa um diferencial competitivo tangível. Medição de Sucesso e Indicadores de Desempenho O sucesso da implementação do ESC N4A-E11 pode ser avaliado por métricas como: throughput computacional sustentado (TFLOPS efetivos), eficiência energética (TFLOPS/Watt), latência de comunicação GPU-GPU e tempo médio entre falhas (MTBF). Além disso, reduções no tempo de treinamento de modelos

ASUS ESC8000A-E11: Servidor GPU para IA e HPC de Próxima Geração No cenário atual de transformação digital e Inteligência Artificial (IA), a capacidade de processar grandes volumes de dados e treinar modelos de aprendizado profundo tornou-se um fator competitivo essencial. O ASUS ESC8000A-E11 representa a síntese entre poder computacional e eficiência térmica, oferecendo uma arquitetura projetada especificamente para cargas de trabalho intensivas em GPU, como IA generativa, simulações científicas e análise de dados em larga escala. Empresas que investem em infraestrutura HPC precisam equilibrar desempenho, densidade e confiabilidade. Nesse contexto, o ESC8000A-E11 surge como uma plataforma robusta baseada em processadores AMD EPYC 7003 e suporte a até oito GPUs NVIDIA A100 ou AMD Instinct MI100, entregando escalabilidade horizontal e vertical em uma estrutura 4U otimizada para eficiência energética e segurança de firmware. Ao longo deste artigo, exploraremos como o design do ESC8000A-E11 permite maximizar o throughput de dados, reduzir gargalos de comunicação entre GPUs e CPUs e garantir alta disponibilidade operacional em ambientes empresariais críticos. Desafio Estratégico: Acelerando a IA e o HPC com Eficiência Nos últimos anos, a IA corporativa e o HPC evoluíram de projetos experimentais para infraestruturas centrais de negócio. No entanto, a execução dessas cargas exige não apenas potência de GPU, mas também uma interconexão balanceada, gerenciamento térmico refinado e disponibilidade constante. A fragmentação de recursos em data centers tradicionais gera ineficiências e eleva custos operacionais. O desafio está em consolidar poder computacional sem comprometer confiabilidade ou eficiência energética. O ESC8000A-E11 foi desenhado exatamente para superar essa barreira, fornecendo um chassi 4U que abriga até oito GPUs duais-slot ativas ou passivas e múltiplas opções de expansão PCIe 4.0 x16, mantendo integridade térmica e estabilidade elétrica mesmo sob carga máxima. Consequências da Inação Ignorar a otimização da infraestrutura para IA e HPC resulta em tempos de treinamento mais longos, consumo excessivo de energia e baixa utilização de hardware. A consequência direta é o aumento do custo total de propriedade (TCO) e a limitação da escalabilidade de modelos de IA e simulações científicas. Organizações que continuam dependentes de arquiteturas legadas enfrentam gargalos de E/S, ineficiência de GPU e maior risco de falhas térmicas. Além disso, a ausência de redundância energética e gestão out-of-band robusta impacta a disponibilidade de serviços críticos. O ESC8000A-E11 mitiga esses riscos ao incorporar quatro fontes de 3000 W 80 Plus Titanium redundantes (2+2) e o módulo ASMB10-iKVM para gerenciamento remoto completo, garantindo visibilidade e controle mesmo em cenários de falha de rede principal. Fundamentos Técnicos da Solução Arquitetura Baseada em AMD EPYC 7003 No núcleo do ESC8000A-E11 estão dois soquetes SP3 (LGA 4094) capazes de hospedar processadores AMD EPYC 7003 de até 280 W TDP. Essa arquitetura oferece até 64 núcleos por CPU e 8 canais de memória DDR4-3200, permitindo 32 slots e capacidade total de 4 TB em módulos RDIMM/LRDIMM. O resultado é uma largura de banda de memória excepcional, fundamental para alimentar múltiplas GPUs com dados simultâneos sem criar gargalos. A presença de até 11 slots PCIe 4.0 proporciona maior throughput e reduz latências, algo essencial para IA distribuída e aplicações de HPC que dependem de comunicação paralela intensiva. Topologia GPU e Escalabilidade via NVLink O sistema suporta até oito GPUs duais-slot, configuráveis tanto com placas NVIDIA A100 quanto AMD Instinct MI100. Para workloads que exigem comunicação GPU-a-GPU de alta largura de banda, o suporte ao NVIDIA NVLink® bridge possibilita o aumento linear de desempenho sem sobrecarga da CPU, beneficiando treinamentos de redes neurais profundas e renderização de cenas complexas. Essa flexibilidade faz do ESC8000A-E11 uma solução ideal tanto para centros de pesquisa quanto para provedores de nuvem que oferecem instâncias GPU compartilhadas. Design Térmico e Eficiência Energética O chassi 4U emprega um sistema de fluxo de ar independente para CPU e GPU, garantindo controle térmico otimizado mesmo sob carga contínua. Aliado às fontes 80 Plus Titanium, o sistema atinge eficiência energética superior a 96%, reduzindo custos operacionais e emissões de CO₂. Essa abordagem é crítica em ambientes de IA onde o consumo energético de GPU pode ultrapassar 1 kW por nó. Implementação Estratégica e Operacional Integração e Expansão Modular A arquitetura do ESC8000A-E11 permite várias configurações de expansão (SKU-1 a SKU-4) com combinações de PCIe, OCP 3.0 e NVMe, oferecendo ao administrador flexibilidade para equilibrar I/O, armazenamento e interconexões de rede. Essa modularidade é vital para organizações que precisam escalar de projetos de IA piloto para ambientes de produção com múltiplos nós interconectados. O suporte a NVMe duplo e M.2 garante latências mínimas para carregamento de datasets massivos, enquanto as controladoras ASUS PIKE II oferecem opções de RAID e SAS 12 Gb/s para armazenamento corporativo seguro e redundante. Gerenciamento Avançado com ASMB10-iKVM O ESC8000A-E11 incorpora o ASMB10-iKVM, baseado no controlador ASPEED AST2600, para gerenciamento out-of-band completo. Combinado ao ASUS Control Center Enterprise, ele possibilita monitoramento remoto, atualizações firmware seguras e recuperação automatizada de falhas, reduzindo drasticamente o tempo de inatividade e a necessidade de intervenção manual no datacenter. Melhores Práticas Avançadas Para organizações que pretendem maximizar a vida útil e a eficiência do ESC8000A-E11, recomenda-se planejar a distribuição de GPUs com base no perfil térmico e nas características de interconexão PCIe. A utilização de GPUs ativas com fluxo direcionado à zona frontal melhora a eficiência de refrigeração em até 15%. Além disso, a configuração de fontes 2+2 redundantes é essencial para evitar falhas em cargas acima de 350 W por GPU. O emprego de monitoramento proativo de temperatura e energia via ASMB10-iKVM permite ajustar curvas de ventoinha e otimizar o consumo em função da demanda computacional. Essa abordagem garante estabilidade térmica contínua e reduz desgaste de componentes críticos. Governança e Segurança de Firmware Com o PFR FPGA integrado como Root of Trust, o ESC8000A-E11 assegura integridade de firmware desde o boot. Essa camada de segurança previne ataques a nível de BIOS e garante conformidade com padrões corporativos de resiliência cibernética em infraestruturas de IA e HPC. Medição de Sucesso e Indicadores O sucesso da implementação do ESC8000A-E11 pode ser avaliado por métricas como tempo de treinamento de modelos, eficiência de

Introdução O avanço das aplicações de inteligência artificial e computação de alto desempenho (HPC) redefiniu o papel da infraestrutura de servidores empresariais. Ambientes de aprendizado profundo, análise preditiva e simulações complexas exigem plataformas capazes de lidar com cargas paralelas intensivas e volumes massivos de dados com eficiência térmica e confiabilidade contínua. Nesse contexto, o ASUS ESC4000-E10S surge como uma solução estratégica de 2U para data centers corporativos, oferecendo equilíbrio ideal entre densidade de GPU, escalabilidade PCIe 4.0 e eficiência operacional. Desenvolvido com base na arquitetura de processadores Intel Xeon Scalable de 3ª geração e suporte a até quatro GPUs de slot duplo, o ESC4000-E10S se posiciona como um servidor de referência para empresas que desejam implementar infraestruturas de IA generativa, inferência, renderização e HPC distribuído. Ao combinar engenharia térmica otimizada, gerenciamento remoto robusto e flexibilidade de expansão, o modelo reflete o compromisso da ASUS com soluções voltadas para performance e resiliência em operações críticas. Este artigo analisa, em profundidade, os fundamentos técnicos e estratégicos do ASUS ESC4000-E10S, explorando seu papel no ecossistema de IA corporativa, sua arquitetura escalável e as implicações de sua adoção em ambientes de missão crítica. Problema Estratégico Empresas que buscam acelerar workloads de IA enfrentam um desafio duplo: a necessidade de poder computacional extremo aliado à eficiência térmica e energética. Clusters tradicionais baseados em CPU não são mais suficientes para processar modelos de aprendizado profundo e cargas de inferência com baixa latência. A limitação de largura de banda e a ineficiência térmica podem elevar custos operacionais e reduzir a confiabilidade de sistemas críticos. Além disso, a crescente demanda por infraestrutura escalável para IA — especialmente em aplicações de treinamento multimodal e HPC — exige uma arquitetura que permita alto throughput de dados, múltiplas GPUs e conectividade PCIe 4.0 sem gargalos internos. O problema estratégico, portanto, é encontrar um servidor que una performance sustentada, flexibilidade arquitetural e baixo TCO (Total Cost of Ownership). Consequências da Inação Ignorar a modernização da infraestrutura computacional resulta em perdas competitivas significativas. Sistemas legados limitam o avanço de pipelines de IA, reduzem a precisão de modelos de inferência e aumentam o consumo energético. Em ambientes HPC, essa limitação se traduz em maior tempo de processamento, ineficiência energética e dificuldade de escalar workloads distribuídas. Sem um servidor otimizado como o ESC4000-E10S, organizações enfrentam riscos como o aumento do custo operacional por watt computacional, gargalos de interconexão entre GPU e CPU, e dificuldade de garantir resiliência em cargas contínuas. A consequência prática é a redução da produtividade de times de engenharia e ciência de dados, comprometendo a inovação e a competitividade empresarial. Fundamentos da Solução O ASUS ESC4000-E10S foi concebido como um servidor GPU universal para IA e HPC, combinando flexibilidade de expansão e confiabilidade corporativa. Sua base em dois soquetes LGA4189 permite suportar a família de processadores Intel Xeon Scalable de 3ª geração com até 235 W por CPU, oferecendo um total de 16 slots de memória DDR4 3200 MHz e capacidade máxima de 2 TB. Um dos diferenciais técnicos centrais é o suporte a até 11 slots PCIe 4.0, permitindo configuração de até quatro GPUs de slot duplo (ou oito de slot simples). Essa flexibilidade é essencial para workloads que exigem paralelismo massivo, como treinamento de redes neurais profundas, modelagem molecular e renderização 3D. A interface PCIe 4.0 dobra a largura de banda em relação à geração anterior, reduzindo gargalos e aumentando a eficiência da comunicação entre GPUs e CPU. Outro aspecto fundamental é a presença de controladores NVMe e SAS/SATA híbridos que suportam até quatro drives NVMe e oito unidades SAS/SATA, proporcionando throughput elevado e latência mínima. Isso habilita pipelines de dados complexos com acesso simultâneo a múltiplos volumes de armazenamento, essencial para aplicações de IA que manipulam datasets em escala petabyte. Implementação Estratégica A implementação do ESC4000-E10S em um cluster de IA requer planejamento orientado à carga de trabalho. O servidor oferece compatibilidade com ASUS Control Center Enterprise para gerenciamento in-band e ASMB10-iKVM para controle remoto out-of-band via BMC AST2600, o que permite administração contínua, diagnósticos remotos e atualizações seguras de firmware. Sua integração de Root-of-Trust baseada em FPGA PFR estabelece uma camada adicional de segurança contra ataques de firmware e corrupção de BIOS, alinhando-se às práticas de segurança corporativa e aos padrões de compliance de data centers modernos. A arquitetura térmica flexível do ESC4000-E10S — com ventoinhas redundantes e hot-swap — mantém operação estável sob carga total de GPU, otimizando o PUE (Power Usage Effectiveness) e reduzindo o consumo energético total. Em clusters HPC, essa eficiência se traduz em economia operacional expressiva e maior tempo médio entre falhas (MTBF). Melhores Práticas Avançadas Para obter desempenho ideal, recomenda-se configurar o ESC4000-E10S com GPUs de arquitetura Ampere ou Ada Lovelace, aproveitando o suporte PCIe 4.0 para maximizar throughput de dados. Em ambientes distribuídos, a topologia deve priorizar interconexão GPU-CPU balanceada, minimizando latência entre nós. Em aplicações HPC, a utilização de armazenamento NVMe em RAID híbrido pode aumentar a eficiência de leitura e escrita, especialmente em simulações científicas e pipelines de treinamento distribuído. Além disso, a integração com plataformas de contêinerização, como Kubernetes com GPU Operators, amplia a flexibilidade de orquestração e escalabilidade elástica de workloads de IA. Por fim, a integração com frameworks como TensorFlow, PyTorch e NVIDIA CUDA permite explorar o potencial total do hardware, garantindo uso eficiente de cada GPU e evitando subutilização de recursos. Medição de Sucesso A avaliação do sucesso na implementação do ESC4000-E10S deve ser feita com base em três dimensões principais: desempenho computacional, eficiência energética e disponibilidade operacional. Métricas como TFLOPS sustentados, consumo médio por workload e tempo de uptime são indicadores diretos da eficácia da solução. Para organizações que executam workloads de IA, é possível medir ganhos tangíveis de performance — por exemplo, redução no tempo de treinamento de modelos complexos e aumento de throughput de inferência. Em contextos HPC, benchmarks como LINPACK e SPEC CPU podem validar a performance em ambientes científicos e de engenharia. O monitoramento contínuo via ASUS Control Center e logs do BMC AST2600 garante visibilidade completa

Introdução: o novo patamar de infraestrutura para cargas de IA e HPC No cenário empresarial atual, a transformação digital e a adoção intensiva de inteligência artificial e modelagem computacional exigem infraestruturas de alto desempenho, escaláveis e energeticamente eficientes. O ASUS ESC4000A-E12 surge como uma resposta de engenharia a essa nova era de demandas computacionais extremas, consolidando-se como uma plataforma de processamento acelerado capaz de suportar desde workloads de inferência de IA até simulações científicas em larga escala. Empresas que lidam com análise de dados, design generativo, modelagem de fluidos ou deep learning enfrentam o desafio de equilibrar potência de cálculo, eficiência térmica e confiabilidade operacional. Um erro na escolha da arquitetura de servidor pode significar gargalos de desempenho, custos energéticos elevados e restrições de escalabilidade. Neste contexto, o ESC4000A-E12 — baseado nos processadores AMD EPYC™ 9004/9005 com até 128 núcleos Zen 4c — redefine o que se espera de um servidor 2U voltado a IA, HPC e computação científica, oferecendo uma combinação inédita de densidade de GPU, largura de banda PCIe 5.0, suporte a DDR5 4800 MHz e design de refrigeração híbrido (ar e líquido). O problema estratégico: limites das arquiteturas tradicionais em IA corporativa Escalabilidade e limitação térmica em data centers modernos À medida que modelos de IA crescem em complexidade e volume de parâmetros, servidores convencionais deixam de atender às exigências de densidade computacional. Arquiteturas baseadas em PCIe 4.0 ou memórias DDR4 não conseguem sustentar o fluxo de dados requerido por GPUs modernas, resultando em gargalos e desperdício de energia. Além disso, a dissipação térmica se torna um gargalo físico: manter quatro GPUs duplas em operação contínua exige uma engenharia de refrigeração precisa. O ASUS ESC4000A-E12 aborda esses desafios de forma holística. Seu design de fluxos de ar independentes para CPU e GPU garante estabilidade térmica sem comprometer o desempenho. A opção de resfriamento líquido amplia a margem térmica e permite operar sob cargas intensivas com eficiência energética superior, reduzindo custos de operação em ambientes HPC. Conectividade e throughput como fator competitivo Em ambientes empresariais, a capacidade de interconectar GPUs, DPUs e NICs de alta velocidade define a eficiência do sistema. O suporte do ESC4000A-E12 a NVIDIA NVLink® Bridge e NVIDIA BlueField DPU transforma o servidor em um núcleo de processamento distribuído pronto para AI factories, eliminando gargalos de I/O e maximizando a escalabilidade horizontal. Empresas que permanecem em infraestruturas anteriores, sem PCIe 5.0 ou módulos OCP 3.0, enfrentam limites físicos de largura de banda, o que impacta diretamente o tempo de treinamento de modelos e a eficiência de clusters. Consequências da inação: custo computacional e perda de competitividade Adiar a modernização da infraestrutura de IA e HPC é, essencialmente, adotar um modelo de obsolescência planejada. Cada ciclo de processamento ineficiente acumula custos energéticos e reduz o retorno sobre o investimento em hardware. Além disso, a incapacidade de integrar GPUs e DPUs de última geração impede a adoção de frameworks modernos de IA e simulação. Empresas que não migram para plataformas como o ESC4000A-E12 perdem acesso à interconexão NVLink de alta velocidade, ao throughput PCIe 5.0 e ao suporte DDR5 4800 MHz, mantendo-se presas a um ecossistema legado que compromete o crescimento de soluções de IA corporativa e a competitividade global. Fundamentos técnicos da solução ASUS ESC4000A-E12 Arquitetura de processamento AMD EPYC™ 9004/9005 No coração do sistema está o socket SP5 (LGA 6096), compatível com os processadores AMD EPYC™ 9004 e 9005 com TDP de até 400 W. Essa geração adota a arquitetura Zen 4c, oferecendo até 128 núcleos e 12 canais DDR5, com largura de banda e latência otimizadas. A capacidade máxima de 3 TB de memória RDIMM (incluindo 3DS) fornece a base para aplicações que exigem armazenamento em memória de alta densidade, como in-memory databases e graph analytics. O suporte a DDR5 4800/4400 MHz garante que cada ciclo de CPU seja aproveitado com eficiência máxima, especialmente em tarefas de IA com alta concorrência. Design 2U otimizado para densidade GPU A flexibilidade do ESC4000A-E12 permite acomodar até quatro GPUs duplas ou oito GPUs simples, conectadas via slots PCIe 5.0 x16. Essa configuração suporta tanto modelos ativos quanto passivos, com compatibilidade estendida a aceleradores NVIDIA certificados. Essa densidade torna o servidor adequado para clusters de IA, inferência de LLMs e simulações físicas, mantendo a proporção ideal entre consumo e desempenho. O design 2U facilita a integração em racks padrão, garantindo escalabilidade linear sem expansão volumétrica. Infraestrutura de armazenamento e expansão escalável O servidor oferece seis baias frontais compatíveis com Tri-Mode NVMe/SATA/SAS, permitindo combinações híbridas entre SSDs NVMe para alta velocidade e discos SAS para armazenamento massivo. Com oito slots PCIe 5.0 adicionais, é possível integrar HBAs, RAIDs ou DPUs, tornando o sistema modular e preparado para evolução tecnológica. O suporte opcional a Broadcom MegaRAID 9560-16i e ASUS PIKE II 3108 assegura controle granular sobre desempenho e redundância. Implementação estratégica e considerações operacionais Gerenciamento unificado e segurança de infraestrutura O ASUS ASMB11-iKVM integrado, com controlador ASPEED AST2600, fornece acesso remoto completo ao hardware, permitindo monitoramento KVM-over-IP, BIOS flashing e controle de energia. Em paralelo, o ASUS Control Center (ACC) consolida a administração de vários servidores em um único painel, com suporte a alertas proativos e Root-of-Trust em nível de hardware, fundamental para governança e compliance. Integração em ecossistemas de IA e HPC Com suporte a OCP 3.0 (PCIe 5.0) e conectividade GbE, o ESC4000A-E12 se integra a redes de alta velocidade, permitindo sua inclusão em clusters interligados com NVIDIA BlueField DPUs ou switches Spectrum. Isso possibilita a construção de infraestruturas de IA distribuídas, onde cada nó atua como unidade autônoma de processamento paralelo, reduzindo a latência de comunicação entre GPUs. Eficiência energética e resiliência operacional O sistema adota fontes redundantes 1+1 de 2600 W com certificação 80 PLUS Titanium, assegurando disponibilidade contínua mesmo sob falhas parciais. O projeto térmico permite operações seguras entre 10 °C e 35 °C, com suporte a resfriamento líquido para ambientes de alta densidade. Essa abordagem garante que o ESC4000A-E12 mantenha desempenho estável e baixo PUE (Power Usage Effectiveness), um fator crítico para data