Introdução: Eficiência Energética como Pilar Estratégico em Infraestrutura de Storage O aumento contínuo dos custos de energia em escala global deixou de ser apenas uma variável financeira secundária e passou a ocupar um papel estratégico nas decisões de infraestrutura de TI. Em ambientes empresariais, onde sistemas de armazenamento precisam permanecer disponíveis de forma contínua, o consumo energético do storage tornou-se um fator direto de impacto no custo operacional total (TCO). Os sistemas NAS, tradicionalmente projetados para alta disponibilidade, historicamente operaram com foco quase exclusivo em desempenho e confiabilidade. Entretanto, a maturidade do mercado e a pressão por eficiência impuseram uma nova exigência: manter dados sempre acessíveis sem desperdiçar energia quando os recursos não estão sendo utilizados. A inação nesse cenário resulta em custos energéticos desnecessários, desgaste prematuro de componentes e maior exposição a falhas de hardware. Além disso, a ausência de uma estratégia de gestão energética compromete iniciativas de sustentabilidade corporativa e governança de TI. Este artigo analisa, de forma técnica e estratégica, como os recursos de economia inteligente de energia presentes nos NAS ASUSTOR — especificamente o modo S3, Wake on LAN/WAN, Power Schedule do ADM e o uso do MyArchive — endereçam esse desafio sem sacrificar disponibilidade, desempenho ou segurança operacional. O Problema Estratégico do Consumo Energético em NAS Corporativos Consumo Contínuo como Passivo Operacional Em muitas organizações, o NAS permanece ligado 24 horas por dia, independentemente do padrão real de uso. Essa prática, embora simplifique o acesso aos dados, transforma o consumo energético em um passivo silencioso, acumulando custos que raramente são auditados de forma granular. O problema se agrava quando múltiplos dispositivos de storage são distribuídos por filiais, escritórios remotos ou ambientes híbridos. A soma de pequenos desperdícios energéticos cria um impacto financeiro significativo ao longo do ciclo de vida do equipamento. Além do custo direto da energia, o funcionamento contínuo acelera o desgaste mecânico de discos, fontes de alimentação e sistemas de refrigeração, reduzindo a vida útil do hardware e antecipando investimentos em substituição. Consequências da Inação Ignorar a gestão energética em NAS corporativos implica aceitar custos operacionais inflados e maior probabilidade de falhas físicas. Ambientes que operam sem períodos de repouso sofrem mais com aquecimento constante, o que afeta diretamente a estabilidade do sistema. Do ponto de vista estratégico, a ausência de mecanismos inteligentes de economia de energia também dificulta a aderência a políticas de sustentabilidade e eficiência exigidas por auditorias, contratos e programas de compliance corporativo. Fundamentos da Gestão Inteligente de Energia em NAS ASUSTOR Modo S3: Economia Energética com Disponibilidade Imediata O modo S3 de economia de energia, suportado por diversos modelos de NAS ASUSTOR, representa um avanço relevante na gestão energética de storage. Nesse estado, o sistema entra em um modo de baixo consumo quando está ocioso, com gasto energético próximo ao de um equipamento desligado. Diferentemente de um desligamento completo, o modo S3 preserva a capacidade de retomada rápida, permitindo que o NAS volte ao estado operacional em pouco tempo quando requisitado. Essa abordagem reduz significativamente o consumo energético sem comprometer a experiência de acesso aos dados. Do ponto de vista técnico, essa estratégia reduz ciclos desnecessários de funcionamento contínuo, minimizando desgaste físico e aumentando a longevidade dos componentes internos. Wake on LAN e Wake on WAN: Acesso sob Demanda Complementando o modo S3, os recursos Wake on LAN e Wake on WAN permitem que o NAS seja ativado apenas quando necessário, seja a partir da rede local ou remotamente pela internet. Essa funcionalidade elimina a necessidade de manter o dispositivo ligado continuamente apenas para garantir disponibilidade. Em cenários empresariais com horários previsíveis de acesso, isso representa uma redução direta e mensurável no consumo energético. Do ponto de vista operacional, Wake on WAN amplia esse conceito ao permitir acesso remoto sob demanda, mantendo a conveniência sem comprometer a estratégia de economia de energia. Power Schedule no ADM: Alinhando Tecnologia aos Hábitos Operacionais Automação como Instrumento de Eficiência O recurso Power Schedule do sistema operacional ADM permite que administradores definam horários automáticos para ligar, desligar ou colocar o NAS em modo de suspensão, alinhando o funcionamento do storage aos hábitos reais de uso da organização. Essa abordagem reduz a dependência de intervenções manuais e elimina falhas humanas comuns, como esquecer equipamentos ligados durante períodos prolongados de inatividade. Ao programar o NAS para entrar em repouso durante horários noturnos ou períodos sem demanda, as empresas conseguem implementar uma política de economia energética previsível, consistente e confiável. Impacto Estratégico no Custo Operacional Embora cada ciclo de economia pareça pequeno isoladamente, a repetição diária ao longo de meses gera uma redução significativa no consumo total de energia. Esse impacto é especialmente relevante em ambientes com múltiplos dispositivos NAS. Além do benefício financeiro, a previsibilidade do Power Schedule contribui para a governança de TI, permitindo documentar e justificar políticas energéticas alinhadas às boas práticas corporativas. MyArchive: Backup Offline como Estratégia Energética Redução de Consumo em Backups O MyArchive introduz uma abordagem diferenciada para backups ao permitir que discos sejam montados automaticamente apenas durante janelas programadas. Após a conclusão do backup, os discos são desmontados. Quando o drive MyArchive está desconectado, o consumo de energia é inexistente, tornando essa solução particularmente eficiente do ponto de vista energético. Essa característica posiciona o MyArchive como uma estratégia de backup offline que não apenas melhora a segurança dos dados, mas também contribui diretamente para a redução do consumo energético. Trade-offs e Considerações Estratégicas Embora o MyArchive ofereça vantagens claras em economia de energia, ele exige planejamento rigoroso das janelas de backup. A indisponibilidade do disco fora do período programado deve ser considerada no desenho da estratégia de recuperação. Em ambientes empresariais, essa abordagem é especialmente eficaz quando combinada com políticas claras de backup e recuperação, equilibrando eficiência energética e resiliência operacional. Governança, Segurança e Sustentabilidade Eficiência Energética como Pilar de Governança A gestão inteligente de energia em NAS ASUSTOR não se limita à redução de custos. Ela contribui para políticas mais amplas de governança, permitindo demonstrar controle operacional e uso consciente de recursos. Em um cenário onde eficiência

Introdução: o varejo diante da transformação orientada por IA O varejo físico atravessa um momento de inflexão estrutural. A convergência entre expectativas crescentes dos consumidores, pressão por margens mais saudáveis e escassez de mão de obra qualificada força as organizações a repensarem profundamente seus modelos operacionais. Nesse contexto, a aplicação de inteligência artificial diretamente no ambiente da loja deixa de ser um experimento pontual e passa a representar um vetor estratégico de competitividade. A Supermicro posiciona essa transformação como um movimento inevitável em direção ao Intelligent Retail, no qual decisões operacionais passam a ser orientadas por análise em tempo real de dados de vídeo, sensores e sistemas transacionais. A premissa central é clara: sem capacidade de resposta em sub-segundos, aplicações como prevenção de perdas, análise de comportamento do cliente e agentes de IA simplesmente não entregam valor prático. Os custos da inação são elevados. Estoques incorretos, rupturas de gôndola, perdas por furto e ineficiência operacional não apenas afetam a rentabilidade, mas corroem a experiência do cliente. O relatório NVIDIA State of AI in Retail & CPG 2026, citado no material original, evidencia esse impacto ao mostrar que 89% dos respondentes já observam aumento de receita e 95% redução de custos com o uso de IA. Este artigo analisa, sob uma ótica técnico-estratégica, como a Supermicro, em colaboração com um amplo ecossistema de parceiros e com aceleração NVIDIA RTX PRO, constrói uma infraestrutura de Edge AI capaz de viabilizar lojas inteligentes em escala, explorando fundamentos técnicos, desafios de implementação e impactos reais no negócio. O problema estratégico: limites do modelo tradicional de varejo físico Desafios operacionais em ambientes distribuídos Lojas físicas são, por natureza, ambientes altamente distribuídos e heterogêneos. Cada unidade opera com restrições de espaço, energia, conectividade e condições ambientais distintas. A tentativa de centralizar todo o processamento de dados em data centers ou nuvem pública introduz latências incompatíveis com aplicações que exigem resposta imediata. Além disso, o volume de dados gerado por câmeras e sensores torna inviável o envio contínuo de fluxos brutos para processamento remoto. O resultado é uma arquitetura tecnicamente ineficiente e economicamente insustentável para casos de uso como detecção de comportamentos suspeitos ou interação em tempo real com clientes. Consequências da inação tecnológica Quando o varejista não endereça essas limitações, surgem efeitos diretos no negócio. A prevenção de perdas permanece reativa, baseada em auditorias tardias. A gestão de pessoal continua dependente de observação humana e relatórios históricos. A experiência do cliente se fragmenta entre canais digitais sofisticados e lojas físicas pouco responsivas. Esse descompasso cria uma desvantagem competitiva estrutural. Enquanto concorrentes passam a operar com inteligência contínua no ponto de venda, organizações que retardam essa transição enfrentam aumento de custos operacionais e perda de relevância. Fundamentos da solução: Edge AI como pilar do Intelligent Retail Por que o processamento no edge é indispensável O conceito de Edge AI, conforme apresentado pela Supermicro, parte de uma premissa técnica fundamental: aplicações de varejo exigem latência sub-segundo para gerar valor operacional. Somente processando dados diretamente no local — a loja ou o elo da cadeia logística — é possível atingir esse nível de responsividade. Ao deslocar a inferência de IA para o edge, o varejista reduz dependência de conectividade, minimiza custos de transmissão de dados e aumenta a resiliência operacional. Esse modelo também simplifica requisitos de conformidade, ao manter dados sensíveis, como vídeo, localmente processados. Infraestrutura Edge AI da Supermicro A Supermicro estrutura sua proposta em um portfólio amplo e escalável de sistemas Edge AI, projetados para diferentes cenários de loja. Para ambientes sem espaço condicionado, a série fanless E103 viabiliza processamento de IA em locais antes inacessíveis, expandindo o alcance das aplicações. Já a série E300, em formato compacto com ventilação ativa, atende lojas que demandam maior capacidade computacional sem abrir mão de footprint reduzido. Para cargas mais intensivas, a Supermicro oferece sistemas de 1U short-depth até 4U, preparados para GPUs discretas NVIDIA RTX PRO Blackwell, permitindo escalar desempenho conforme a complexidade do caso de uso. Implementação estratégica: do experimento à produção em escala Desafios específicos de implantações no edge Implementar IA no edge não é uma simples extensão do data center. Restrições térmicas, consumo energético, manutenção remota e confiabilidade de hardware assumem papel central. A Supermicro endereça esses desafios com sistemas projetados especificamente para operação contínua em ambientes distribuídos. Outro ponto crítico é o equilíbrio entre performance e ROI. Dimensionar corretamente a infraestrutura evita tanto o subdimensionamento, que compromete a aplicação, quanto o excesso de capacidade, que eleva custos sem retorno proporcional. Ecossistema de parceiros como fator de viabilidade A colaboração com parceiros especializados é um elemento central da estratégia. Soluções como o Evercheck, da Everseen, utilizam Vision AI para detecção e dissuasão de comportamentos indesejados no checkout, atacando diretamente o problema de shrinkage com inferência em tempo real. A Wobot AI demonstra como câmeras já existentes podem ser transformadas em agentes autônomos, capazes de observar, aprender e gerar insights operacionais contínuos. Esse reaproveitamento de infraestrutura reduz barreiras de adoção e acelera o time-to-value. Casos de uso avançados: além da prevenção de perdas Agentes de IA como nova camada de interação A LiveX AI introduz o conceito de agentes de IA como camada padrão de interação entre marcas e consumidores no espaço físico. Ao operar diretamente no edge, esses agentes mantêm fluidez, continuidade e naturalidade no atendimento, algo inviável com arquiteturas centralizadas. Esse modelo aproxima a experiência da loja física da sofisticação já observada no e-commerce, reduzindo a lacuna histórica entre os canais. Digital Twins e otimização da cadeia de valor A parceria entre Kinetic Vision e ALLSIDES evidencia outro vetor estratégico: o uso de digital twins de alta fidelidade. Ao criar uma camada 3D de dados para treinamento de IA, torna-se possível simular layouts, fluxos de checkout e processos logísticos antes da implementação física. Essa abordagem reduz riscos, acelera ciclos de inovação e conecta decisões operacionais a resultados mensuráveis, como maior eficiência e taxas de conversão. Medição de sucesso e impactos no negócio Indicadores operacionais e financeiros O sucesso de iniciativas de Intelligent Retail deve

Introdução O crescimento exponencial do volume de dados nas organizações, aliado à necessidade de maior desempenho, segurança e flexibilidade operacional, tem pressionado pequenas e médias empresas a reavaliar suas arquiteturas de armazenamento. Soluções tradicionais baseadas exclusivamente em servidores genéricos ou storage legados frequentemente não acompanham a evolução das cargas de trabalho modernas, como virtualização, backups de máquinas virtuais, aplicações colaborativas e fluxos de dados intensivos. Nesse contexto, o NAS deixou de ser apenas um repositório de arquivos para assumir um papel estratégico dentro da infraestrutura de TI. Ele passa a atuar como elemento central de desempenho, proteção de dados e escalabilidade. O QNAP TS-473A surge exatamente nesse cenário, posicionando-se como uma plataforma flexível, capaz de evoluir conforme as necessidades do negócio. A inação ou a adoção de soluções subdimensionadas pode resultar em gargalos de desempenho, riscos de perda de dados, custos elevados de manutenção e limitações futuras de crescimento. Escolher uma plataforma inadequada compromete não apenas a eficiência operacional, mas também a capacidade da organização de responder a novas demandas. Este artigo analisa em profundidade o QNAP TS-473A, explorando sua arquitetura baseada em AMD Ryzen, conectividade Multi-Gigabit, suporte a SSD NVMe, sistemas operacionais QTS e QuTS hero, capacidades de expansão, proteção de dados e aplicações empresariais reais, sempre conectando decisões técnicas a impactos diretos no negócio. O desafio estratégico do armazenamento nas PMEs modernas Problema estratégico Empresas em crescimento enfrentam um dilema recorrente: precisam de desempenho e confiabilidade próximos aos ambientes enterprise, mas com restrições orçamentárias e equipes de TI reduzidas. Aplicações como virtualização, backups frequentes, compartilhamento de arquivos e acesso simultâneo de múltiplos usuários impõem cargas mistas de IOPS e throughput. Infraestruturas baseadas exclusivamente em 1 GbE, discos mecânicos e arquiteturas rígidas rapidamente se tornam gargalos. O resultado é latência elevada, janelas de backup prolongadas e degradação da experiência do usuário. Consequências da inação Manter uma arquitetura limitada implica em aumento do tempo de indisponibilidade, riscos operacionais e dificuldades para adotar novas soluções. Além disso, a necessidade de substituições completas em vez de expansões graduais eleva o custo total de propriedade (TCO). Fundamentos da solução O TS-473A foi projetado para oferecer uma base de hardware suficientemente robusta desde o início, mas com opções claras de expansão. Isso permite que a organização cresça de forma incremental, alinhando investimentos à evolução real do negócio. Arquitetura de processamento: AMD Ryzen V1500B Base técnica e implicações estratégicas No coração do QNAP TS-473A está o processador AMD Ryzen™ V1500B quad-core da série V1000, com até 4 núcleos e 8 threads e Turbo Core até 2,2 GHz. Essa escolha arquitetônica diferencia o equipamento de soluções baseadas em CPUs de entrada, oferecendo maior capacidade de processamento paralelo. Esse poder computacional é fundamental para lidar simultaneamente com serviços de arquivo, aplicações QPKG, virtualização, snapshots e criptografia sem comprometer o desempenho geral do sistema. Trade-offs e cenários de aplicação Embora o foco não seja cargas de IA ou HPC, o Ryzen V1500B oferece um equilíbrio sólido entre eficiência energética e desempenho, tornando o TS-473A adequado para ambientes empresariais que exigem consistência operacional. Conectividade Multi-Gigabit: 2,5 GbE como novo padrão Problema estratégico Redes baseadas exclusivamente em 1 GbE tornaram-se um gargalo evidente em ambientes com múltiplos usuários e aplicações intensivas em dados. A migração direta para 10 GbE, por outro lado, pode ser financeiramente inviável para muitas PMEs. Fundamentos da solução O TS-473A incorpora duas portas RJ45 de 2,5 GbE, permitindo ganhos imediatos de desempenho em relação ao 1 GbE tradicional, sem exigir substituição completa do cabeamento existente, já que é compatível com cabos CAT5e. Essa abordagem reduz drasticamente o custo de modernização da rede, viabilizando melhorias perceptíveis em backup, acesso a arquivos e virtualização. Interoperabilidade e escalabilidade A compatibilidade com switches Multi-Gigabit da QNAP possibilita a construção de uma infraestrutura escalável, segura e alinhada ao orçamento. SSD M.2 NVMe: cache e Qtier como aceleradores estratégicos Fundamentos técnicos O TS-473A inclui duas ranhuras SSD M.2 NVMe, permitindo a implementação de cache SSD ou da tecnologia Qtier™. Ambas as abordagens visam reduzir latência e melhorar o desempenho de IOPS, especialmente em acessos aleatórios. Cache SSD para cargas críticas A colocação em cache SSD é particularmente eficaz em ambientes de virtualização e bases de dados, onde o acesso frequente a pequenos blocos de dados pode comprometer o desempenho em discos mecânicos. Qtier como otimização contínua O Qtier™ 2.0 introduz divisão automática em camadas entre SSD M.2, SSD SATA e HDD, movendo dados conforme a frequência de acesso. A deteção de E/S em tempo real permite lidar com picos de tráfego, maximizando o retorno sobre o investimento em SSD. QTS vs QuTS hero: escolha estratégica do sistema operativo QTS: flexibilidade e simplicidade O QTS é adequado para sincronização de ficheiros, aplicações colaborativas e ambientes híbridos HDD/SSD. Sua flexibilidade o torna uma escolha prática para organizações que priorizam versatilidade. QuTS hero: integridade e proteção avançada Baseado em ZFS, o QuTS hero oferece integridade de dados ponto a ponto, snapshots avançados e redução de dados inline (eliminação de duplicados, compressão e compactação). Essas capacidades são críticas para ambientes onde a proteção de dados é prioridade estratégica. Requisitos e trade-offs O QuTS hero exige no mínimo 8 GB de memória, sendo recomendados 16 GB ou mais, especialmente quando se utilizam múltiplas aplicações ou eliminação de duplicados inline. A troca entre sistemas requer a remoção das unidades, o que demanda planejamento cuidadoso. Expansão PCIe: adaptabilidade ao longo do ciclo de vida Fundamentos da expansão Com duas ranhuras PCIe Gen 3 ×4 de baixo perfil, o TS-473A permite adicionar placas de rede 5 GbE/10 GbE, placas QM2 para SSD NVMe, placas USB 3.2 Gen 2, adaptadores Wi-Fi 6 ou controladoras SAS/SATA. Impacto estratégico Essa modularidade prolonga a vida útil do investimento, permitindo que o NAS evolua conforme novas demandas surgem, sem substituições completas. Virtualização e proteção de dados Backup de VMs com Hyper Data Protector O TS-473A suporta cópias de segurança sem agente de VMware vSphere e Microsoft Hyper-V, com backup incremental, eliminação de duplicados global, compressão e agendamento. A conectividade de 2,5 GbE reduz significativamente

Introdução À medida que as organizações dependem cada vez mais de dados para sustentar operações críticas, a infraestrutura de armazenamento deixa de ser apenas um repositório passivo e passa a desempenhar um papel central na continuidade do negócio, na virtualização, na proteção de dados e no desempenho das aplicações. Nesse contexto, soluções NAS empresariais precisam equilibrar capacidade, flexibilidade arquitetural, desempenho consistente e confiabilidade operacional. O QNAP TS-873A surge como uma resposta direta a esse cenário ao combinar um processador AMD Ryzen™ V1500B quad-core, conectividade 2,5 GbE nativa, suporte a expansão PCIe e compatibilidade com dois sistemas operativos distintos — QTS e QuTS hero. Essa combinação posiciona o equipamento não apenas como um NAS de armazenamento, mas como uma plataforma multifuncional para virtualização, backup, cache SSD e ambientes híbridos. Organizações que mantêm infraestruturas legadas baseadas em 1 GbE, discos mecânicos sem aceleração e sistemas de ficheiros sem mecanismos avançados de proteção enfrentam gargalos de desempenho, janelas de backup prolongadas e riscos elevados de integridade de dados. A inação nesse cenário resulta em custos operacionais crescentes, baixa escalabilidade e exposição a falhas difíceis de mitigar. Este artigo analisa em profundidade o QNAP TS-873A sob uma ótica técnico-estratégica, explorando sua arquitetura, opções de sistema operativo, expansão, virtualização, proteção de dados e cenários reais de aplicação empresarial, sempre conectando decisões técnicas a impactos concretos no negócio. Arquitetura do QNAP TS-873A e o desafio do desempenho empresarial Problema estratégico Ambientes empresariais modernos exigem que o armazenamento acompanhe cargas de trabalho mistas: acesso simultâneo a ficheiros, máquinas virtuais, bases de dados, backups e, em alguns casos, processamento multimédia. NAS baseados em CPUs de baixo desempenho ou com conectividade limitada tornam-se rapidamente pontos de estrangulamento. O TS-873A endereça esse desafio ao adotar o processador AMD Ryzen™ V1500B Série V1000, com até 4 núcleos e 8 threads, operando até 2,2 GHz. Essa arquitetura fornece capacidade computacional suficiente para lidar com múltiplos serviços simultâneos, incluindo virtualização, cache SSD e aplicações de backup. Do ponto de vista estratégico, a presença de um processador de classe empresarial reduz a necessidade de infraestruturas paralelas dedicadas a funções específicas, consolidando serviços e simplificando a gestão. Consequências da inação Sem uma base de processamento adequada, o crescimento natural das cargas de trabalho leva a latências elevadas, degradação do desempenho de VMs e falhas em janelas de backup. Isso impacta diretamente a produtividade das equipas e a confiabilidade das operações. Além disso, soluções subdimensionadas frequentemente exigem substituição prematura, gerando custos adicionais de aquisição e migração de dados. Fundamentos da solução O AMD Ryzen™ V1500B combina eficiência energética e capacidade multi-thread, permitindo que o TS-873A execute tarefas intensivas sem comprometer a estabilidade. O suporte a até 64 GB de memória, incluindo memória ECC, reforça a confiabilidade do sistema em cenários onde a integridade dos dados é crítica. A exigência de remoção da memória não ECC para utilização de ECC reflete uma abordagem arquitetural clara: evitar configurações híbridas que poderiam comprometer a estabilidade do sistema. Implementação estratégica Em ambientes empresariais, a adoção do TS-873A deve considerar o dimensionamento adequado de memória, especialmente quando combinado com QuTS hero, virtualização ou múltiplas aplicações QPKG. A escolha consciente da memória ECC reforça a resiliência operacional. Medição de sucesso Indicadores como estabilidade sob carga, redução de latência em aplicações simultâneas e consistência de desempenho durante backups e acessos concorrentes são métricas-chave para avaliar a eficácia dessa arquitetura. Conectividade 2,5 GbE e evolução de rede sem ruptura Problema estratégico Muitas organizações enfrentam o dilema entre permanecer em redes 1 GbE saturadas ou investir em atualizações dispendiosas de 10 GbE. Essa barreira frequentemente atrasa melhorias de desempenho necessárias. O TS-873A integra duas portas RJ45 de 2,5 GbE, retrocompatíveis com 1 GbE e 100 MbE, oferecendo uma evolução gradual e financeiramente viável. Consequências da inação Manter-se exclusivamente em 1 GbE limita severamente o aproveitamento de SSDs, cache e virtualização, tornando investimentos em hardware subutilizados. Fundamentos da solução Com suporte a Port Trunking, o TS-873A pode atingir até 5 Gb/s, permitindo ganhos imediatos de throughput sem substituição da cablagem existente. A compatibilidade com switches 2,5 GbE da QNAP facilita a adoção incremental. Implementação estratégica A estratégia recomendada envolve iniciar com 2,5 GbE para ganhos rápidos e, conforme a maturidade do ambiente, avançar para 10 GbE via placas PCIe, mantendo a longevidade do investimento. Medição de sucesso Redução do tempo de transferência de ficheiros, janelas de backup menores e melhor resposta de aplicações são métricas diretas do impacto da conectividade 2,5 GbE. Expansão PCIe como pilar de flexibilidade arquitetural Problema estratégico Ambientes empresariais raramente permanecem estáticos. Crescimento de dados, novas aplicações e mudanças de topologia exigem uma plataforma adaptável. Fundamentos da solução O TS-873A possui duas ranhuras PCIe Gen 3 ×4, compatíveis com placas de alto perfil. Isso permite adicionar 10 GbE, cache SSD adicional, Fibre Channel, USB 3.2 Gen 2, Wi-Fi 6 ou expansão SAS/SATA. Implementação estratégica Essa abordagem modular permite alinhar investimentos às necessidades reais do negócio, evitando sobreprovisionamento inicial. Pontos de falha e mitigação A escolha inadequada de placas ou a ausência de planeamento térmico pode limitar benefícios. A consulta à lista de compatibilidade é essencial. QTS vs QuTS hero: escolha estratégica do sistema operativo Problema estratégico Nem todos os workloads exigem o mesmo nível de proteção ou redução de dados. Escolher o sistema operativo inadequado pode gerar desperdício de recursos ou riscos desnecessários. Fundamentos da solução O QTS é indicado para sincronização de ficheiros e ambientes híbridos HDD/SSD. Já o QuTS hero, baseado em ZFS, oferece integridade de dados ponta a ponta, eliminação de duplicados, compressão e compactação inline. Trade-offs críticos O QuTS hero exige no mínimo 8 GB de memória, sendo recomendados 16 GB ou mais, e 32 GB para deduplicação eficiente. Além disso, a migração entre sistemas requer remoção das unidades, o que demanda planeamento rigoroso. Medição de sucesso Redução de dados efetiva, estabilidade de volumes e recuperação confiável são indicadores centrais ao adotar QuTS hero. Cache SSD, Qtier e otimização contínua do armazenamento Fundamentos da solução As duas ranhuras M.2 NVMe do TS-873A permitem cache SSD ou tecnologia

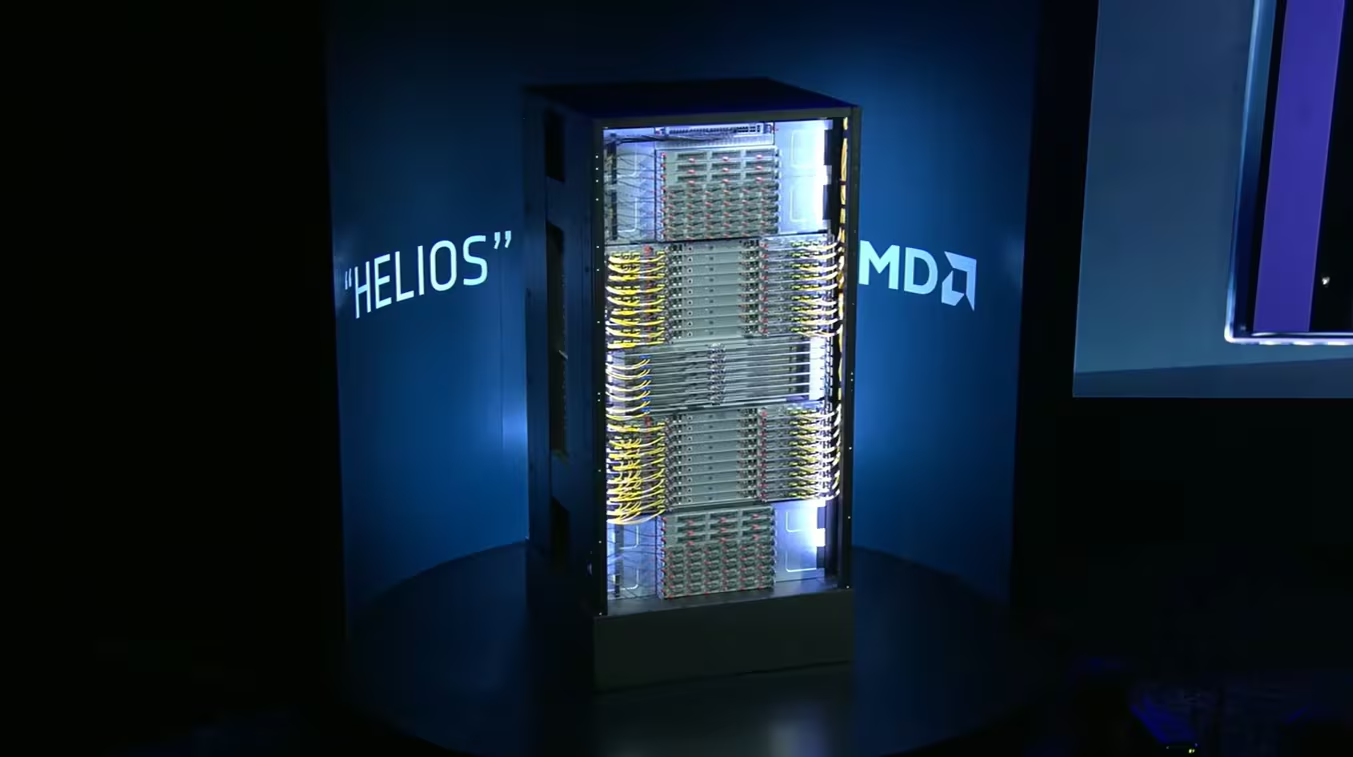

Introdução A aceleração exponencial das cargas de trabalho de inteligência artificial está redefinindo, em ritmo acelerado, os limites da infraestrutura de computação corporativa. Durante a CES 2026, a AMD apresentou uma prévia concreta de como pretende responder a esse desafio ao revelar detalhes do sistema Helios e das futuras GPUs Instinct MI500, posicionando-se estrategicamente para disputar protagonismo em um mercado atualmente dominado pela Nvidia. O cenário descrito pela própria AMD é revelador: ao longo da última década, a capacidade computacional necessária para treinamento de modelos de IA cresceu quatro vezes ao ano, enquanto a inferência passou a dominar o consumo de recursos, com o volume de tokens processados aumentando cem vezes apenas nos últimos dois anos. Essa mudança estrutural impõe pressões inéditas sobre desempenho, largura de banda, eficiência energética e capacidade de integração em escala de data center. Para as organizações, a inação diante desse movimento não é neutra. A incapacidade de acompanhar essas demandas pode resultar em gargalos operacionais, custos crescentes de infraestrutura e perda de competitividade em iniciativas de IA. Nesse contexto, a proposta da AMD com o Helios vai além de um novo GPU: trata-se de uma arquitetura de rack em escala yotta, pensada para integrar CPUs, aceleradores, memória e rede em um sistema coengenheirado. Este artigo analisa, de forma aprofundada, os fundamentos técnicos e estratégicos do sistema Helios, das GPUs MI455 e da futura família MI500, avaliando implicações para arquiteturas de IA corporativas, desafios de implementação e os possíveis impactos no equilíbrio competitivo do mercado de infraestrutura para inteligência artificial. O desafio estratégico da IA em escala extrema Pressão crescente por desempenho e escala A expansão acelerada das aplicações de IA corporativa deslocou o foco do treinamento isolado de modelos para a execução contínua de inferência em larga escala. Esse movimento altera radicalmente o perfil das cargas de trabalho, exigindo não apenas maior poder computacional bruto, mas também conectividade de altíssima velocidade entre milhares de aceleradores. Segundo a AMD, a inferência já supera o treinamento em volume de processamento, o que implica arquiteturas capazes de sustentar fluxos massivos de dados com latência mínima. Em ambientes corporativos, isso se traduz na necessidade de racks altamente integrados, capazes de operar como sistemas unificados e não como conjuntos de servidores isolados. Ignorar essa transição implica arquitetar data centers que rapidamente se tornam obsoletos, incapazes de absorver o crescimento das cargas de IA sem custos desproporcionais de expansão ou complexidade operacional excessiva. Consequências da inação Organizações que mantêm arquiteturas fragmentadas enfrentam limitações claras: subutilização de GPUs, gargalos de memória, latências elevadas entre nós e aumento do consumo energético por unidade de desempenho entregue. Em escala, esses fatores comprometem tanto o retorno sobre investimento quanto a viabilidade de projetos avançados de IA. Além disso, a dependência de soluções pouco integradas dificulta a adoção de novos aceleradores e tecnologias de interconexão, ampliando riscos de lock-in arquitetural e reduzindo flexibilidade estratégica. Fundamentos do sistema Helios Arquitetura de rack em escala yotta O Helios foi concebido pela AMD como uma plataforma de rack modular e aberta, capaz de evoluir ao longo de múltiplas gerações de produtos. Essa abordagem reconhece que a escala exigida pela IA moderna não pode ser atendida apenas por ganhos incrementais de desempenho em componentes isolados. Quando entrar em produção, ainda em 2026, o Helios combinará GPUs Instinct MI455, CPUs EPYC “Venice”, memória HBM4 e unidades de processamento de dados (DPUs) Pensando, integradas por meio da arquitetura de empilhamento 3D da AMD e resfriamento líquido. O foco declarado da empresa é oferecer soluções turnkey, reduzindo a complexidade de implantação em ambientes corporativos e permitindo que milhares de aceleradores operem como um único sistema lógico. Interconexão e rede como pilares Um dos diferenciais centrais do Helios é o uso de interconexões Ethernet de alta velocidade em múltiplos níveis. Dentro do rack, os dados trafegam via Ultra Accelerator Link (UALink), enquanto a comunicação entre racks ocorre por meio de Ultra Ethernet (UE) e NICs compatíveis. Essa escolha reflete uma estratégia de adoção de padrões abertos e escaláveis, em oposição a interconexões proprietárias, facilitando a expansão para dezenas de milhares de racks interligados em um único data center. Do ponto de vista corporativo, essa abordagem favorece interoperabilidade e governança, reduzindo riscos associados à adoção de tecnologias fechadas em ambientes críticos. GPUs Instinct MI455: base computacional do Helios Avanços arquiteturais e densidade extrema A GPU MI455 foi descrita pela AMD como o chip mais avançado já produzido pela empresa. Construída com processos de 2 nm e 3 nm, ela incorpora 320 bilhões de transistores, representando um aumento de 70% em relação à geração anterior MI355. O design utiliza 12 chiplets de computação e I/O, integrados por meio da tecnologia de empilhamento 3D da AMD, além de 432 GB de memória HBM4 de alta velocidade. Quatro dessas GPUs são instaladas em cada bandeja de computação do Helios. Essa densidade extrema visa atender diretamente às demandas de inferência e treinamento em larga escala, reduzindo latências internas e maximizando a taxa de transferência de dados. Implicações para desempenho e eficiência A combinação de HBM4 e empilhamento 3D permite que a MI455 opere com larguras de banda significativamente superiores às gerações anteriores, mitigando gargalos comuns em cargas de IA intensivas em memória. Do ponto de vista estratégico, esse avanço reforça a posição da AMD como fornecedora de aceleradores capazes de competir em ambientes de missão crítica, onde eficiência energética e densidade por rack são fatores determinantes. CPUs EPYC “Venice” e a coengenharia CPU-GPU CPU projetada para IA As CPUs EPYC Venice, baseadas na arquitetura Zen 6 em processo de 2 nm, foram explicitamente projetadas para atuar como “AI CPUs”, segundo a própria AMD. O foco está na ampliação da largura de banda de memória e de comunicação com GPUs. De acordo com Lisa Su, a Venice dobra a largura de banda de memória e de GPU em relação à geração anterior, garantindo que as MI455 sejam alimentadas com dados em velocidade plena, mesmo em escala de rack. Essa coengenharia reduz desequilíbrios clássicos entre CPU e GPU, comuns em

Introdução A transformação digital acelerou de forma decisiva a complexidade das redes empresariais. Organizações modernas operam simultaneamente com aplicações críticas, múltiplas filiais, trabalhadores remotos, dispositivos IoT e volumes crescentes de dados armazenados em NAS corporativos. Nesse cenário, o router deixou de ser apenas um elemento de conectividade e passou a desempenhar um papel estratégico na continuidade operacional, na segurança e na eficiência do negócio. O QHora-322 surge como resposta direta a esse novo paradigma. Posicionado como um router SD-WAN de próxima geração, ele combina portas de alta velocidade 10 GbE e 2,5 GbE com uma arquitetura de encaminhamento totalmente definida por software, integrada nativamente ao ecossistema QuWAN SD-WAN da QNAP. Essa combinação reflete uma mudança estrutural: da gestão manual e fragmentada para um modelo centralizado, automatizado e orientado à segurança. As organizações que mantêm infraestruturas de rede tradicionais enfrentam riscos claros: gargalos de desempenho, elevada complexidade operacional, dificuldades de expansão multilocal e exposição crescente a ataques cibernéticos. A ausência de segmentação adequada, de redundância de WAN e de túneis VPN bem geridos resulta frequentemente em interrupções de serviço e perdas operacionais. Este artigo analisa de forma aprofundada o QHora-322 sob a perspetiva estratégica e técnica, contextualizando seus fundamentos, implicações práticas, cenários de uso empresarial e integração com NAS QNAP, IoT e ambientes distribuídos, sempre conectando as decisões tecnológicas aos impactos reais no negócio. O desafio estratégico das redes empresariais modernas Fragmentação, desempenho e risco operacional À medida que empresas expandem operações para múltiplos locais, a rede passa a ser um dos principais fatores de risco operacional. Infraestruturas baseadas em routers convencionais, configurados manualmente e sem inteligência de tráfego, não acompanham a dinâmica atual de aplicações distribuídas e fluxos de dados intensivos. Ambientes com NAS empresariais, videovigilância, sistemas POS, ERP e acesso remoto exigem largura de banda elevada, latência previsível e segurança consistente entre todos os pontos da rede. Sem esses requisitos, a experiência do utilizador degrada-se, os tempos de resposta aumentam e processos críticos tornam-se vulneráveis. Além disso, a gestão descentralizada de VPNs e políticas de firewall cria inconsistências de segurança. Cada novo local ou colaborador remoto adiciona complexidade, aumentando a probabilidade de falhas de configuração e brechas exploráveis. Consequências da inação A manutenção de uma arquitetura de rede tradicional implica custos ocultos elevados. Interrupções de conectividade entre filiais, falhas em backups remotos e lentidão na replicação de dados afetam diretamente a continuidade dos negócios. Do ponto de vista de segurança, a ausência de segmentação e de um modelo Zero Trust expõe NAS, dispositivos IoT e sistemas internos a ataques laterais, ransomware e acessos não autorizados. Esses riscos são amplificados quando o acesso remoto cresce sem uma estratégia SD-WAN bem definida. Fundamentos técnicos do QHora-322 Arquitetura de portas e desempenho com fios O QHora-322 disponibiliza três portas de 10 GbE e seis portas de 2,5 GbE, permitindo uma implementação altamente flexível de WAN e LAN. Cada porta é, por predefinição, independente, o que representa uma mudança importante face aos routers tradicionais com portas rigidamente agrupadas. Essa abordagem orientada por software possibilita que cada interface seja definida conforme a necessidade do negócio, seja para ligações WAN de alta velocidade, LANs dedicadas ou segmentos isolados para IoT. A compatibilidade multi-speed (10G/5G/2,5G/1G/100M) assegura interoperabilidade com infraestruturas existentes. O suporte a PPPoE de 10 GbE com desempenho superior a 9 Gb/s posiciona o QHora-322 num patamar de conectividade normalmente reservado a ambientes empresariais de maior escala, garantindo capacidade suficiente para aplicações intensivas e backups contínuos. Encaminhamento definido por software O modelo de encaminhamento do QHora-322 é totalmente controlado pelo SO QuRouter. Em vez de configurações estáticas e complexas, a segmentação de rede, a atribuição de portas e as políticas de tráfego são definidas de forma lógica e adaptável. O suporte a encaminhamento baseado em políticas e rotas estáticas permite direcionar tráfego conforme IP de origem, aplicação ou dispositivo. Essa granularidade é essencial para otimizar fluxos, evitar congestionamentos e garantir previsibilidade de desempenho. SD-WAN e VPN mesh com QuWAN VPN mesh automatizada A tecnologia QuWAN SD-WAN estabelece automaticamente uma VPN em rede mesh segura entre dispositivos QNAP em múltiplos locais. Essa automatização elimina a necessidade de configurações manuais complexas, reduzindo drasticamente o tempo de implementação. Ao adicionar o QHora-322 ao QuWAN Orchestrator, o sistema configura rotas e túneis VPN de forma centralizada. Isso viabiliza uma arquitetura multilocal consistente, onde sede, filiais e até NAS remotos comunicam-se como se estivessem na mesma rede lógica. Escalabilidade e alta disponibilidade O QHora-322 suporta até 1000 ligações VPN simultâneas, refletindo uma capacidade alinhada a ambientes empresariais com grande número de utilizadores remotos ou dispositivos conectados. Funcionalidades como agregação de WAN dupla, balanceamento de carga e ativação pós-falha asseguram continuidade operacional. Em caso de falha de uma ligação, o tráfego é automaticamente redirecionado, minimizando impactos nos serviços críticos. Integração estratégica com NAS e backup seguro Proteção do NAS e acesso remoto O emparelhamento do QHora-322 com um NAS QNAP é fortemente recomendado para cenários empresariais. Ao posicionar o router à frente do NAS, a tradução de endereços de rede (NAT) oculta o IP real do dispositivo, reduzindo a superfície de ataque. Essa arquitetura protege não apenas NAS QNAP, mas também dispositivos de outros fabricantes, criando uma camada adicional de segurança perimetral. Backups remotos e air-gap Com o uso do Hybrid Backup Sync através do QuWAN, é possível transferir ficheiros e snapshots entre vários NAS por meio de uma rede encriptada. Isso viabiliza estratégias de backup remoto seguras, fundamentais para continuidade de negócios. O suporte à solução Airgap+ permite isolar logicamente redes de backup, protegendo dados contra ransomware e vazamentos. Esse modelo de isolamento representa uma evolução importante face a backups tradicionais sempre online. Segmentação, IoT e governança de rede Segmentação VLAN e IoT O QHora-322 permite a criação de múltiplos segmentos VLAN, separando aplicações, dispositivos IoT e sistemas críticos mesmo quando partilham a mesma infraestrutura física. A conectividade direta de dispositivos IoT em segmentos independentes reduz riscos de movimentação lateral e garante que dispositivos heterogéneos possam coexistir sem comprometer a segurança. Governança e controlo de aplicações A firewall L7

Supermicro leva desempenho de IA corporativa para cliente, edge e desktop Introdução A adoção de inteligência artificial deixou de ser um privilégio exclusivo de grandes data centers e ambientes de hyperscale. Organizações de todos os portes enfrentam hoje a necessidade de executar modelos de IA próximos às fontes de dados, com menor latência, maior controle sobre informações sensíveis e custos operacionais previsíveis. Esse movimento pressiona o mercado por soluções que levem desempenho de classe empresarial para formatos mais compactos, acessíveis e distribuídos. Nesse contexto, a Supermicro anuncia a expansão de seu portfólio de sistemas de IA corporativa para além do data center tradicional, alcançando estações de trabalho avançadas, plataformas de edge computing e até o segmento de PCs de alto desempenho. A proposta não é apenas miniaturizar hardware, mas preservar características críticas como capacidade computacional, eficiência energética, escalabilidade e segurança de dados. O desafio estratégico para empresas, instituições de pesquisa e startups está em equilibrar inovação em IA com limitações práticas: ausência de infraestrutura de cluster, custos elevados de nuvem, preocupações com privacidade e restrições de latência. A inação ou a adoção inadequada de plataformas pode resultar em gargalos de desenvolvimento, dependência excessiva de serviços externos e perda de competitividade. Este artigo analisa, de forma técnica e estratégica, como a Supermicro estrutura sua nova geração de sistemas para atender esses desafios, explorando os fundamentos das plataformas apresentadas, seus cenários de aplicação e as implicações para ambientes corporativos, educacionais e industriais. O desafio estratégico da IA fora do data center Problema estratégico À medida que aplicações de IA se tornam mais distribuídas, cresce a demanda por execução local de modelos para inferência, ajuste fino e prototipação. No entanto, a maioria das organizações não possui acesso contínuo a clusters de GPU ou a orçamentos que viabilizem o uso intensivo de serviços de nuvem para essas finalidades. Além disso, workloads de IA modernos frequentemente exigem grandes volumes de memória, interconexão eficiente entre CPU e aceleradores e baixa latência de acesso aos dados. Plataformas convencionais de workstation baseadas apenas em GPUs PCIe tendem a se tornar limitantes nesses cenários. Consequências da inação A incapacidade de executar IA localmente força equipes a recorrerem à nuvem, introduzindo dependência de disponibilidade externa, custos recorrentes e possíveis riscos de compliance relacionados à transferência de dados sensíveis. Em ambientes acadêmicos e de pesquisa, isso pode limitar experimentação e atrasar ciclos de inovação. No edge, a ausência de plataformas adequadas resulta em arquiteturas fragmentadas, com desempenho insuficiente para workloads virtualizados ou aplicações de IA em tempo real, comprometendo iniciativas em varejo, indústria 4.0 e automação. Fundamentos da solução A abordagem da Supermicro parte do conceito de “Application-Optimized Total IT Solutions”, no qual cada sistema é projetado para um perfil específico de workload. Ao integrar tecnologias de NVIDIA, Intel e AMD, a empresa busca cobrir desde o desenvolvimento de modelos até a execução em ambientes distribuídos. Essa estratégia se reflete na diversidade de formatos — deskside, rack compacto, mini-1U, tower e sistemas fanless — sem abandonar princípios de arquitetura corporativa como gerenciamento remoto, eficiência energética e suporte a grandes capacidades de memória. Super AI Station: desempenho de data center no formato deskside Problema estratégico Desenvolvedores de IA, startups e instituições de ensino frequentemente carecem de infraestrutura de servidor dedicada para treinamento e inferência avançados. Workstations tradicionais não conseguem atender modelos de grande porte, enquanto clusters e serviços de nuvem podem ser inviáveis por custo, latência ou restrições de privacidade. Fundamentos técnicos da solução A Super AI Station (ARS-511GD-NB-LCC) introduz o superchip NVIDIA GB300 Grace Blackwell Ultra Desktop em um formato deskside, algo inédito segundo a própria Supermicro. Essa integração resulta em mais de 5x AI PFLOPS de capacidade computacional quando comparada a workstations baseadas em GPUs PCIe tradicionais. Um dos elementos centrais é o suporte a 775 GB de memória coerente, permitindo o processamento local de modelos massivos sem a fragmentação típica de arquiteturas convencionais. O uso de refrigeração líquida integrada garante a sustentação térmica necessária para esse nível de desempenho. Implementação estratégica Ao ser implantada on-premises, a Super AI Station oferece latência mínima e controle total sobre os dados, eliminando a necessidade de transferência para ambientes externos. Isso é particularmente relevante para organizações com restrições de confidencialidade ou requisitos regulatórios. A plataforma se apresenta como uma solução completa para fine-tuning, inferência, prototipação e desenvolvimento de aplicações de IA, sem depender de infraestrutura de cluster. Cenários críticos e trade-offs Embora entregue desempenho excepcional, a adoção desse tipo de sistema pressupõe maturidade técnica para operação e manutenção de soluções com refrigeração líquida. Ainda assim, para ambientes que não podem acessar clusters ou nuvem, o trade-off se mostra estratégico. Workstations Intel Xeon 6 para IA agentic e mídia Problema estratégico Aplicações como VDI, streaming ao vivo, CDN e software-defined broadcast demandam não apenas capacidade de IA, mas também aceleração de mídia e conectividade de rede de alta velocidade. Fundamentos técnicos O Supermicro SYS-542T-2R, baseado em processadores Intel Xeon 6 SoC, suporta uma ampla gama de GPUs e grande capacidade de memória. A presença de aceleração integrada de transcodificação de mídia atende diretamente workloads de distribuição de conteúdo. A conectividade 2x 100GbE QSFP28 posiciona o sistema como um nó central para ambientes que exigem alto throughput e baixa latência de rede. Aplicações e governança Essas características permitem consolidar múltiplos serviços — VDI, streaming, CDN — em uma única plataforma, simplificando a governança e reduzindo a complexidade operacional. AI PC e produtividade baseada em IA Problema estratégico A IA começa a se integrar aos fluxos de trabalho cotidianos, exigindo plataformas capazes de executar aplicações localmente, sem depender constantemente de recursos externos. Fundamentos da solução O Supermicro AI PC (AS-C521D-11302U), baseado nos mais recentes CPUs AMD, foi projetado para o mercado de PCs slim. Seu design minimalista e foco em aplicações de IA refletem a tendência de levar aceleração computacional para o ambiente de escritório e uso pessoal. Essa linha é complementada por workstations GPU-ready, ampliando o espectro de desempenho disponível para usuários corporativos. Edge AI: eficiência, compactação e gerenciamento Problema estratégico No edge, espaço

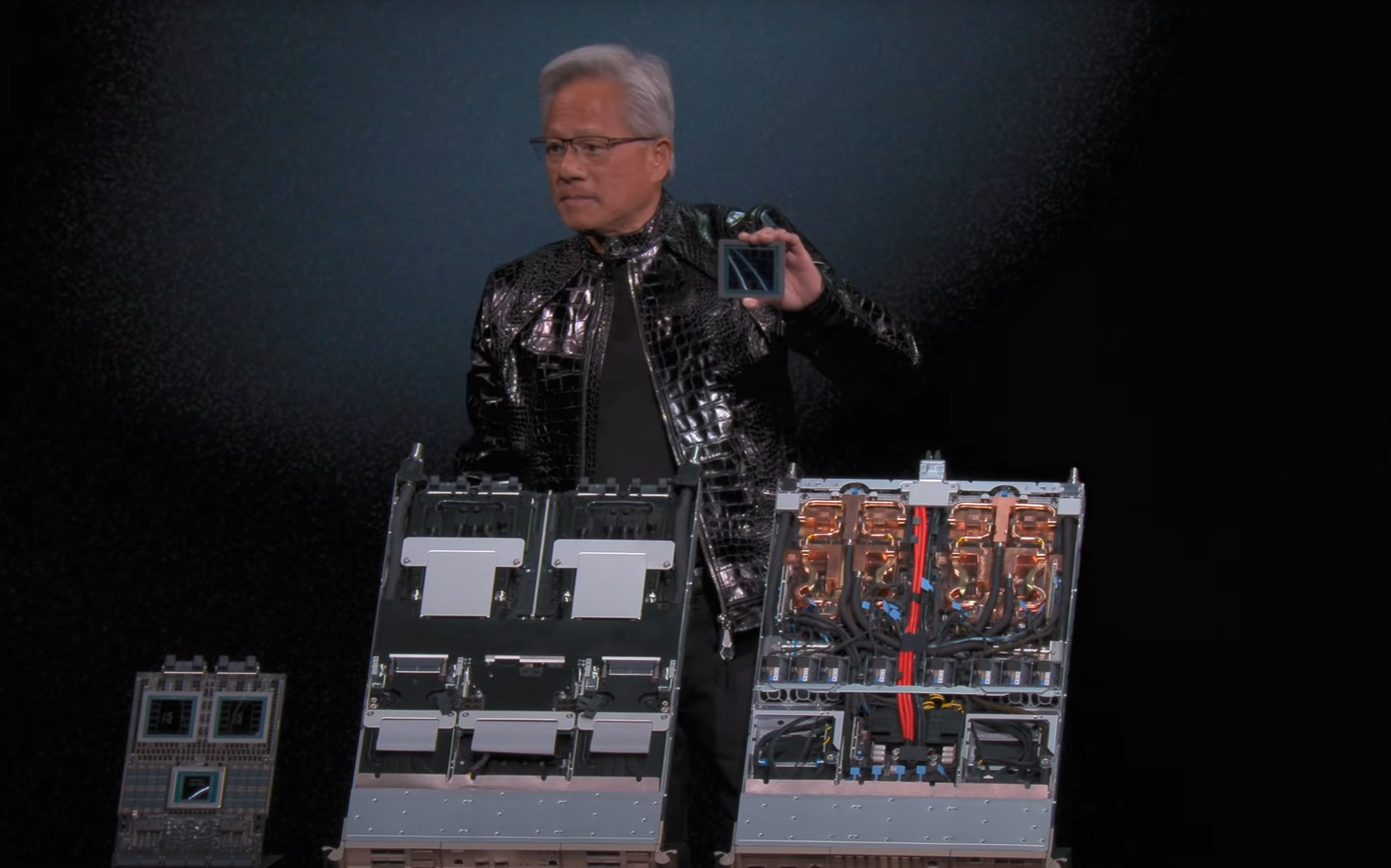

Nvidia Rubin: arquitetura que redefine desempenho e escala da IA Introdução: a próxima fronteira da computação para IA A evolução recente da inteligência artificial deixou de ser limitada por algoritmos e passou a ser condicionada pela capacidade da infraestrutura computacional de acompanhar modelos cada vez maiores, mais complexos e mais intensivos em dados. Nesse contexto, a Nvidia ocupa um papel central ao concentrar aproximadamente 90% do mercado de chips dedicados à IA, tornando suas decisões arquitetônicas determinantes para todo o ecossistema. Com o anúncio oficial da plataforma Vera Rubin na CES 2026, a Nvidia não apresentou apenas uma nova GPU, mas sinalizou uma mudança profunda na forma como a indústria precisa pensar desempenho, escalabilidade e design de sistemas para IA. Segundo a própria empresa, a GPU Rubin entregará um aumento de cinco vezes no desempenho de inferência NVPF4 e de 3,5 vezes no treinamento, quando comparada à geração Blackwell. Esse salto não ocorre em um cenário trivial. A desaceleração da Lei de Moore impõe limites claros ao crescimento linear de transistores, enquanto a demanda por geração de tokens de IA e redução de custos pressiona arquiteturas existentes. A Rubin surge, portanto, como resposta direta a um problema estratégico: como continuar escalando desempenho em um mundo onde simplesmente “colocar mais transistores” já não é suficiente. Este artigo analisa, de forma técnica e estratégica, o que a arquitetura Nvidia Rubin representa para organizações que dependem de IA em larga escala, explorando seus fundamentos, implicações, riscos e os novos paradigmas de design que emergem com essa geração. O problema estratégico: escalar IA além dos limites da Lei de Moore O desafio estrutural da evolução dos modelos de IA Modelos de IA modernos cresceram em ordens de magnitude nos últimos anos, tanto em parâmetros quanto em volume de dados processados. Esse crescimento cria uma pressão contínua por maior capacidade de inferência e treinamento, especialmente em ambientes corporativos e científicos que operam em escala industrial. Entretanto, conforme destacado pelo próprio CEO da Nvidia, Jensen Huang, a Lei de Moore desacelerou significativamente. O número de transistores adicionados a cada nova geração de chips já não acompanha o ritmo de crescimento dos modelos, criando um descompasso estrutural entre demanda computacional e capacidade física do silício. Esse cenário torna inviável depender exclusivamente de ganhos incrementais tradicionais. Um aumento de 1,6 vezes no número de transistores, como ocorre do Blackwell para o Rubin, não seria suficiente para sustentar aumentos de desempenho da ordem de cinco ou dez vezes exigidos pelo mercado. Consequências da inação arquitetônica Sem uma mudança estrutural no design dos sistemas, organizações enfrentariam custos crescentes, gargalos de desempenho e limitação na viabilidade econômica de aplicações de IA em larga escala. A incapacidade de escalar inferência impacta diretamente modelos generativos, sistemas de recomendação e aplicações que dependem de respostas em tempo quase real. Além disso, a estagnação arquitetônica comprometeria a redução do custo por token, um fator crítico para a viabilidade comercial de soluções de IA. Nesse sentido, a inação não representa apenas um problema técnico, mas um risco estratégico direto para negócios baseados em IA. Fundamentos da solução: a arquitetura Nvidia Rubin Desempenho bruto e métricas divulgadas De acordo com a Nvidia, a GPU Rubin oferecerá 50 petaflops de desempenho de inferência NVPF4, representando um aumento de cinco vezes em relação à Blackwell. No treinamento NVPF4, o desempenho anunciado é de 35 petaflops, um ganho de 3,5 vezes. Esses números são acompanhados por avanços substanciais na subsistema de memória. A Rubin contará com 22 TB/s de largura de banda de memória HBM4, uma melhoria de 2,8 vezes sobre a geração anterior. Esse aspecto é crítico, pois gargalos de memória frequentemente limitam o aproveitamento do poder computacional em cargas de IA. No campo da interconexão, cada GPU Rubin oferecerá 3,6 TB/s de largura de banda NVLink, o dobro do que estava disponível no Blackwell. Esse fator é determinante para arquiteturas multi-GPU e sistemas NVL72, onde a comunicação entre aceleradores define o desempenho global. O papel do processador Vera A plataforma Vera Rubin não se limita à GPU. O processador Vera, baseado em arquitetura Arm, foi projetado para substituir o Grace e, segundo Jensen Huang, oferecerá o dobro de desempenho. Embora a Nvidia não tenha divulgado métricas detalhadas, alguns elementos arquitetônicos foram confirmados. O chip contará com 88 núcleos Olympus personalizados e suportará 176 threads por núcleo por meio da tecnologia de “multithreading espacial” da Nvidia. Essa abordagem indica uma otimização profunda para cargas altamente paralelizáveis, típicas de pipelines de IA. O Vera também incorpora uma conexão NVLink C2C de 1,8 TB/s, 1,5 TB de memória on-chip — três vezes mais que o Grace — e 1,2 TB/s de largura de banda de memória LPDDR5X. Esses números reforçam a estratégia de eliminar gargalos entre CPU e GPU, tratando o sistema como uma entidade coesa. Design colaborativo extremo: rompendo paradigmas tradicionais Por que redesenhar tudo ao mesmo tempo Historicamente, a Nvidia seguia uma regra interna clara: nenhuma nova geração deveria introduzir mais do que uma ou duas mudanças significativas no chip. Essa abordagem reduzia riscos e facilitava a evolução incremental. Contudo, conforme explicado por Huang, esse modelo tornou-se inviável diante da desaceleração da Lei de Moore e da explosão dos modelos de IA. A Rubin representa uma ruptura deliberada, na qual cada componente — GPU, CPU, interconexão, memória e rack — foi redesenhado simultaneamente. Esse “design colaborativo extremo” permite ganhos sistêmicos que não seriam alcançáveis por otimizações isoladas. O aumento de desempenho não vem apenas do silício, mas da integração profunda entre todos os elementos do sistema. O caso do Vera Rubin NVL72 O pod Vera Rubin NVL72 exemplifica essa abordagem. O primeiro rack, apresentado na CES 2026, contém 18 bandejas de computação, nove bandejas NVLink e pesa quase duas toneladas. Segundo a Nvidia, o sistema totaliza 220 trilhões de transistores. Huang afirmou que o projeto consumiu o equivalente a 15.000 anos de engenharia, uma métrica simbólica que ilustra a complexidade e o nível de coordenação necessário para viabilizar essa geração. Esse tipo de sistema não pode ser analisado

Introdução: a pressão estrutural por densidade e eficiência nos data centers modernos A evolução dos workloads corporativos, especialmente aqueles associados a HPC e inteligência artificial, impôs uma ruptura estrutural na forma como data centers são projetados. O crescimento simultâneo da demanda por poder computacional, eficiência energética e otimização de espaço físico criou um cenário no qual arquiteturas tradicionais em rack começam a se tornar um fator limitante, tanto técnica quanto economicamente. Setores como manufatura avançada, serviços financeiros, pesquisa científica, energia e modelagem climática dependem cada vez mais de ambientes capazes de escalar desempenho sem crescimento proporcional de consumo elétrico, complexidade operacional e footprint físico. Nesse contexto, a densidade computacional deixa de ser apenas uma métrica técnica e passa a ser um elemento estratégico. A Supermicro responde diretamente a esse desafio com a nova geração do 6U SuperBlade®, equipada com processadores Intel® Xeon® 6900 Series. Trata-se de uma proposta arquitetônica que redefine a relação entre desempenho, espaço e eficiência, ao mesmo tempo em que reduz custos operacionais por meio de compartilhamento de recursos, gestão centralizada e opções avançadas de refrigeração. Este artigo analisa, de forma aprofundada, os fundamentos técnicos, implicações estratégicas e cenários de aplicação do Supermicro 6U SuperBlade, conectando suas decisões arquitetônicas aos desafios reais enfrentados por organizações que operam infraestruturas críticas. O problema estratégico: limites físicos, energéticos e operacionais do modelo tradicional Por que arquiteturas 1U se tornaram insuficientes O modelo tradicional baseado em servidores 1U independentes foi concebido para um cenário onde densidade de núcleos, consumo energético e refrigeração eram variáveis mais previsíveis. Com a chegada de CPUs de altíssimo TDP e cargas altamente paralelizáveis, esse modelo passou a escalar de forma ineficiente. O aumento do número de servidores implica crescimento proporcional de cabos, fontes de alimentação, ventoinhas e pontos de falha. Isso se traduz diretamente em maior complexidade operacional, maior consumo energético indireto e maior custo de manutenção. Além disso, racks tradicionais rapidamente atingem limites térmicos e elétricos, exigindo investimentos adicionais em refrigeração e infraestrutura predial, muitas vezes inviáveis em data centers existentes. Consequências da inação arquitetônica Manter arquiteturas inadequadas para workloads modernos resulta em desperdício de espaço, ineficiência energética e limitação de crescimento. Em ambientes HPC e IA, isso pode significar menor capacidade de processamento por metro quadrado e menor competitividade operacional. A fragmentação da gestão, com múltiplos pontos de controle e ausência de orquestração centralizada, também aumenta o risco operacional e reduz a capacidade de resposta a incidentes. Fundamentos da solução Supermicro 6U SuperBlade Arquitetura de alta densidade orientada a compartilhamento de recursos O Supermicro 6U SuperBlade foi projetado para maximizar a densidade computacional por rack por meio de um chassis compacto de 32 polegadas de profundidade, compatível com racks padrão de 19 polegadas, eliminando a necessidade de racks profundos. Um único enclosure 6U suporta até 10 blades SBI-622BA-1NE12-LCC, permitindo alcançar até 25.600 núcleos de alto desempenho por rack. Essa densidade é viabilizada pelo uso de recursos compartilhados, como fontes de alimentação, sistemas de ventilação, networking integrado e gerenciamento centralizado. Essa abordagem reduz drasticamente a redundância de componentes físicos, resultando em menor consumo energético agregado e menor custo total de propriedade. Processadores Intel Xeon 6900 Series como pilar computacional Cada blade é equipado com dois processadores Intel Xeon 6900 Series, cada um com até 128 P-cores e até 500W de TDP. Essa configuração é especialmente adequada para workloads altamente paralelizáveis, comuns em HPC e IA. A elevada contagem de núcleos por socket permite consolidar cargas de trabalho que, anteriormente, exigiriam múltiplos servidores físicos, reduzindo latência interna e aumentando a eficiência do processamento. Refrigeração como elemento estratégico de performance e eficiência Suporte a refrigeração a ar e líquida direta O SuperBlade oferece suporte tanto a refrigeração a ar (com até 5 nós por enclosure 6U) quanto a refrigeração líquida direta (até 10 nós por enclosure 6U), incluindo opções de cold plates para CPU, DIMM e VRM. A refrigeração líquida direta permite lidar com CPUs de alto TDP de forma mais eficiente, reduzindo hotspots térmicos e permitindo maior densidade sem comprometer a estabilidade. Essa flexibilidade possibilita que data centers adotem uma estratégia híbrida ou progressiva, sem a necessidade de reformulações estruturais imediatas. Memória, armazenamento e expansão: flexibilidade para workloads intensivos Capacidade e desempenho de memória Cada blade suporta até 24 slots DIMM, permitindo configurações de até 3TB de DDR5 RDIMM a 6400MT/s ou 1,5TB de DDR5 MRDIMM a 8800MT/s. Essa capacidade é crítica para aplicações intensivas em memória, como simulações científicas e análise de grandes volumes de dados. Armazenamento NVMe e opções PCIe O subsistema de armazenamento suporta até quatro SSDs NVMe PCIe 5.0, dois SSDs E1.S hot-swap e dois SSDs M.2, oferecendo baixa latência e alta taxa de transferência. A expansão PCIe inclui suporte a três placas PCIe 3.0 x16, possibilitando combinações com GPUs e placas de rede InfiniBand/Ethernet de até 400G, fundamentais para workloads de IA e HPC distribuído. Networking integrado e redução radical de cabos O enclosure integra dois switches Ethernet de 25G com uplinks de 100G, posicionados na parte traseira do chassis. Essa arquitetura reduz drasticamente a necessidade de cabeamento externo. Segundo a Supermicro, essa abordagem permite uma redução de até 93% no cabeamento e até 50% de economia de espaço em comparação com servidores rackmount tradicionais, impactando diretamente o TCO e a simplicidade operacional. Gestão centralizada e controle operacional avançado SuperBlade Chassis Management Module (CMM) O CMM fornece controle remoto completo sobre blades, fontes, ventiladores e switches. Por ser um controlador dedicado, todas as funções de monitoramento e gestão permanecem operacionais independentemente do estado dos CPUs. Recursos como power capping, alocação de energia por blade, reboot remoto, acesso à BIOS e console via SOL ou KVM embarcado aumentam significativamente a governança e reduzem o tempo de resposta a incidentes. Impacto direto no TCO e modernização de data centers O design hot-swappable, a alta densidade e o compartilhamento de recursos reduzem custos operacionais, facilitam manutenção e aceleram ciclos de atualização tecnológica. Ao entregar o desempenho equivalente a um rack inteiro tradicional em um único enclosure 6U, o SuperBlade se posiciona como uma

Qnap TS: como escolher o melhor NAS server para cada ambiente Introdução A centralização de dados deixou de ser uma conveniência técnica e passou a ser um requisito estratégico para organizações e usuários que lidam com volumes crescentes de informação digital. Arquivos espalhados entre computadores, notebooks e discos externos não apenas dificultam o acesso e o compartilhamento, como ampliam significativamente os riscos de perda de dados, falhas de backup e interrupções operacionais. Esse cenário fragmentado afeta tanto usuários domésticos quanto empresas. Em ambientes corporativos, a ausência de um ponto central de armazenamento compromete rotinas de backup, dificulta o controle de permissões e cria vulnerabilidades de segurança. Em contextos domésticos e pequenos escritórios, a desorganização gera retrabalho e perda de produtividade. É nesse contexto que um NAS server se consolida como a resposta mais completa. A linha Qnap TS foi projetada para atender diferentes perfis de uso, variando desde aplicações simples de compartilhamento de arquivos até cenários empresariais com virtualização, snapshots e alta disponibilidade. No entanto, a variedade de modelos torna a escolha inadequada um risco real. Este artigo analisa, de forma estratégica e técnica, como escolher o modelo Qnap TS mais adequado para cada ambiente. A abordagem parte dos desafios reais enfrentados pelos usuários, explora os fundamentos técnicos da solução e conecta cada decisão de hardware e software aos impactos diretos no desempenho, na segurança e na escalabilidade do ambiente. Qual modelo Qnap TS é o melhor NAS server para cada ambiente? Problema estratégico A principal dificuldade ao escolher um NAS Qnap TS está em alinhar corretamente a capacidade técnica do equipamento com a carga de trabalho real. Ambientes diferentes possuem demandas distintas de desempenho, número de usuários simultâneos, volume de dados e expectativa de crescimento. Quando essa análise não é feita de forma criteriosa, surgem dois cenários igualmente problemáticos. No primeiro, o NAS é subdimensionado, gerando lentidão, gargalos e insatisfação dos usuários. No segundo, o equipamento é superdimensionado, elevando o custo sem retorno prático. Consequências da inação A escolha inadequada impacta diretamente a eficiência operacional. Um NAS com poder de processamento insuficiente compromete backups, acesso remoto e serviços simultâneos. Já um investimento excessivo em recursos que não serão utilizados consome orçamento que poderia ser direcionado a outras áreas estratégicas. Fundamentos da solução A linha Qnap TS cobre uma ampla gama de aplicações. Modelos com duas baias e conectividade 2.5GbE atendem bem ambientes domésticos e pequenos escritórios, enquanto equipamentos mais robustos, como aqueles voltados para virtualização, oferecem CPUs mais potentes, maior capacidade de memória e recursos avançados. A pergunta central que orienta a escolha é simples: qual será a função principal do NAS? A partir dessa resposta, torna-se possível definir o conjunto ideal de hardware e software. O ponto de partida: número de baias e capacidade Fundamentos técnicos O número de baias determina tanto a capacidade máxima de armazenamento quanto as opções de redundância disponíveis. Um NAS de duas baias permite arranjos simples, como RAID 1, que priorizam a proteção dos dados em detrimento da capacidade utilizável. Já modelos com quatro ou mais baias ampliam significativamente as possibilidades. Arranjos como RAID 5 ou RAID 6 equilibram desempenho, tolerância a falhas e aproveitamento de espaço, sendo mais adequados para ambientes corporativos. Escalabilidade e planejamento Além da capacidade inicial, o número de baias define o potencial de crescimento do ambiente. A possibilidade de iniciar com poucos discos e expandir conforme a demanda cresce reduz o risco de substituição prematura do equipamento. Esse planejamento é especialmente relevante em empresas, onde o crescimento do volume de dados tende a ser constante. Pensar apenas na necessidade atual quase sempre resulta em limitações futuras. Processador e memória: o motor do seu storage Base arquitetônica O processador e a memória RAM são os principais responsáveis pela capacidade do NAS de lidar com tarefas simultâneas. Em modelos Qnap TS, CPUs Intel Celeron são suficientes para compartilhamento de arquivos, backups e uso multimídia com poucos usuários. Para cargas mais exigentes, como virtualização, múltiplos serviços ativos e transcodificação de vídeo em tempo real, processadores AMD Ryzen oferecem maior capacidade de processamento e estabilidade sob carga. Impacto na experiência do usuário A memória RAM segue a mesma lógica. Ambientes com mais usuários simultâneos e aplicações ativas demandam maior quantidade de memória para evitar degradação de desempenho. A possibilidade de expansão de RAM em alguns modelos prolonga a vida útil do equipamento. Investir corretamente nesses componentes reduz gargalos futuros e garante previsibilidade operacional. Conectividade de rede para evitar gargalos Desafio de desempenho A conectividade de rede historicamente foi um dos principais limitadores de desempenho em NAS. Embora o padrão Gigabit ainda seja funcional, ele se torna rapidamente um gargalo em cenários modernos. Conexões 2.5GbE representam um avanço significativo sem exigir grandes mudanças na infraestrutura existente. Para aplicações mais intensivas, como edição de vídeo e grandes volumes de dados, o 10GbE elimina limitações de throughput. Estratégias de mitigação Modelos Qnap TS com múltiplas portas de rede permitem agregação de link, aumentando simultaneamente desempenho e redundância. Slots PCIe oferecem flexibilidade para futuras expansões conforme o ambiente evolui. NAS para uso doméstico e pequenos escritórios Cenário de aplicação Em ambientes domésticos, modelos como TS-233 e TS-464 centralizam mídias, documentos e backups. A integração com soluções como Plex Media Server transforma o NAS em um hub multimídia acessível de qualquer dispositivo. Para pequenos escritórios, esses mesmos modelos atendem bem ao compartilhamento seguro de arquivos e à criação de uma nuvem privada, reduzindo dependência de serviços externos. Proteção de dados O uso do Hybrid Backup Sync permite implementar estratégias de backup automatizadas, incluindo cópias locais e remotas. Essa abordagem reduz riscos e garante maior resiliência. Soluções para pequenas e médias empresas Requisitos críticos PMEs exigem mais do que armazenamento básico. Modelos como TS-673A e TVS-h874 oferecem recursos como snapshots, fundamentais para recuperação rápida em casos de ransomware ou exclusão acidental. O suporte a iSCSI permite que o NAS atue como storage para ambientes de virtualização, melhorando desempenho e gestão das máquinas virtuais. Governança e segurança O controle granular de permissões garante que apenas usuários autorizados acessem

Supermicro expande soluções de IA com GPUs AMD Instinct MI355X e resfriamento a ar Introdução A aceleração da inteligência artificial em ambientes corporativos deixou de ser um movimento experimental para se tornar um imperativo estratégico. Organizações que operam com grandes volumes de dados, modelos avançados de aprendizado de máquina e inferência em escala enfrentam um desafio crescente: como ampliar a capacidade computacional sem comprometer eficiência energética, confiabilidade operacional e compatibilidade com infraestruturas existentes. Nesse contexto, a Supermicro anuncia a expansão de seu portfólio de soluções de IA com a introdução de um novo servidor 10U refrigerado a ar, equipado com GPUs AMD Instinct™ MI355X. Essa abordagem responde diretamente às limitações práticas de muitos data centers corporativos, que não dispõem de infraestrutura de refrigeração líquida, mas ainda assim precisam de desempenho extremo para cargas de trabalho de IA e HPC. A inação frente a esse cenário pode resultar em ciclos de desenvolvimento mais longos, baixa eficiência computacional e dificuldades para escalar inferência e treinamento de modelos. Além disso, decisões inadequadas de infraestrutura podem gerar custos operacionais elevados e limitar a competitividade tecnológica das organizações. Este artigo analisa de forma aprofundada como a nova solução da Supermicro, baseada na arquitetura Data Center Building Block Solutions® (DCBBS) e nas GPUs AMD Instinct MI355X, endereça esses desafios, explorando fundamentos técnicos, implicações estratégicas e critérios de avaliação para ambientes corporativos e provedores de serviços. O desafio estratégico da IA em data centers corporativos Problema estratégico À medida que workloads de IA se tornam mais intensivos em dados e computação, a infraestrutura tradicional de data centers enfrenta limitações claras. A necessidade de maior largura de banda de memória, maior densidade computacional e eficiência energética entra em conflito com restrições físicas, térmicas e operacionais. Para muitas organizações, a adoção de soluções com refrigeração líquida representa uma barreira significativa, exigindo investimentos elevados, mudanças estruturais e maior complexidade operacional. Isso cria um dilema estratégico: como obter desempenho de ponta em IA sem redesenhar completamente o data center. Consequências da inação A ausência de soluções adequadas pode levar à subutilização de modelos de IA, gargalos de inferência e maior tempo de resposta para aplicações críticas. Em setores como serviços em nuvem e ambientes corporativos de grande escala, isso impacta diretamente a capacidade de inovação e o time-to-market. Além disso, sistemas menos eficientes tendem a consumir mais energia por unidade de desempenho, aumentando o custo total de propriedade (TCO) e dificultando iniciativas de sustentabilidade. Fundamentos da solução A Supermicro responde a esse cenário com um servidor 10U refrigerado a ar que integra GPUs AMD Instinct MI355X, projetadas com base na arquitetura CDNA de 4ª geração da AMD. Essa combinação permite atingir níveis elevados de desempenho sem exigir mudanças drásticas na infraestrutura térmica existente. O uso do módulo acelerador OCP (OAM), padrão da indústria, reforça a interoperabilidade e a escalabilidade, permitindo que o sistema se encaixe em arquiteturas modernas de data center. Arquitetura técnica do servidor Supermicro 10U Fundamentos arquitetônicos O servidor 10U da Supermicro foi projetado para maximizar desempenho por rack em ambientes com refrigeração a ar e líquida. Cada GPU AMD Instinct MI355X oferece 288 GB de memória HBM3e, com largura de banda de até 8 TB/s, características essenciais para workloads de IA de grande escala. O aumento do TDP de 1000 W para 1400 W por GPU reflete a capacidade do sistema de sustentar cargas computacionais mais intensas, mantendo estabilidade térmica e confiabilidade operacional. Comparação com gerações anteriores Segundo informações divulgadas, o novo sistema apresenta um aumento de até dois dígitos no desempenho em comparação com o sistema 8U MI350X refrigerado a ar. Além disso, a Supermicro indica uma melhoria de até quatro vezes na computação de IA e até 35 vezes no desempenho de inferência em relação a gerações anteriores. Esses avanços são particularmente relevantes para organizações que precisam acelerar pipelines de IA sem comprometer a previsibilidade operacional. Implementação estratégica A adoção desse servidor permite que empresas integrem desempenho avançado de IA em infraestruturas existentes. Isso reduz riscos de implantação e encurta ciclos de desenvolvimento, um fator crítico para ambientes competitivos. A arquitetura DCBBS da Supermicro facilita a rápida incorporação de novas tecnologias, permitindo ajustes modulares conforme a evolução das cargas de trabalho. Escalabilidade e eficiência energética Desempenho por rack Com a introdução do formato 10U, a Supermicro amplia as opções de densidade computacional para data centers que operam em larga escala. Isso possibilita maior desempenho por rack, um indicador crítico em ambientes onde espaço físico e consumo energético são limitados. Eficiência operacional A capacidade de operar com refrigeração a ar simplifica a gestão térmica e reduz a complexidade operacional. Para muitas organizações, essa abordagem representa um equilíbrio estratégico entre desempenho extremo e eficiência energética. Essa eficiência contribui diretamente para a redução do TCO e para iniciativas de computação verde, alinhando desempenho tecnológico a metas ambientais. Medição de sucesso A eficácia dessa implementação pode ser avaliada por métricas como desempenho de inferência, throughput de treinamento, consumo energético por workload e estabilidade operacional ao longo do tempo. Esses indicadores permitem uma análise objetiva do retorno sobre investimento e da adequação da solução às demandas do negócio. Aplicações em IA, HPC e inferência em escala Cenários de uso As soluções com GPUs AMD Instinct MI355X foram projetadas para provedores de serviços em nuvem e empresas que demandam desempenho máximo em IA e HPC. Isso inclui treinamento de modelos avançados, inferência em tempo real e processamento intensivo de dados. A compatibilidade com infraestruturas existentes amplia o leque de aplicações, reduzindo barreiras de adoção. Interoperabilidade e governança O uso de padrões da indústria, como o OAM, facilita a integração com sistemas existentes e emergentes. Isso é essencial para ambientes que exigem governança rigorosa, conformidade e previsibilidade operacional. A abordagem modular da Supermicro também simplifica atualizações futuras, protegendo o investimento ao longo do tempo. Conclusão A introdução do servidor Supermicro 10U refrigerado a ar com GPUs AMD Instinct MI355X representa um avanço estratégico para organizações que buscam desempenho extremo em IA sem a complexidade da refrigeração líquida. Ao combinar a