ASUS ESC NB8-E11: desempenho máximo com NVIDIA Blackwell para IA empresarial

Introdução

O avanço da inteligência artificial empresarial exige uma infraestrutura de computação cada vez mais especializada, capaz de lidar com modelos de larga escala, processamento paralelo e latências mínimas entre GPUs. Nesse contexto, a ASUS apresenta o ESC NB8-E11, um servidor 10U NVIDIA® Blackwell HGX™ B200 de oito GPUs, projetado para operar como o coração computacional de uma AI Factory corporativa.

O cenário atual de IA corporativa não é apenas uma corrida por poder de processamento, mas uma disputa por eficiência energética, escalabilidade e interoperabilidade entre aceleradores. A dificuldade de escalar modelos generativos ou inferências em larga escala sem gargalos de I/O e consumo extremo de energia tem levado muitas empresas a reavaliar suas arquiteturas.

O ASUS ESC NB8-E11 surge exatamente nesse ponto crítico: uma plataforma projetada para oferecer equilíbrio entre densidade de GPU, eficiência térmica e integração de rede de alta velocidade, pronta para cargas de trabalho de IA generativa, treinamento de LLMs e HPC corporativo.

Este artigo explora em profundidade o design técnico e estratégico do ESC NB8-E11, abordando desafios, fundamentos arquitetônicos, metodologias de implementação e práticas avançadas de operação em ambientes empresariais.

O Problema Estratégico: IA em Escala e o Colapso da Infraestrutura Tradicional

À medida que as empresas adotam IA generativa e modelos de linguagem de bilhões de parâmetros, os data centers convencionais enfrentam limitações estruturais. As topologias PCIe tradicionais e arquiteturas baseadas em CPU não conseguem mais fornecer a largura de banda e a conectividade necessárias entre múltiplas GPUs.

Isso resulta em ineficiências de treinamento, desperdício de energia e aumento do tempo de inferência — problemas que impactam diretamente o time-to-value dos projetos de IA. Além disso, o crescimento exponencial dos conjuntos de dados torna o trânsito interno entre GPUs um gargalo crítico.

Nesse cenário, empresas que não investem em infraestruturas otimizadas para IA enfrentam riscos competitivos significativos: lentidão em desenvolvimento de modelos, custos de energia insustentáveis e incapacidade de integrar pipelines de IA em escala corporativa.

Consequências da Inação: Custo Competitivo e Risco Tecnológico

Ignorar a evolução da infraestrutura de IA pode levar a um colapso operacional. Organizações que mantêm sistemas baseados em GPU convencionais, sem interconexão dedicada ou resfriamento otimizado, enfrentam:

Consumo energético desproporcional, com custos de TCO (Total Cost of Ownership) elevados.

Bottlenecks entre GPUs, limitando o throughput de dados.

Baixa eficiência térmica, exigindo sistemas de refrigeração mais caros e menos sustentáveis.

Obsolescência tecnológica acelerada, especialmente diante da rápida evolução das arquiteturas NVIDIA Blackwell e Intel Xeon 5ª geração.

O resultado é uma infraestrutura incapaz de sustentar treinamento contínuo de modelos de IA, comprometendo tanto a inovação quanto a rentabilidade.

Fundamentos da Solução: Arquitetura NVIDIA Blackwell e Intel Xeon 5ª Geração

Integração Total com NVIDIA HGX B200

O ESC NB8-E11 utiliza o módulo NVIDIA HGX™ B200, um design de referência para servidores de oito GPUs Blackwell interligadas via NVLink™, oferecendo 1.800 GB/s de largura de banda direta GPU-to-GPU. Essa interconectividade elimina o gargalo de comunicação típico em ambientes PCIe puros, permitindo escalabilidade quase linear em cargas de IA distribuída.

Cada GPU Blackwell é capaz de processar modelos de múltiplos trilhões de parâmetros, combinando eficiência energética superior e aceleração nativa para operações FP8 e FP16 — essenciais em treinamento de IA generativa e simulações científicas.

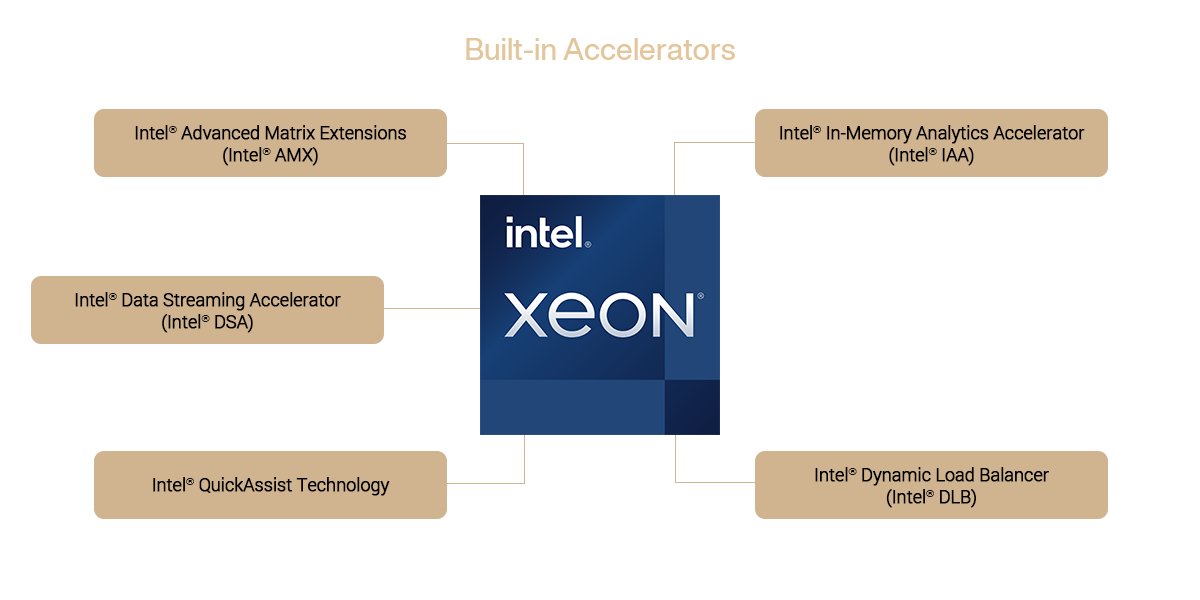

Potência de Processamento com Intel Xeon 5ª Geração

Com duas CPUs Intel® Xeon® Scalable de 5ª geração (até 350W cada), o ESC NB8-E11 proporciona alto throughput de dados e suporte a DDR5 5600 MHz em 32 slots DIMM — até 8 canais por CPU. Essa arquitetura entrega até 8 TB de memória total, reduzindo latências em inferência e treinamento local.

Além disso, o suporte à 5ª geração de barramento PCIe Gen5 multiplica a largura de banda disponível para NICs, DPUs e controladoras NVMe, assegurando máxima sinergia entre CPU e GPU.

Topologia Um-para-Um GPU–NIC

Diferente de implementações tradicionais, o ASUS ESC NB8-E11 adota uma topologia 1 GPU : 1 NIC, com suporte a até oito interfaces de rede dedicadas. Essa arquitetura garante máximo throughput e baixa latência em workloads distribuídas, essenciais em treinamentos de IA em múltiplos nós.

Implementação Estratégica: Design, Energia e Escalabilidade

Eficiência Térmica Avançada com Engenharia de Fluxo de Ar Dedicado

O ESC NB8-E11 apresenta um sistema térmico otimizado, com túneis de fluxo de ar independentes para CPUs e GPUs, assegurando refrigeração eficiente em configurações de alta densidade. Esse design maximiza a confiabilidade do sistema mesmo em ambientes de alta carga contínua.

A estrutura 10U possibilita manutenção simplificada e integração em racks padrão de data centers empresariais, sem necessidade de soluções líquidas complexas.

Energia com Redundância e Eficiência 80 PLUS Titanium

Equipado com seis fontes redundantes (5+1) de 3000W cada, o sistema atinge o nível 80 PLUS® Titanium, o padrão mais alto de eficiência energética do setor. Essa certificação assegura redução significativa no desperdício de energia e maior confiabilidade operacional, reduzindo o risco de downtime em operações críticas de IA.

Capacidade de Expansão e Interoperabilidade

O servidor oferece até 11 slots PCIe, incluindo 10 PCIe Gen5 x16 e 1 Gen4 x8, garantindo compatibilidade com DPUs NVIDIA BlueField-3, controladoras RAID, adaptadores de rede de baixa latência e placas de expansão NVMe.

Esse nível de flexibilidade permite às empresas configurar topologias específicas de interconexão e armazenamento, otimizadas conforme o tipo de workload — seja treinamento, inferência, ou HPC híbrido.

Melhores Práticas Avançadas: Operação e Otimização

Gerenciamento Unificado com ASUS Control Center

O ESC NB8-E11 integra o ASUS Control Center (ACC) e o módulo ASMB11-iKVM, permitindo gerenciamento remoto de todo o sistema com monitoramento em tempo real de consumo, temperatura, falhas e estado das GPUs.

Essa visibilidade granular permite mitigar falhas antes que se tornem incidentes críticos, além de otimizar o balanceamento de carga térmica e energética em clusters de IA.

Integração com NVIDIA AI Enterprise e BlueField DPUs

A compatibilidade nativa com o NVIDIA AI Enterprise Stack e a capacidade de incluir DPUs BlueField-3 criam uma plataforma ideal para AI Factories — ambientes empresariais que integram computação, rede e armazenamento em uma única malha otimizada.

Essa arquitetura reduz a complexidade da implantação e melhora o isolamento de carga, tornando o ESC NB8-E11 apto a operar tanto em nuvens privadas quanto em infraestruturas híbridas corporativas.

Conformidade e Governança

O produto é certificado para FCC e Industry Canada, garantindo conformidade regulatória e segurança elétrica. Isso o torna viável para operações corporativas regulamentadas, como finanças, governo e saúde, que exigem certificações internacionais para implantação de IA crítica.

Medição de Sucesso: Indicadores de Performance e Eficiência

Para avaliar o sucesso da implementação do ASUS ESC NB8-E11, as organizações devem acompanhar:

Throughput de Treinamento (TFLOPs sustentados) por watt e por GPU.

Eficiência térmica (°C/W) em cargas contínuas.

Uptime e MTBF (Mean Time Between Failures) em operações críticas.

Escalabilidade horizontal entre múltiplos nós via NVLink e NICs dedicadas.

Custo total de propriedade (TCO) versus desempenho entregue por nó.

Empresas que adotam essas métricas constatam reduções expressivas em tempo de treinamento de modelos e custos de energia por inferência, obtendo vantagem competitiva real em suas operações de IA.

Conclusão

O ASUS ESC NB8-E11 representa o estado da arte em servidores de IA corporativa, unindo a potência da arquitetura NVIDIA Blackwell HGX B200 à robustez dos processadores Intel Xeon 5ª Geração.

Sua combinação de eficiência térmica, arquitetura GPU-to-GPU NVLink de 1.800 GB/s, e topologia de rede dedicada o posiciona como elemento central na transformação de data centers em AI Factories completas.

Empresas que investem nessa classe de servidor não estão apenas adquirindo desempenho, mas construindo a base para uma infraestrutura de IA sustentável, escalável e pronta para o futuro.

O futuro da inteligência artificial corporativa não dependerá apenas de algoritmos mais sofisticados, mas da capacidade das organizações de implementar plataformas como o ESC NB8-E11, que alinham potência computacional, eficiência energética e governança tecnológica em um único ecossistema.