Introdução: a nova geração de servidores GPU para IA empresarial

Com o avanço da inteligência artificial generativa, do aprendizado profundo e das simulações de alto desempenho (HPC), o papel dos servidores GPU de nova geração tornou-se estratégico. O ASUS ESC8000-E12P representa a síntese entre densidade computacional extrema e arquitetura aberta, combinando processadores Intel Xeon 6 com a plataforma NVIDIA MGX — um padrão projetado para acelerar o desenvolvimento e a padronização de servidores voltados para IA e nuvem de larga escala.

No cenário corporativo atual, empresas enfrentam o desafio de equilibrar desempenho, eficiência e escalabilidade em suas infraestruturas de IA. Soluções proprietárias, embora poderosas, limitam a flexibilidade. É nesse contexto que a ASUS se destaca com o ESC8000-E12P, oferecendo uma arquitetura aberta, modular e totalmente compatível com as GPUs mais avançadas do mercado — de NVIDIA H200 e RTX PRO 6000 Blackwell até o Intel Gaudi 3 PCIe AI Accelerator.

Ignorar a evolução dessa categoria de servidores significa perder competitividade em um mercado onde o tempo de treinamento e a eficiência energética definem margens e diferenciais estratégicos. O ESC8000-E12P surge como uma plataforma de referência para empresas que buscam consolidar suas operações de IA e HPC com previsibilidade, segurança e compatibilidade futura.

Este artigo aprofunda os fundamentos técnicos e estratégicos dessa solução, detalhando sua arquitetura MGX, seus diferenciais em conectividade PCIe Gen5, a integração com Intel Xeon 6 e as implicações práticas para data centers empresariais.

O problema estratégico: escalar IA e HPC com flexibilidade e padronização

A evolução das cargas de trabalho de IA trouxe um novo paradigma: o modelo de hardware precisa acompanhar ciclos de inovação cada vez mais curtos. Modelos generativos, simulações físicas e inferências multimodais exigem infraestrutura escalável, de alta largura de banda e com densidade térmica controlada.

Empresas que ainda dependem de servidores GPU de gerações anteriores enfrentam gargalos sérios — desde limitações de barramento PCIe até ineficiências térmicas que restringem o uso simultâneo de GPUs de alto TDP. Além disso, a falta de compatibilidade entre plataformas de hardware e frameworks de IA reduz a agilidade no deployment de novos modelos.

O desafio é duplo: manter compatibilidade com diferentes aceleradores (NVIDIA, Intel, AMD) e, ao mesmo tempo, sustentar padrões de desempenho e confiabilidade corporativos. É aqui que o conceito de NVIDIA MGX se torna decisivo, e o ESC8000-E12P se posiciona como uma resposta técnica e estratégica a esse impasse.

Consequências da inação: risco operacional e obsolescência acelerada

Ignorar a necessidade de atualizar infraestruturas GPU em tempos de IA generativa é uma forma de obsolescência antecipada. Organizações que continuam operando em arquiteturas anteriores à geração PCIe 5.0 enfrentam taxas de transferência inferiores, latências elevadas e limitações na comunicação GPU-GPU — o que se traduz diretamente em custos maiores por ciclo de treinamento.

Além disso, a ausência de compatibilidade com arquiteturas MGX implica em dependência de soluções proprietárias, dificultando upgrades graduais e forçando substituições completas de chassis. Isso eleva o TCO (Total Cost of Ownership) e compromete a flexibilidade de roadmap tecnológico da empresa.

Do ponto de vista energético, servidores não otimizados para GPUs de até 600 watts também sofrem penalidades térmicas e de eficiência, afetando tanto a estabilidade quanto a vida útil do equipamento. O resultado é um ciclo vicioso de manutenção, ineficiência e custo de oportunidade perdido.

Fundamentos técnicos: arquitetura MGX e Intel Xeon 6

Compatibilidade total com NVIDIA MGX

A arquitetura MGX é o pilar técnico do ESC8000-E12P. Ela define um padrão modular e escalável para servidores de IA, permitindo que fabricantes como a ASUS integrem GPUs, DPUs e processadores de múltiplos fornecedores com interoperabilidade total. Isso significa que o mesmo chassi pode acomodar tanto GPUs NVIDIA H200 quanto aceleradores Intel Gaudi 3 — um avanço em flexibilidade sem precedentes.

Processadores Intel Xeon 6: equilíbrio entre densidade e eficiência

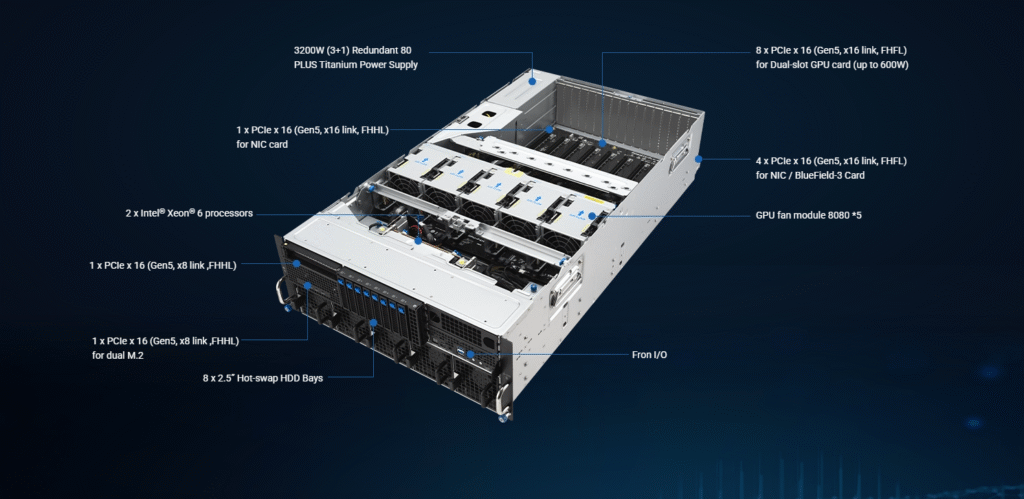

Equipado com dois processadores Intel Xeon 6, o ESC8000-E12P oferece até 86 núcleos por CPU e suporte para memória DDR5 de 6400 MHz, em oito canais, com TDP de até 350 watts por soquete. Essa configuração permite entregar throughput extremo em pipelines de inferência e simulação, com ganho significativo em eficiência energética por watt.

Infraestrutura PCIe 5.0 de alta largura de banda

Com cinco slots PCIe 5.0 adicionais, o servidor suporta NICs de alta velocidade, DPUs e interconexões para escalar clusters GPU de forma linear. Essa flexibilidade é essencial para ambientes que demandam topologias complexas, como redes InfiniBand e malhas NVLink interligadas, otimizando o desempenho em workloads distribuídas.

Implementação estratégica: eficiência e escalabilidade no data center

A implementação do ASUS ESC8000-E12P em um ambiente corporativo exige considerar tanto aspectos físicos (energia, refrigeração, espaço) quanto lógicos (orquestração, segurança e manutenção). A ASUS simplifica esse processo com um design toolless que facilita o acesso a componentes internos e acelera manutenções, reduzindo significativamente o tempo de parada operacional.

Em termos de gerenciamento, o servidor é integrado ao ASUS Control Center, uma solução de administração unificada que permite monitorar consumo energético, temperaturas, alertas e status de GPUs e DIMMs. Essa integração de hardware e software cria uma camada de governança técnica essencial para ambientes de missão crítica.

O uso de soluções de gerenciamento com Root-of-Trust em nível de hardware adiciona uma camada adicional de segurança, protegendo a integridade do firmware e garantindo conformidade com políticas de segurança corporativas e regulamentações de data centers sensíveis.

Melhores práticas avançadas e otimizações

Gerenciamento térmico para GPUs de 600 W

O ESC8000-E12P foi projetado para suportar até oito GPUs de 600 watts, o que exige um sistema térmico de alto desempenho. A ASUS emprega engenharia de fluxo de ar otimizada e sensores térmicos distribuídos para garantir a estabilidade mesmo sob carga máxima — um fator crítico para clusters de IA contínuos.

Escalabilidade horizontal com interconexões PCIe

A presença de cinco slots PCIe 5.0 adicionais possibilita a expansão de rede com adaptadores InfiniBand e DPUs de última geração. Essa capacidade é vital para ambientes que pretendem crescer em topologias em malha (mesh) ou fat-tree, otimizando a comunicação GPU-GPU entre múltiplos nós.

Gerenciamento inteligente via ASUS Control Center

O ASUS Control Center oferece visibilidade granular sobre desempenho e integridade dos componentes. Além de monitoramento remoto, ele permite atualizações de firmware automatizadas, políticas de segurança centralizadas e integração com sistemas de gestão de TI corporativos, ampliando o controle operacional e reduzindo riscos de downtime não planejado.

Medição de sucesso: métricas de desempenho e confiabilidade

A avaliação da eficácia do ESC8000-E12P em ambientes de IA deve considerar métricas multidimensionais. Entre elas, o throughput GPU agregado, a eficiência energética por watt, o tempo de inferência por lote e o MTBF (Mean Time Between Failures) do sistema.

Empresas que adotam essa arquitetura observam ganhos diretos em velocidade de treinamento, redução de latência em inferência e menor consumo energético por modelo treinado. A confiabilidade da arquitetura MGX e do sistema de refrigeração da ASUS garante operação contínua sob carga intensiva, sem throttling térmico.

Além disso, o uso de padrões abertos e compatibilidade cruzada com aceleradores de múltiplos fabricantes assegura longevidade tecnológica — um diferencial crítico quando o ciclo de vida dos modelos de IA é mais curto que o da infraestrutura física.

Conclusão: convergência entre padronização e desempenho extremo

O ASUS ESC8000-E12P consolida uma nova era na infraestrutura corporativa de IA e HPC, combinando padronização arquitetônica (NVIDIA MGX), potência de processamento (Intel Xeon 6) e escalabilidade modular (PCIe 5.0). Essa convergência redefine o que significa construir data centers prontos para o futuro da IA generativa.

Mais do que um servidor de alto desempenho, o ESC8000-E12P representa uma estratégia de continuidade tecnológica: permite evolução incremental, interoperabilidade entre fabricantes e adoção rápida de novas gerações de GPUs sem reengenharia completa da infraestrutura.

Em um cenário de transformação acelerada, investir em plataformas abertas, escaláveis e seguras não é apenas uma escolha técnica — é uma decisão estratégica que define a capacidade de competir e inovar. O ASUS ESC8000-E12P é o exemplo mais avançado dessa filosofia aplicada à realidade corporativa de IA.