2U NVIDIA Grace Superchip: Desempenho Extremo para HPC e IA Empresarial

Em um cenário empresarial marcado por demandas exponenciais de processamento, análise de dados e inteligência artificial, a escolha de infraestrutura computacional torna-se decisiva. O sistema 2U NVIDIA Grace Superchip emerge como uma solução de ponta, integrando CPUs Grace altamente eficientes e GPUs NVIDIA de última geração para atender workloads complexos em HPC, AI, treinamento de modelos de linguagem (LLM) e processamento de dados de alto desempenho.

Introdução

Contextualização Estratégica

Organizações modernas enfrentam um crescimento acelerado de dados e necessidades de processamento paralelo. O gerenciamento eficiente desses recursos é essencial para competitividade. Sistemas convencionais muitas vezes apresentam gargalos em memória, interconectividade CPU-GPU e consumo energético. O 2U NVIDIA Grace Superchip aborda essas limitações, oferecendo uma arquitetura densa e otimizada para máxima eficiência de throughput e latência mínima.

Desafios Críticos

Os desafios incluem a execução de modelos de IA de larga escala, simulações científicas e workloads analíticos intensivos. Sistemas com CPUs tradicionais podem limitar o desempenho devido à largura de banda de memória restrita e baixa densidade de núcleos. Além disso, a interconectividade GPU-GPU e CPU-GPU é fundamental para acelerar cargas distribuídas, especialmente em ambientes que dependem de treinamentos de deep learning e inferência em tempo real.

Custos e Riscos da Inação

Ignorar a necessidade de infraestrutura otimizada pode resultar em atrasos críticos na entrega de projetos, aumento do custo total de propriedade e vulnerabilidades operacionais. A incapacidade de processar grandes volumes de dados com eficiência reduz a competitividade e compromete decisões estratégicas baseadas em insights analíticos. Sistemas subdimensionados podem levar a falhas em simulações complexas, degradação de performance de IA e restrições no desenvolvimento de LLMs.

Visão Geral do Artigo

Este artigo detalha os fundamentos técnicos do 2U NVIDIA Grace Superchip, suas vantagens estratégicas, considerações de implementação, práticas recomendadas, métricas de sucesso e implicações de negócios, fornecendo uma análise aprofundada para gestores de TI e engenheiros de infraestrutura.

Desenvolvimento

Problema Estratégico

Empresas que dependem de computação intensiva enfrentam limitações significativas em termos de densidade de processamento, consumo energético e escalabilidade. Sistemas tradicionais não oferecem largura de banda suficiente entre CPU e GPU, nem suporte a memória de alta velocidade para workloads críticos. Isso impacta diretamente prazos de entrega, capacidade de análise e competitividade em setores que demandam inovação rápida, como AI, análise de dados e modelagem científica.

Consequências da Inação

Manter infraestruturas desatualizadas aumenta o risco de gargalos computacionais, falhas de processamento e atrasos em projetos de AI e HPC. A falta de memória rápida e de interconexão PCIe de última geração reduz eficiência energética e aumenta custos operacionais. Organizações podem experimentar atrasos no treinamento de LLMs, lentidão em simulações HPC e limitação de análise em tempo real, resultando em perda de oportunidades estratégicas.

Fundamentos da Solução

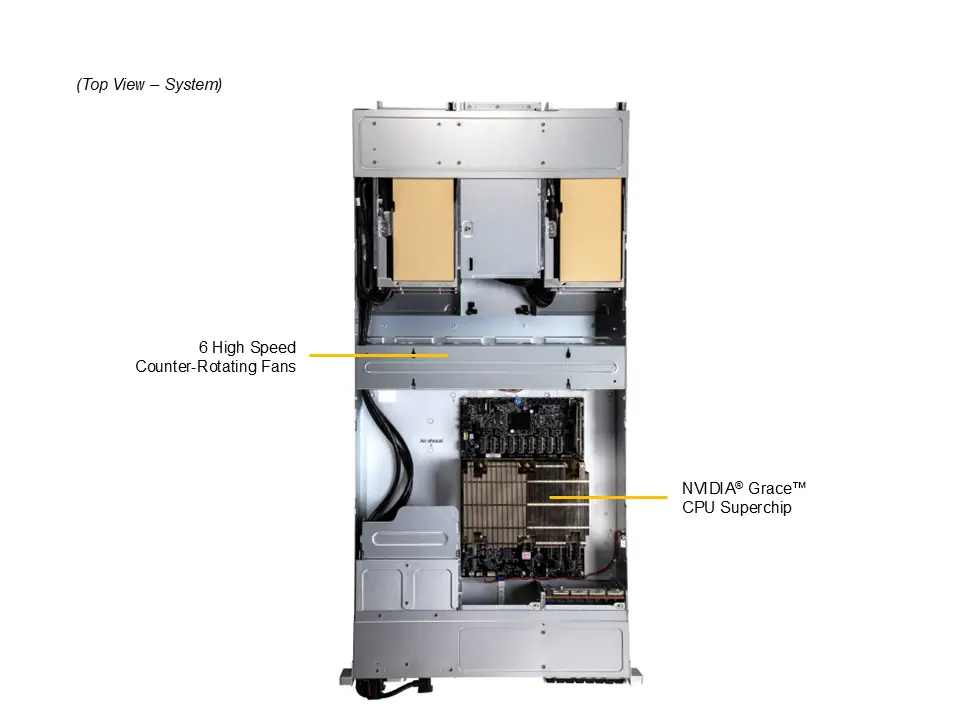

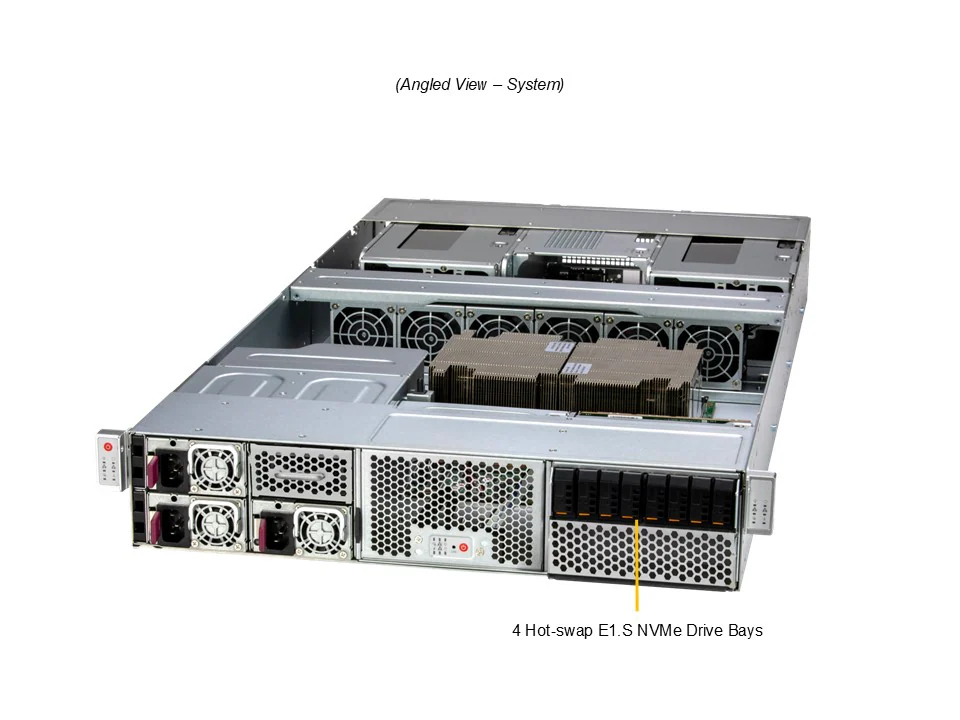

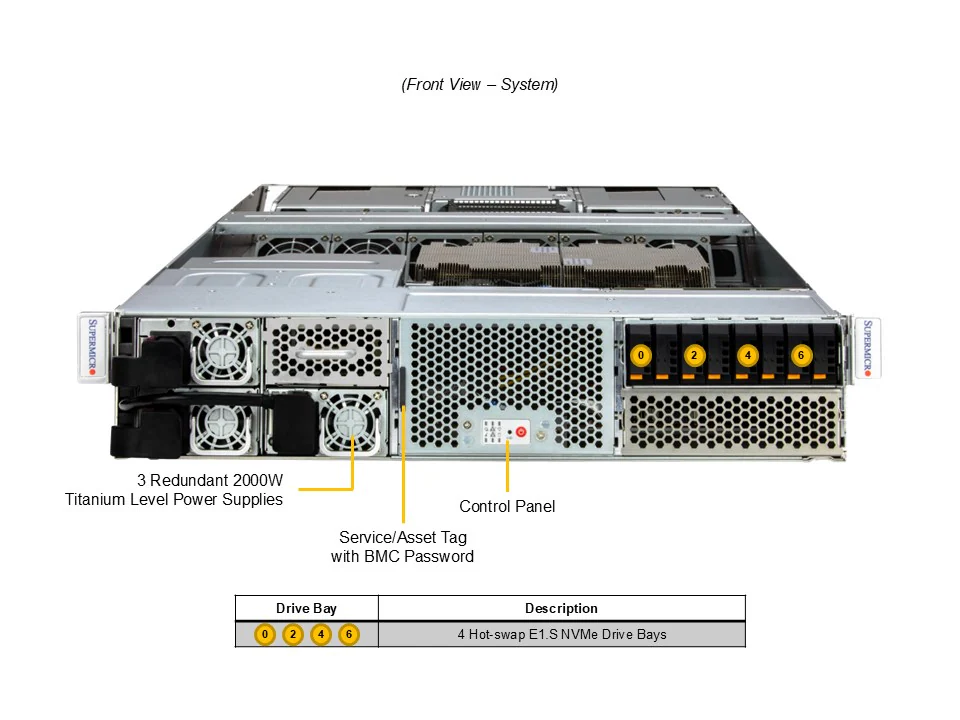

O 2U NVIDIA Grace Superchip integra CPU Grace de 144 núcleos com até 960GB de memória ECC LPDDR5X, garantindo baixa latência e alto desempenho por watt. Suporta até 2 GPUs NVIDIA H100 NVL ou L40S conectadas via PCIe 5.0 x16, permitindo interconectividade de alta velocidade entre CPU e GPU, bem como comunicação eficiente GPU-GPU. O sistema possui 4 bays NVMe E1.S hot-swap e slots M.2 PCIe 5.0 x4, oferecendo armazenamento ultra-rápido para workloads exigentes.

A arquitetura 2U permite densidade elevada sem comprometer resfriamento ou redundância. Com até 3 fontes de 2000W Titanium Level (96% de eficiência), o sistema mantém confiabilidade energética e operação contínua em ambientes críticos. O design modular facilita upgrades de memória e GPUs, garantindo escalabilidade para atender demandas futuras.

Implementação Estratégica

A implementação requer alinhamento com objetivos de performance e eficiência energética. A seleção de GPUs (H100 NVL vs L40S) deve considerar workloads específicos de AI ou HPC. O gerenciamento do sistema pode ser realizado via IPMI 2.0, Redfish API ou Supermicro Update Manager, garantindo monitoramento detalhado de CPU, memória, temperatura e ventilação.

Para integração eficiente, recomenda-se planejamento de conectividade PCIe e NVMe, além de testes de resfriamento para workloads máximos. Considerações de segurança incluem uso de TPM onboard, monitoramento contínuo via KVM-over-LAN e políticas de governança para manutenção de firmware atualizado e compliance.

Melhores Práticas Avançadas

Otimizações avançadas incluem balanceamento de workloads entre CPUs Grace e GPUs, priorização de memória ECC LPDDR5X para tarefas críticas e utilização de slots M.2 para cache de alta velocidade. Configurações de resfriamento devem ser ajustadas dinamicamente via controle de fan PWM, evitando hotspots e mantendo eficiência energética máxima.

Para workloads de IA distribuída, a configuração PCIe e interconectividade GPU-GPU são cruciais. Técnicas de particionamento de memória e pipelines paralelos aumentam throughput sem comprometer integridade de dados. Ferramentas de monitoramento e alerta antecipado minimizam riscos de falha em produção.

Medição de Sucesso

Indicadores incluem desempenho por watt, latência de memória, throughput PCIe, tempo de treinamento de LLMs e eficiência de resfriamento. Métricas de confiabilidade abrangem uptime do sistema, falhas de ventiladores, consistência de temperatura e integridade de memória ECC. Avaliações periódicas permitem ajustes finos, garantindo alinhamento contínuo entre performance técnica e metas de negócio.

Conclusão

Resumo dos Pontos Principais

O 2U NVIDIA Grace Superchip representa uma solução robusta para empresas que demandam HPC e AI de alta performance. Combina CPU Grace de 144 núcleos, memória ECC LPDDR5X de até 960GB, GPUs NVIDIA de ponta e armazenamento NVMe ultra-rápido, garantindo densidade, eficiência energética e escalabilidade.

Considerações Finais

Investir em infraestrutura de ponta reduz riscos de falhas, aumenta competitividade e permite exploração de workloads complexos, desde simulações HPC até treinamento de modelos de AI. A implementação estratégica, monitoramento contínuo e práticas avançadas de otimização são essenciais para extrair máximo valor do investimento.

Perspectivas Futuras

Com a evolução de LLMs e workloads distribuídos, a demanda por sistemas densos, eficientes e altamente interconectados continuará crescendo. O 2U NVIDIA Grace Superchip posiciona empresas para adoção de tecnologias emergentes, mantendo performance e eficiência energética.

Próximos Passos Práticos

Organizações devem realizar auditoria de workloads atuais, identificar gargalos em CPU-GPU e memória, planejar upgrades moduláveis e implementar monitoramento avançado para assegurar que o sistema opere com performance ideal. Considerar integração com soluções de AI e HPC distribuídas maximiza retorno sobre investimento.