1U 2-Node NVIDIA GH200 Grace Hopper Superchip: Performance AI e HPC Avançada

No cenário empresarial atual, a demanda por processamento de alto desempenho para Inteligência Artificial (AI), Machine Learning e Large Language Models (LLMs) cresce de forma exponencial. Organizações que não adotam sistemas otimizados para HPC (High Performance Computing) enfrentam limitações críticas de capacidade, escalabilidade e eficiência, impactando diretamente sua competitividade e tempo de entrega de insights estratégicos.

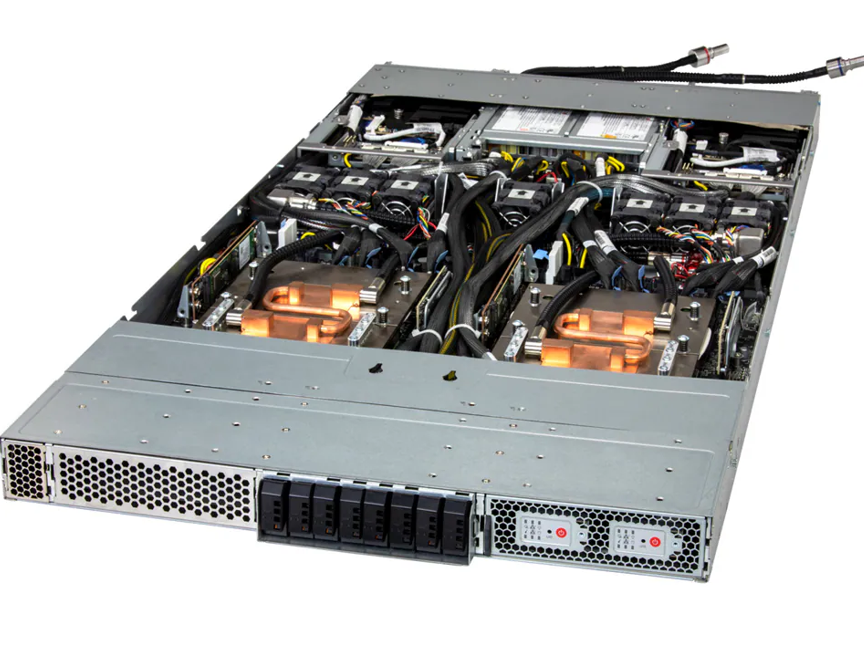

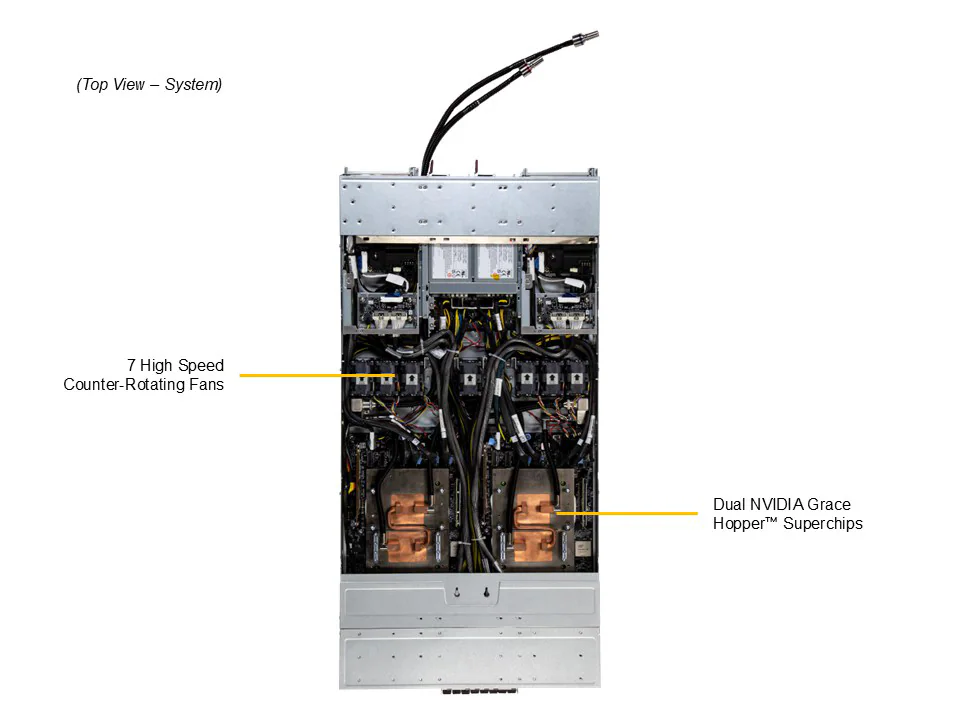

O 1U 2-Node NVIDIA GH200 Grace Hopper Superchip surge como uma solução de vanguarda, oferecendo integração de CPU Grace e GPU H100, além de suporte para armazenamento E1.S de alta velocidade. Sua arquitetura compacta e líquida refrigerada permite densidade máxima sem comprometer performance ou confiabilidade.

Este artigo explora profundamente os aspectos técnicos, estratégicos e operacionais do sistema, detalhando como ele resolve desafios críticos de infraestrutura, otimiza workloads de AI e HPC, e oferece retorno mensurável para empresas que dependem de alto desempenho computacional.

Desafio Estratégico em HPC e AI

Limitações de Infraestrutura Tradicional

Servidores tradicionais de rack não conseguem sustentar workloads intensivos de AI e LLM devido à limitação de memória, largura de banda e densidade de GPU. A falta de integração estreita entre CPU e GPU aumenta a latência e reduz o throughput, impactando diretamente o desempenho de treinamento de modelos complexos e inferência em tempo real.

Implicações para Negócios

Organizações que não atualizam sua infraestrutura enfrentam aumento de custos operacionais, menor velocidade de inovação e risco de ficar atrás da concorrência em mercados que dependem de insights baseados em AI.

Fundamentos da Solução: Arquitetura 1U 2-Node NVIDIA GH200

Integração Grace CPU + H100 GPU

Cada nó do sistema conta com o Grace Hopper Superchip da NVIDIA, integrando CPU de 72 núcleos e GPU H100. Essa integração reduz latência de comunicação, melhora throughput em workloads HPC e AI, e possibilita execução simultânea de múltiplos pipelines de processamento sem comprometimento de performance.

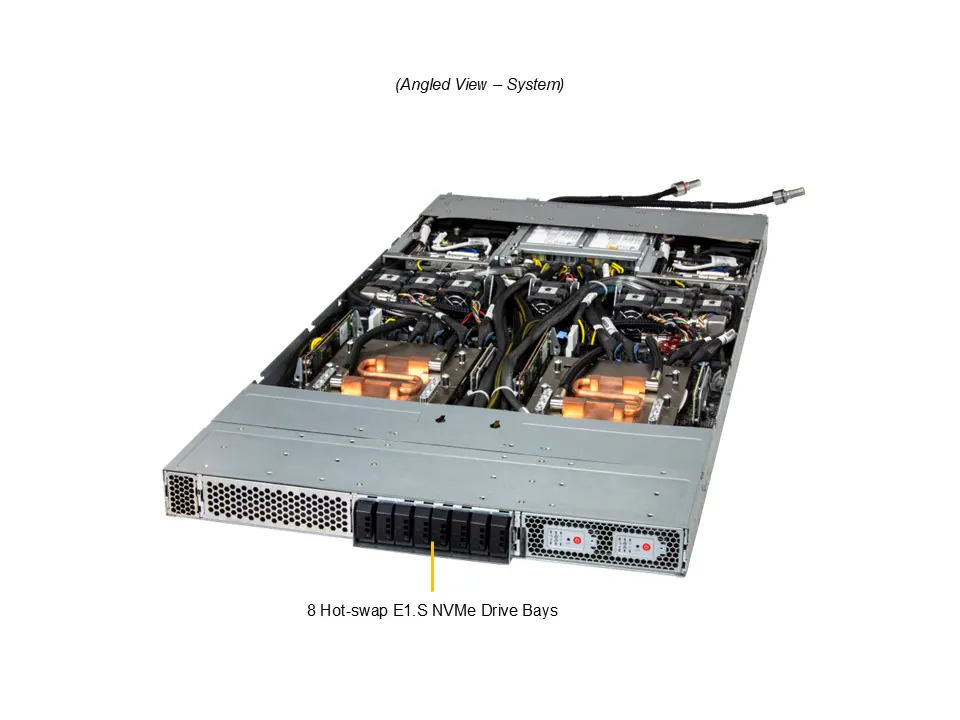

Memória e Armazenamento de Alta Performance

O sistema suporta até 480GB de ECC LPDDR5X por nó, com GPU adicional de até 96GB ECC HBM3. O armazenamento E1.S NVMe em hot-swap oferece IOPS extremamente altos, essencial para treinamento de modelos de AI que manipulam grandes volumes de dados. Esta configuração reduz gargalos de I/O e melhora a eficiência energética, conectando diretamente performance técnica com redução de custos operacionais.

Design Compacto e Refrigerado a Líquido

O 1U 2-Node permite densidade sem comprometer o resfriamento. O sistema líquido refrigerado D2C (Direct to Chip) mantém TDPs de até 2000W por CPU, garantindo operação estável em workloads críticos. Além disso, o monitoramento de CPU, memória, ventoinhas e temperatura oferece governança e compliance operacional em data centers exigentes.

Implementação Estratégica

Considerações de Integração

O sistema é altamente compatível com infraestruturas existentes em data centers, oferecendo slots PCIe 5.0 x16 para expansão adicional e conectividade com NVIDIA BlueField-3 ou ConnectX-7. Isso permite integração com redes de alta velocidade e soluções de armazenamento distribuído, mantendo interoperabilidade e escalabilidade.

Gerenciamento e Monitoramento

O BIOS AMI de 64MB e ferramentas de gerenciamento avançadas permitem configuração detalhada de ACPI, monitoramento de saúde do sistema e controle de ventoinhas via PWM, garantindo que cada componente opere dentro de parâmetros ideais. Essa abordagem reduz riscos operacionais e aumenta a confiabilidade.

Melhores Práticas Avançadas

Otimização de Workloads AI

Para maximizar performance em treinamento de modelos, recomenda-se balancear cargas entre CPU e GPU, monitorar consumo de memória HBM3, e ajustar configuração de armazenamento E1.S NVMe para otimizar throughput. Estratégias de cooling e gerenciamento de energia devem ser implementadas para prevenir throttling em picos de demanda.

Segurança e Governança

O sistema permite segmentação de rede via BlueField-3, proporcionando isolamento de workloads críticos. Além disso, a redundância de fontes de 2700W Titanium garante continuidade operacional e segurança contra falhas elétricas, atendendo requisitos de compliance de data centers corporativos.

Medição de Sucesso

Métricas de Performance

Indicadores-chave incluem throughput de treinamento de modelos AI, latência de inferência, utilização de memória LPDDR5X e HBM3, IOPS de armazenamento E1.S, e eficiência energética medida por performance por Watt. Monitoramento contínuo permite ajustes proativos e melhoria contínua.

ROI e Impacto no Negócio

Empresas que implementam o 1U 2-Node NVIDIA GH200 experimentam redução de tempo de treinamento de modelos, aceleração de pipelines de AI, maior densidade computacional e menor custo total de operação por unidade de processamento, conectando diretamente tecnologia a vantagem competitiva estratégica.

Conclusão

O 1U 2-Node NVIDIA GH200 Grace Hopper Superchip representa um avanço significativo para empresas que buscam alto desempenho em AI, Deep Learning e HPC. Sua arquitetura integrada, resfriamento líquido e suporte de memória/armazenamento de última geração resolvem desafios críticos de infraestrutura e performance.

Ao adotar esta solução, organizações aumentam sua capacidade de inovação, reduzem riscos de operação e garantem competitividade em setores que dependem de processamento intensivo de dados. A implementação estratégica do sistema permite extração máxima de valor de cada componente, conectando performance técnica a resultados tangíveis de negócio.

Com a evolução contínua de AI e HPC, o 1U 2-Node NVIDIA GH200 está posicionado como plataforma futura-proof, capaz de suportar demandas emergentes e expandir conforme necessidades corporativas crescem.