Introdução: infraestrutura líquida para cargas computacionais extremas

Em um cenário em que modelos de linguagem de grande porte (LLMs), simulações científicas e inteligência artificial generativa demandam densidade computacional inédita, a infraestrutura passa a ser um diferencial competitivo. O DP Intel 4U Liquid-Cooled System com NVIDIA HGX H100/H200 8-GPU da Supermicro representa o ápice dessa nova geração de servidores de alta performance, combinando refrigeração líquida direta ao chip, interconexão NVLink e suporte a processadores Intel Xeon escaláveis de 5ª geração.

Empresas que buscam executar workloads de IA de larga escala enfrentam desafios relacionados à dissipação térmica, latência entre GPUs e eficiência energética. O design 4U da Supermicro foi concebido especificamente para resolver esses pontos críticos, integrando hardware, arquitetura e gerenciamento em um único ecossistema certificado pela NVIDIA e inspirado em padrões OCP.

Ignorar a necessidade de infraestrutura térmica e elétrica adequada para cargas intensivas pode comprometer não apenas o desempenho, mas também a integridade operacional de todo o data center. Este artigo analisa em profundidade os fundamentos técnicos, estratégias de implementação e implicações empresariais deste sistema, revelando por que ele se tornou uma escolha estratégica para IA, HPC e pesquisa científica de ponta.

O problema estratégico: densidade computacional versus eficiência térmica

Com o avanço dos modelos de IA e simulações numéricas complexas, as organizações se deparam com um dilema estrutural: como acomodar centenas de teraflops em um espaço físico limitado, sem que o consumo de energia e a temperatura se tornem insustentáveis. O servidor 4U Supermicro responde diretamente a esse dilema ao introduzir refrigeração líquida de circuito direto (D2C), eliminando gargalos térmicos que inviabilizam o uso contínuo de GPUs de última geração.

Enquanto soluções tradicionais com refrigeração a ar exigem restrições de TDP e limites de frequência, o modelo Supermicro suporta CPUs de até 385W TDP e GPUs NVIDIA H100 ou H200 operando em plena capacidade, mantendo estabilidade sob cargas contínuas. Essa abordagem permite consolidar desempenho equivalente a múltiplos racks em uma única unidade 4U, reduzindo o custo por watt e otimizando o uso do espaço físico.

Consequências da inação: os riscos de ignorar o fator térmico

Ignorar a integração entre densidade computacional e dissipação térmica pode acarretar impactos diretos na competitividade. Sobrecarga térmica reduz o tempo médio entre falhas (MTBF), acelera o desgaste de componentes e obriga o uso de underclocking forçado, comprometendo o retorno sobre investimento em GPUs de alto valor.

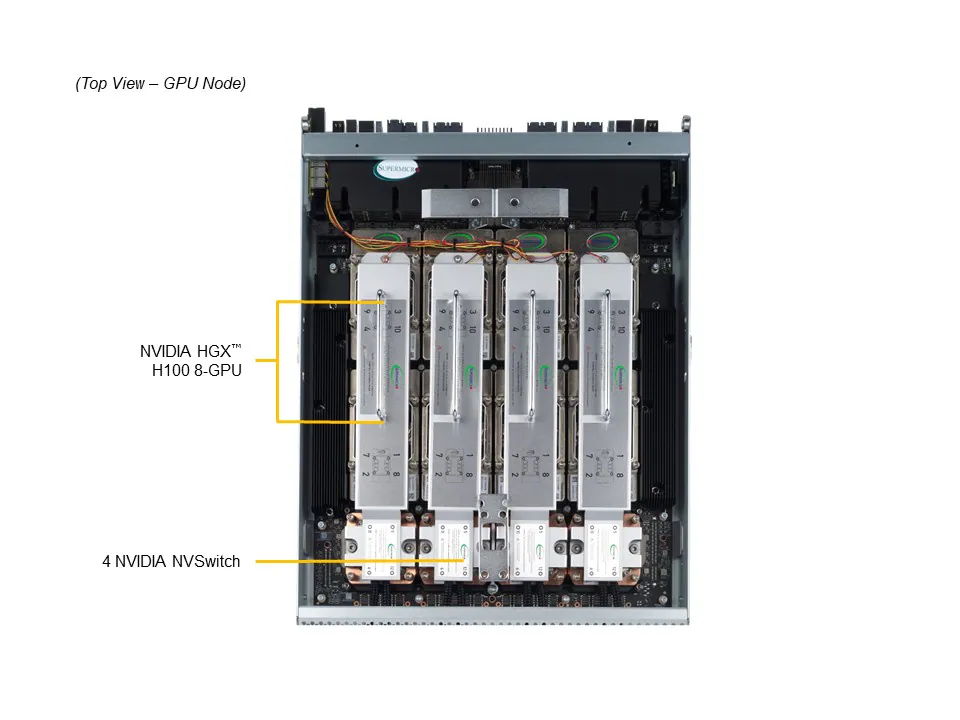

Além disso, a ausência de infraestrutura líquida compatível limita a adoção de GPUs topo de linha como as NVIDIA HGX H200, que operam com até 141 GB de memória HBM3e e interconexão NVSwitch. O custo oculto dessa limitação é o aumento do tempo de treinamento e a redução da eficiência energética por operação, fatores que impactam diretamente o custo por modelo de IA treinado.

Empresas que adiam a adoção de sistemas com refrigeração líquida acabam, inevitavelmente, deslocadas de ambientes de HPC e IA de próxima geração — um espaço dominado por infraestruturas certificadas e termicamente otimizadas, como o SuperServer SYS-421GE-TNHR2-LCC.

Fundamentos da solução: arquitetura integrada de alta densidade

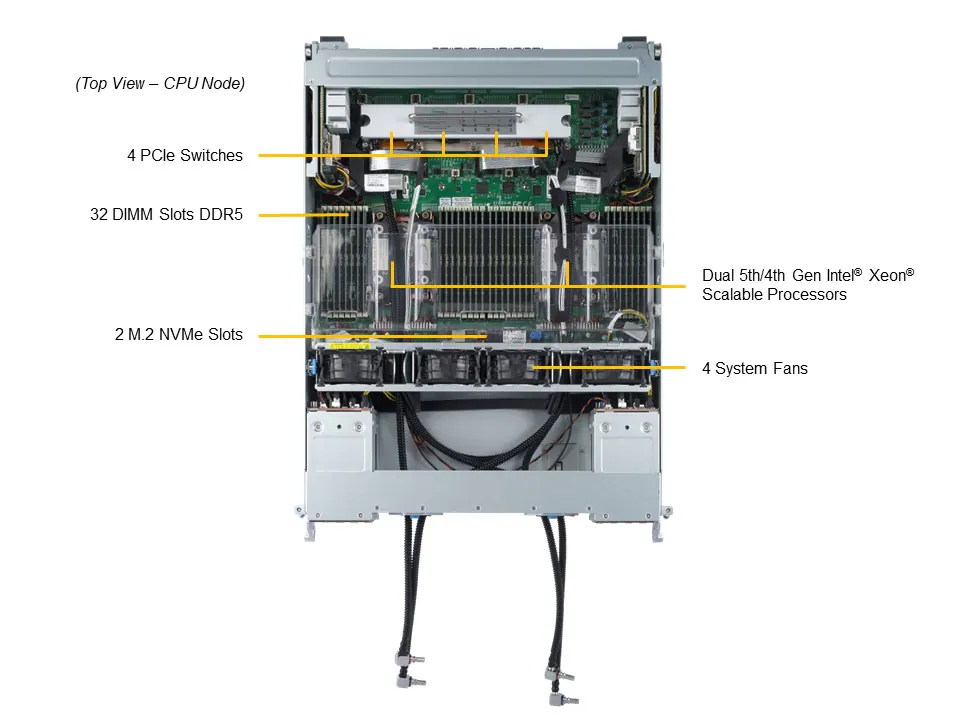

Integração CPU-GPU e interconectividade NVLink

O coração técnico deste sistema reside em sua topologia de interconexão. A comunicação entre CPUs Intel Xeon e as oito GPUs H100/H200 ocorre via PCIe 5.0 x16, enquanto as GPUs são interligadas entre si através da malha NVIDIA NVLink com NVSwitch. Essa arquitetura elimina gargalos de comunicação e maximiza o throughput entre GPUs, essencial para workloads de IA distribuída e HPC.

A certificação NVIDIA garante compatibilidade e otimização de performance para frameworks como TensorFlow, PyTorch e aplicações CUDA personalizadas. Essa integração de hardware e software reduz a sobrecarga de latência e permite escalabilidade linear — característica crítica para treinamento de LLMs e aplicações científicas paralelizadas.

Memória e largura de banda extrema

Com 32 slots DIMM DDR5 ECC RDIMM, o sistema suporta até 8TB de memória a 4400MT/s, combinando integridade ECC e alta taxa de transferência. Essa configuração assegura estabilidade em ambientes de cálculo intensivo, onde qualquer bit incorreto pode corromper grandes volumes de dados de inferência ou simulação.

O uso de módulos DDR5 ECC, aliado à arquitetura de alimentação 8+4 fases com regulação dinâmica, oferece consistência elétrica para cargas flutuantes — um requisito essencial em clusters de IA e bancos de dados in-memory.

Armazenamento NVMe de baixa latência

O sistema inclui oito baias hot-swap NVMe U.2 e dois slots M.2 NVMe, permitindo arranjos de armazenamento em camadas para dados de treinamento, checkpoints de modelos e logs de inferência. Essa flexibilidade possibilita estratégias híbridas de I/O, combinando desempenho de NVMe com redundância RAID em níveis de produção.

Implementação estratégica: integração e manutenção de ambientes líquidos

A implantação do Supermicro 4U liquid-cooled requer planejamento específico de rack, rede hidráulica e monitoramento térmico. O fabricante exige integração completa de rack com serviço local especializado, garantindo que o circuito de refrigeração D2C opere dentro dos parâmetros de pressão, temperatura e condutividade elétrica especificados.

Essa abordagem elimina improvisos comuns em sistemas híbridos, onde líquidos e eletrônicos compartilham o mesmo espaço físico. Ao integrar sensores térmicos em cada GPU e CPU, o sistema ajusta dinamicamente o fluxo de refrigeração e o regime de ventilação PWM, preservando eficiência energética e segurança operacional.

Além disso, o gerenciamento é centralizado via SuperCloud Composer®, SSM e SAA, permitindo orquestração e diagnóstico remoto em tempo real. Isso é particularmente crítico em data centers com múltiplos nós de IA, onde a automação do controle térmico se traduz em confiabilidade e redução de OPEX.

Melhores práticas avançadas: eficiência e governança operacional

Gestão de energia e conformidade

Com fontes redundantes Titanium Level de 5250W (96% de eficiência), o sistema minimiza perdas e assegura conformidade com políticas de sustentabilidade e green computing. Esse nível de eficiência energética é particularmente relevante em operações de HPC, onde centenas de nós podem representar megawatts de consumo contínuo.

Segurança de firmware e cadeia de suprimentos

O servidor incorpora mecanismos de segurança baseados em TPM 2.0 e Silicon Root of Trust (RoT) compatíveis com o padrão NIST 800-193. Isso garante validação criptográfica de firmware, secure boot, recuperação automática e atestação remota. Em ambientes empresariais que lidam com modelos proprietários e dados sensíveis, essa camada de proteção é tão crítica quanto o desempenho bruto.

Automação e visibilidade operacional

As ferramentas Supermicro, como o Thin-Agent Service e o Server Automation Assistant, elevam o nível de automação na operação do sistema. Elas permitem monitorar parâmetros térmicos, voltagens e consumo energético em tempo real, criando uma base de dados operacional que auxilia na previsão de falhas e otimização contínua do ambiente.

Medição de sucesso: métricas de desempenho e confiabilidade

A eficácia de um servidor desse porte deve ser avaliada por métricas multidimensionais. Entre as mais relevantes estão o throughput de treinamento (tokens/s), o tempo de convergência de modelos e o consumo energético por operação (W/TFlop). Em benchmarks internos, soluções com HGX H100 atingem picos superiores a 4 PFLOPS FP8, enquanto o H200 expande a largura de banda de memória em até 50%.

Do ponto de vista operacional, o sistema atinge alta disponibilidade (HA) graças à redundância total de energia e à confiabilidade térmica do circuito líquido. Esses fatores, combinados, reduzem o downtime não planejado e maximizam o ROI ao longo do ciclo de vida do equipamento.

Conclusão: infraestrutura projetada para a era da IA generativa

O DP Intel 4U Liquid-Cooled System com NVIDIA HGX H100/H200 sintetiza o novo paradigma da computação de alto desempenho: densidade extrema, eficiência térmica e governança de hardware unificadas em um mesmo chassis. Trata-se de uma plataforma desenhada não apenas para processar IA, mas para sustentá-la em escala industrial.

Empresas que investem em modelos de linguagem, pesquisa biomédica, automação autônoma e análise financeira em tempo real encontram nesse sistema um ponto de equilíbrio entre potência, segurança e sustentabilidade. Mais do que um servidor, ele é um alicerce estratégico para operações que exigem confiabilidade e desempenho contínuo.

O futuro do HPC e da IA generativa será definido por arquiteturas como esta — onde a integração térmica, energética e lógica se converte em vantagem competitiva tangível. O Supermicro 4U não apenas acompanha essa transição, mas a antecipa.