Introdução

No cenário atual de computação de alto desempenho (HPC) e inteligência artificial (IA), as demandas por eficiência, escalabilidade e integração entre CPU e GPU atingiram novos patamares. O avanço dos modelos de IA generativa e dos workloads científicos complexos exige uma infraestrutura capaz de sustentar cálculos massivamente paralelos e transferências de dados em altíssima velocidade.

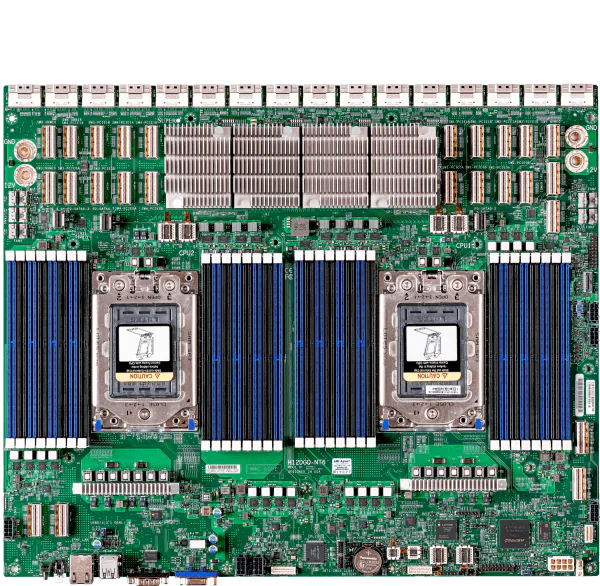

É nesse contexto que o Supermicro A+ Server AS-4124GQ-TNMI se posiciona como uma solução de referência. Baseado na arquitetura AMD Instinct MI250 OAM e nos processadores AMD EPYC 7003, o sistema foi projetado para maximizar o throughput computacional e otimizar a comunicação entre GPUs via Infinity Fabric Link. Seu design de 4U combina densidade, desempenho e confiabilidade, com foco em cargas de trabalho críticas de HPC, aprendizado profundo e análise científica.

Organizações que negligenciam a modernização de seus clusters HPC enfrentam gargalos sérios: tempos de treinamento prolongados, consumo energético elevado e ineficiência na orquestração de workloads híbridos. Este artigo examina, em profundidade, como o servidor GPU AMD da Supermicro redefine a eficiência operacional e acelera o processamento de IA em escala empresarial.

Problema Estratégico: o gargalo entre computação e comunicação

A transição para workloads baseados em IA e análise preditiva tem revelado um desafio fundamental: a discrepância entre a velocidade de processamento dos aceleradores e a capacidade de transferência de dados entre componentes. Em arquiteturas convencionais, a latência entre GPU-GPU e CPU-GPU cria um gargalo que limita o desempenho real, mesmo em sistemas com alto poder teórico de FLOPs.

Para data centers que executam aplicações como simulações moleculares, inferência em larga escala e modelagem financeira, essa limitação representa um custo direto. O atraso na comunicação interprocessos reduz o uso efetivo das GPUs, impactando o retorno sobre investimento (ROI) e ampliando os custos energéticos e operacionais. Além disso, a falta de um ecossistema unificado entre hardware e software torna a otimização uma tarefa complexa para equipes de TI corporativas.

Consequências da Inação: riscos de obsolescência técnica e competitiva

Ignorar a evolução das arquiteturas GPU modernas implica mais do que perda de desempenho: representa uma perda estratégica. Organizações que mantêm clusters baseados em interconexões legadas ou CPUs de gerações anteriores sofrem com escalabilidade limitada, maior latência e menor eficiência térmica. Esses fatores reduzem a competitividade em áreas como pesquisa científica, análise de dados e serviços de IA empresarial.

Além do impacto técnico, há consequências econômicas. O custo por teraflop útil em sistemas desatualizados é significativamente superior devido à ineficiência energética e ao subaproveitamento de recursos. A ausência de recursos de segurança como TPM 2.0 e Silicon Root of Trust também amplia a vulnerabilidade do ambiente a ataques de firmware e violações de integridade.

Fundamentos da Solução: arquitetura AMD Instinct e EPYC integrados

O coração do sistema reside na sinergia entre as GPUs AMD Instinct MI250 e os processadores AMD EPYC 7003. A arquitetura MI250 baseia-se na interconexão Infinity Fabric™, que estabelece canais de comunicação de alta largura de banda entre GPUs, eliminando gargalos e permitindo escalabilidade quase linear em aplicações paralelas.

Essa comunicação GPU-GPU via Infinity Fabric é complementada pelo PCIe 4.0 x16 para a interface CPU-GPU, garantindo baixa latência e suporte a transferências simultâneas de alto throughput. Com até 8TB de memória DDR4 ECC 3200MHz distribuída em 32 DIMMs, o sistema assegura estabilidade para workloads intensivos em dados e permite otimizações complexas em modelos de IA e simulações científicas.

O design em 4U da Supermicro alia densidade e robustez, suportando até quatro GPUs OAM MI250 em um chassi compacto, com fonte redundante de 3000W (Titanium Level) e ventilação de alta capacidade. O resultado é um equilíbrio exemplar entre eficiência térmica, potência computacional e confiabilidade para operações críticas.

Implementação Estratégica: alinhando desempenho e eficiência operacional

Do ponto de vista de integração, o servidor A+ AS-4124GQ-TNMI foi concebido para interoperar de forma transparente com ecossistemas baseados em AMD e soluções de IA de múltiplos fornecedores. Seu suporte nativo ao Supermicro Server Manager (SSM), Power Manager (SPM) e SuperDoctor 5 facilita o monitoramento remoto, a atualização automatizada de firmware e o balanceamento térmico em clusters de grande escala.

O uso de PCIe 4.0 x16 via PLX amplia as possibilidades de expansão, permitindo integração com NICs de alta velocidade ou aceleradores adicionais para aplicações de rede definida por software (SDN) e aprendizado distribuído. O gerenciamento via IPMI 2.0 e KVM-over-LAN proporciona visibilidade completa do hardware, reduzindo o tempo de resposta em manutenções preventivas e emergenciais.

Na camada de segurança, o sistema implementa um conjunto robusto de medidas baseadas em hardware: TPM 2.0 garante armazenamento seguro de chaves criptográficas, enquanto o Silicon Root of Trust assegura a integridade do firmware desde a inicialização. Recursos como Secure Boot, Secure Firmware Updates e System Lockdown tornam o servidor adequado para data centers que exigem conformidade com o padrão NIST 800-193.

Melhores Práticas Avançadas: otimização de desempenho e confiabilidade

Para maximizar o desempenho do sistema, é essencial adotar práticas de balanceamento térmico e tuning de interconexão. O conjunto de cinco ventiladores hot-swap de 11,5K RPM garante operação estável sob cargas intensivas, mas a calibração do fluxo de ar deve considerar o perfil térmico das GPUs MI250 e a densidade de memória instalada.

A implementação de topologias otimizadas de comunicação GPU-GPU, utilizando o Infinity Fabric, reduz significativamente o overhead em aplicações paralelas. Em workloads de IA distribuída, o uso de uma relação 1:1 entre GPU e NIC, suportada nativamente pelo design da Supermicro, elimina gargalos de rede e potencializa a performance de inferência em tempo real.

Adicionalmente, a combinação de fontes redundantes 2+2 Titanium Level assegura continuidade operacional mesmo em caso de falha parcial de energia, e o uso de DIMMs ECC reduz erros de memória que podem comprometer simulações de longa duração. Essa arquitetura torna o servidor ideal para ambientes que demandam uptime superior a 99,99%.

Medição de Sucesso: métricas e indicadores de desempenho

A avaliação de sucesso em ambientes HPC e IA deve ser multidimensional. Para esse sistema, os principais indicadores incluem:

- Throughput computacional efetivo: medido em TFLOPs por watt, refletindo o equilíbrio entre potência e eficiência energética.

- Latência GPU-GPU: monitorada via Infinity Fabric, deve manter valores mínimos para maximizar paralelismo.

- Utilização de memória: otimização de 8 canais DDR4, garantindo acesso balanceado entre CPUs e GPUs.

- Confiabilidade operacional: uptime superior a 99,9%, monitorado via SuperDoctor 5 e IPMI logs.

Essas métricas permitem validar o impacto direto da infraestrutura na aceleração de workloads e no ROI de projetos de IA e HPC. A adoção de ferramentas integradas de monitoramento e ajuste dinâmico de potência oferece uma base sólida para operação contínua e previsível em ambientes corporativos.

Conclusão: convergência de eficiência e poder computacional

O Supermicro A+ Server AS-4124GQ-TNMI representa um ponto de inflexão na infraestrutura de alto desempenho baseada em AMD. Sua combinação de GPUs MI250 com CPUs EPYC 7003 e interconexão Infinity Fabric estabelece um novo padrão de eficiência para cargas de trabalho de IA e HPC, reduzindo gargalos e ampliando a produtividade computacional.

Além do desempenho, sua arquitetura reflete maturidade em segurança e gerenciamento, com recursos que atendem às exigências de conformidade corporativa e às práticas modernas de governança de dados. Em um mundo onde a convergência entre IA e HPC define a competitividade tecnológica, soluções como essa consolidam o caminho para data centers mais inteligentes, eficientes e seguros.

Para organizações que buscam consolidar uma base escalável para IA e simulações científicas, a adoção de servidores GPU AMD 4U com Instinct MI250 oferece não apenas velocidade, mas uma arquitetura preparada para o futuro da computação paralela.