Supermicro 4U GPU Server com HGX A100: Desempenho Máximo para HPC e Treinamento de IA

Introdução

No cenário atual de transformação digital, as organizações enfrentam demandas crescentes por processamento de dados em larga escala, inteligência artificial (IA) e simulações de alto desempenho. Para atender a esses requisitos, data centers corporativos necessitam de servidores GPU capazes de entregar desempenho extremo, confiabilidade e flexibilidade operacional. O Supermicro 4U GPU Server com NVIDIA HGX A100 4-GPU surge como uma solução estratégica para organizações que buscam maximizar a performance de suas cargas de trabalho de HPC e treinamento de IA.

Os desafios enfrentados pelas empresas incluem a necessidade de acelerar cálculos científicos complexos, reduzir o tempo de treinamento de modelos de deep learning e garantir disponibilidade contínua em ambientes críticos. Qualquer falha na infraestrutura ou limitação de performance pode gerar atrasos significativos em projetos estratégicos e aumentar os custos operacionais.

Além disso, a implementação inadequada de servidores GPU em larga escala pode resultar em desperdício de energia, problemas térmicos e subutilização de recursos. Este artigo apresenta uma análise aprofundada do Supermicro 4U HGX A100, explorando suas características técnicas, benefícios estratégicos, melhores práticas de implementação e métricas de sucesso para ambientes corporativos.

Desenvolvimento

Problema Estratégico

Organizações modernas lidam com volumes de dados cada vez maiores e exigem sistemas que suportem cargas de trabalho intensivas em GPU, como simulações científicas, modelagem financeira, treinamento de redes neurais profundas e análise preditiva. Sistemas tradicionais de CPU não oferecem escalabilidade ou throughput necessário para esses cenários, resultando em gargalos de processamento e atrasos na entrega de insights críticos.

Além disso, a complexidade da interconexão entre GPUs e CPUs impacta diretamente a eficiência de processamento paralelo. Sem uma arquitetura otimizada, as GPUs podem operar abaixo de sua capacidade, reduzindo o retorno sobre o investimento em hardware de alto desempenho.

Consequências da Inação

Ignorar a necessidade de servidores GPU especializados implica em custos operacionais mais altos, maior tempo de processamento e risco de perda competitiva. Projetos de IA e HPC podem sofrer atrasos de semanas ou meses, impactando diretamente na capacidade da organização de inovar, lançar produtos ou responder rapidamente a mudanças de mercado.

Além disso, a falha em gerenciar eficiência energética e resfriamento pode resultar em sobrecarga térmica, falhas de hardware e interrupções não planejadas. Para ambientes corporativos que dependem de disponibilidade contínua, esses riscos representam perda financeira direta e danos à reputação.

Fundamentos da Solução

O Supermicro 4U GPU Server integra quatro GPUs NVIDIA HGX A100, conectadas via NVLink para comunicação de alta velocidade entre as unidades. Esta arquitetura permite throughput de dados excepcional e baixa latência na execução de cargas de trabalho distribuídas, fundamental para treinamento de modelos de IA e simulações complexas.

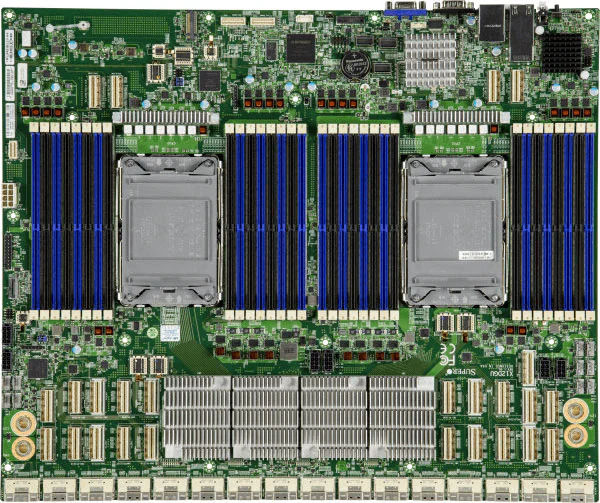

O servidor é equipado com processadores Dual Socket P+ 3ª geração Intel Xeon Scalable, com suporte a até 40 núcleos e 80 threads por CPU, garantindo capacidade de processamento paralelo robusta e otimização do balanceamento CPU-GPU. Com 32 slots DIMM e suporte a até 8TB de memória ECC DDR4, o sistema oferece resiliência, alta capacidade de armazenamento temporário e desempenho consistente em cargas críticas.

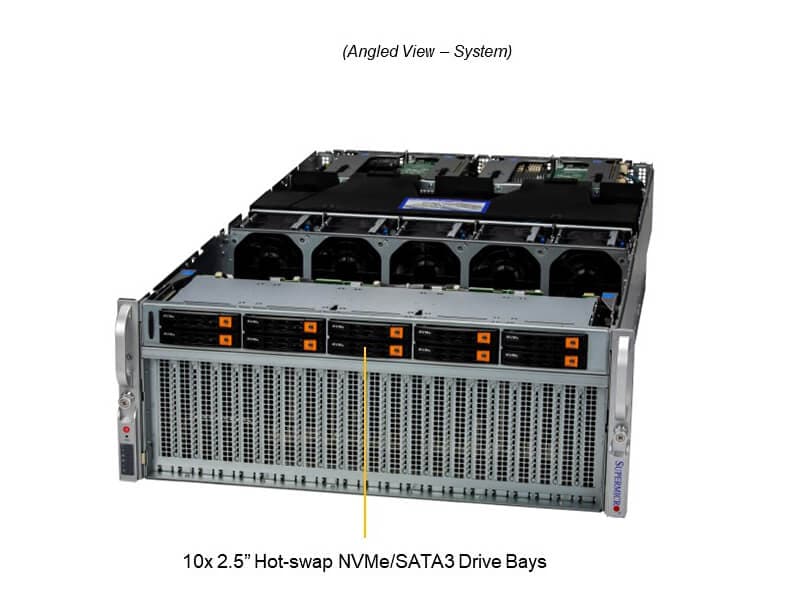

O armazenamento é altamente flexível, incluindo até 10 baias hot-swap de 2,5″ NVMe/SATA e um slot M.2 para boot. Essa configuração permite alta densidade de I/O, essencial para ambientes que demandam acesso rápido a grandes volumes de dados. Complementando, a gestão térmica avançada com cinco fans heavy-duty e quatro fontes redundantes Titanium Level de 3000W garante confiabilidade operacional e eficiência energética.

Implementação Estratégica

A implementação do Supermicro HGX A100 requer planejamento detalhado de data center, incluindo infraestrutura de rede, refrigeração e fornecimento de energia. A configuração de PCIe 4.0 x16 dual-root e NVLink otimiza o desempenho entre CPU e GPU, mas exige balanceamento cuidadoso de recursos para evitar saturação de barramentos ou gargalos de memória.

Para maximizar a performance, recomenda-se alinhar workloads de HPC e IA com os recursos disponíveis, utilizando técnicas de paralelização de tarefas e otimização de memória. O gerenciamento do sistema pode ser centralizado com ferramentas como SuperCloud Composer e Supermicro Server Manager (SSM), que oferecem monitoramento de hardware, diagnóstico proativo e atualização de firmware segura.

Além disso, a segurança é integrada com Trusted Platform Module (TPM) 2.0, Root of Trust (RoT) compatível com NIST 800-193, Secure Boot e firmware assinado criptograficamente, garantindo proteção contra ataques e integridade do sistema em ambientes corporativos sensíveis.

Melhores Práticas Avançadas

Para otimizar o retorno do investimento, é recomendável configurar clusters de servidores GPU com balanceamento de carga automatizado, utilizando ferramentas de orquestração compatíveis com workloads de deep learning e HPC. A integração de storage NVMe de alta velocidade permite reduzir latência e acelerar treinamento de modelos, enquanto a manutenção preventiva baseada em monitoramento contínuo de temperatura e desempenho garante disponibilidade máxima.

O alinhamento entre capacidade de memória, throughput de rede e interconexão NVLink é crucial para workloads intensivos, permitindo escalabilidade horizontal sem comprometer performance. O ajuste fino de parâmetros de BIOS, ventilação e priorização de tarefas GPU é uma prática avançada que eleva significativamente a eficiência operacional.

Medição de Sucesso

Indicadores críticos para avaliar a eficácia da implementação incluem throughput de GPU, tempo de treinamento de modelos, utilização média de CPU e GPU, latência de I/O e eficiência energética do rack. Métricas de confiabilidade como MTBF (Mean Time Between Failures), tempo de recuperação e integridade do sistema também são essenciais para data centers corporativos.

Além disso, a medição deve incluir análise de custo-benefício em relação a alternativas de CPU-only, considerando economia de tempo, redução de consumo energético e aumento de produtividade em projetos de IA e HPC.

Conclusão

O Supermicro 4U GPU Server com NVIDIA HGX A100 4-GPU oferece uma solução completa para ambientes de HPC e IA, combinando processamento de alto desempenho, interconexão NVLink de baixa latência, memória robusta e gestão avançada de energia e segurança. Implementar esta tecnologia com planejamento estratégico garante redução de riscos, maximização de desempenho e escalabilidade para projetos corporativos críticos.

A adoção de servidores GPU especializados representa um diferencial competitivo, permitindo que organizações processem dados em larga escala, treinem modelos complexos e respondam rapidamente às demandas de mercado. A correta implementação e monitoramento contínuo asseguram que os investimentos em hardware resultem em benefícios mensuráveis e sustentáveis.

O futuro da computação de alto desempenho e inteligência artificial depende de soluções como o Supermicro HGX A100, que combinam inovação tecnológica com confiabilidade corporativa. Organizações que adotarem essas práticas estarão preparadas para enfrentar desafios de performance, escalabilidade e eficiência em qualquer cenário de data center.