Servidor GPU 2U NVIDIA GH200 Grace Hopper: desempenho extremo para IA generativa e HPC

A integração entre CPU e GPU chegou a um novo patamar com o lançamento do DP NVIDIA GH200 Grace Hopper Superchip System, uma plataforma projetada para cargas de trabalho de IA generativa e computação de alto desempenho (HPC). Este servidor 2U combina o poder de processamento massivo da GPU NVIDIA H100 Tensor Core com a eficiência e escalabilidade do processador Grace baseado em Arm Neoverse V2, estabelecendo um novo padrão para data centers corporativos e institutos de pesquisa.

O desafio estratégico da integração CPU-GPU em larga escala

Nos últimos anos, a computação heterogênea tornou-se a base para IA, aprendizado profundo e HPC. No entanto, a distância física e lógica entre CPU e GPU continua sendo uma das principais barreiras de desempenho. Em arquiteturas tradicionais, o tráfego de dados via PCIe cria gargalos que limitam a eficiência energética e a largura de banda total. Esse obstáculo é crítico em workloads de IA generativa e modelos de linguagem de larga escala, nos quais bilhões de parâmetros precisam ser processados simultaneamente com latência mínima.

O Grace Hopper Superchip foi desenvolvido para eliminar essa limitação. Através do NVLink Chip-2-Chip (C2C), a NVIDIA alcança uma comunicação direta entre CPU e GPU a 900 GB/s, proporcionando até 7 vezes mais largura de banda que o PCIe 5.0. Isso transforma o paradigma de computação: os dados não são apenas transferidos — são compartilhados em um espaço de memória coerente entre processadores.

Consequências da inação: o custo dos gargalos de dados

Ignorar a integração CPU-GPU resulta em desperdício massivo de recursos. Modelos de IA que exigem movimentação constante de grandes matrizes de dados entre CPU e GPU perdem eficiência computacional e energia. Além disso, o aumento da latência reduz o throughput total e limita o tamanho dos modelos possíveis. Em setores como pesquisa científica, engenharia assistida e análise de risco, essa limitação traduz-se em prazos mais longos e custos operacionais exponencialmente maiores.

Fundamentos da solução: a arquitetura Grace Hopper

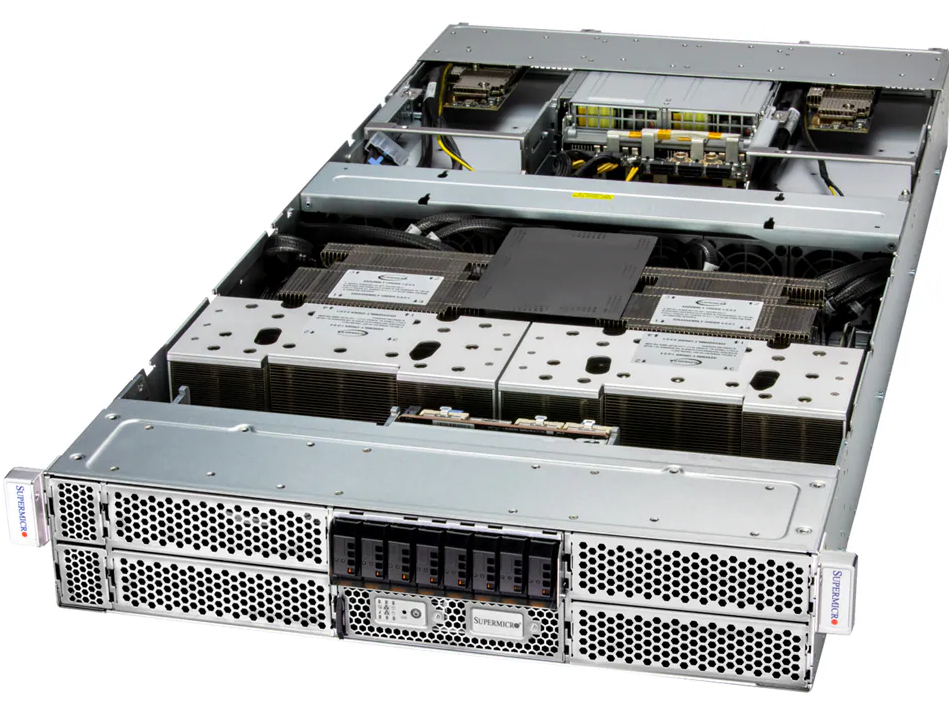

O DP NVIDIA GH200 Grace Hopper Superchip System combina dois Grace CPUs de 72 núcleos com duas GPUs H100 Tensor Core em um design de alta densidade 2U. Essa integração é possível graças ao NVLink-C2C, um barramento de interconexão de alta largura de banda e baixa latência que permite comunicação direta entre as unidades. O resultado é uma arquitetura unificada que reduz significativamente a sobrecarga de transferência de dados.

Além da interconexão, o sistema oferece uma estrutura de memória revolucionária: até 1248 GB de memória coerente, incluindo 960 GB de LPDDR5X ECC e 288 GB de HBM3e. Essa memória unificada é especialmente vantajosa em aplicações de Large Language Models (LLM) e treinamento de redes neurais profundas, onde o volume de parâmetros exige alta largura de banda sustentada e baixa latência de acesso.

Eficiência térmica e estabilidade operacional

O sistema é mantido por até 6 ventoinhas de alto desempenho com controle de velocidade PWM e sensores de temperatura que monitoram CPU e ambiente do chassi. Aliado a isso, o conjunto de 4 fontes redundantes Titanium (96%) de 2000W garante operação contínua em regimes de alta carga térmica e energética, típicos de clusters de IA.

Implementação estratégica: conectividade e expansão

O GH200 2U foi projetado com uma abordagem de conectividade modular. Ele oferece 3 slots PCIe 5.0 x16 e 1 x4, com suporte a controladoras de rede NVIDIA BlueField-3 e ConnectX-7. Essa configuração permite implementar GPUDirect RDMA, reduzindo a latência entre nós em ambientes distribuídos e otimizando fluxos de dados entre servidores GPU.

Para armazenamento, o sistema inclui 3 baias frontais E1.S NVMe e 2 slots M.2 NVMe, ideais para sistemas operacionais, caches de inferência e bancos de dados de embeddings. Essa flexibilidade é fundamental em implementações que alternam entre inferência, fine-tuning e workloads de HPC.

Melhores práticas avançadas: alinhando IA e infraestrutura

Ao implantar o GH200, as organizações devem considerar três pilares críticos: coerência de memória, otimização térmica e topologia de rede. O uso do NVLink-C2C exige balanceamento cuidadoso de threads e buffers, evitando sobrecarga de comunicação entre processadores. A refrigeração deve ser ajustada com base no regime térmico específico de cada workload. E a topologia de interconexão RDMA deve ser configurada para maximizar o throughput de GPU a GPU, especialmente em clusters multi-nó.

Interoperabilidade com sistemas empresariais

O GH200 é certificado pela NVIDIA, o que garante compatibilidade plena com o ecossistema CUDA e frameworks como PyTorch, TensorFlow e JAX. Essa interoperabilidade facilita a adoção em ambientes corporativos já otimizados para HPC e IA, reduzindo custos de integração e tempo de implementação.

Medição de sucesso: métricas de desempenho e eficiência

Para avaliar o sucesso da implementação, devem ser monitorados três indicadores principais:

- Throughput de treinamento e inferência: medido em tokens/s ou TFLOPS sustentados.

- Eficiência energética: relação entre desempenho e consumo (TFLOPS/Watt).

- Latência interprocessual: tempo médio de comunicação CPU-GPU e GPU-GPU.

Essas métricas permitem quantificar o impacto do NVLink-C2C e da arquitetura de memória unificada na eficiência operacional do cluster.

Conclusão: o novo patamar da computação de IA

O DP NVIDIA GH200 Grace Hopper Superchip System consolida uma visão de computação unificada que redefine os limites entre CPU e GPU. Com largura de banda sem precedentes, memória coerente de até 1,2 TB e suporte a interconectividade avançada, o sistema é uma base sólida para IA generativa, HPC e aplicações científicas críticas.

Em um cenário onde o volume de dados cresce exponencialmente e a demanda por eficiência computacional é constante, o GH200 2U representa o equilíbrio ideal entre densidade, escalabilidade e estabilidade operacional. É, ao mesmo tempo, uma plataforma de pesquisa e um acelerador de negócios, capaz de sustentar a próxima geração de inteligência artificial corporativa.